Résumés

Résumé

La présente étude a pour objectifs de dégager la structuration des croyances de 76 futurs enseignants à l’égard de l’évaluation au moment où ils entament leur premier cours d’évaluation à l’université et d’examiner l’évolution de leurs croyances entre le début et la fin de celui-ci. Les résultats ont montré que les futurs enseignants possèdent, à l’entrée, des croyances plus marquées par l’évaluation nouvelle que par l’évaluation traditionnelle. Au terme du cours, leurs croyances sont demeurées stables. Des pistes d’actions susceptibles de favoriser le développement de la compétence à évaluer chez les futurs enseignants sont proposées aux formateurs.

Mots-clés :

- Croyances,

- évaluation,

- futurs enseignants

Abstract

The current study investigates the pattern of beliefs of 76 preservice teachers about assessment as they start their first assessment course at the university and examines the evolution of their beliefs through the course. The results showed that the preservice teachers hold initial beliefs more in line with alternative assessment than traditional assessment. At the end of the course, their beliefs remained stable. Suggestions for action to promote the development of assessment skills among preservice teachers are proposed to instructors.

Keywords:

- Belief,

- assessment,

- preservice teachers

Corps de l’article

Introduction

À l’enseignement primaire et secondaire, à l’exception des épreuves ministérielles ou de centre de services scolaire qui peuvent avoir lieu au terme de l’année scolaire, il revient aux enseignants québécois de mettre en place les modalités d’évaluation des apprentissages dans les classes (Gouvernement du Québec, 2022). Parmi les tâches qui leur incombent, il leur faut, entre autres, planifier l’évaluation, concevoir et assurer la passation des épreuves aux élèves, corriger les copies, identifier leurs forces et leurs défis, communiquer les résultats de l’évaluation et mettre en place les actions de remédiation qui s’imposent. Une commande qui ne se fait pas toujours sans heurt, car l’évaluation représente, aux dires de Moss (2013), l’une des tâches les plus complexes qu’il soit pour les enseignants.

La complexité de l’acte d’évaluer conduit à interroger la qualité de la formation de la relève enseignante : forme-t-on, dans les facultés d’éducation québécoises, des futurs enseignants qui seront en mesure de mettre en place comme il se doit les modalités d’évaluation dans les classes une fois entrés dans le métier ? Au Québec, la compétence à évaluer est l’une des compétences professionnelles à développer dans les programmes de formation des maîtres. Dans le document phare intitulé Référentiel de compétences professionnelles : profession enseignante (MEQ, 2020), la compétence 5 s’énonce comme suit : Évaluer les apprentissages - développer, choisir et utiliser différentes modalités afin d’évaluer l’acquisition des connaissances et le développement des compétences chez les élèves.

Pour préparer au mieux la relève enseignante à l’évaluation, il faut, dans les cours préparatoires, former les futurs enseignants aux manières de faire l’évaluation éprouvées par la recherche scientifique (Frey, 2014 ; Popham, 2014) et aux prescriptions ministérielles (MEQ, 2002, 2003) en la matière. Mais il y a plus. Pour les formateurs à l’évaluation que nous sommes, il a semblé judicieux de s’intéresser à ce qui pourrait freiner ou, mieux encore, favoriser le développement de la compétence à évaluer chez les futurs enseignants dans la mesure où, comme le rappellent Monney et Fontaine (2016), plusieurs d’entre eux se sentiraient peu compétents en la matière. Parce qu’il est reconnu qu’ils « se servent des croyances et connaissances relatives à l’acte d’enseigner qu’ils possèdent déjà pour interpréter les nouvelles théories et compétences qu’ils acquièrent au cours de leur formation » (Vause, 2010, p. 17), l’examen de leurs croyances à l’égard de l’évaluation nous a paru une avenue féconde pour guider les enseignements. Quelles croyances les futurs enseignants possèdent-ils à leur arrivée dans les cours d’évaluation à l’université sur la manière dont l’évaluation doit être effectuée dans les classes du primaire et du secondaire ? Comment se heurtent-elles aux contenus qui y sont enseignés ? Sont-elles finalement maintenues, renforcées ou réfutées pour garantir la pratique du métier d’enseignant ? Telle est la trame de la présente étude.

Il s’agit là de questionnements légitimes dans la mesure où les futurs enseignants à qui nous enseignions au moment de la présente étude avaient été confrontés, du temps de leur scolarité primaire et secondaire, à deux tendances en évaluation : celle marquée par les examens « classiques » qui s’harmonisent avec des contenus formulés selon une hiérarchie d’objectifs, puis celle dominée par les tâches complexes et authentiques en réponse à la réécriture, en matière de compétences, des programmes d’études construits sur la base d’objectifs pédagogiques.

Nous présenterons ci-après quelques éléments de définition autour du concept de croyance en général, puis l’ancrerons dans le contexte particulier de l’évaluation. Nous enchaînerons avec une synthèse des objectifs de l’étude, le détail de sa méthodologie (dont la construction d’un inventaire de croyances à l’égard de l’évaluation) et ses principaux résultats. Dans une discussion conclusive, des pistes d’actions susceptibles de favoriser le développement de la compétence à évaluer chez les futurs enseignants seront entre autres dégagées, dont celle, à l’attention des formateurs, de prendre en compte leurs croyances au moment de leur entrée en formation.

Cadre conceptuel

Le concept de croyance et ses effets

Pour les besoins de l’étude, nous adoptons la définition de croyance proposée par Harvey (1986, cité dans Pajares, 1992, p. 313, traduction libre) qui renvoie à « une représentation individuelle de la réalité qui a suffisamment de validité, de vérité, ou de crédibilité pour guider la pensée et le comportement ». Dans le contexte de la formation à l’évaluation, c’est le temps passé sur les bancs d’école par les futurs enseignants qui est, pour une large part, à la base de leurs croyances sur ce que doit être l’acte d’évaluer (Crahay et al., 2010 ; Vause, 2010). Combien de fois a-t-on évalué leurs apprentissages scolaires, enfant ou adolescent ? Par conséquent, les futurs enseignants arrivent dans les cours de formation à l’évaluation avec une idée précise de ce à quoi elle devrait ressembler dans les classes. Ces croyances, qui peuvent être en adéquation ou non avec les bonnes façons de faire l’évaluation et les prescriptions ministérielles, se positionnent tel un filtre (Cabaroglu et Roberts, 2000) entre les futurs enseignants et la matière qui leur est enseignée, ce qui les amènerait à prendre en compte les éléments de contenu soutenant leurs croyances et à rejeter, voire déformer, ceux qui s’en éloignent (Crahay et al., 2010). Par exemple, croire depuis l’enfance que les notes des élèves doivent servir à les classer les uns par rapport aux autres pourrait conduire les futurs enseignants à rejeter l’élément de contenu voulant que l’évaluation doit, dans le système scolaire québécois, contribuer à la réussite de tous les élèves (MEQ, 2003). Au sortir de l’université, ces croyances tantôt fondées, tantôt erronées iraient même jusqu’à influencer la pratique du métier d’enseignant (Brown et Gao, 2015 ; Gebril, 2017 ; Rogers et al., 2007). Pour reprendre la démonstration de Lafortune (2002, p. 71), croire que « les élèves ne sont pas capables de porter un jugement adéquat sur leurs productions » pourrait inciter les enseignants à « éviter l’interévaluation ou l’autoévaluation » dans leur classe.

L’état des recherches sur les croyances à l’égard de l’évaluation

Une revue des écrits a révélé que ce sont principalement les croyances des enseignants en exercice à l’égard de l’évaluation qui ont retenu l’attention des chercheurs, tant dans le monde francophone qu’anglophone. Pour les appréhender, deux instruments de mesure font autorité du côté de la recherche : celui d’Issaieva et de Crahay (2010, 2015) qui interroge les conceptions de l’évaluation au regard de ses dimensions (normative, formative et critériée) et le Conceptions of Assessment Inventory de Brown (2002, 2006) qui les situe par rapport aux finalités de l’évaluation (improvement of teaching and learning, school accountability, student accountability et treating assessment as irrelevant). À la suite d’études conduites dans plusieurs pays, il appert que les croyances des enseignants en exercice à l’égard de l’évaluation s’avèrent spécifiques aux contextes socioculturel et éducatif dans lesquels ils évoluent (Brown et Gao, 2015 ; Fagnant et Goffin, 2017). On se rappellera à cet effet que le Québec a connu, au début du siècle, une réforme de ses programmes d’études par objectifs au profit des compétences, avec pour conséquence un recadrage des pratiques d’évaluation traditionnelle vers de nouvelles approches. Il est coutume d’associer l’évaluation traditionnelle aux contenus formulés selon une hiérarchie d’objectifs, souvent mesurés par des tâches simples (p. ex. : items à réponse choisie ou à réponse courte). À l’opposé, l’évaluation nouvelle va plutôt de pair avec la singularité d’un programme par compétences où des tâches complexes et authentiques nourrissent les jugements à porter sur celles-ci. On gardera toutefois à l’esprit qu’il s’agit là de tendances, dans la mesure où certaines pratiques associées à l’évaluation nouvelle étaient d’actualité, dans une moindre mesure certes, du temps du règne de la pédagogie par objectifs. Il en est de même pour les pratiques associées à l’évaluation traditionnelle : certaines d’entre elles semblent avoir survécu à la venue du concept de compétence en éducation.

Du côté des futurs enseignants, ce sont principalement les croyances à l’égard du métier d’enseignant en général qui ont été étudiées autour du questionnement suivant : est-il possible de les faire évoluer comme il se doit au cours de la formation qui mène au métier d’enseignant ? La note de synthèse de Boraita et Crahay (2013, p. 127), qui effectue un tour complet de la question, renseigne bien à cet égard :

les études recensées concernant l’effet des dispositifs de formation sur l’évolution des croyances des FE [futurs enseignants] fournissent des résultats plus que mitigés. Dans de nombreux cas, les chercheurs se résignent à conclure des effets de la formation que les croyances n’ont pas bougé au cours de celle-ci, que ce soit de l’effet du programme en général, des cours théoriques ou des stages et de l’expérience de terrain

Bien qu’il soit réputé difficile de les faire évoluer, nous osons formuler les questionnements suivants : qu’en est-il de la structuration des croyances des futurs enseignants québécois à l’égard de l’évaluation à leur arrivée dans les cours d’évaluation à l’université ? Sont-elles plus marquées par l’évaluation nouvelle ou par l’évaluation traditionnelle ? Par nos enseignements, réussissons-nous finalement à les faire évoluer ? Sont-elles maintenues, renforcées ou réfutées en conformité avec les façons de faire l’évaluation éprouvées par la recherche scientifique et les prescriptions ministérielles en la matière ?

Objectifs de l’étude

Sur la base des propos annoncés plus haut, les objectifs poursuivis par la présente étude sont 1) de dégager la structuration des croyances de futurs enseignants à l’égard de l’évaluation au moment où ils font leur entrée dans leur premier cours d’évaluation à l’université et 2) d’examiner l’évolution de leurs croyances entre le début et la fin de celui-ci. Ces objectifs ont nécessité la construction de l’inventaire de croyances à l’égard de l’évaluation dont il sera question à la prochaine section.

Méthodologie et résultats

Les cours d’évaluation à l’origine de l’étude

Deux cours d’initiation de trois crédits, sous notre responsabilité respective et offerts dans deux universités québécoises, ont servi de matériaux pour appréhender la structuration et l’évolution des croyances de futurs enseignants à l’égard de l’évaluation. Malgré une modalité de diffusion différente (l’un en présentiel et l’autre à distance), il se dégage de ces deux cours une trame commune. Chacun d’eux a pour mission de faire progresser les futurs enseignants dans l’acte d’évaluer par l’enseignement d’éléments de contenu similaires liés à la planification de l’évaluation, à la conception et à la passation d’épreuves, à la correction des copies, à l’identification des forces et des défis des élèves, à la communication des résultats de l’évaluation et à la mise en place d’actions de remédiation.

L’Inventaire des croyances à l’égard de l’évaluation (ICE)

Pour atteindre nos objectifs de recherche, il est apparu comme souhaitable de se doter d’un instrument de mesure aux qualités édumétriques appréciables capable d’appréhender les croyances à l’égard de l’évaluation pour en apprécier la structuration et l’évolution. Si nous pouvons qualifier d’intéressants les instruments mis au point par Issaieva et Crahay (2010, 2015) ainsi que par Brown (2002, 2006), force est d’admettre que leur portée est limitée pour la présente étude : aucun d’eux n’a formalisé son instrument de prise de données en rapport aux caractéristiques contextuelles de l’évaluation dans le système scolaire québécois qui a connu, au début du siècle, une réforme majeure de ses programmes d’études.

La construction de l’Inventaire des croyances à l’égard de l’évaluation (ICE) a pris appui sur les sept étapes proposées par Frenette et al. (2019). Ces étapes, qui visent à maximiser l’accumulation de preuves de validité tout au long du processus de construction, sont les suivantes : 1) déterminer le concept à l’étude ; 2) préciser le contexte de passation ; 3) générer une banque d’énoncés ; 4) déterminer le format de l’échelle de réponses ; 5) évaluer la banque d’énoncés à l’aide du jugement d’experts ; 6) effectuer un prétest et 7) procéder à la collecte de données. La façon dont ces étapes se sont matérialisées dans le contexte de la présente étude est décrite ci-après.

Étapes 1 à 5 : construction de l’ICE

Différentes démarches ont servi à déterminer le concept à l’étude (étape 1), à savoir les croyances des futurs enseignants québécois à l’égard de l’évaluation : a) une revue des écrits sur le concept de croyance ; b) une analyse documentaire des prescriptions ministérielles traditionnelles (avant la réforme) et nouvelles (après la réforme) en évaluation ; c) une revue des écrits sur les concepts d’évaluation traditionnelle et d’évaluation nouvelle ; d) des discussions informelles auprès de 45 futurs enseignants pour prendre le pouls de leurs croyances et e) l’examen d’instruments de mesure pour appréhender les croyances à l’égard de l’évaluation, notamment celui d’Issaieva et de Crahay (2010, 2015) et celui de Brown (2002, 2006).

À l’étape 2 du processus de construction, il a fallu préciser le contexte de passation dans lequel l’ICE serait administré pour en orienter le design. Il devait a) s’employer auprès de futurs enseignants ; b) être accessible en ligne et en version papier pour répondre au besoin de la collecte de données et c) se remplir rapidement en vue d’être administré avec d’autres instruments de mesure dans des recherches futures. C’est également à cette étape qu’a été demandée et obtenue l’autorisation d’entreprendre la présente étude auprès du Comité d’éthique de l’université d’attache de la chercheure principale.

À la suite de ces démarches, des énoncés (n = 200+) ont été générés par les membres de l’équipe de recherche pour conduire à une première version de l’ICE (étape 3). Ceux-ci devaient refléter les deux facteurs d’intérêt à l’origine de la construction de l’inventaire de croyances : l’évaluation traditionnelle d’avant la réforme (p. ex. : « Je crois que les évaluations devraient avoir un caractère artificiel ou scolaire. ») et l’évaluation nouvelle d’après la réforme (p. ex. : « Je crois que les évaluations devraient s’inspirer de la vie courante des élèves. »). À la suite du retrait des énoncés redondants, non pertinents et manquant de clarté, la première version de l’ICE s’est trouvée constituée de 24 énoncés.

Afin de permettre aux répondants de se positionner sur chacun des énoncés, il a été décidé, à l’étape 4, de retenir une échelle de réponses classique de type Likert en six points, allant de « tout à fait en désaccord » (1) à « tout à fait en accord » (6).

Enfin, à l’étape 5, des spécialistes en évaluation (n = 7) et des enseignants en exercice (n = 8) ont été invités a) à se prononcer sur la clarté des 24 énoncés de l’ICE ; b) à les associer à l’un des deux facteurs d’intérêt (évaluation traditionnelle et évaluation nouvelle) et c) à proposer, si souhaité, de nouveaux énoncés. Au sortir de l’exercice, trois énoncés ont été modifiés et trois autres ont été ajoutés, ce qui a conduit l’ICE à 27 énoncés (voir tableau 1).

Étape 6 : prétest de l’ICE

L’ICE a été soumis à un prétest en version papier auprès de 147 futurs enseignants inscrits dans l’une des deux universités où a été conduite la présente étude, mais qui ne feraient pas partie de la collecte de données à venir (étape 7) pour répondre à nos objectifs de recherche. Ces étudiants, qui n’avaient toujours pas entrepris de cours d’évaluation à l’université au moment de participer au prétest, possédaient les caractéristiques sociodémographiques suivantes (genre, âge, programme d’études) : femmes (n = 134), hommes (n = 13) ; 19 ans (n = 60), 20 ans (n = 42), 21 ans (n = 21), 22 ans (n = 10), 23 ans (n = 5), 24 ans (n = 5), 25 ans (n = 1), 26 ans et plus (n = 3) ; BÉPEP (n = 123), BES (n = 24).

Dans un premier temps, deux analyses ont servi à détecter la présence d’énoncés problématiques au sein de l’ICE à 27 énoncés : l’examen des corrélations item-total ainsi qu’une analyse factorielle exploratoire (ML, rotation varimax, forcée à 2 facteurs). Les traitements statistiques ont été effectués au moyen du logiciel SPSS. Cinq énoncés sur 27 en sont ressortis comme problématiques, rapportant l’ICE à 22 énoncés. Deux raisons ont conduit à ce retrait d’énoncés de l’inventaire en construction : une corrélation item-total inférieure à ,30 (Crocker et Algina, 2006) ou une saturation de même amplitude sur les deux facteurs initialement envisagés (évaluation traditionnelle et évaluation nouvelle) lors de l’analyse factorielle exploratoire.

Dans un deuxième temps et dans l’optique d’en apprécier les qualités édumétriques, l’ICE, dans sa version à 22 énoncés, a été soumis aux mêmes analyses statistiques auxquelles se sont ajoutés l’examen du niveau de consistance interne et une analyse factorielle confirmatoire (ML, correction de Lee et al. [1995], options catégorielle et Robust, logiciel EQS). Comme souhaité, les analyses factorielles exploratoire (deux facteurs expliquant 34 % de la variance) et confirmatoire (Li-Bentler = ,92 ; CFI = ,95 ; NNFI = ,95 ; RMSEA = ,046 ; r entre les deux facteurs = ,43) ont mis en évidence la structure factorielle à deux facteurs anticipée (voir figure 1). Qui plus est, aucune corrélation item-total inférieure à ,30 n’a été repérée parmi les énoncés et le niveau de consistance interne a été considéré comme acceptable pour les deux facteurs (évaluation traditionnelle : α = ,66 et évaluation nouvelle : α = ,84).

Figure 1

Graphique des saturations de l’analyse factorielle exploratoire

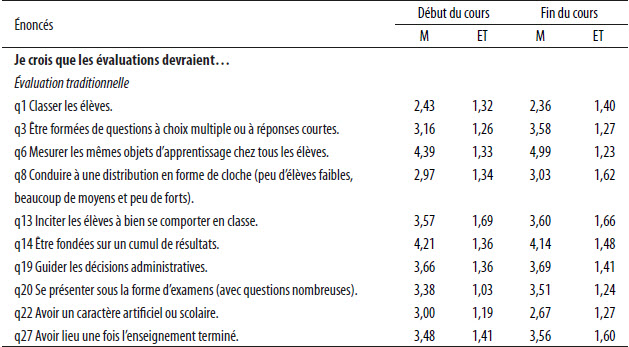

Le tableau 1 rassemble les statistiques descriptives pour les 27 énoncés expérimentés en prétest (10 énoncés relatifs à l’évaluation traditionnelle : q1, q3, q6, q8, q13, q14, q19, q20, q22, q27 ; 12 énoncés relatifs à l’évaluation nouvelle : q2, q4, q5, q7, q9, q11, q12, q15, q17, q18, q21, q26 et les 5 énoncés retirés : q10, q16, q23, q24, q25).

Tableau 1

Statistiques descriptives des énoncés lors du prétest (147 futurs enseignants)

Étape 7 : Collecte de données au moyen de l’ICE

Après nous être dotés d’un instrument de mesure aux qualités édumétriques appréciables à l’étape 6, nous avons lancé la collecte de données pour répondre à nos objectifs de recherche (dégager la structuration des croyances de futurs enseignants à l’égard de l’évaluation au moment où ils font leur entrée dans leur premier cours d’évaluation à l’université et examiner l’évolution de leurs croyances entre le début et la fin de celui-ci).

Soixante-seize futurs enseignants, inscrits dans les deux cours d’évaluation sous notre responsabilité respective et dont le parcours scolaire a été marqué à la fois par l’évaluation traditionnelle et l’évaluation nouvelle, se sont portés volontaires pour participer à la collecte de données (22 pour le cours en présentiel et 54 pour le cours à distance). Leurs caractéristiques sociodémographiques (genre, âge, programme d’études) sont les suivantes : femmes (n = 63), hommes (n = 13) ; 20 ans (n = 4), 21 ans (n = 18), 22 ans (n = 9), 23 ans (n = 13), 24 ans (n = 4), 25 ans (n = 5), 26 ans et plus (n = 22), ND (n = 1) ; BÉPEP (n = 33), BES (n = 28), BEP (n = 7), autres programmes (n = 8).

Les croyances des 76 futurs enseignants à l’égard de l’évaluation ont été appréhendées au moyen de l’ICE dans sa version finale à 22 énoncés à deux moments « critiques » : avant d’entreprendre leur premier cours d’évaluation à l’université (semaine 1) et après celui-ci (semaine 15). Les futurs enseignants inscrits au cours à distance l’ont rempli en ligne via LimeSurvey, tandis qu’une modalité de passation papier a été privilégiée pour ceux du cours en présentiel. Le tableau 2 présente les statistiques descriptives aux deux temps de mesure (début du cours et fin de celui-ci) pour les 22 énoncés de l’ICE selon leur appartenance à l’évaluation traditionnelle ou nouvelle.

Tableau 2

Statistiques descriptives des énoncés lors de la collecte de données (76 futurs enseignants)

Des tests t pour échantillons appariés ont permis de se prononcer sur la structuration des croyances des 76 futurs enseignants à l’égard de l’évaluation à l’entrée dans leur cours et sur leur évolution entre le début et la fin de celui-ci. Il ressort des analyses conduites avec le logiciel SPSS que les futurs enseignants adhéraient davantage (t(75) = 19,78, p = 0,00) à l’évaluation nouvelle (M = 5,16 ; ET = ,51) que traditionnelle (M = 3,62 ; ET = ,60) au début du cours, mais sans rejeter totalement cette dernière. À la fin du cours, les croyances des futurs enseignants sont demeurées stables pour l’ensemble des 22 énoncés[1].

Discussion et conclusion

La présente étude avait pour objectifs de dégager la structuration des croyances de futurs enseignants à l’égard de l’évaluation au moment où ils font leur entrée dans leur premier cours d’évaluation à l’université et d’examiner l’évolution de leurs croyances entre le début et la fin de celui-ci. Elle a nécessité la construction de l’Inventaire des croyances à l’égard de l’évaluation (ICE) qui vient combler le besoin, dans le contexte québécois, d’un instrument de mesure aux qualités édumétriques appréciables capable d’appréhender les croyances de futurs enseignants à l’égard de l’évaluation.

Les résultats ont montré que les futurs enseignants possèdent, à l’entrée dans leur premier cours d’évaluation à l’université, des croyances plus marquées par l’évaluation nouvelle que par l’évaluation traditionnelle qui demeure, malgré tout, bien présente. Ce constat paraît logique dans la mesure où c’est le temps passé sur les bancs d’école par les futurs enseignants qui est, pour une large part, à la base de leurs croyances sur ce que doit être l’acte d’évaluer (Crahay et al., 2010 ; Vause, 2010). On se souviendra que, du temps de leur scolarité primaire et secondaire, ces deux formes d’évaluation ont cohabité dans le système scolaire québécois. D’abord, la tendance en évaluation a été aux examens « classiques » qui s’harmonisent avec des contenus formulés selon une hiérarchie d’objectifs. Puis, avec l’arrivée de la réforme, la singularité des programmes par compétences a induit une autre culture d’évaluation dominée par les tâches complexes et authentiques. Ce contexte de mouvance dans le système scolaire québécois n’est certes pas étranger au fait que les évaluations traditionnelle et nouvelles aient pu s’entremêler dans les croyances des futurs enseignants.

Au terme du cours d’évaluation, les analyses ont révélé une stabilité pour l’ensemble des croyances. La note de synthèse de Boraita et Crahay (2013), citée en début de texte, nous rappelle que, trop souvent, les recherches du même type en arrivent à des conclusions similaires.

C’est précisément ce qui nous amène du côté des pistes d’actions pour les formateurs qui souhaitent maintenir, renforcer ou réfuter comme il se doit les croyances des futurs enseignants qui leur sont confiés. Kagan (1992, cité dans Crahay et al., 2010, p. 111) propose d’intervenir de la façon suivante :

-

aider les étudiants à prendre conscience de leurs croyances implicites et, partant, à les expliciter ;

-

les confronter avec des éléments pouvant déboucher sur une mise en question de leurs croyances en mettant en évidence leurs contradictions internes, leurs incohérences, voire leurs inadéquations par rapport à la réalité de l’enseignement ;

-

donner l’opportunité aux étudiants d’intégrer de nouvelles connaissances, de sorte à différencier les anciennes croyances, voire de remplacer les conceptions totalement inadaptées.

Se servir de l’ICE pour faire émerger les croyances des futurs enseignants pourrait aussi constituer un bon point de départ pour lancer les discussions et orienter les enseignements.

Malgré sa force méthodologique qui a permis de construire l’ICE justement, la présente étude n’est pas exempte de limites. Dans un premier temps, il y a lieu de pointer le fait que nous avons travaillé à partir de scores globaux pour conclure à la stabilité des croyances à la fin du cours d’évaluation, ce qui a eu pour inconvénient de masquer les différences individuelles. Par exemple, il est possible qu’il y ait eu dans l’échantillon des futurs enseignants dont les croyances ont évolué bien au-delà de la marge requise pour conclure à des mouvements significatifs. Par ailleurs, il faut signaler l’absence d’entrevue qui aurait pu servir à comprendre l’origine des croyances des futurs enseignants et les raisons de leur non-évolution. Enfin, parce que le cours d’évaluation n’est pas un milieu hermétique, il est possible que des variables externes non contrôlées (p. ex. : cours suivis en simultané) aient pu influencer les résultats de l’étude.

Outre celles liées aux limites énoncées ci-dessus, des idées de recherches futures peuvent être dégagées à la suite de la présente étude. Il pourrait s’agir de mettre en place un devis de recherche longitudinal visant à suivre les futurs enseignants non plus dans un seul cours, mais à travers un programme de formation des maîtres où les cours théoriques et les stages cohabitent. Ce devis pourrait aussi se prolonger au-delà de la diplomation pour voir comment l’arrivée dans le métier influence les croyances des enseignants débutants à l’égard de l’évaluation.

Parties annexes

Note

-

[1]

Le seuil de signification a été fixé à p < ,002 (,05/22 énoncés).

Bibliographie

- Boraita, F. et Crahay, M. (2013). Les croyances des futurs enseignants : est-il possible de les faire évoluer en cours de formation initiale et, si oui, comment ? Revue française de pédagogie, 183, 99-158. https://doi.org/10.4000/rfp.4186

- Brown, G. T. L. (2002). Teachers’ Conceptions of Assessment (Thèse de doctorat inédite). University of Auckland.

- Brown, G. T. L. (2006). Teachers’ conceptions of assessment : Validation of an abridged version. Psychological Reports, 99, 166-170. https://doi.org/10.2466/pr0.99.1.166-170

- Brown, G. T. L. et Gao, L. (2015). Chinese teachers’ conceptions of assessment for and of learning : Six competing and complementary purposes. Cogent Education, 2(1), 1-19. https://doi.org/10.1080/2331186X.2014.993836

- Cabaroglu, N. et Roberts, J. (2000). Development in student teachers’ pre-existing beliefs during a 1-year PGCE programme. System, 28(3), 387-402. https://doi.org/10.1016/S0346-251X(00)00019-1

- Crahay, M., Wanlin, P., Issaieva, É. et Laduron, I. (2010). Fonctions, structuration et évolution des croyances (et connaissances) des enseignants. Revue française de pédagogie, 172, 85-129. https://doi.org/10.4000/rfp.2296

- Crocker, L. et Algina, J. (2006). Introduction to classical and modern test theory. Belmont, CA : Wadsworth.

- Fagnant, A. et Goffin, C. (2017). Les conceptions des futurs enseignants du secondaire en matière d’évaluation : entre un accord de principe et une vision limitée de l’évaluation formative. Mesure et évaluation en éducation, 40(1), 1-32. https://doi.org/10.7202/1041002ar

- Frenette, E., Fontaine, S., Hébert, M.-H. et Éthier, M. (2019). Étude sur la propension à tricher aux examens à l’université : élaboration et processus de validation du Questionnaire sur la tricherie aux examens à l’université (QTEU). Mesure et évaluation en éducation, 42(2), 1-33. https://doi.org/10.7202/1071514ar

- Frey, B. B. (2014). Modern Classroom Assessment. Thousand Oaks, CA : SAGE Publications, Inc.

- Gebril, A. (2017). Language teachers’ conceptions of assessment : an Egyptian perspective. Teacher Development, 21(1), 81-100. https://doi.org/10.1080/13664530.2016.1218364

- Gouvernement du Québec (2022). Loi sur l’instruction publique. Repéré à https://www.legisquebec.gouv.qc.ca/fr/pdf/lc/I-13.3.pdf

- Issaieva, É. et Crahay, M. (2010). Conceptions de l’évaluation scolaire des élèves et des enseignants : Validation d’échelles et étude de leurs relations. Mesure et évaluation en éducation, 33(1), 31-61. https://doi.org/10.7202/1024925ar

- Issaieva, É., Yerly, G., Petkova, I., Marbaise, C. et Crahay, M. (2015). Conceptions et prises de positions des enseignants face à l’évaluation scolaire dans quatre systèmes éducatifs européens : quel est le reflet des cultures et politiques éducatives ? Dans P.-F. Coen et L. M. Bélair (dir.), Évaluation et autoévaluation. Quels espaces de formation (p. 73-98) ? Louvain-la-Neuve, Belgique : De Boeck Supérieur.

- Lafortune, L. (2002). Une pratique réflexive pour accompagner l’évaluation. Québec français, 127, 71-73.

- Lee, S.-Y., Poon, W.-Y. et Bentler, P. M. (1995). A two-stage estimation of structural equation models with continuous and polytomous variables. British Journal of Mathematical and Statistical Psychology, 48(2), 339-358. https://doi.org/10.1111/j.2044-8317.1995.tb01067.x

- MEQ (2002). L’évaluation des apprentissages au préscolaire et au primaire. Cadre de référence. Québec, Canada : gouvernement du Québec.

- MEQ (2003). Politique d’évaluation des apprentissages. Formation générale des jeunes. Formation générale des adultes. Formation professionnelle. Québec, Canada : gouvernement du Québec.

- MEQ (2020). Référentiel de compétences professionnelles : profession enseignante. Repéré à https://cdn-contenu.quebec.ca/cdn-contenu/adm/min/education/publications-adm/devenir-enseignant/referentiel_competences_professionnelles_profession_enseignante.pdf?1606848024

- Monney, N. et Fontaine, S. (2016). La représentation sociale de l’évaluation des apprentissages chez des finissants d’un programme universitaire en éducation préscolaire et en enseignement primaire. Mesure et évaluation en éducation, 39(2), 59-84. https://doi.org/10.7202/1038242ar

- Moss, C. M. (2013). Research on Classroom Summative Assessment. Dans J. H. McMillan (dir.), SAGE Handbook of Research on Classroom Assessment (p. 235-255). Thousand Oaks, CA : SAGE Publications, Inc.

- Pajares, M. F. (1992). Teachers’ Beliefs and Educational Research : Cleaning Up a Messy Construct. Review of Educational Research. 62(3), 307-332. https://doi.org/10.2307/1170741

- Popham, W. J. (2014). Classroom Assessment. What Teachers Need to Know (7th ed.). Upper Saddle River, NJ : Pearson Education.

- Rogers, W. T., Cheng, L. et Hu, H. (2007). ESL/EFL Instructors’ Beliefs about Assessment and Evaluation. Canadian and International Education, 36(1), 39-61.

- Vause, A. (2010). Les croyances et connaissances des enseignants de l’école primaire à propos de l’acte d’enseigner. Éducation & Formation, 294, 13-19.

Liste des figures

Figure 1

Graphique des saturations de l’analyse factorielle exploratoire

Liste des tableaux

Tableau 1

Statistiques descriptives des énoncés lors du prétest (147 futurs enseignants)

Tableau 2

Statistiques descriptives des énoncés lors de la collecte de données (76 futurs enseignants)

10.7202/1041002ar

10.7202/1041002ar