Corps de l’article

Le séquençage du génome de plusieurs organismes vivants incluant celui de l’homme a provoqué une véritable révolution scientifique dont nous commençons à peine à mesurer les multiples implications. Le début de l’année étant une période propice à la réflexion sur les réalisations passées, et surtout sur ce que nous réserve l’avenir, nous nous penchons dans cet Éditorial sur quelques-unes des conséquences que la révolution génomique a déjà eues et continuera d’avoir sur la recherche biomédicale.

Au-delà des espoirs et des fantasmes que peut faire naître chez certains la conscience de voir exposé devant nos yeux le « code de la vie », la masse d’informations et notre capacité à appréhender « globalement » les questions biologiques ont changé de façon irrévocable notre façon de faire de la science. L’origine de cette révolution est ancrée au milieu du siècle dernier quand des pionniers tels que Chargaff, Crick, Franklin, Khoranna, Kornberg, Monod, Nirenberg, Pauling, Watson, et bien d’autres ont donné naissance à une nouvelle discipline, la biologie moléculaire. Malgré le pouvoir considérable que donnaient les nouvelles méthodes issues de cette discipline, cette première phase de la révolution était tranquille. Tranquille par son rythme, s’échelonnant sur plus d’une cinquantaine d’années, mais aussi tranquille parce qu’elle ne modifiait pas fondamentalement les étapes de la démarche scientifique qui était celle des sciences de la vie depuis près de deux siècles. Malgré la capacité de modifier, à l’échelle moléculaire, le fonctionnement des cellules jusqu’à atteindre l’intégrité ou la régulation de ses gènes, les méthodes de la biologie moléculaire ne transformaient pas notre façon de formuler une hypothèse. Celle-ci faisait toujours intervenir un savant mélange de connaissances, de raisonnement rigoureux et d’intuition qui constitue le « génie propre » du chercheur. L’approche demeurait largement réductionniste et « étapiste », proposant de mieux comprendre les rôles et fonctions d’un ou de quelques gènes à la fois. En donnant accès à l’ensemble des gènes et des protéines d’un être vivant, les méthodes de la génomique et de la protéomique ont provoqué un changement d’échelle. Il ne s’agit plus de formuler une hypothèse précise sur le rôle d’un gène donné et de concevoir les expériences permettant de la tester, mais plutôt d’appréhender l’implication potentielle de l’ensemble des gènes dans un - ou une série de - processus biologiques donnés.

La valeur intrinsèque des approches non biaisées proposées par les « Omiques » découle en partie de l’humilité que nous impose la complexité du vivant. Selon les prédictions les plus classiques, les quelques 25 000 gènes du génome humain se transforment en plus de 500 000 protéines lorsqu’on prend en compte les épissages alternatifs et les modifications post-traductionnelles. Considérant que le nombre de partenaires de chaque protéine est estimé au moins à cinq, la complexité des réseaux d’interactions possibles est intimidante. Quiconque a regardé les « interactomes » engendrés par des approches protéomiques à grande échelle ne peut qu’être perplexe quant à notre capacité à formuler la meilleure hypothèse à partir de cette masse de données. Bien que ces approches aient déjà produit leurs premiers fruits en permettant, entre autres, de proposer des fonctions pour des protéines dont on ignorait jusqu’à l’existence ou de révéler des rôles inattendus pour des protéines que l’on croyait bien connaître, l’intuition et les connaissances du chercheur ne suffisent plus à exploiter de manière optimale l’ensemble des données. Une contribution de plus en plus importante d’outils informatiques est donc devenue essentielle, tant pour la gestion des données que pour la formulation d’hypothèses objectives à partir de modèles mathématiques permettant d’appréhender de façon globale des systèmes complexes.

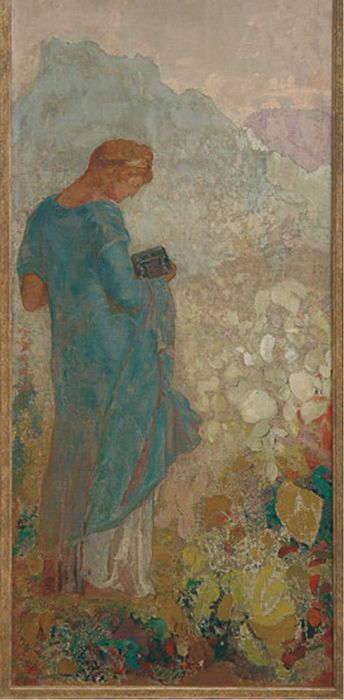

Autant par son rythme effréné que par son impact majeur sur notre conception de la recherche biomédicale, cette révolution des « omiques » est tout sauf tranquille. Grisantes par leur potentiel en apparence illimité, les méthodes « omiques » ne sont pas sans poser des défis majeurs, aussi bien sur le plan de la démarche scientifique que sur celui de l’organisation structurelle des activités de recherche. Devant les changements importants et les divers problèmes soulevés par les approches à grande échelle, certains rêvent de faire marche arrière et de refermer la boîte de Pandore, arguant que les « fléaux » s’échappant de la cassette annihilent les promesses qu’elles font miroiter. Parmi les difficultés et les dangers le plus souvent évoqués, il faut souligner la tâche complexe du contrôle de qualité des données produites par les études à grande échelle, les difficultés de comparaison de larges ensembles de données obtenues dans des conditions expérimentales différentes, l’assemblage et la dissémination des résultats sous des formats qui peuvent être exploités facilement par d’autres chercheurs et l’absence d’approches systématiques permettant de tester l’ensemble des trop nombreuses hypothèses engendrées.

Suscitant peut-être plus d’inquiétudes encore que les problèmes techniques évoqués plus haut et qui sauront sans doute être surmontés, ce sont les changements qu’imposent les approches « omiques » sur notre façon de faire de la recherche qui alimentent la réflexion et parfois la crainte. En effet, les ressources financières et humaines nécessaires à la réalisation des projets à grande échelle conduisent à la concentration de moyens importants au sein de grands groupes (réseaux, consortiums tels que celui qui vient, en un temps record, de terminer la première phase de l’ambitieux projet international HapMap) souvent constitués de chercheurs oeuvrant aux quatre coins du monde. Cela a amené plusieurs organismes « subventionnaires » à favoriser la formation d’équipes multidisciplinaires, théoriquement mieux armées pour résoudre les problèmes complexes engendrés par des projets génomiques ou protéomiques de grande envergure, et à investir une proportion importante des fonds disponibles dans la mise en place des infrastructures nécessaires à la conduite de ces projets. Bien que souvent couronnée de succès, cette approche dite de « big science » est génératrice d’angoisse chez un grand nombre de scientifiques qui voient là un risque de faire disparaître les chercheurs indépendants et de perdre ainsi une source importante d’originalité. Les petites équipes disciplinaires s’intéressant à des problèmes fondamentaux sont en effet perçues par beaucoup comme les unités de base sur lesquelles se fondent l’innovation, l’excellence et le maintien de programmes de formation de qualité.

Ces craintes sont justifiées et méritent notre attention. Il est toutefois illusoire de penser faire marche arrière et refermer la boîte de Pandore. Il nous faut au contraire la laisser ouverte pour en laisser sortir l’espérance que Zeus avait sagement placée au fond de la cassette. Cet espoir ne peut être porté que par des chercheurs ayant intégré les approches expérimentales à grande échelle sans pour autant être devenus des « ouvriers scientifiques » d’une entreprise sans âme et sans imagination. Il faudra donc nous assurer que les organismes subventionnaires et les institutions de recherche permettent et encouragent le développement non seulement de projets à grande échelle, mais aussi de projets scientifiques ciblés et originaux menés par de petites équipes dynamiques qui ont déjà démontré leur efficacité et leur savoir-faire. Il nous faut aussi préparer la prochaine génération de scientifiques pour qu’ils soient dotés des outils conceptuels et techniques nécessaires à la domestication de la masse de connaissances libérées. À nous de montrer notre capacité à récolter les fruits de cette connaissance sans sacrifier l’imagination et la passion sur l’autel de la révolution des « Omiques ».

À tous, nous souhaitons une recherche fructueuse et une année prospère.

Figure

Pandora

Liste des figures

Figure

Pandora