Résumés

Résumé

Cet article décrit, analyse et évalue la ludification d’un simulateur d’examen au travers de l’installation d’une dynamique d’octroi de badges. Destiné à des étudiants de première année en médecine, cet outil a pour objectif de les familiariser avec la résolution de QCM et de favoriser la maîtrise des prérequis et de la matière enseignée dans le cadre d’un cours de physique. Cette recherche met en évidence l’impact positif des badges sur la fréquentation du simulateur d’examen, la perception de sa contribution à l’étude et les performances à l’examen.

Mots-clés :

- Ludification,

- badges,

- didactique des sciences,

- physique,

- QCM,

- enseignement supérieur,

- bachelier,

- e-learning

Abstract

This article describes, analyses and questions the gamification of an examination simulator through the implementation of a dynamic system of badges used as awards. This tool targets first-year medicine students. Its purpose is to introduce students to MCQ tests and to improve their command of the pre-requisite knowledge and new topics taught in physics classes. This research highlights the positive impact of the examination simulator on participation, performance, and perception.

Keywords:

- Gamification,

- badges,

- science education,

- physics,

- MCQ,

- higher education,

- undergraduate,

- e-learning

Corps de l’article

Introduction

La littérature pédagogique a développé ces dernières années un intérêt pour la ludification d’activités d’apprentissage (The New Media Consortium [NMC], 2015, 2016), définie comme l’insertion de mécanismes de jeux dans d’autres contextes que celui du divertissement (Deterding, Dixon, Khaled et Nacke, 2011). Parmi les éléments ludiques potentiellement transposables au domaine de l’éducation, notamment sur les plateformes d’e-learning (Broer et Breiter, 2015), plusieurs auteurs mentionnent les badges (Abramovich, Schunn et Higashi, 2013; Antin et Churchill, 2011; Carey, 2012; Casilli et Knight, 2012; Knight et Casilli, 2012; Law, 2015; Shields et Chugh, 2017). Issus du scoutisme (Wu, Whiteley et Sass, 2015), les badges sont des indicateurs validés et visuels (Glahn, Specht et Koper, 2007) d’accomplissements et de mérites particuliers. Dans un contexte technopédagogique, « [b]adges are given to users for particular contributions to a site, such as performing a certain number of actions of a given type » (Anderson, Huttenlocher, Kleinberg et Leskovec, 2013, p. 95). Le présent article décrit, analyse et évalue la ludification d’un simulateur d’examen — une banque de questions similaires à celles de l’examen proposée en libre accès aux étudiants en première année de médecine pour travailler leur matière de physique — au travers de l’installation d’une dynamique d’octroi de badges. Ce simulateur d’examen est venu, en 2015, compléter une écologie d’apprentissage initiée dès 2012 (Marique et Hoebeke, 2014) en vue de :

-

favoriser la maîtrise des prérequis, facteur critique connu de réussite (Romainville, 2000). Cet objectif est particulièrement de mise en physique. En effet, le test d’orientation du secteur de la santé – épreuve obligatoire mais non contraignante organisée en préambule aux études de médecine – a révélé, ces trois dernières années, des moyennes variant, pour cette matière, de 1,7/20 à 3,9/20 (ARES, 2016; Detroz et al., 2016);

-

familiariser les étudiants avec les examens basés sur des questions à choix multiples (QCM), une modalité peu pratiquée en enseignement secondaire.

Quoique cet outil d’aide à la réussite ait bénéficié d’améliorations continues, prenant la forme de tests formatifs alignés sur l’examen final (Biggs, 1995; Leclercq, 1998; Tyler, 1949), de systèmes de feedback de plus en plus raffinés (Nicol et Macfarlane-Dick, 2006; Nicol et Milligan, 2006), de ventilations des questions en groupes thématiques pour une visibilité accrue de la structure de la matière, d’augmentations du nombre de questions encodées (passées de 80 à plus de 400) afin de prévenir un effet de redondance, d’articulations renforcées entre les activités en ligne et les activités en présentiel (Gibbs et Simpson, 2004) avec la mise en place de dates butoirs pour l’entraînement autonome et calquées sur la cadence des cours, et d’une amélioration de la communication autour des différentes activités proposées[1], les taux de fréquentation du simulateur d’examen se sont avérés décevants. À titre d’exemple, au cours de l’année universitaire 2014-2015, 17 % des étudiants se sont donné la peine de s’exercer sur ces tests formatifs en ligne.

Ce constat fait, la ludification s’est présentée comme une voie à explorer, eu égard à des résultats de recherche tendant à montrer que, insufflée dans des activités scolaires, elle peut augmenter la motivation et l’engagement des apprenants dans l’étude (Buckley et Doyle, 2016; Darejeh et Salim, 2016; Hamari, Koivisto et Sarsa, 2014; Hamari, Huotari et Tolvanen, 2015; Hamari, 2017; Huotari et Hamari, 2012; Lister, 2015; McGonigal, 2011). Trois hypothèses ont guidé la présente recherche dont l’objectif est de mesurer l’effet de la ludification sur la participation, la perception et la performance des étudiants (modèle des « 3 P », Verpoorten, et al., 2017) :

-

Hypothèse 1 — L’introduction de badges augmente la fréquentation du simulateur par les étudiants (données de participation)

-

Hypothèse 2 — L’acquisition de badges a un effet positif sur la performance à l’examen (données de performance)

-

Hypothèse 3 — Les étudiants expriment une satisfaction quant à leur expérience d’apprentissage avec l’outil (données de perception)

1. Méthodologie

A. Population

L’étude porte sur 555 étudiants inscrits en première année de médecine à l’Université de Liège pour l’année universitaire 2015-2016 et qui ont présenté, les 5 et 6 janvier 2016, l’examen final du cours de physique, intitulé « Bases physiques des sciences médicales, y compris les bases physiques de l’imagerie médicale » (Université de Liège, 2015)[2]. Vingt-trois autres étudiants, régulièrement inscrits, n’ont pas présenté l’examen de janvier. Seuls cinq d’entre eux avaient utilisé, très faiblement, les outils proposés en ligne. Les données les concernant ont été retranchées du matériel de l’étude.

B. Le simulateur d’examen

1) Plateforme

Dans sa version la plus récente, le simulateur se présente comme une banque de questions en concordance délibérée avec les questions de l’examen final, fournissant dès lors aux étudiants une forme d’exercices d’entraînement automatisés sur la matière (Marique, Van de Poël et Hoebeke, 2016). Le simulateur est proposé sur la plateforme d’e-learning institutionnelle Blackboard 9.1, dont le potentiel en matière de ludification a été établi par ailleurs (Broer et Breiter, 2015).

2) Interface et paramètres

Le simulateur permet à l’étudiant de générer à tout moment un test personnalisable selon trois paramètres :

-

Paramètre matière. La matière vue au cours a préalablement été décomposée en cinq grands thèmes : optique, électricité, mécanique, mécanique des fluides (appelée simplement « fluides » dans la suite de cette étude) et imagerie médicale (nommée « imagerie »). L’étudiant peut, à l’ouverture d’une session, choisir de s’entraîner à l’un de ces thèmes.

-

Paramètre temps. L’étudiant précise s’il veut consacrer 30, 60, 90 ou 120 minutes (figure 1) à son entraînement. Les tests de 30 minutes, qui rassemblent pour chaque thème des questions de compréhension de base ou portant sur les prérequis correspondants, sont cependant un passage obligé pour tous les étudiants. Leur réussite débloque la clé d’accès pour ce thème et ouvre à l’étudiant le choix de ses durées d’entraînement. Le nombre de questions figurant dans le test formatif dépendra de la durée sélectionnée. Un ratio de 10 questions par heure, identique aux conditions d’examens, est appliqué.

Figure 1

Le simulateur ludifié laisse à l’étudiant le choix de sa durée d’entraînement à la matière

-

Paramètre maîtrise. L’étudiant fixe, parmi quatre niveaux de difficulté, celui auquel il souhaite se mesurer (figure 2). Le niveau de difficulté du test dépend, lui, des questions qui le composent (voir section suivante).

Figure 2

L’étudiant évalue lui-même le niveau auquel il veut se tester

Selon les valeurs choisies par l’étudiant pour les trois paramètres, le système génère automatiquement un test formatif correspondant.

3) Niveaux de difficulté

Le simulateur comporte plus de 400 questions, conformes aux règles docimologiques de conception de QCM (Leclercq, 1986) et distribuées en 20 groupes croisant 5 domaines et 4 niveaux de difficulté. Pour établir ces derniers, l’équipe pédagogique a été sollicitée et chaque question a été caractérisée selon 4 critères (Marique, Van de Poël et Hoebeke, 2017) :

-

Abstraction — Ce critère est lié au niveau d’abstraction de l’énoncé et de la réponse attendue;

-

Réflexion — Ce critère estime le nombre d’étapes intellectuelles impliquées par la résolution;

-

Mixité — Ce critère mesure la diversité des chapitres dans lesquels se trouvent les informations à mobiliser pour résoudre le problème;

-

Niveau mathématique — Ce critère examine la compétence mathématique requise pour la résolution de la question de physique.

À chaque question, trois évaluateurs ont attribué un score de 1 à 3 sur chacun des critères. La moyenne des différents totaux fournis établit le niveau de difficulté de la question. Afin de vérifier la concordance des évaluations, le Kappa de Fleiss (Fleiss, 1981; Gwet, 2008) a été mesuré, révélant une concordance moyenne (0,4) jugée satisfaisante. Les tests de « niveau A » contiendront uniquement des questions de difficulté faible (niveaux 1 et 2). Les tests de « niveau B » agrégeront des questions de difficulté faible et moyenne (niveaux 1, 2 et 3). Quant aux tests de « niveau C », ils ajouteront aux questions de difficulté 1, 2 et 3 un niveau avancé (4) qui correspond à des résolutions d’exercices ou de problèmes complexes. Ce « niveau C » correspond au niveau de l’examen de janvier.

4) Les badges

Les badges collectionnés matérialisent les interactions que l’étudiant a eues avec le simulateur. Un tableau individuel des trophées affiche le niveau de maîtrise atteint sur le simulateur pour chacun des domaines (figure 3).

Figure 3

Tableau des trophées : l’étudiant no 21 a obtenu toutes les clés d’accès, un badge Or pour 4 domaines, Argent pour 4 domaines et Bronze pour 2 domaines

5) Déroulement

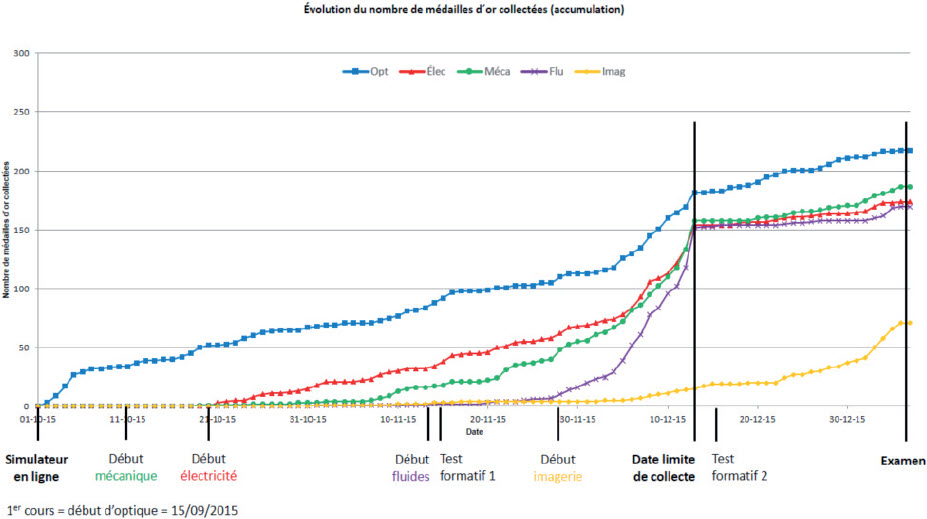

Figure 4

Outil d’aide à la réussite, le simulateur est accessible aux étudiants durant l’entièreté de l’année universitaire

Le simulateur ludifié a été mis à disposition peu après le début du cours (figure 4). Son usage a été laissé à l’initiative des étudiants, et ce, jusqu’à la fin de l’année universitaire (septembre 2016 dans ce cas-ci). Deux tests formatifs libres en amphithéâtre ont complété le dispositif. Le premier, à mi-parcours, était ouvert à tous (figure 4, 15 nov.). Le second, en fin de parcours, était conditionné par l’obtention de quatre médailles d’or sur cinq[3]. Une fois cette condition remplie, un pass (laissez-passer) personnel (figure 5) était alors automatiquement généré, donnant accès à l’amphithéâtre où se déroulait le test formatif no 2 (figure 4, 15 déc.).

Figure 5

Détenir 4 médailles d’or débloque automatiquement un pass (laissez-passer) pour le test formatif no 2

6) Instruments et sources de données

Trois sources de données ont été mobilisées pour traiter les hypothèses :

-

Les traces. Un suivi des interactions des étudiants avec le simulateur ludifié a permis de relever le nombre total de médailles obtenues, leurs niveaux, la médaille maximale obtenue dans chaque matière ainsi que la date d’obtention des différentes médailles pour chaque étudiant.

-

Les scores. Pour chaque étudiant, les notes globales et par matière obtenues à l’examen certificatif de janvier, clôturant le cours de physique, ont été recueillies. Cet examen a eu lieu durant deux périodes de quatre heures chacune.

-

Le questionnaire de rétroaction. Les étudiants ont été invités à répondre, sur une base volontaire, à une enquête de satisfaction (figure 4) portant aussi bien sur les activités obligatoires en amphithéâtre et en classe que sur les activités en ligne et les remédiations. Vingt-six questions composaient le questionnaire, dont trois en rapport direct avec le simulateur d’examen :

-

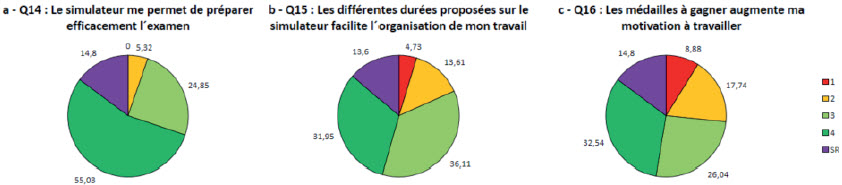

Q14. Le simulateur d’examen me permet de préparer efficacement l’examen. Estimez à quel point cette affirmation est vraie en donnant une valeur comprise entre 1 et 4. 1 correspond à « absolument pas d’accord »; 4 à « tout à fait d’accord ».

-

Q15. Les différentes durées proposées dans le simulateur facilitent ma manière de travailler.

Estimez à quel point cette affirmation est vraie en donnant une valeur comprise entre 1 et 4. 1 correspond à « absolument pas d’accord »; 4 à « tout à fait d’accord ».

-

Q16. Les médailles à collectionner dans le simulateur augmentent ma motivation à travailler.

-

Estimez à quel point cette affirmation est vraie en donnant une valeur comprise entre 1 et 4. 1 correspond à « absolument pas d’accord »; 4 à « tout à fait d’accord ».

Différentes annonces sur la plateforme en ligne et plusieurs messages électroniques généraux ont été envoyés aux étudiants, entre le second test formatif et l’examen de janvier, pour les inciter à répondre au questionnaire.

2. Résultats

Hypothèse 1 — L’introduction de badges augmente la fréquentation du simulateur d’examen par les étudiants (données de participation)

En comparaison avec les 17 % de fréquentation observés au cours des années précédentes sur les tests non ludifiés (toutes choses égales par ailleurs), le simulateur ludifié a attiré une proportion d’étudiants oscillant entre 37,12 % et 74,23 % selon le thème (tableau 1). La fréquentation par matière décroît au cours du trimestre, la dernière matière couverte par le cours (imagerie) obtenant le niveau le plus bas (37,12 %) alors que l’optique, vue en premier lieu, a généré 74,23 % de fréquentation.

Tableau 1

Une fréquentation du simulateur en nette progression mais avec des variations au cours du trimestre

Au-delà de cette fréquentation globale, trois observations se dégagent (tableau 2) :

-

Les taux d’acquisition des différents badges (tableau 2) présentent des évolutions similaires : toutes médailles confondues, ils décroissent au cours du trimestre. Par exemple, la clé d’accès en imagerie a été remportée par 32,79 % alors que la clé d’accès en optique a été remportée par 66,13 %.

Tableau 2

Taux d’acquisition des différents badges : plus la matière est vue tardivement, plus la fréquentation baisse

-

Le même phénomène vaut pour les médailles d’or. Les pourcentages d’étudiants les obtenant sont plus élevés (de 32,07 % à 40,72 %) pour les quatre premières matières que pour l’imagerie (11,89 %). La troisième colonne indique le pourcentage d’étudiants ayant collecté une médaille en fonction du nombre total de ceux qui ont gagné la clé d’accès dans cette matière. Les médailles d’or en optique, mécanique, électricité et mécanique des fluides ont été recueillies par 59,21 à 63,80 % des étudiants ayant la clé d’accès dans ces matières respectives. Par contre, seuls 36,26 % des étudiants possédant la clé d’accès en imagerie ont également remporté la médaille d’or dans cette matière. Les étudiants ont donc négligé la dernière médaille d’or. Le fait que la contrainte exigée pour participer au second test formatif n’intègre pas cette médaille d’or en imagerie médicale a certainement influencé ce résultat.

-

Les étudiants présentent une tendance forte à « contourner » les médailles d’argent et de bronze au profit des médailles d’or qui leur ouvrent les portes du second test formatif. Cela est particulièrement le cas en mécanique (27,45 % des étudiants ayant gagné la clé dans cette matière acquièrent la médaille de bronze et 24,84 % la médaille d’argent contre 61,44 % pour la médaille d’or), en électricité (36,84 % bronze; 29,28 % argent; 59,21 % or) et en mécanique des fluides (23,30 % bronze; 17,59 % argent; 63,80 % or). Cette focalisation sur les médailles d’or s’accentue à l’approche du test formatif no 2. La figure 6 fait voir que quelques médailles d’or sont collectées dès le début des séances de cours. C’est le cas par exemple en électricité ou encore en mécanique des fluides. Après analyse, il est apparu qu’il s’agit systématiquement d’étudiants répétant leur première année et qui ont donc déjà eu ces séances un an plus tôt. Ceci est particulièrement marquant dans le cas de l’imagerie. À la date limite de collecte des médailles d’or pour le test formatif, 15 étudiants, tous répétant leur première année, ont déjà collecté la médaille en imagerie médicale alors que cette matière ne fait pas partie des conditions et que les séances de cours portant sur cette matière ne sont pas toutes données.

Figure 6

L’approche du test formatif no 2 précipite l’acquisition des médailles d’or en optique, mécanique, électricités et fluides, conditions d’accès à sa passation

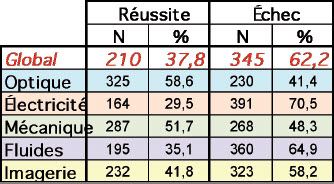

Hypothèse 2 — L’acquisition de badges a un effet sur la performance à l’examen (données de performance)

Sur les 555 étudiants ayant présenté l’examen de janvier 2016, 210 l’ont réussi et 345 ont échoué (tableau 3). Le taux de réussite s’établit donc à 37,8 %. Le tableau 3 fournit pour ces mêmes étudiants les taux de réussite thème par thème.

Tableau 3

Taux de réussite global et thème par thème

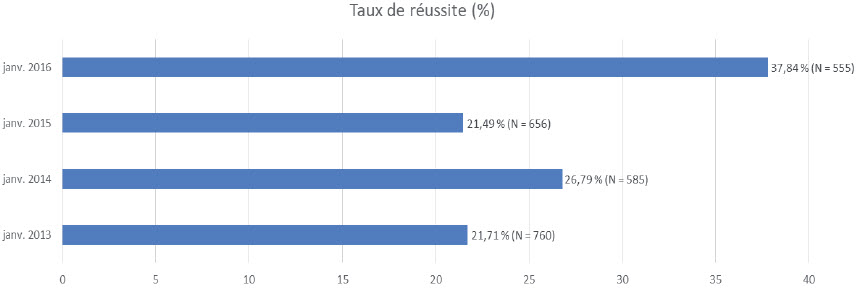

Une comparaison avec les années précédentes (figure 7) fait ressortir une progression importante du taux de réussite l’année où le simulateur ludifié a été introduit. Une application du chi carré indique une différence significative entre les taux de réussite des sessions de janvier 2013, 2014 et 2015, et celui de janvier 2016 (khi²(4) = 53,3, p < 0,0001).

Cette différence significative peut-elle raisonnablement être imputée à l’introduction de la ludification par badges et non à des variables non contrôlées que seraient par exemple des niveaux de départ différents dans les cohortes ou des effets enseignants, etc.? S’il est impossible d’avoir une réponse absolue à cette question, différents résultats convergent pour suggérer une influence de la ludification. Un test de Forsythe-Brown (Brown et Forsythe, 1974) enregistre des différences significatives de moyenne à l’examen entre les groupes ayant obtenu diverses quantités de clés d’accès, F(5, 239,7) = 55,38, p < 0,0001 (figure 8a) ou collecté diverses quantités de médailles d’or, F(5, 13,93) = 68,25, p < 0,0001 (figure 8b).

Figure 7

Évolution importante du taux de réussite mesuré sur l’examen de physique de janvier depuis l’introduction de notre simulateur d’examen ludifié

Figures 8a et 8b

Augmentation de la moyenne avec le nombre de clés d’accès collectées et de médailles d’or obtenues

Hypothèse 3 — Les étudiants expriment une satisfaction quant à leur expérience d’apprentissage avec l’outil (données de perception)

Les données de perception récoltées auprès de 169 étudiants ayant répondu à l’enquête (30,45 % de la population qui a présenté l’examen) manifestent une réception globalement positive de l’outil. En effet, 79,9 % des répondants jugent favorablement son utilité pour l’étude et son efficacité dans la préparation à l’examen (figure 9a). Dans 68 % des avis reçus, le simulateur est crédité d’une fonction de facilitateur de l’organisation du travail scolaire engendrée par la possibilité de personnalisation de l’outil sur les durées de test (figure 9b). Enfin, le fait d’avoir des médailles à gagner engendre une augmentation de motivation à s’investir dans le travail et l’étude pour 58,6 % des participants à cette enquête (figure 9c).

Figures 9a (Q14), 9b (Q15), 9c (Q16)

Les perceptions étudiantes du simulateur sont positives quant à son utilité pour l’apprentissage, son caractère motivant et ses possibilités de personnalisation (1 = pas du tout d’accord; 2 = plutôt pas d’accord; 3 = assez d’accord; 4 = tout à fait d’accord)

3. Discussions

La présente étude avait pour intention de présenter et d’évaluer l’introduction d’une ludification par badges dans un simulateur d’examen. Cette initiative technopédagogique a été mise à l’essai avec un nombre important d’étudiants. Les données issues de ce test confirment les hypothèses d’un effet sur la participation, la performance et les perceptions des étudiants. Ces résultats sont à présent remis en contexte, discutés et assortis, pour chaque paramètre, de perspectives de régulation et de recherche.

A. Badges et participation

L’intention pédagogique des enseignants ayant mis en oeuvre la ludification par badges était d’augmenter la fréquentation du simulateur d’examen et donc les occasions d’entraînement à la matière. À première vue, les résultats obtenus semblent accréditer la justesse de l’intuition : l’augmentation de l’usage de l’outil est très significative suite à l’introduction de la mécanique des badges. Ce résultat doit cependant être interprété avec circonspection. En effet, l’année de la ludification du simulateur est aussi celle de l’instauration d’un concours en fin de première année de bachelier afin de limiter le nombre d’étudiants autorisés à passer en deuxième année. Il est dès lors malaisé de discriminer ce qui, dans la fréquentation accrue de l’outil, revient à ses propriétés internes ou à des facteurs externes. À tout le moins est-il légitime d’observer que :

-

la différence est forte comparativement aux 17 % enregistrés en 2014-2015 avec l’artefact non ludifié;

-

cette adoption renforcée de l’outil semble en indiquer le caractère approprié aux yeux des étudiants;

-

l’engagement accru dans l’étude est un bénéfice qui a été porté au crédit de la ludification par d’autres études portant sur les badges (Antin et Churchill, 2011; Broer et Breiter, 2015; Kapp, 2012; Shields et Chugh, 2017).

L’observation précise des types de badges collectés soulève, elle aussi, une ambiguïté. La prédilection des étudiants pour les médailles d’or est en effet un résultat. Faut-il interpréter ce phénomène comme un raisonnement utilitariste des étudiants : les médailles d’or étant les plus proches du niveau du test, elles sont perçues comme la meilleure préparation à celui-ci et sont donc plus recherchées. Ou bien le mécanisme de ludification a-t-il pu soutenir chez certains étudiants la recherche des badges les plus valorisants? Dans la même veine, le relatif « dédain » pour la dernière médaille d’or en imagerie médicale, non « scolairement » exigée pour l’accès à la séance bonus, peut s’expliquer par des étudiants principalement motivés par la récompense. Mais il est aussi probable que, parmi les 71 étudiants ayant fait l’effort de l’obtenir, on en trouve qui soient motivés par le dispositif lui-même et soucieux, soit de leur « tableau de chasse », soit de se mesurer à leur propre niveau de compétence, ou les deux.

Enfin, le dispositif ludifié semble être exploité par deux groupes distincts : les « omnibus » et les « TGV ». Pour une portion des étudiants, la scénarisation pédagogique organisée autour du simulateur ludifié a, à l’évidence, favorisé un travail régulier qui les a fait s’arrêter à « toutes les stations ». Ces étudiants travaillent régulièrement et passent donc les tests, successivement et au moment prévu, en vue d’obtenir les médailles liées à chacun des thèmes couverts dans les cours. Mais le dispositif s’est aussi prêté aux « TGV », profil qui se manifeste dans le pic important de collecte de médailles juste avant la date limite permettant l’accès au second test formatif bonus en amphithéâtre[4]. Il est raisonnable de penser que ce dispositif a permis de stimuler les étudiants « TGV » plus tôt qu’à l’habitude. En effet, nous pouvons penser qu’ils ont avancé dans le temps le pic de travail important qu’ils doivent fournir en vue de l’examen ou qu’ils ont doublé ce pic (avant test formatif / avant examen). Dans le premier cas, il s’agit donc d’un simple déplacement de pic qui n’a a priori que l’intérêt de laisser un laps de temps de réaction plus important à l’étudiant dans le cas où il se rend compte qu’il a beaucoup de lacunes. Dans le second cas, le temps d’étude étant plus long, une maîtrise plus approfondie de la matière pourra probablement être observée.

À côté des « TGV » et des « omnibus », les résultats permettent de distinguer un troisième groupe de bénéficiaires spécifiques du dispositif : les quelques étudiants qui décrochent la médaille d’or dans une matière dès le début des séances de cours en présentiel. Un travail d’établissement de ces profils montre qu’il s’agit d’étudiants recommençant leur année et ayant déjà donc eu des cours similaires auparavant.

Il semble dès lors qu’un dispositif créé à destination de tous les étudiants, sans distinction de leurs profils, soit propre à soutenir des stratégies diverses de travail de la matière (Verpoorten, Glahn, Kravcik, Ternier et Specht, 2009) et donc une certaine forme de différentiation de l’apprentissage, en plus de celle qui est offerte par les différents paramètres de création de test.

B. Badges et performance

Par-delà la fréquentation de l’outil proprement dite, la performance va elle aussi de pair avec l’insertion de mécanismes de ludification. Pris comme variable dépendante, le taux de réussite à l’examen apparaît fortement lié, pour toutes les matières, au nombre de clés d’accès collectées ou de médailles d’or. Certes, ces observations tentent d’établir, comme souvent dans le domaine des initiatives d’aide à la réussite, la cause et l’effet : Le simulateur ludifié a-t-il partiellement contribué à façonner des étudiants performants ou sont-ce les étudiants déjà performants qui ont perçu la valeur du simulateur? Constitue-t-il une simple boîte d’enregistrement de la valeur initiale des étudiants ou bien est-il en lui-même catalyseur de progression? Sur la base des résultats présentés ici, il est cependant concevable de suggérer une contribution positive intrinsèque de la ludification. Cette suggestion peut se conforter, d’une part, par la littérature existante qui fait écho à de pareilles influences dans des dispositifs de badges de moindre envergure (Hamari, 2017) et, d’autre part, par un schéma explicatif plausible. Dans son modèle de la motivation, Viau (2009) fait dépendre l’engagement et la persévérance dans une activité d’apprentissage de la perception de sa valeur, de sa contrôlabilité et de la compétence qu’on est capable d’y montrer. En jouant la carte ludique des badges, tels qu’ils figurent dans de nombreux minijeux populaires bien connus des générations actuelles (Frazer, Argles et Wills, 2007), en permettant un paramétrage individuel de la séquence d’entraînement et en multipliant les occasions de mesurer son niveau de maîtrise, la ludification a pu activer différents leviers de motivation. L’effet de la ludification sur la performance serait donc indirect mais réel : la motivation renforcée à s’entraîner engendrerait un usage plus intense du simulateur, générant une fréquentation de la matière plus importante et donc une meilleure préparation à l’examen. Cet effet de contact fréquent et régulier avec la matière, qui fait précéder la performance finale de multiples performances intermédiaires, pourrait d’ailleurs ne pas tenir uniquement au simulateur lui-même, mais aussi à la scénarisation pédagogique orchestrée entre périodes en ligne et périodes de cours présentiels, transformant, pour les étudiants « omnibus » en tout cas, l’expérience du cours en une forme de classe inversée. Le renforcement des occasions de pratique, accessible mais non activé dans la version non ludifiée du simulateur et obtenu plus largement par l’insertion des badges, pourrait enfin avoir trouvé une pertinence particulière dans un domaine de la physique où l’automatisation de certaines opérations mentales est nécessaire et peut s’acquérir par la pratique de tests (Roediger et Karpicke, 2006). Quoique certains problèmes offerts par le simulateur ludifié fassent appel à la réflexion, il est vrai que sa pratique relève globalement d’une forme d’exercices d’entraînement et de répétition souvent considérée comme un repoussoir par les étudiants dont la progression exige cependant qu’ils s’y appliquent. La ludification peut ici fournir une stimulation adéquate de l’événement d’apprentissage « exercisation / guidage » (Verpoorten, Poumay et Leclercq, 2007), la pédagogie n’étant pas que, mais aussi, un moyen de « faire passer » d’une façon plus agréable des apprentissages qui ne le sont pas a priori.

C. Badges et perceptions

La réception de ce dispositif par les étudiants est globalement positive (section 3). Le simulateur est crédité d’une efficacité par rapport à l’apprentissage (figure 9a). L’intervention pédagogique que représente le simulateur est jugée fonctionnelle par les étudiants (Clarebout et Elen, 2009). Les propos autodéclarés collectés dans le questionnaire de rétroactionpointent aussi vers la perception positive d’une efficience (figure 9b), c’est-à-dire d’un ratio « temps consacré / bénéfices pour l’étude » satisfaisant (Elen et Lowyck, 1998). Ainsi, 70 % des étudiants attribuent au simulateur (figure 9b) un rôle facilitateur dans l’organisation du travail. Sur ce point, il est possible que la progression des médailles ait permis à certains étudiants, dont les doublants, de se mesurer d’entrée de jeu (autrement dit, après avoir obtenu la clé d’accès) à l’or dans la perspective de discerner ce qu’ils savent ou non en vue précisément d’une organisation plus rationnelle de leur temps. Il se pourrait aussi que les étudiants aient plus tenté d’obtenir la médaille d’or (tableau 2) pour les domaines de la physique où il existe des prérequis enseignés durant les années antérieures, et donc avec lesquels ils sont plus familiers. C’est le cas de l’optique, de la mécanique et de l’électricité.

À côté de ces perceptions qui, triangulées avec les données de participation et de performance, fournissent une image globalement positive de l’initiative, il ne faut pas minorer la part d’étudiants qui n’ont pas perçu les médailles comme étant particulièrement motivantes (figure 8c). Auraient-ils utilisé le simulateur même non ludifié? Envisager cette question, c’est s’engager dans une discussion sur les types de motivation (Ryan et Deci, 2000). Il est parfois reproché aux approches recourant aux jeux et aux récompenses de stimuler une motivation extrinsèque. Ce reproche pourrait être adressé à la ludification du simulateur. Les étudiants ne doivent-ils pas, par l’entremise des enseignants, développer avant tout un plaisir internalisé d’apprendre (Meirieu, 2014), une passion gratuite pour leur objet d’étude, indépendamment de toute considération stratégique liée à une récompense? Le simulateur ludifié ne fait-il pas basculer la fréquentation de la matière dans une forme de logique comptable fondée sur des badges et bien loin des idéaux universitaires? L’expérience menée peut éclairer cette question à plusieurs niveaux. Tout d’abord, il faut observer que le cours de physique est le seul, sur le curriculum complet des étudiants, à proposer un exercice ludifié. À l’heure actuelle, celui-ci participe donc davantage d’une diversification des manières d’apprendre que d’une sorte de dictature du ludique. On peut suggérer aussi que compter d’entrée de jeu sur la seule motivation intrinsèque, particulièrement en première année d’université, peut refléter une vision non progressive ou développementale de la motivation. À ce titre, il est intéressant de rappeler que dans leur article princeps, Ryan et Deci (2000) décrivent et organisent six types de motivation dont quatre relèvent de la motivation… extrinsèque. Dans le cas du simulateur ludifié, gagner progressivement en maîtrise du domaine par la fréquentation plus assidue et plus agréable de la matière pourrait-il aussi induire un accroissement de la motivation intrinsèque, la ludification et ses récompenses extrinsèques étant une voie d’accès à une motivation plus interne?

4. Perspectives

La présente étude s’inscrit dans une réflexion générale sur les apports possibles des mécanismes de jeu à l’apprentissage. Ses résultats ouvrent des perspectives concrètes d’amélioration du dispositif et des perspectives plus spéculatives de recherche. Concernant les régulations, le dispositif sera assurément reconduit, tant ses initiateurs ont été positivement surpris par son appropriation générale, la dernière couche de ludification étant finalement ce qui donne du sens à tous les efforts précédents orientés vers l’accroissement de l’usage. Plus précisément, le cours intégrera, dans sa séquence introductive, des données issues de la première cohorte, montrant à la fois l’intérêt du dispositif par rapport notamment à l’examen final et à un travail régulier (« aplatissement » des pics observés dans le graphique 1). Les enseignants porteurs du dispositif prévoient aussi de déterminer dans quelle mesure le recours à d’autres mécanismes de ludification (Bunchball Inc., 2010; Dignan, 2011; Lister, 2015) serait susceptible de consolider ou de diversifier les apprentissages véhiculés par celui-ci.

En matière de recherche, seules des études supplémentaires à définir seront en mesure d’apprécier plus précisément si l’octroi de badges peut, par lui-même, jouer un rôle positif dans l’entraînement à une matière. Cette investigation ne sera cependant pas des plus aisées, car elle nécessitera de connaître le niveau de départ des joueurs ou d’établir un dispositif expérimental classique avec groupes expérimental et témoin, difficilement envisageable à l’échelle d’un trimestre entier et au regard du contexte institutionnel. À l’avenir, il sera aussi intéressant d’analyser les traces des différentes tentatives de passation de test dans le temps. Cela devrait permettre de mettre en évidence différents profils d’utilisation de l’outil et donc différents profils de travail. Il sera, par exemple, important de mettre en lien l’influence du moment de l’obtention d’une médaille avec le score obtenu à l’examen par l’étudiant dans cette matière, et ce, en fonction de son profil de travail. Ces profils devront tenir compte également des données de départ de l’étudiant tant sur ses formations antérieures et son niveau de maîtrise des prérequis que sur des aspects sociodémographiques. Les recherches pourront aussi, sur un plan plus général, se donner pour objectif l’investigation des liens causaux ou de renfort mutuel de la ludification, de la motivation même à s’entraîner et de la fréquentation des outils d’entraînement proposés.

En finale, il est important de souligner que le simulateur ludifié a été réalisé sans grands moyens pour des résultats honorables sur le plan de la performance, de la participation et de la perception. Cette forme d’efficience et le potentiel concret de transposition à d’autres matières expliquent sans doute l’intérêt manifesté par des collègues et des facultés pour le simulateur d’examen.

Parties annexes

Notes

-

[1]

En particulier, les corrélations mesurées sur les années antérieures entre les taux de participation aux différentes activités en ligne proposées (tests formatifs en ligne, résolution de problèmes…) et les notes obtenues à l’examen de janvier sont présentées lors du premier cours de l’année en septembre.

-

[2]

Le passage en deuxième année de bachelier est conditionné par la réussite d’au moins 45 des 60 crédits liés aux cours de première année, ainsi que par le fait d’être classé en ordre utile à l’issue du concours organisé en juin 2016. Ce concours, portant uniquement sur les matières du second quadrimestre (et donc pas la physique), a pour but de limiter le nombre d’étudiants accédant à l’année supérieure afin que ceux-ci soient certains d’obtenir, à l’issue de leurs études, le numéro INAMI leur donnant le droit d’exercer la médecine. L’influence de ce concours sur les résultats observés dans cette étude sera évoquée dans la partie « Discussions », mais il est bon de signaler d’entrée de jeu que celle-ci est possible.

-

[3]

La médaille d’or en imagerie médicale n’est pas requise pour participer au second test formatif. Cette décision, communiquée aux étudiants dès la mise en ligne de l’outil, a été justifiée par le fait que toutes les activités en présentiel pour ce thème n’étaient pas clôturées à la date limite de collecte des médailles.

-

[4]

Il est à noter que pour la matière vue juste avant la date limite, la mécanique des fluides, on observe naturellement un effet combiné de ces deux profils (figure 6).

Références

- Abramovich, S., Schunn, C. et Higashi, R. M. (2013). Are badges useful in education? It depends upon the type of badge and expertise of learner. Educational Technology Research and Development, 61(2), 217-232. Récupéré du site de C. Schunn : http://lrdc.pitt.edu/schunn

- Académie de recherche et d’enseignement supérieur (ARES). (2016, 9 septembre). 2642 étudiants ont passé en 2016 le test d’orientation aux études du secteur de la santé. Récupéré le 12 octobre 2017 du site de l’ARES : http://ares-ac.be

- Anderson, A., Huttenlocher, D., Kleinberg, J. et Leskovec, J. (2013). Steering user behavior with badges. Dans D. Schwabe, V. Almeida et H. Glaser (dir.), Proceedings of the 22nd International Conference on World Wide Web (p. 95-106). New York, NY : ACM. Récupéré du site de J. Leskovec : http://www-cs.stanford.edu/people/jure

- Antin, J. et Churchill, E. F. (2011). Badges in social media: A social psychological perspective. Dans CHI 2011 Gamification Workshop Proceedings. Récupéré du site du Gamification Research Network : http://gamification-research.org

- Biggs, J. (1995). Enhancing teaching through constructive alignment. Higher Education, 32(3), 347-364. Récupéré du site Agricultural and Resource Economics de l’Université Western Australia : http://www.are.uwa.edu.au

- Broer, J. et Breiter, A. (2015). Potentials of gamification in learning management systems: A qualitative evaluation. Dans G. Conole, T. Klobučar, C. Rensing, J. Konert et E. Lavoué (dir.), Design for Teaching and Learning in a Networked World. Proceedings of 10th European Conference on Technology Enhanced Learning (EC-TEL 2015). Lectures notes in computer sciences, vol. 9307 (p. 389-394). Cham, Allemagne : Springer. doi:10.1007/978-3-319-24258-3_29 Manuscrit récupéré du site de l’Institute for Information Management Bremende : http://ifib.de

- Brown, M. B. et Forsythe, A. B. (1974). Robust tests for the equality of variances. Journal of the American Statistical Association, 69(346), 364-367. doi:10.1080/01621459.1974.10482955

- Buckley, P. et Doyle, E. (2016). Gamification and student motivation. Interactive Learning Environments, 24(6), 1162-1175. doi:10.1080/10494820.2014.964263

- Bunchball Inc. (2010). Gamification 101: An introduction to the use of game dynamics to influence behavior (White paper). Récupéré du site JND Global : http://jndglobal.com

- Carey, K. (2012). A future full of badges. Chronicle of Higher Education, 58(32), A60.

- Casilli, C. et Knight, E. (2012). 7 things you should know about badges. Récupéré du site EDUCAUSE : http://educause.edu

- Clarebout, G. et Elen, J. (2009). The complexity of tool use in computer-based learning environments. Instructional Science, 37(5), 475-486. doi:10.1007/s11251-008-9068-3

- Darejeh, A. et Salim, S. S. (2016). Gamification solutions to enhance software user engagement: A systematic review. International Journal of Human-Computer Interaction, 32(8), 613-642. doi:10.1080/10447318.2016.1183330

- Deterding, S., Dixon, D., Khaled, R. et Nacke, L. (2011). From game design elements to gamefulness: Defining gamification. Dans Proceedings of the 15th International Academic MindTrek Conference: Envisioning Future Media Environments (p. 9-15). New York, NY : ACM.

- Detroz, P., Monseur. C., Romainville, M., Crahay, V., Demeuse, M., Dehon, C., ... Piazza, A. (2016). Rapport de l’étude visant à évaluer le dispositif appliqué en sciences médicales pour l’Académie de recherche et d’enseignement supérieur. Récupéré du site de l’Académie de recherche et d’enseignement supérieur (ARES) : http://ares-ac.be

- Dignan, A. (2011). Game frame: Using games as a strategy for success. New York, NY : Simon and Schuster.

- Elen, J. et Lowyck, J. (1998). Students’ views on the efficiency of instruction: An exploratory survey of the instructional metacognitive knowledge of university freshmen. Higher Education, 36(2), 231-252. doi:10.1023/A:1003227502618

- Fleiss, J. L. (1981). Statistical methods for rates and proportions (2e éd.). New York, NY : John Wiley.

- Frazer, A., Argles, D. et Wills, G. (2007). Is less actually more? The usefulness of educational mini-games. Dans J. M. Spector, D. G. Sampson, T. Okamoto, Kinshuk, S. A. Cerri, ... A. Kashihara (dir.), Proceedings of the Seventh IEEE International Conference on Advanced Learning Technologies (ICALT 2007) (p. 533-537). Récupéré du répertoire de l’Université de Southampton : http://eprints.soton.ac.uk

- Gibbs, G. et Simpson, C. (2004). Conditions under which assessment supports students’ learning. Learning and Teaching in higher education, 2004/5(1), 3-31. Récupéré du répertoire de l’Université de Gloucestershire : http://eprints.glos.ac.uk

- Glahn, C., Specht, M. et Koper, R. (2007). Smart indicators on learning interactions. Dans E. Duval, R. Klamma et M. Wolpers (dir.), Creating new learning experiences on a global scale. Proceedings of the 2nd European Conference on Technology Enhanced Learning (EC-TEL 2007). Lecture notes in computer science, vol. 4753 (p. 56-70). Berlin, Allemagne : Springer. doi:10.1007/978-3-540-75195-3_5 Récupéré du répertoire de l’Open Universiteit : http://dspace.ou.nl

- Gwet, K. L. (2008). Computing inter-rater reliability and its variance in the presence of high agreement. British Journal of Mathematical and Statistical Psychology, 61, 29-48. Récupéré du répertoire de l’auteur : http://agreestat.com

- Hamari, J. (2017). Do badges increase user activity? A field experiment on the effects of gamification. Computers in Human Behavior, 71, 469-478. doi:10.1016/j.chb.2015.03.036 Récupéré du répertoire de l’auteur : http://people.uta.fi/~kljuham

- Hamari, J., Huotari, K. et Tolvanen, J. (2015). Gamification and economics. Dans S. P. Walz et S. Deterding (dir.), The Gameful world: Approaches, issues, applications (p. 139-161). Cambridge, MA : MIT Press. Récupéré du répertoire de J. Hamari : http://people.uta.fi/~kljuham

- Hamari, J., Koivisto, J. et Sarsa, H. (2014). Does gamification work? A literature review of empirical studies on gamification. Dans R. H. Sprague (dir.), Proceedings of the 47th Hawaii International Conference on System Science (HICSS 2014) (p. 3025-3034). Récupéré du site de la conférence : http://computer.org/csdl/proceedings/hicss/index.html

- Huotari, K. et Hamari, J. (2012). Defining gamification: A service marketing perspective. Dans Proceedings of the 16th International Academic MindTrek Conference (p. 17-22). New York, NY : ACM.

- Kapp, K. M. (2012). The gamification of learning and instruction: Game-based methods and strategies for training and education. New York, NY : John Wiley.

- Knight, E. et Casilli, C. (2012). Mozilla open badges. Dans D. G. Oblinger (dir.), Game changers: Education and information technologies (p. 279-284). Récupéré du site EDUCAUSE : http://educause.edu

- Law, P. (2015). Digital badging at The Open University: Recognition for informal learning. Open Learning: The Journal of Open, Distance and e-Learning, 30(3), 221-234 https://doi.org/10.1080/02680513.2015.1104500

- Leclercq, D. (1986). La conception des questions à choix multiple. Bruxelles, Belgique : Labor.

- Leclercq, D. (1998). Pour une pédagogie universitaire de qualité (vol. 224). Sprimont, Belgique : Mardaga.

- Lister, M. C. (2015). Gamification: The effect on student motivation and performance at the post-secondary level. Issues and Trends in Educational Technology, 3(2), 1-22. Récupéré de http://journals.uair.arizona.edu/index.php/itet

- Marique, P.-X. et Hoebeke, M. (2014). Plate-forme interactive au service des grandes populations d’étudiants suivant un cours de physique. Dans C. Frasson, J.-M. Labat, F. Gandon, D. Cassagne, C. Jonquet, ... P. Pujas (dir.), Actes de la 9e conférence des Technologies de l’information et de la communication pour l’enseignement (TICE 2014). Récupéré du répertoire ORBi de l’Université de Liège : http://orbi.uliege.be

- Marique, P.-X., Van de Poël, J.-F. et Hoebeke, M. (2016, janvier). Quel outil d’entraînement pour des étudiants en médecine évalués par QCM en physique?. Communication présentée au 28e colloque de l’ADMEE Europe, Lisbonne, Portugal. Résumé récupéré du site du colloque : http://admee2016.ie.ulisboa.pt

- Marique, P.-X., Van de Poël, J.-F. et Hoebeke, M. (2017, janvier). Recyclage de questions à choix multiples d’épreuves certificatives de physique en items de tests formatifs en ligne. Communication présentée au 29e colloque de l’ADMEE Europe 2017, Dijon, France. Résumé récupéré du site du colloque : http://agrosupdijon.fr/actes

- McGonigal, J. (2011). Reality is broken: Why games make us better and how they can change the world. Londres, R.-U. : Penguin.

- Meirieu, P. (2014). Le plaisir d’apprendre. Paris, France : Autrement.

- Nicol, D. J. et Macfarlane-Dick, D. (2006). Formative assessment and self-regulated learning: A model and seven principles of good feedback practice. Studies in Higher Education, 31(2), 199-218. Récupéré du site du projet REAP de l’Université de Strathclyde : http://ewds.strath.ac.uk/REAP

- Nicol,D. et Milligan, C. (2006). Rethinking technology supported assessment practices in relation to the seven principles of good feedback practice. Dans C. Bryan et K.V. Clegg (dir.), Innovative assessment in higher education (pp. 64-77). London : Routledge.

- Roediger, H. L. et Karpicke, J. D. (2006). Test-enhanced learning: Taking memory tests improves long-term retention. Psychological Science Education, 17, 249-255. doi:10.1111/j.1467-9280.2006.01693.x

- Romainville, M. (2000). L’échec dans l’université de masse. Paris, France : L’Harmattan.

- Ryan, R. M. et Deci, E. L. (2000). Intrinsic and extrinsic motivations: Classic definitions and new directions. Contemporary Educational Psychology, 25(1), 54-67. doi:10.1006/ceps.1999.1020 Récupéré du site CiteSeerX : http://citeseerx.ist.psu.edu

- Shields, R. et Chugh, R. (2017). Digital badges – Rewards for learning? Education and Information Technologies, 22(4), 1817-1824. doi:10.1007/s10639-016-9521-x

- The New Media Consortium (NMC). (2015). Horizon report, 2015 Higher education edition. Récupéré du site du consortium : http://nmc.org

- The New Media Consortium (NMC). (2016). Horizon report, 2016 Higher education edition. Récupéré du site du consortium : http://nmc.org :

- Tyler, R. W. (1949). Basic principles of curriculum and instruction. Chicago, IL : University of Chicago Press.

- Université de Liège (2015). Engagement pédagogique du cours PHYS3018-1 – Bases physiques des sciences médicales, y compris les bases physiques de l’imagerie médicale. Récupéré le 18 août 2016 de : https://www.programmes.uliege.be/cocoon/cours/PHYS3018-1.html

- Verpoorten, D., Glahn, C., Kravcik, M., Ternier, S. et Specht, M. (2009). Personalisation of learning in virtual learning environments. Dans U. Cress, V. Dimitrova et M. Specht (dir.), Learning in the Synergy of Multiple Disciplines. Proceedings of the Fourth European Conference on Technology-Enhanced Learning (EC-TEL 2009). Lecture notes in computer science vol. 5794 (p. 52-66). Berlin, Allemagne : Springer-Verlag. Manuscrit récupéré du répertoire de l’Open Universiteit : http://dspace.ou.nl

- Verpoorten, D., Parlascino, E., André, M., Schillings, P., Devyver, ... Jérôme, F. (2017). Blended learning. Pedagogical success factors and development methodology. IFRES-Université de Liège, Belgique. Récupéré du répertoire ORBi de l’Université de Liège : http://orbi.uliege.be

- Verpoorten, D., Poumay, M. et Leclercq, D. (2007). The 8 learning events model: A pedagogic conceptual tool supporting diversification of learning methods. Interactive Learning Environments, 15(2), 151-160. doi:10.1080/10494820701343694 Manuscrit récupéré du répertoire ORBi de l’Université de Liège : http://orbi.uliege.be

- Viau, R. (2009). La motivation en contexte scolaire. Bruxelles, Belgique : De Boeck.

- Wu, M., Whiteley, D. et Sass, M. (2015). From girl scout to grown up: Emerging applications of digital badges in higher education. The Online Journal of Distance Education and e-Learning, 3(2), 48-52. Récupéré de http://tojdel.net

Liste des figures

Figure 1

Le simulateur ludifié laisse à l’étudiant le choix de sa durée d’entraînement à la matière

Figure 2

L’étudiant évalue lui-même le niveau auquel il veut se tester

Figure 3

Tableau des trophées : l’étudiant no 21 a obtenu toutes les clés d’accès, un badge Or pour 4 domaines, Argent pour 4 domaines et Bronze pour 2 domaines

Figure 4

Outil d’aide à la réussite, le simulateur est accessible aux étudiants durant l’entièreté de l’année universitaire

Figure 5

Détenir 4 médailles d’or débloque automatiquement un pass (laissez-passer) pour le test formatif no 2

Figure 6

L’approche du test formatif no 2 précipite l’acquisition des médailles d’or en optique, mécanique, électricités et fluides, conditions d’accès à sa passation

Figure 7

Évolution importante du taux de réussite mesuré sur l’examen de physique de janvier depuis l’introduction de notre simulateur d’examen ludifié

Figures 8a et 8b

Augmentation de la moyenne avec le nombre de clés d’accès collectées et de médailles d’or obtenues

Figures 9a (Q14), 9b (Q15), 9c (Q16)

Les perceptions étudiantes du simulateur sont positives quant à son utilité pour l’apprentissage, son caractère motivant et ses possibilités de personnalisation (1 = pas du tout d’accord; 2 = plutôt pas d’accord; 3 = assez d’accord; 4 = tout à fait d’accord)

Liste des tableaux

Tableau 1

Une fréquentation du simulateur en nette progression mais avec des variations au cours du trimestre

Tableau 2

Taux d’acquisition des différents badges : plus la matière est vue tardivement, plus la fréquentation baisse

Tableau 3

Taux de réussite global et thème par thème