Résumés

Résumé

Les sondages d’opinion sont un des principaux moyens utilisés pour connaître les perceptions du public en matière de sécurité et de police. Plusieurs observateurs remettent toutefois en question la représentativité des répondants et la validité des informations recueillies. Le présent article aborde ces questions en analysant les réponses obtenues à la suite d’un sondage commandé par un service de police canadien. Deux échantillons aléatoires de participants ont répondu à un questionnaire similaire à l’aide d’une entrevue téléphonique (n = 403) ou d’un sondage autoadministré sur le Web (n = 474). Les résultats obtenus montrent que les réponses diffèrent selon le mode de collecte : les répondants au questionnaire Web ont offert des réponses moins favorables à la police et étaient plus susceptibles de sélectionner des réponses modérées. Les tailles d’effet obtenues semblent aussi indiquer que les répondants aux sondages téléphoniques sont plus susceptibles d’exagérer leur opinion en optant pour des réponses extrêmes, soit en début ou en fin de sélection, que de la modifier en sélectionnant des réponses contraires à leurs impressions. Ces résultats impliquent que les comparaisons temporelles pour un même service de police et les comparaisons entre organisations nécessitent une interprétation plus nuancée que celle qui est généralement offerte.

Mots-clés :

- Police,

- sondage,

- sentiment de sécurité,

- opinion publique,

- performance policière

Abstract

Opinion surveys are frequently used to assess public perceptions about the police. However, observers have questioned the reliability of such information, particularly with regard to whether respondents are representative of the target population. This article investigates such concerns using a survey commissioned by a Canadian police force. Two groups of participants completed a similar questionnaire either during a telephone interview (n = 403) or by using a Web-based self-administered survey (n = 474). The analysis uncovered several differences related to the method used to obtain information. Web respondents reported opinions that were less favourable to the police and were more likely to select moderate choices while telephone respondents, adjusted for average effect size, were more likely to inflate their actual opinions by selecting extreme choices rather than the more moderate choices also offered. These results suggest that comparisons over time for a single organization as well as comparisons between organisations require more careful interpretation than is generally provided.

Keywords:

- Police,

- surveys,

- sense of security,

- attitudes to the police,

- police performance

Resumen

Las encuestas de opinión son uno de los medios principalmente utilizados para conocer las percepciones del público en materia de seguridad y de policía. Sin embargo, muchos observadores cuestionan la representatividad de los encuestados y la validez de las informaciones recopiladas. El presente artículo aborda éstas cuestiones analizando las respuestas obtenidas a raíz de una encuesta encargada por un servicio policial canadiense. Los participantes de dos muestras aleatorias han respondido a un cuestionario similar a través de una entrevista telefónica (n = 403), o de un cuestionario auto-administrado vía Internet (n = 474). Los resultados obtenidos demuestran que las respuestas varían según el modo de recolección de datos : los encuestados a través del cuestionario web, han ofrecido respuestas menos favorables hacia la policía y eran más propensos a elegir las opciones de respuesta más moderadas. Los resultados obtenidos sugieren también que los encuestados telefónicos son más proclives a exagerar sus opiniones, seleccionando opciones extremas que a modificarlas con la elección de opciones contrarias a sus impresiones. Estos resultados implican que las comparaciones temporales dentro de un mismo servicio de policía, al igual que las comparaciones entre organizaciones, necesitan una interpretación más matizada que la que se ofrece generalmente.

Palabras clave:

- Policía,

- encuesta,

- sentimiento de seguridad,

- opinión pública,

- desempeño policial

Corps de l’article

Introduction

Dans la foulée du modèle de la police communautaire, les attentes envers la police ont radicalement changé au cours des dernières décennies. Il est maintenant attendu que la police intègre les besoins et les demandes des citoyens dans sa lutte à la criminalité et le maintien de l’ordre public (Skogan, 2006). Ainsi, la performance policière se mesure maintenant autant en termes de résolution et de prévention du crime que de sentiment de sécurité et de satisfaction de la « clientèle ». Cette redéfinition s’accompagne d’un besoin de développer et de recueillir de nouveaux indicateurs de performance (Collier, 2006 ; Donnelly, Kerr, Rimmer et Chui, 2006).

Évidemment, les mieux placés pour parler de sentiment de sécurité et de satisfaction envers la police sont les principaux intéressés : les citoyens eux-mêmes. Comme pour la plupart des phénomènes sociaux, connaître l’opinion réelle du public envers la police n’est pas chose facile. Les sondages d’opinion sont un des moyens utilisés ; dans presque tous les cas, seul un échantillon de la population peut être entendu, faute de moyens financiers et humains illimités. La première préoccupation est donc de savoir si les sondages d’opinion permettent d’obtenir des informations pouvant être généralisées à l’ensemble de la population et ainsi mesurer l’opinion du public envers la police (Weisberg, 2008).

La réalité fournit toutefois des exemples contradictoires qui poussent à remettre en question la valeur des sondages d’opinion. Par exemple, un sondage mené à l’automne 2010 a démontré que 69 % des Montréalais ne se sentaient pas en sécurité à Montréal ; pourtant, en décembre 2008, un autre sondage révélait que 92 % des résidents jugeaient que leur quartier était sécuritaire. Cette évolution dans les perceptions semble indiquer qu’il y a eu une dégradation majeure de la qualité de vie des Montréalais à cette époque, donc que le service de police est brusquement devenu moins performant. Pourtant, rien ne montre qu’une telle chose se soit produite : quel sondage dit vrai ?

Une analyse plus approfondie de ces résultats permet de constater plusieurs différences pouvant expliquer l’écart entre les deux sondages. Par exemple, les résultats ont été obtenus au moyen de questions formulées différemment, une générale (sécurité à Montréal) et une spécifique (sécurité dans votre quartier). Des travaux ont justement montré comment des questions générales et spécifiques pouvaient mesurer des concepts complètement distincts et ainsi offrir des réponses différentes. Par exemple, Brandl, Frank, Worden et Bynum (1994) ont distingué les questions générales (« Êtes-vous satisfait de la police ? ») des questions spécifiques (« Êtes-vous satisfait de la police de votre quartier ? ») (voir aussi Ferraro et LaGrange, 1987 ; Farrall, Bannister, Ditton et Gilchrist, 1997). Autre point à noter, le premier sondage a été commandé par le syndicat des policiers qui s’en est servi pour montrer les besoins criants en matière de sécurité publique tandis que le second était une initiative du service de police qui l’a utilisé pour évaluer la (bonne) performance de l’organisation. Bien que les deux sondages aient été menés par des firmes indépendantes et qu’il n’y ait à priori aucune raison de croire qu’un sondage était mieux conçu que l’autre, certains observateurs se sont montrés sceptiques quant à l’interprétation faite des données.

Les erreurs de mesure potentielles

Deux différences méthodologiques dans ces sondages montréalais ont aussi retenu notre attention. Premièrement, les répondants aux deux sondages étaient différents sous plusieurs aspects, tant sur le plan de leurs caractéristiques sociodémographiques que de leur profil de réponse. Il a été démontré que plusieurs facteurs individuels, situationnels et contextuels pouvaient influencer les perceptions quant à la sécurité et la police (Brown et Benedict, 2002 ; Brunton-Smith et Sturgis, 2011 ; Weitzer et Tuch, 2005 ; Zhao, Lawton et Longmire, 2010). Deuxièmement, un des sondages a été réalisé au moyen d’un panel Web, tandis que l’autre a été mené auprès d’un échantillon de répondants au téléphone. Est-il possible que ce simple détail puisse expliquer l’écart entre les résultats ? Les limites des sondages Web sont connues depuis qu’ils existent (Couper, 2000), et les questions sur le crime, la police et la sécurité sont, par définition, sensibles (Guegan, Moliner et Vidal, 2013 ; Tourangeau et Yan, 2007). Les réponses obtenues sont-elles biaisées ?

Une vaste documentation, venant principalement de travaux en science politique et en méthodologie des sondages, indique que relativement à une question sensible, les répondants ont trois options : 1) donner une réponse véridique ; 2) refuser de répondre ; 3) falsifier leurs réponses en mentant ou en embellissant leur opinion réelle. La première option est idéale pour les chercheurs puisqu’elle permet d’atteindre les objectifs du sondage. La seconde, le refus de répondre, est une menace à la validité des résultats, surtout si les refus ne sont pas distribués aléatoirement ; c’est le cas si les réponses des répondants à une question précise diffèrent significativement des réponses des non-répondants (Dillman, Eltinge, Groves et Little, 2002). Des travaux récents indiquent que les refus augmentent avec la sensibilité des questions (Messer, Edwards et Dillman, 2012 ; Sakshaug, Yan et Tourangeau, 2010). La falsification des réponses est pourtant une menace d’une plus grande importance puisque les chercheurs ne sont généralement pas en mesure d’évaluer son impact, principalement parce qu’ils ne sont pas capables de distinguer les réponses véridiques des réponses falsifiées (Flament, Guimelli et Abric, 2006 ; Lensvelt-Mulders, 2008)[3]. La falsification peut être volontaire (si le répondant indique une opinion différente de ce qu’il croit réellement) ou non (si la structure du sondage favorise certains types de réponses).

Traditionnellement, trois grands types de sondages d’opinion ont été utilisés en sciences sociales. Les entrevues en personne ont presque disparu des pratiques actuelles en matière de sondage à grande échelle pour faire place à deux méthodes moins coûteuses, plus rapides à réaliser et donnant accès à des répondants différents (Jäckle, Roberts et Lynn, 2010) : les questionnaires oraux (par ex. : téléphone) et les sondages autoadministrés (par ex. : Web). Plusieurs études ont rapporté que le mode de collecte[4] avait un impact important sur les réponses obtenues à des questions sensibles (pour une revue de la littérature, voir De Leeuw, Hox et Dillman, 2008 ; Tourangeau et Yan, 2007) : par exemple, Chang et Krosnick (2010) ont posé les mêmes questions à deux échantillons de répondants en laboratoire et ont observé que les répondants oraux avaient une plus grande tendance à la désirabilité sociale que ceux qui répondaient à l’aide d’un ordinateur (questionnaire autoadministré). Il semble aussi que les sondages oraux entraînent une plus grande tendance à la réponse extrême, c’est-à-dire la propension à choisir des réponses en début ou en fin de séquence, indépendamment du contenu de la question (Baumgartner et Steenkamp, 2001 ; Groves et al., 2004 ; Ye, Fulton et Tourangeau, 2011). Ainsi, il y aurait dans les sondages téléphoniques un surnombre des répondants très en accord ou très en désaccord. Dans tous les cas, la falsification peut avoir un impact relativement mineur si les opinions rapportées sont simplement « gonflées », mais un impact majeur si les répondants ont donné des réponses contraires à leur opinion réelle.

Les sondages d’opinion sur la police et la sécurité

À notre connaissance, l’étude de Hennigan, Maxson, Sloane et Ranney (2002) est la seule à avoir examiné l’existence de ce type d’erreur de mesure et tenté de mesurer son effet dans les sondages d’opinion visant à évaluer la performance policière. Ils ont comparé les réponses à un questionnaire oral (par téléphone) et à un questionnaire autoadministré envoyé par la poste. Ils ont ainsi confirmé les résultats obtenus dans d’autres champs de recherche, c’est-à-dire que les répondants oraux étaient significativement plus vieux, plus éduqués, moins susceptibles d’avoir déménagé récemment et d’origine ethnique plus homogène. Autrement dit, les répondants des deux modes de collecte étaient différents, ce qui est un problème dans la mesure où les caractéristiques sociodémographiques sont elles-mêmes associées à l’opinion relativement à la police. De manière tout aussi importante, Hennigan et al. (2002) ont trouvé des différences d’opinions entre les deux modes de collecte qui ne s’expliquaient pas par les différences entre les répondants. Concrètement, ils ont trouvé que les répondants au questionnaire autoadministré étaient plus critiques envers la police et qu’ils rapportaient des niveaux plus élevés d’insécurité. La conclusion prudente des auteurs est qu’il est possible qu’il y ait des biais liés au mode de collecte et que les répondants oraux soient les plus susceptibles de falsifier leurs réponses aux questions sensibles sur la police et la sécurité[5].

Quoique fort instructive, l’étude de Hennigan et al. (2002) n’a pas été reproduite depuis sa publication. Elle posait pourtant des questions importantes pour toutes les organisations de sécurité susceptibles d’utiliser des sondages d’opinion pour évaluer leur performance. Le présent article porte spécifiquement sur deux questions : premièrement, les caractéristiques des individus sont-elles associées à une probabilité différentielle de répondre par l’un ou l’autre des modes de collecte ? Autrement dit, les deux modes de collecte permettent-ils de joindre des répondants similaires ? Deuxièmement, quel est l’impact du mode de collecte sur les réponses obtenues ?

Méthodologie

L’analyse est fondée sur un sondage commandé par un service de police canadien et réalisé à l’automne 2011 par une entreprise de sondages indépendante. La population de départ était l’ensemble des résidents de la municipalité, les répondants devant indiquer leur code postal pour valider leur admissibilité. À la demande du service de police, l’entreprise de sondages a sélectionné deux échantillons aléatoires de taille similaire à partir de la liste des numéros de téléphone résidentiels de la municipalité et d’un panel Web de répondants potentiels recrutés par l’entreprise. Les questionnaires téléphoniques et Web, qui prenaient en moyenne 8 minutes à remplir, étaient quasi identiques et comptaient 39 questions à choix multiples. Dans les deux cas, la collecte de données impliquait une relance des répondants sélectionnés n’ayant pu être joints lors de la première tentative. Il ne s’agissait pas d’un design expérimental à proprement parler puisque les répondants n’étaient pas assignés au questionnaire téléphonique ou Web de façon aléatoire – un individu contacté par téléphone répondait nécessairement au questionnaire téléphonique et vice versa. L’échantillon final du sondage comportait 877 répondants anonymes, dont 46,0 % (n = 403) ont répondu au questionnaire téléphonique, les autres participants (n = 474) ayant plutôt rempli la version Web autoadministrée.

Le présent article présente une réanalyse des données compilées par Boivin et Cordeau (2014). Bien que le matériau de base soit le même pour les deux analyses, nous utilisons une stratégie analytique distincte afin d’examiner des questions de recherche complémentaires. Les principaux résultats obtenus seront rapportés dans la suite du texte afin de mettre en contexte et contraster ceux présentés dans le présent article.

Même s’ils acceptaient de participer à la collecte de données, les répondants pouvaient refuser de répondre à des questions spécifiques. Globalement, le taux de participation et le taux de non-réponse à des questions spécifiques ont été considérablement plus élevés par téléphone, ce qui correspond à la littérature scientifique sur le sujet (Shih et Fan, 2008). En d’autres mots, les répondants au téléphone étaient plus susceptibles d’accepter de répondre au sondage que les répondants Web, mais ces derniers étaient plus susceptibles de répondre à toutes les questions qui leur étaient posées (Boivin et Cordeau, 2014).

Variables à l’étude

L’analyse porte sur sept questions sélectionnées sur la base du taux de réponse et du sujet abordé. L’analyse descriptive indiquait aussi une variation considérable des réponses à ces questions selon le mode de collecte. Elles peuvent être regroupées en trois grands thèmes : la satisfaction envers le service de police, la légitimité perçue de la police et le sentiment de sécurité. Chaque question proposait quatre choix de réponses, deux choix positifs et deux choix négatifs, en fonction de la nature de la question (ex : satisfait ou insatisfait, en accord ou en désaccord, efficace ou inefficace ; voir Tableau 1). Aucun choix neutre n’était offert afin d’éviter les réponses à tendance centrale, mais les répondants pouvaient qualifier l’intensité de leur opinion (par ex. : très satisfait ou assez satisfait).

Pour les besoins de l’analyse, les réponses ont été regroupées en deux paires de valeurs dichotomiques : 1) les réponses positives (favorables à la police) et négatives ; et 2) les réponses extrêmes et modérées. Les réponses positives incluent les valeurs 3 et 4 alors que les négatives comprennent les valeurs 1 et 2 ; les réponses extrêmes incluent les valeurs 1 et 4 tandis que les valeurs modérées comprennent les valeurs 2 et 3.

L’analyse vise à déterminer l’impact du mode de collecte des données sur les réponses obtenues (1 = téléphone ; 2 = Web). Afin de vérifier l’existence de biais de sélection et de tenir compte de leurs effets respectifs sur les réponses, plusieurs caractéristiques des répondants ont été incluses dans l’analyse : l’âge, le genre, le revenu, l’appartenance culturelle, la langue maternelle, l’expérience d’interpellation par la police, l’historique de victimisation directe et indirecte ainsi que les habitudes de sorties (pour la description des variables, voir Boivin et Cordeau, 2014).

Tableau 1

Variables dépendantes

Stratégie analytique

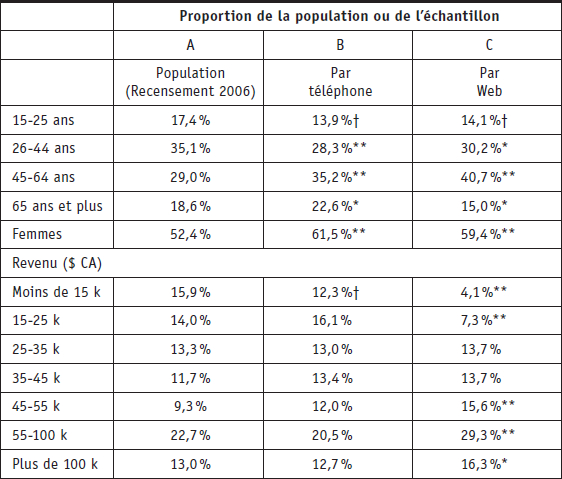

Des analyses bivariées sont utilisées pour comparer les caractéristiques des répondants aux sondages à celles de la population (selon le Recensement 2006). Des tests de différences de proportions ont été utilisés afin de comparer les échantillons de différentes tailles.

Puisque le but principal de l’analyse était de déterminer l’effet du mode de collecte sur les réponses, indépendamment des biais de sélection anticipés, l’analyse d’appariement des coefficients de propension (propensity score matching) a été la méthode privilégiée. Celle-ci opère en deux étapes. La première consiste à associer les cas en fonction de leurs caractéristiques de façon à recréer des conditions expérimentales. Autrement dit, les cas sont reliés à leur(s) semblable(s) à partir d’un coefficient de similarité calculé en fonction des variables sélectionnées par le chercheur. Il existe plusieurs méthodes d’appariement qui permettent d’obtenir les meilleurs pairages possible (pour une description détaillée de ces méthodes, voir Pearl, 2009). L’étape de pairage est cruciale et doit se baser sur les caractéristiques les plus fondamentales ou sur le plus grand nombre de caractéristiques possible. Autrement dit, la qualité du pairage est fonction directe des variables prises en compte. La deuxième étape consiste à tester la relation entre les variables d’intérêt, ce qui donne une mesure d’effet de traitement moyen. Cette mesure indique la force et le sens de la relation entre les deux variables ; sa valeur varie généralement de -1 à 1. Dix-neuf méthodes de pairage de deux types (voisin le plus proche et noyau « kernel ») ont été calculées pour la présente analyse (étape 1) ; les résultats obtenus pour une même analyse à l’aide de différentes méthodes d’appariement sont généralement similaires (étape 2), ce qui fait que seul le résultat obtenu avec le meilleur pairage est présenté dans les tableaux qui suivent.

Résultats

Biais de sélection : probabilité de réponse selon le mode de collecte

La fonction première de l’échantillonnage est de donner accès à une partie représentative de la population à l’étude. Les bénéfices de l’échantillonnage sont évidents lorsque la population à l’étude est très grande ; dans le cas présent, la population d’intérêt était l’ensemble des résidents de la ville à l’étude, soit plusieurs milliers de personnes. Compte tenu des ressources financières et humaines disponibles, il n’était envisageable de sonder l’opinion que d’environ 800 d’entre elles et d’extrapoler que leurs réponses pouvaient s’appliquer à l’ensemble de la population. La première chose à faire était donc de vérifier si l’échantillon de répondants avait les mêmes caractéristiques que la population en général. Le Tableau 2 compare quelques caractéristiques des répondants à celles obtenues grâce au recensement récent le plus complet (2006).

Tableau 2

Représentativité de l’échantillon

Les signes * et † indiquent des différences significatives entre l’échantillon et la population. On constate que les répondants au sondage sont généralement plus vieux que la population, que les femmes sont plus nombreuses que les hommes à avoir répondu au questionnaire et que les revenus des répondants sont en moyenne plus élevés, en particulier pour les répondants Web. Ce genre de biais est souvent minimisé par l’utilisation de pondérations, c’est-à-dire le fait d’attribuer une plus grande valeur aux réponses des répondants dont le poids relatif est inférieur à la proportion attendue. Toutefois, on remarque aussi que les différences sont plus ou moins prononcées selon le mode de collecte et que les écarts observés ne suivent pas une tendance linéaire. Par exemple, les répondants de 15 à 25 ans et de 26 à 44 ans sont sous-représentés dans les deux sous-échantillons, mais les écarts avec la population sont légèrement moins prononcés parmi les répondants Web. Toutefois, les répondants de 65 ans et plus (qui représentent 18,6 % de la population de la ville) sont surreprésentés dans la collecte par téléphone (22,6 %) mais sous-représentés dans la collecte par Web (15,0 %). Les écarts sont plus évidents pour le revenu : des sept catégories de revenus, une seule présente un écart par rapport à la population (les personnes ayant indiqué un revenu de moins de 15 000 $) pour le téléphone, tandis que les répondants Web sont significativement moins nombreux à avoir déclaré un revenu dans les deux catégories inférieures et plus nombreux pour les trois catégories supérieures.

Ces résultats semblent indiquer que, en l’absence d’une méthode de sélection complètement aléatoire, la combinaison des deux modes de collecte permet de joindre un échantillon dont les caractéristiques sociodémographiques sont plus proches de celles de la population que l’utilisation d’une seule des deux méthodes. Le téléphone permet mieux de joindre des répondants des différentes catégories de revenus tandis que le Web offre une meilleure couverture du sexe et de l’âge.

Impact du mode de collecte sur les réponses obtenues

La présente section vise à répondre à une question simple : le mode de collecte a-t-il un impact sur les réponses à des questions sur la police et la sécurité ? L’appariement des coefficients de propension peut être utilisé pour répondre à ce genre de questionnement, comme illustré à la Figure 1. Plusieurs travaux ont montré qu’il y avait un lien entre les caractéristiques individuelles et les attitudes relativement à la police (Lai et Zhao, 2010 ; Weitzer et Tuch, 2005 ; flèche 1). Dans la section précédente, il a aussi été démontré que le Web permettait de joindre des répondants qui ne sont pas tout à fait comparables aux répondants au téléphone (flèche 2). La présente section vise à vérifier si les réponses données par les répondants Web auraient été les mêmes s’ils avaient répondu par téléphone (flèche 3).

Figure 1

Schéma d’analyse

La première étape de l’appariement visait à réduire au mieux les différences entre les sous-échantillons de façon à recréer des conditions expérimentales permettant de mieux évaluer l’effet du mode de collecte sur les opinions déclarées quant à la police et à la sécurité. Dans le cas présent, l’opération d’appariement a permis d’obtenir des sous-échantillons plus satisfaisants, améliorant la robustesse des analyses subséquentes. Concrètement, les mesures standardisées de biais (non montrées) sont toutes inférieures à 10 après l’appariement, ce qui indique que les sous-échantillons sont équilibrés (Apel et Sweeten, 2010). Autrement dit, la première étape de l’analyse a permis d’apparier les cas d’un groupe (répondants au téléphone) aux répondants les plus semblables de l’autre groupe (répondants Web).

Les résultats liés à la seconde étape de l’appariement des coefficients de propension sont donc présentés pour les sept questions à l’étude. Le Tableau 3 montre l’effet de traitement moyen de la collecte Web sur la probabilité d’une réponse favorable à la police, lorsque sont pris en compte les effets de neuf caractéristiques individuelles.

Les répondants Web déclarent des opinions moins favorables que les répondants par téléphone, et les analyses présentées semblent fortement indiquer que ces différences sont dues au mode de collecte des données. Pour les questions sur la satisfaction par rapport aux services policiers, la taille d’effet varie de -0,100 à -0,087 ; rappelons que plus la valeur absolue de la taille d’effet moyenne (ATE) est élevée, plus l’effet est grand, indépendamment des caractéristiques des répondants ou du biais de sélection décrit dans la section précédente. L’effet du mode de collecte est aussi significatif pour les questions sur le sentiment de sécurité : les répondants Web indiquent plus souvent qu’ils ont peur de marcher seuls le soir (T.E. = -0,118 ; p <0,05) ou que leur quartier n’est pas sécuritaire (T.E. = -0,043 ; p <0,05). L’effet est toutefois moins prononcé pour les questions sur la légitimité perçue de la police. Selon les analyses, les répondants Web sont significativement moins susceptibles d’indiquer que la police offre un traitement égal à tous (T.E. = -0,087 ; p <0,05) ou qu’ils ont confiance en elle (T.E. = -0,061 ; p <0,01). Enfin, le mode de collecte n’est pas associé à une réponse indiquant que les policiers interpelleraient sans motif des citoyens. Bref, on peut résumer ainsi l’effet du mode de collecte sur les réponses au sondage : un individu répondant par Web est plus susceptible d’indiquer de l’insatisfaction relativement aux services policiers, des critiques quant à la légitimité de la police et un certain sentiment d’insécurité, indépendamment de plusieurs de ses caractéristiques individuelles.

Tableau 3

Tailles d’effet d’une collecte Web (vs téléphonique) sur la probabilité d’une réponse favorable à la police

L’autre aspect à considérer est de savoir si certains répondants ont plus tendance à choisir une réponse extrême plutôt que médiane. Le Tableau 4 présente la taille d’effet de la collecte Web sur la probabilité d’une réponse extrême positive ou négative, lorsque sont pris en compte les effets de neuf caractéristiques individuelles.

Dans tous les cas, les répondants Web sont plus susceptibles d’avoir choisi une réponse médiane lorsqu’ils ont rempli le questionnaire que les répondants qui l’ont fait oralement. Autrement dit, les répondants téléphoniques démontrent une tendance significative à opter pour une réponse en début ou en fin de séquence indépendamment du contenu de la question, ce qui est cohérent avec la littérature scientifique sur le sujet. Fait à noter : à une exception près, l’effet est plus prononcé que pour la probabilité d’une réponse favorable à la police. Ceci semble indiquer que les répondants au téléphone sont plus susceptibles d’exagérer leur opinion en sélectionnant des réponses extrêmes que de la modifier en choisissant des réponses contraires à leurs impressions.

Tableau 4

Mesures d’effet d’une collecte Web (vs téléphonique) sur la probabilité de réponse extrême

Discussion

Les résultats présentés dans cet article semblent indiquer que les réponses à un sondage sur la sécurité et les services policiers diffèrent selon le mode de collecte, et donc que la mesure de la performance varie dans la même mesure. Les répondants au questionnaire Web autoadministré ont offert des réponses moins favorables à la police, même en tenant compte de plusieurs caractéristiques individuelles. Les résultats indiquent aussi que les répondants Web étaient moins susceptibles de choisir des réponses extrêmes, et donc, qu’ils étaient significativement plus susceptibles de choisir des réponses modérées.

Deux explications peuvent être avancées pour expliquer ces résultats. La première est « mécanique », dans le sens où certaines études indiquent que les répondants à des questionnaires autoadministrés sont plus à même de nuancer leurs réponses que dans le cas d’un questionnaire réalisé oralement, surtout si le nombre de choix est très grand (Dillman et al., 2009 ; Ye et al., 2011). Dans leur analyse des mêmes données, Boivin et Cordeau (2014) ont trouvé que les répondants Web favorables à la police avaient tout de même tendance à fournir une opinion plus près du milieu de l’échelle de mesure, ce qui semble indiquer que les réponses obtenues par le Web sont simplement « tirées vers le centre » plutôt que contraires à l’attitude globale des répondants. Cette situation serait liée au fait qu’il est plus difficile de retenir plusieurs choix de réponses énoncés oralement (ex. : par téléphone) et que les répondants par écrit peuvent généralement consulter les choix de réponse à leur guise. L’erreur de mesure qui en résulterait serait donc involontaire de la part des répondants puisque les sondages Web (autoadministrés) seraient plus faciles d’exécution que les sondages téléphoniques.

La deuxième explication se fonde sur la notion de désirabilité sociale proposée par les psychologues sociaux. Plusieurs études ont démontré que bon nombre de répondants ajustaient leurs réponses en fonction de leur perception des attentes des intervieweurs, de façon à leur paraître sympathiques ou agréables (Groves et al., 2004). Ce comportement est volontaire (quoique plus ou moins conscient) de la part du répondant ; il en résulterait donc une réponse exagérément favorable ou défavorable à une question, malgré une vérité plus nuancée. Par exemple, face à un intervieweur qui lui demande son niveau de satisfaction des services policiers d’un endroit, un répondant pourrait se dire très satisfait même si son opinion est plus mitigée, dans l’espoir d’éviter d’avoir l’air de se plaindre de tout et de rien. Les modes de collecte autorapportés, qui ne nécessitent pas l’intervention d’un intervieweur, réduisent l’effet de désirabilité sociale et permettent donc d’obtenir des réponses plus près de la vérité (De Leeuw et al., 2008 ; Tourangeau et Yan, 2007). Dans le cas présent, le fait que les réponses Web sont plus modérées que les réponses téléphoniques pourrait être interprété comme un signe que les réponses obtenues par Web sont plus valides.

Si la nature des données et le type d’analyses effectuées ne permettent pas de savoir précisément pourquoi les réponses varient selon le mode de collecte, les implications sont tout de même claires : les sondages téléphoniques – qui sont probablement aujourd’hui la méthode de sondage la plus utilisée par les organisations policières – surestiment les opinions favorables à leur égard et sous-estiment les préoccupations de sécurité de la population. Les résultats ont trois conséquences particulièrement importantes pour l’étude des opinions en matière de sécurité.

Premièrement, il est difficile, voire impossible, de suivre l’évolution temporelle des opinions si le mode de collecte de données varie dans le temps. Outre le SPVM, qui est passé d’un mode exclusivement téléphonique à un mode mixte Web-téléphone au cours des dernières années, les analystes du sondage Police-Public Contact Survey (qui fait partie du National Crime Victimization Survey, mené régulièrement aux États-Unis) s’inquiètent de la proportion grandissante d’entrevues menées par téléphone plutôt que face à face. Ils ne s’inquiètent pas de la méthode elle-même mais plutôt du changement de méthode, qui représente selon eux une importante menace à la validité interne du sondage. Les résultats présentés plus haut appuient cette position et semblent indiquer que, si la tendance se maintient, les opinions rapportées continueront à changer au cours des prochaines éditions, indépendamment de l’opinion réelle des répondants.

Deuxièmement, les résultats semblent indiquer que des sondages menés différemment ne sont pas directement comparables, même si les questions posées sont exactement les mêmes. Ce type de comparaisons est fréquent entre organisations qui désirent évaluer leur performance et leurs besoins par rapport aux autres. Par exemple, la satisfaction des répondants au sondage sur la satisfaction des citoyens de la police de Nouvelle-Zélande atteignait en 2011 un taux de 82 % ; le taux de satisfaction se situait plutôt aux environs de 74 % pour les utilisateurs des services policiers offerts à Londres (Metropolitan Police Service) et à Montréal (SPVM). Peut-on en conclure que la police néo-zélandaise offre de meilleurs services que ses homologues canadiens et britanniques ? À la lumière des résultats, et sachant que le sondage néo-zélandais est mené par téléphone uniquement, mais que le sondage londonien recueille ses données à l’aide d’entretiens en personne et que le sondage montréalais utilise une méthode mixte Web-téléphone, cette conclusion semble prématurée.

Troisièmement, les résultats indiquent que les sondages sur la sécurité sont biaisés de façon favorable ou défavorable envers la police. Il en découle qu’à la suite des conclusions qu’on peut en tirer, des solutions ne doivent pas être directement mises en application, sous peine d’énoncer des politiques inappropriées. Par exemple, un sondage mené en 2013 par le service de police d’Hawaii (États-Unis) indiquait que les répondants souhaitaient que le service de police améliore la visibilité de son action et la résolution des crimes sur son territoire. Ce sondage a été mené après qu’Hawaii ait enregistré une baisse record de 40 % de la criminalité en 10 ans. Autrement dit, alors que l’indicateur traditionnel de performance policière (le taux de criminalité) indiquait que le service de police faisait de mieux en mieux son travail, un sondage Web était si alarmant que le chef de police publia un communiqué de presse très détaillé pour rassurer la population[6]. Il faut dire que la police d’Hawaii n’avait comme point de comparaison qu’un précédent sondage téléphonique beaucoup moins alarmant…

Conclusion

Les individus ayant répondu au sondage Web étaient-ils à la base différents des répondants au téléphone ? L’analyse présentée indique que oui. Ces différences s’accompagnent-elles d’opinions différentes sur la police et la sécurité ? Il n’est pas possible de répondre à cette question avec certitude sur la base des données utilisées ici. Par contre, les résultats semblent indiquer que les réponses obtenues par Web diffèrent de celles obtenues par téléphone, même lorsque bon nombre de caractéristiques individuelles sont constantes. Autrement dit, l’interprétation des sondages d’opinion nécessite un bon niveau de prudence et une bonne connaissance de certains détails méthodologiques.

Un constat plus général de l’analyse découle de l’utilisation de méthodes d’appariement. La question de l’utilisation des méthodes de recherche expérimentales, souvent jugées fondamentales à l’avancement de la science, a depuis longtemps causé un problème en criminologie et, plus généralement, en sciences sociales (Petersen, 2008). Le problème vient du fait qu’il est généralement impossible d’évaluer la représentativité de l’échantillon, qu’il soit composé de délinquants, de policiers ou, comme dans l’exemple présenté ici, de citoyens « ordinaires ». Des biais de sélection sont presque toujours soupçonnés, ce qui réduit la portée des résultats obtenus ; par exemple, les délinquants rencontrés en prison sont-ils représentatifs de tous les délinquants, y compris ceux qui ne se feront jamais prendre pour leurs délits ? La difficulté vient du fait qu’il est difficile de concevoir un projet répondant aux critères d’expérimentation (sélection aléatoire d’une partie seulement de la population à l’étude) sans faire une entorse importante à l’éthique de la recherche et sans entraîner des coûts supplémentaires. Ainsi, il serait intéressant d’un point de vue scientifique d’obliger des individus à répondre à un sondage, mais la recherche recueille plutôt les réponses de participants volontaires ; ici, le mode de collecte du sondage aurait idéalement dû être imposé aux répondants volontaires, mais une telle procédure aurait possiblement entraîné un plus grand taux de refus et donc, des coûts supplémentaires liés au recrutement de participants. La conséquence de ces méthodes parfois dites « de convenance » est que l’effet du biais de sélection et son impact sur les résultats sont largement sous-étudiés. L’appariement ne permet pas de régler une fois pour toutes ces questions, mais permet de recréer des conditions quasi expérimentales, ce qui ajoute à la robustesse des conclusions. Cette méthode pourrait s’avérer très utile pour les chercheurs en sciences sociales, et particulièrement en criminologie.

Parties annexes

Notes

-

[1]

Les données utilisées dans cet article ont fait l’objet d’une première analyse publiée en anglais par Boivin et Cordeau (2014). Tandis que l’analyse précédente portait sur un ensemble de facteurs susceptibles d’influencer les réponses au sondage, le présent article utilise des techniques statistiques différentes et aborde les résultats sous un angle différent (l’impact du mode de collecte). Les auteurs souhaitent remercier Gilbert Cordeau pour ses commentaires et ses suggestions pour le présent article.

-

[2]

École de criminologie, Université de Montréal, Pavillon Lionel-Groulx, C. P. 6128, succ. Centre-ville, Montréal (Québec), Canada, H3C 3J7.

-

[3]

Il existe des techniques statistiques pour détecter les patrons de réponse erronés et les réponses falsifiées, dont plusieurs sont encadrées par la théorie de réponse aux items. Il s’agit de techniques assez sophistiquées qui ne sont pas utilisées par la plupart des analystes et, surtout, qui nécessitent une certaine répétition que n’offrent pas plusieurs sondages (par exemple, que le répondant donne des réponses incohérentes suffisamment souvent pour qu’elles soient détectées).

-

[4]

Plusieurs termes peuvent être utilisés pour désigner la façon dont sont recueillies les opinions des répondants : mode de collecte, de recueil, de collection, etc. L’expression « mode de collecte » utilisée ici est la plus fréquemment citée dans le contexte canadien.

-

[5]

Interprétation libre de la discussion de Hennigan et al. (2002) intitulée « Presumptive evidence of response bias » : « Our analyses support the conclusion that differential selection bias contributed to the differences by mode in fear of crime and opinion of the police » (p. 582) ; « Hence, response bias is also a plausible explanation, albeit a partial explanation, for the difference by mode in opinions of the police » (p. 581) ; « In addition, the pattern of results supports the presumption that the phone respondents were influenced to report more favorable opinions of the police than were the mail respondents » (p. 582).

-

[6]

Wall (2013) a décrit un processus similaire pour un type de crime précis (le vol d’identité). Il rappelle que plusieurs actions policières en réaction à des préoccupations publiques sont essentiellement destinées à rassurer la population plutôt qu’à apporter une solution à un problème réel.

Références

- Apel, R. J. et Sweeten, G. (2010). Propensity score matching in criminology and criminal justice. Dans A. R. Piquero et D. Weisburd (dir.), Handbook of quantitative criminology (p. 543-562). New York, NY : Springer.

- Baumgartner, H. et Steenkamp, J.-B. E. M. (2001). Response styles in marketing research : A cross-national investigation. Journal of Marketing Research, 38, 143-156.

- Boivin, R. et Cordeau, G. (2014). Do Web surveys facilitate reporting less favourable opinions about law enforcement ? Security Journal. Repéré à http://www.palgrave-journals.com/sj/journal/vaop/ncurrent/full/sj201435a.html.

- Brandl, S. G., Frank, J., Worden, R. E et Bynum, T. S. (1994). Global and specific attitudes toward the police : Disentangling the relationship. Justice Quarterly, 11, 119-134.

- Brown, B. et Benedict, W. R. (2002). Perceptions of the police : Past findings, methodological issues, conceptual issues and policy implications. Policing : An international Journal of Police Strategies and Management, 25, 543-579.

- Brunton-Smith, I. et Sturgis, P. (2011). Do neighborhoods generate fear of crime ? An empirical test using the British Crime Survey. Criminology, 49, 331-369.

- Chang, L. et Krosnick, J. A. (2010). Comparing oral interviewing with self-administered computerized questionnaires : An experiment. Public Opinion Quarterly, 74, 154-167.

- Collier, P. M. (2006). In search of purpose and priorities : Police performance indicators in England and Wales. Public Money and Management, 26, 165-172.

- Couper, M. P. (2000). Web surveys : A review of issues and approaches. Public Opinion Quarterly, 64 (4), 464-494.

- De Leeuw, E. D., Hox, J. J. et Dillman, D. (2008). Mixed-mode surveys : When and why. Dans E. D. De Leeuw, J. J. Hox et D. Dillman (dir.), International Handbook of Survey Methodology (p. 299-316). New York, NY : Psychology.

- Dillman, D. A., Eltinge, J., Groves, R. M. et Little, R. J. A. (2002). Survey nonresponse in design, data collection, and analysis. Dans R. M. Groves, D. A. Dillman, J. Eltinge et R. J. A. Little (dir.), Survey nonresponse (p. 3-25). New York, NY : Wiley-Interscience.

- Dillman, D., Phelps G., Tortora, R., Swift, K., Korhell, J., Berck, J. et Messer, B. (2009). Response rate and measurement differences in mixed-mode surveys using mail, telephone, interactive voice response (IVR) and the Internet. Social Science Research, 38, 1-17.

- Donnelly, M., Kerr, N. J., Rimmer, R. et Shiu, E. M. (2006). Assessing the quality of police services using SERVQUAL. Policing : An International Journal of Police Strategies and Management, 29, 92-105.

- Farrall, S., Bannister, J., Ditton, J. et Gilchrist, E. (1997). Questioning the measurement of the ‘fear of crime’. The British Journal of Criminology, 37, 658-679.

- Ferraro, K. F. et LaGrange, R. (1987). The measurement of fear of crime. Sociological Inquiry, 57, 70-97.

- Flament, C., Guimelli, C. et Abric, J. C. (2006). Effets de masquage dans l’expression d’une représentation sociale. Cahiers Internationaux de Psychologie Sociale, 69, 15-31.

- Groves, R. M., Fowler, F. J. Jr., Couper, M. P., Lepkowski, J. M., Singer, E. et Tourangeau, R. (2004). Survey methodology. Hoboken, NJ : Wiley-Interscience.

- Guegan, J., Moliner, P. et Vidal, J. (2013). Enquête en ligne et masquage / démasquage des opinions sensibles : une autre approche des effets de contexte. Revue Internationale de Psychologie Sociale, 26(1), 101-124.

- Hennigan, K. M., Maxson, C. L., Sloane, D. et Ranney, M. (2002). Community views on crime and policing : Survey mode effects on bias in community surveys. Justice Quarterly, 19, 565-587.

- Jäckle, A., Roberts, C. et Lynn, P. (2010). Assessing the effect of data collection mode on measurement. International Statistical Review, 78, 3-20.

- Lai, Y.-L. et Zhao, J. S. (2010). The impact of race/ethnicity, neighborhood context, and police/citizen interaction on residents’ attitudes toward the police. Journal of Criminal Justice, 38, 685-692.

- Lensvelt-Mulders, G. (2008) Surveying sensitive topics. Dans E. D. de Leeuw, J. J. Hox et D. Dillman (dir.), International handbook of survey methodology (p. 461-478). New York, NY : Psychology Press

- Messer, B. L., Edwards, M. L. et Dillman, D. A. (2012). Determinants of item nonresponse to Web and mail respondents in three address-based mixed-mode surveys of the general public. Survey Practice, 5(2).

- Pearl, J. (2009). Causality : Models, reasoning and inference (2e édition). Cambridge, Royeume-Uni : Cambridge University Press.

- Petersen, T. (2008). Split ballots as an experimental approach to public opinion research. Dans W. Donsbach et M. W. Traugott (dir.), The SAGE handbook of public opinion research (p. 223-231). Thousand Oaks, CA : SAGE Publications inc.

- Sakshaug, J. W., Yan, T. et Tourangeau, R. (2010). Nonresponse error, measurement error, and mode of data collection : Tradeoffs in a multi-mode survey of sensitive and non-sensitive items. Public Opinion Quarterly, 74, 907-933.

- Shih, T.-H. et Fan, X. (2008). Comparing response rates from Web and mail surveys : A meta-analysis. Field Methods, 20, 249-271.

- Skogan, W. G. (2006). The promise of community policing. Dans D. Weisburd et A. A. Braga (dir.), Police innovation : contrasting perspectives (p. 27-42). Cambridge, Royaume-Uni : Cambridge University Press.

- Tourangeau, R. et Yan, T. (2007). Sensitive questions in surveys. Psychological Bulletin, 133, 859-882.

- Wall, D. S. (2013). Policing identity crimes. Policing & Society, 23, 437-460.

- Weisberg, H. F. (2008). The methodological strengths and weaknesses of survey research. Dans W. Donsbach et M. W. Traugott (dir.), The SAGE handbook of public opinion research (p. 223-231). Thousand Oaks, CA : SAGE Publications inc.

- Weitzer, R. et Tuch, S. A. (2005). Determinants of Public Satisfaction with the Police. Police Quarterly, 8, 279-297.

- Ye, C., Fulton, J. et Tourangeau, R. (2011). More positive or more extreme ? A meta-analysis of mode differences in response choice. Public Opinion Quarterly, 75, 349-365.

- Zhao, J. S., Lawton, B. et Longmire, D. (2010). An Examination of the Micro-Level Crime–Fear of Crime Link. Crime and Delinquency, 61(1), 19-44.

Liste des figures

Figure 1

Schéma d’analyse

Liste des tableaux

Tableau 1

Variables dépendantes

Tableau 2

Représentativité de l’échantillon

Tableau 3

Tailles d’effet d’une collecte Web (vs téléphonique) sur la probabilité d’une réponse favorable à la police

Tableau 4

Mesures d’effet d’une collecte Web (vs téléphonique) sur la probabilité de réponse extrême