Abstracts

Résumé

À partir d’études ethnographiques menées dans des laboratoires appartenant à deux disciplines des sciences de la nature, la physique des matériaux et la pharmacologie, Catherine Allamel-Raffin élabore une classification des images produites dans ces domaines de recherche en les envisageant sous l’angle de leur production, c’est-à-dire en adoptant une perspective génétique. Cette démarche conduit notamment au constat suivant : certaines images massivement présentes en pharmacologie (histogrammes), et peu présentes en physique des matériaux, soulèvent des problèmes sémiotiques particuliers qu’il est possible d’analyser à l’aide des travaux de E. Tufte. Le recours à une perspective génétique, dans un second temps, permet de relever les similitudes, mais également d’établir les distinctions qui s’imposent quant aux processus de réalisation de ces images : la présence potentielle d’artefacts, ceux-ci étant situés à des moments différents du cours de l’expérimentation, la non-existence d’une flexibilité interprétative dans le cas des images produites en pharmacologie à l’opposé de ce que l’on rencontre en physique des matériaux, l’évolution du statut épistémique de certaines images au cours de la recherche grâce au recours, couronné de succès, à des stratégies expérimentales déterminées.

Abstract

Catherine Allamel-Raffin proposes a classification of scientific images produced in two different fields of the natural sciences (pharmacology and surface sciences). This classification relies upon ethnographic studies. The point of view adopted here is a genetic one, in other words, these ethnographic studies especially focus on the processes which lead to the production of images in two different laboratories. In the first part of my contribution, I will show that certain types of images particularly well represented in pharmacology (but not in surface sciences) like histograms, generate some specific semiotic problems. These semiotic problems will be approached by referring to the E. Tufte’s work. In the second part of my contribution, I will show that this genetic point of view leads us to underline the similarities but also the differences which take place all along the production’s processes of the images: the possible existence of artifacts which are not situated, in the two laboratories, at the same levels of the experiment; the fact that there is no interpretative flexibility in pharmacology contrasting with the interpretative flexibility one can observe in surface sciences; the evolution of the epistemic status of some images based on the successful use of determined experimental strategies.

Article body

Introduction

De nombreux auteurs ont souligné, depuis plusieurs décennies, le rôle capital joué par les images au sein des procédures de production et de justification des résultats scientifiques (Jacobi, 1985 ; Bastide, 1985 ; Latour, 1985, 1988, 1993 ; Giere, 1996). Après avoir établi un tel constat global, il me semble qu’il faut encore se doter des moyens de cerner les différents statuts épistémiques qu’acquièrent ces images au cours des processus de recherche observationnels et expérimentaux. En effet, une fréquentation régulière des laboratoires scientifiques en tant qu’ethnographe[1] m’a convaincue que, par delà la reconnaissance du caractère essentiel des images dans la pratique scientifique contemporaine, il conviendrait de mettre l’accent sur le fait qu’elles ne semblent pas toutes avoir le même statut, ni remplir les mêmes fonctions : le chercheur ne situe pas toutes les images, celles qu’il exploite au quotidien ou celles qu’il trouve contenues dans une publication, sur un même plan. Il évalue une image donnée en fonction non seulement de ses qualités intrinsèques, mais également de son histoire, chaque fois singulière. Ainsi, les images figurant dans un article scientifique possèdent des statuts variés en termes de qualité et de fiabilité et, par conséquent, des significations distinctes aux yeux du chercheur, parce qu’elles sont produites de multiples manières, avec des visées hétérogènes, et qu’elles posent des problèmes spécifiques quant à leur pertinence.

Il en résulte que, si l’on aspire en tant que sémioticien, philosophe ou sociologue à comprendre les processus de signification relatifs aux images scientifiques, il s’avère indispensable de se pencher sur leurs contextes de production et de réception[2]. L’appéhension par le chercheur d’une image donnée et le sens qu’il lui confère sont hautement conditionnés par les informations dont il dispose relativement à ces deux contextes. Dans le cadre de cet article, j’étudierai principalement le contexte de production en adoptant une perspective génétique correspondant à la question : « comment les images sont-elles produites ? ». Je souhaite ainsi affirmer l’importance pour toutes sortes d’études (sémiotiques, philosophiques, sociologiques, historiques, etc.) de cette perspective qui se révèle non pas concurrente, mais plutôt complémentaire d’autres approches.

Je me propose donc, dans un premier temps, d’esquisser les principaux éléments d’une typologie des images scientifiques résultant de l’adoption d’une telle perspective génétique en prenant d’abord pour discipline de référence la physique des matériaux, puis la pharmacologie. Ce passage d’une discipline à l’autre s’avère très fécond, puisqu’il m’a amenée à compléter ma typologie initiale[3].

Cette typologie me permet de disposer d’une grille de lecture transcendant les frontières disciplinaires. Cela dit, son établissement même m’a amenée à constater que les processus de production et d’exploitation des images présentent à la fois des similitudes et des différences entre physique des matériaux et pharmacologie et influencent, comme nous le verrons dans un troisième temps, non seulement la forme finale des images, mais également la fonction épistémique qu’elles se voient conférer au sein de chaque discipline.

1. Les laboratoires étudiés

Mon terrain d’étude en physique des matériaux est le laboratoire « Groupe Surfaces/Interfaces » (GSI)[4] de Strasbourg, au sein duquel sont menées des recherches essentiellement expérimentales portant sur les structures et les propriétés des surfaces de matériaux (en général, des métaux). Ce laboratoire dispose d’un parc instrumental important qui comprend un certain nombre de microscopes : le microscope électronique à transmission (ou MET), le microscope électronique à balayage (ou MEB), le microscope à force atomique (ou AFM), le microscope à effet tunnel (ou STM). Il s’agit de microscopes basés sur des rayonnements électromagnétiques ou sur d’autres effets, comme l’effet tunnel dans le cas du STM : la vision naturelle est abandonnée[5]. Les échantillons sont en général des dépôts métalliques sur des substrats métalliques, d’une taille millimétrique (par exemple un dépôt de cobalt sur un substrat d’or).

Mon second terrain d’étude, en pharmacologie cette fois, est constitué par le laboratoire « Inflammation et environnement dans l’asthme » (IEA)[6]. Ce laboratoire travaille sur les processus inflammatoires mis en jeu dans l’asthme, mais également sur d’autres processus inflammatoires, comme la broncho-pneumopathie chronique obstructive, la transplantation pulmonaire, le rejet de greffe, etc. À cela s’adjoint une recherche relative à la toxicité pulmonaire de certaines substances, comme la toxicité éventuelle des nanoparticules. Le travail mené vise à expliquer les processus inflammatoires au niveau biomoléculaire et à évaluer l’activité de certaines substances afin de voir si elles ont un effet positif ou négatif sur les types d’inflammation étudiés. Ce travail est réalisé in vivo sur des souris, souvent génétiquement modifiées, ou in vitro sur des cellules de souris ou d’être humain. Les instruments utilisés sont le microscope optique, le microscope confocal et le microscope électronique à transmission. On peut ajouter à cette liste tous les instruments permettant la mise en oeuvre de techniques particulières – par exemple le Western Blot, technique qui permet de détecter la présence d’une protéine dans un homogénat tissulaire ou cellulaire, d’évaluer sa taille et d’apprécier semi-quantitativement son expression et les variations de cette expression entre deux échantillons traités par des substances différentes. Cette technique mobilise des instruments tels qu’un matériel pour réaliser des électrophorèses et le transfert sur membrane des protéines, un générateur de courant électrique, un matériel de développement de films photographiques, etc.

2. Comment classer les images produites en physique des matériaux ?

En adoptant une perspective génétique, il me semble qu’on peut distinguer trois types au sein de la profusion des images produites en physique des matériaux. J’ai choisi de les désigner à l’aide des expressions suivantes : « images sources », « images retraitées » et « images de synthèse »[7].

2.1 Les images sources

Les images sources sont celles que les physiciens des matériaux obtiennent en utilisant leurs microscopes. Ces images se caractérisent par le fait d’être premières dans l’ordre chronologique de production[8]. Les processus qui permettent d’obtenir de telles images sont extrêmement complexes. Cela se révèle d’autant plus vrai que les microscopes utilisés en physique des matériaux combinent l’apport d’informations, sous forme de traces laissées par le référent visé, avec des opérations de calcul menées d’emblée sur ces informations à l’aide d’ordinateurs. L’emploi des microscopes aboutit donc à la réalisation d’images que j’ai qualifiées ailleurs de « mixtes » : à la fois indiciaires et symboliques (Allamel-Raffin, 20004a, 2004b, 2006). Le statut épistémique particulier des images sources aux yeux des chercheurs est perceptible notamment au travers de l’attitude qu’ils adoptent à leur égard. Ils estiment nécessaire de conserver celles qu’ils réalisent afin de pouvoir se livrer à une réinterprétation éventuelle. Ces images sources sont donc considérées comme précieuses par les scientifiques, car, en vertu de leur caractère indiciaire, elles constituent les seuls points de contact qui leur permettent d’étudier des aspects du réel inaccessibles à nos sens. La figure 1 ci-dessous consiste en une image source réalisée avec un microscope à effet tunnel ; elle représente des agrégats de nickel sur un substrat de cuivre.

Figure 1

Image STM d’agrégats de nickel sur cuivre.

2.2 Les images retraitées

À partir des images sources réalisées avec des microscopes, les physiciens des matériaux en produisent d’autres : les images retraitées. La caractéristique essentielle de ce que j’appelle « image retraitée » est donc d’être une image réalisée à partir d’une autre image[10]. Elle peut revêtir diverses formes : courbes, images filtrées, etc. L’image retraitée est la plupart du temps créée afin d’obtenir des informations plus précises que celles qui figurent sur l’image source. La figure 2 consiste en une image source réalisée avec un microscope à force atomique. Elle représente la topographie d’un film d’aluminium oxydé par technique plasma. L’image retraitée, quant à elle, est constituée par la courbe figurant sous l’image source. Cette courbe correspond au relief observé le long de la ligne virtuelle noire tracée en diagonale sur l’image source. Ce profil topographique est de ce fait beaucoup plus précis sur un plan quantitatif que ne l’est l’image source.

Figure 2

Image retraitée. Image AFM représentant la topographie d’un film d’aluminium oxydé par technique plasma.

Comme traitements d’images les plus courants, on trouve l’élimination du bruit ou des artefacts[11] et l’amélioration des qualités sensibles des images sources. Plusieurs techniques sont envisageables pour mener à bien cette opération : le filtrage, l’usage de fausses couleurs, la soustraction ou l’amélioration de contraste. Il existe également des traitements d’images qui permettent d’extraire des informations très précises, comme c’est le cas avec la courbe de la figure 2[12].

Le traitement des images sources s’opère à l’aide de programmes informatiques. Certains de ces programmes n’entraînent pas de problème particulier, comme celui qui permet d’obtenir la courbe ci-dessus, mais d’autres requièrent des mois de travail pour être mis au point. Soulignons que, dès que les modèles logicomathématiques interviennent dans l’élaboration d’une image, des risques d’artefacts spécifiques apparaissent : on peut perdre des informations, en ajouter, les déformer abusivement. Cette phase de retraitement est par conséquent potentiellement problématique.

2.3 Les images de synthèse

Elles sont produites exclusivement à l’aide de programmes informatiques. On peut distinguer deux types d’images de synthèse : les images de modélisation et les images de simulation.

L’image de simulation est le résultat d’un processus destiné à reproduire numériquement et à générer de façon figurative des situations, des séquences, des mécanismes identiques aux processus réels. Dans le cadre du GSI, les images de simulation visent à reproduire sous forme visuelle une expérience virtuelle, en prenant en compte un grand nombre de facteurs expérimentaux. Ces images sont comparées aux images sources qui sont souvent de moins bonne qualité, parce que les conditions expérimentales sont très difficiles à maîtriser. Ces images de simulation servent ainsi de « renforçateur épistémique » par rapport aux images sources produites par ailleurs. Si un chercheur est capable de produire une bonne image de simulation, on estime qu’il a su décrypter tous les aspects, à la fois théoriques et expérimentaux, qui interviennent dans la production d’une image source donnée.

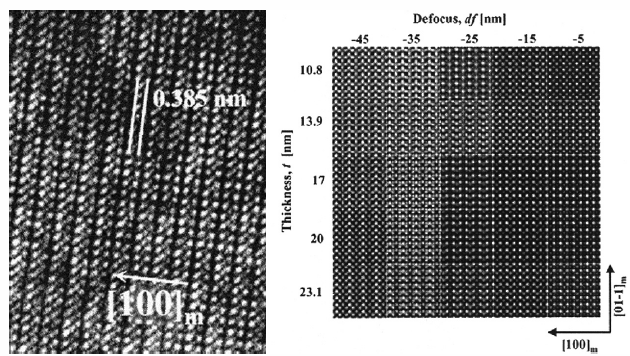

Figure 3

À gauche : image source d’un échantillon de perovskite réalisée avec un MET.

À droite : des images simulées d’un échantillon de perovskite.

Les petits carrés correspondent à différentes épaisseurs de perovskite.

Ces images simulées sont comparées à l’image source.

L’image de modélisation consiste à ne retenir, pour sa réalisation, que les théories validées à propos d’un objet d’étude donné, à l’exclusion des facteurs expérimentaux. Elle est, de ce fait, beaucoup plus schématique et ne vise pas une ressemblance trait pour trait avec des images sources. L’image de modélisation permet de mieux comprendre, sur un plan théorique, les phénomènes observés grâce aux images sources et retraitées. Voici une image (fig. 4) de modélisation d’atomes de cobalt sur un substrat d’or.

Figure 4

Image de modélisation d’atomes de cobalt sur or.

Cette première classification – images sources, images retraitées, images de synthèse –, résultant d’observations ethnographiques menées dans un laboratoire de physique des matériaux, est-elle pertinente lorsqu’on aborde les images produites dans un laboratoire de pharmacologie ?

3. Quels sont les types d’images produites en pharmacologie ?

3.1 Les images sources en pharmacologie

On peut inclure dans cette rubrique toutes les images réalisées en microscopie ou, par exemple, celles qui sont produites à l’issue d’un Western Blot. Ci-dessous, en guise d’illustration, une image source, obtenue avec un microscope optique, de cellules d’épithélium bronchique cultivées en présence de nanoparticules. Il s’agit de voir si ces nanoparticules ont un effet létal sur les cellules humaines.

Figure 5

Image source de microscopie optique de cellules pulmonaires cultivées en présence de nanoparticules.

Figure 6

Image retraitée en microscopie confoncale représentant une jonction neuromusculaire.

3.2 Les images retraitées en pharmacologie

Les traitements d’images revêtent diverses formes en pharmacologie. Le traitement, par le biais des programmes informatiques permettant d’extraire directement de l’image source des informations précises ou de les mettre en valeur, est utilisé dans le cadre des activités quotidiennes, tout comme en physique des matériaux. On trouve par exemple l’usage des fausses couleurs, en microscopie confocale, nécessaire pour mettre en évidence une superposition de marquages, permettant la démonstration absolue d’une co-localisation d’un phénomène (voir fig. 6).

Le traitement du bruit et des artéfacts, parfois si laborieux en physique des matériaux, et qui se traduit par le recours à de multiples traitements informatiques destinés à les éliminer, est ici en général intégré directement au logiciel permettant de traiter les données produites par un instrument. Prenons en guise d’exemple le pléthysmographe qui permet, en enregistrant des variations de pression, de mesurer des volumes gazeux pulmonaires des souris in vivo. Le résultat est enregistré sous forme de courbes (variations de pression en fonction du temps). Si la souris bouge, la courbe enregistrera un pic « hors norme » dû au mouvement de l’animal. Le logiciel qui convertit les données sources en courbes est capable de détecter ce type d’artefact et d’en éliminer automatiquement les occurrences. Les images, retraitées à l’aide de programmes informatiques en pharmacologie, nécessitent souvent en parallèle le recours à une médiation humaine pour réaliser leur traitement. Prenons l’exemple d’un comptage de cellules sur une image produite par microscopie optique. Les pharmacologues préfèrent déterminer eux-mêmes les zones où sont localisées les cellules qu’il faudra prendre en compte et celles qui devront être écartées. Un chercheur peut en effet juger, grâce à son regard éduqué et en se remémorant les étapes du processus de préparation des échantillons, quels sont les éléments pertinents sur l’image de microscopie, et ce, même lorsque ces éléments se présentent de manière quelque peu inhabituelle ou inappropriée (par exemple, une cellule écrasée par le processus de préparation), ce qu’un logiciel est incapable de faire. Ce comptage peut alors se traduire sous la forme d’instructions données à un logiciel par le chercheur, qui a décidé des zones déterminées sur lesquelles il est pertinent de réaliser automatiquement la tâche. Sans ces instructions, le logiciel n’offrirait pas la même efficacité.

3.3 Les images de synthèse en pharmacologie

Il n’existe pas, à ma connaissance, d’images de synthèse (de simulation ou de modélisation) dans ce laboratoire, au sens défini plus haut. Rappelons que ces types d’images visent bien à reproduire, parfois très précisément, des phénomènes expérimentaux, au point qu’une image de simulation, produite en physique des matériaux par exemple, est pratiquement identique à celle produite au cours d’une expérience réelle menée avec un microscope.

Ces images de synthèse en physique des matériaux ont pour objectif bien souvent de contourner le fait que l’expérimentation constitue une phase extrêmement problématique, et permettent de créer numériquement une vice-expérience exempte de tous les aléas expérimentaux.

Pourquoi, dans le type de laboratoire de pharmacologie au sein duquel j’ai séjourné, ne trouve-t-on pas d’images de synthèse ? Une réponse possible, à affiner sans doute, est que ce type d’images nécessite une compréhension approfondie des processus physiques et biologiques à l’oeuvre. Les images de simulation et de modélisation ont pour visée la représentation de systèmes physiques extrêmement limités, comprenant quelques centaines d’atomes. Or, dans ce laboratoire de pharmacologie, les données sont issues d’expérimentations sur le vivant (des organismes de souris, par exemple). La complexité de ce type de système est évidemment telle que la réalisation d’images de synthèse est difficilement envisageable.

Bien sûr, on peut modéliser une protéine en biologie moléculaire et cela se fait dans des laboratoires où l’on trouve des chercheurs qui consacrent principalement leur activité à cela. Mais, dans le laboratoire de pharmacologie présenté dans le cadre de cet article, il faudrait être en mesure de modéliser, sous forme d’algorithmes, non seulement la protéine, mais également son action sur un organe particulier et sur l’ensemble de l’organisme de la souris. Les chercheurs ne sont pas encore capables de modéliser ou de simuler ces types de systèmes complexes, à supposer qu’ils puissent le faire un jour et que cela soit utile d’une quelconque manière aux yeux des pharmacologues du laboratoire.

3.4 D’autres types d’images présents en pharmacologie : histogrammes et schémas explicatifs

3.4.1 Histogrammes

On peut observer, dans le laboratoire de pharmacologie, la présence massive d’un autre type d’images, à la fois dans la pratique quotidienne et dans les publications, qui est pratiquement absent en physique des matériaux : l’histogramme[13]. Prenons pour exemple la mesure de la densité optique qui s’effectue à l’aide d’un spectromètre. La densité optique repose sur la loi de Behr-Lambert et établit une proportionnalité entre la concentration d’une entité chimique en solution (un colorant, par exemple), l’absorbance de celle-ci et la longueur du trajet parcouru par la lumière dans la solution. On obtient ainsi des données chiffrées sous forme de tableau. Ces données chiffrées peuvent être transformées en deux types de diagrammes : en histogrammes ou en un type de diagramme que l’on rencontrait déjà en physique des matériaux, sous la forme d’images retraitées, à savoir les courbes.

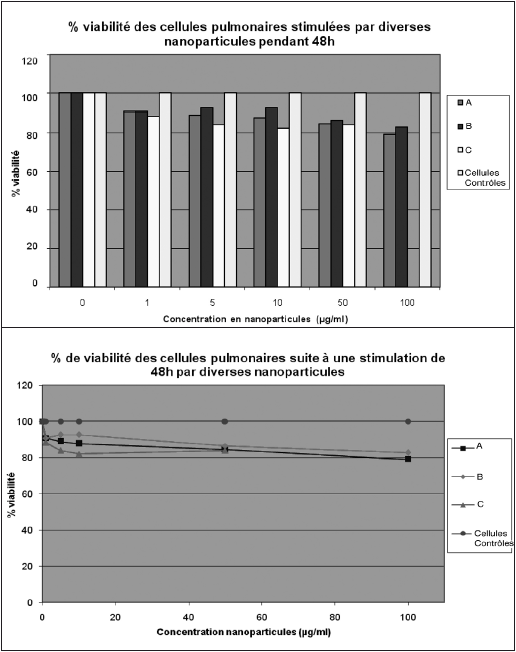

Figure 7

Illustrons ceci par une étude qui vise à montrer que des nanoparticules ont une toxicité potentielle. La chercheuse fait varier la concentration de nanoparticules qu’elle va mettre en contact avec des cellules humaines de l’épithélium bronchique cultivées dans des plaques. Les nanoparticules étudiées sont de trois types, appelons-les A, B et C. La question est de savoir si ces nanoparticules tuent ou « stressent » les cellules bronchiques. La dernière phase des expériences consiste à utiliser un réactif dont l’intensité de coloration, et donc de densité optique, sera proportionnelle à la quantité de cellules restées vivantes. Les plaques ainsi obtenues sont analysées dans le spectromètre et on obtient un tableau chiffré de la densité optique qui sera converti sous forme d’histogramme ou de courbe.

3.4.2 Schémas explicatifs

Si, comme je l’ai déjà souligné plus haut, nous trouvons peu d’images de synthèse produites uniquement à l’aide d’algorithmes en pharmacologie, nous rencontrons en revanche, et ce de manière récurrente, un autre type d’images, inexistant en physique des matériaux. Ce sont les schémas explicatifs. Ces schémas assument un rôle épistémique extrêmement important puisqu’ils fournissent, sous forme visuelle, une explication détaillée des phénomènes biologiques à l’oeuvre dans un système vivant donné. Ils intègrent tout à la fois des données issues du réel et une grande part de convention permettant de développer l’explication. Ces schémas possèdent une fonction cognitive essentielle, car ce sont eux qui permettent aux chercheurs de résumer de manière efficace les processus à l’oeuvre. Ils supposent comme conditions de leur réalisation :

que le chercheur ait réussi à bien comprendre toutes les étapes du processus investigué et les liens entre ces différentes étapes ;

une compétence à élaborer une représentation visuelle qui soit compréhensible pour le lecteur, ce qui nécessite non seulement une maîtrise des conventions utilisées en pharmacologie, mais également une compétence didactique, de manière à transmettre les informations efficacement sans en omettre.

Figure 8

Schéma explicatif.

Ces images supposent également, de la part du lecteur, une maîtrise minimale des conventions utilisées pour figurer les processus (interpréter correctement la signification d’une flèche, comprendre de quelle manière a été représentée la membrane d’une cellule, etc.)[14]. Il conviendrait d’étudier plus précisément ces schémas et d’y repérer les artifices de présentation qui leur confèrent leur efficacité cognitive.

Ma classification initiale établie en adoptant un critère génétique, à partir de mes observations en physique des matériaux, ne peut plus être conservée en l’état, puisque, comme nous l’avons vu, nous avons affaire à d’autres types d’images en pharmacologie.

4. Réaménagement de ma typologie initiale

4.1 Données sources

J’ai choisi d’intégrer ma catégorie « images sources » à l’intérieur d’une catégorie plus générale que je nommerai « données sources ». Cette catégorie inclut les images sources et les données chiffrées sources – le point commun étant que ce sont toujours les premières informations recueillies à l’aide d’un ou de plusieurs instruments. Ainsi, en pharmacologie, nous trouvons aussi bien des images sources (par exemple, des images de microscopie optique) et des données sources (par exemple, des données chiffrées de densité optique).

4.2 Données retraitées

Ma deuxième catégorie devient dès lors la catégorie « données retraitées ». Les opérations de retraitement se font :

soit informatiquement et donc automatiquement, en physique des matériaux et en pharmacologie, en fabriquant des images retraitées à partir d’images sources, avec tous les problèmes liés à la création ou à l’utilisation de logiciels ou de programmes adéquats ;

soit en pharmacologie, en fabriquant des images dérivées de données sources ; entreprise qui suppose fréquemment l’existence d’une phase durant laquelle l’être humain intervient directement et ne délègue pas entièrement ce travail à des logiciels.

Il s’agit ici de transformer des données chiffrées sources en histogrammes ou en courbes[15]. Qu’est-ce qui motive le choix de ces types de représentation graphique – courbes et histogrammes notamment – en pharmacologie ? Pour tenter de comprendre ce point, j’ai trouvé utiles les propositions d’Edward Tufte relatives à la mise en graphique des données chiffrées :

Quand nous raisonnons à partir de données quantitatives, certaines méthodes de présentation et d’analyse de ces données sont meilleures que d’autres. Les meilleures méthodes permettent d’aboutir à de meilleurs résultats en termes de vérité, de crédibilité et de précision. Qu’une analyse soit d’excellente ou de mauvaise qualité n’est pas indifférent et peut aboutir, le cas échéant, à des conséquences catastrophiques. (1997 : 27 ; ma traduction)[16]

La pensée de Tufte sur ce point est précisée dans un ouvrage ultérieur :

Si les représentations visuelles des données doivent être véridiques et riches d’enseignement, alors la logique du processus de mise en forme de la représentation doit refléter la logique de l’analyse intellectuelle, autrement dit, du raisonnement scientifique. Une visualisation claire et précise ne fait plus qu’une avec une pensée claire et précise. Les raisonnements sur les données quantitatives et la mise en forme des graphiques quantitatifs doivent inclure les points suivants : fournir des informations sur la source et sur les caractéristiques des données, souligner la pertinence des comparaisons effectuées, établir des relations de cause à effet, exprimer ces relations quantitativement, reconnaître que les problèmes analytiques comportent intrinsèquement des variables multiples, rechercher et évaluer des explications alternatives. (2000 : 53 ; ma traduction)

Pour en revenir au laboratoire de pharmacologie, je vais essayer de montrer que ces remarques de Tufte sont particulièrement opératoires pour les images dérivées de données sources. Revenons sur l’exemple de l’étude qui vise à montrer que des nanoparticules ont une toxicité potentielle. La grille de lecture répertoriant les différentes fonctions des graphiques quantitatifs, proposée par Tufte, est-elle judicieuse ?

Figure 9

-

Fournir des informations sur la source et sur les caractéristiques des données.

Sur les deux représentations, nous apprenons qu’il s’agit de cellules bronchiques de type X, stimulées pendant 48 heures. Les cellules X sont bien connues par ailleurs puisqu’elles sont issues depuis des années de la même souche prélevée sur un même patient. Nous découvrons également les types de nanoparticules utilisées (A, B, C).

-

Souligner la pertinence des comparaisons effectuées.

Cela se manifeste par la présence de quatre courbes ou de quatre barres permettant de comparer les cellules en milieu de culture sans nanoparticules, qui constituent le groupe contrôle, et les cellules avec des doses croissantes de nanoparticules A, B et C (indiquées en abscisse). Les cellules contrôles (traitées par le solvant des nanoparticules seulement) restent vivantes tout au long du processus, tandis que les autres, soumises au contact avec les nanoparticules, meurent progressivement : la comparaison semble donc pertinente.

-

Établir des relations de cause à effet.

La courbe et l’histogramme permettent, avec des variantes selon les nanoparticules, de visualiser le fait que plus leur concentration est élevée, plus les cellules meurent (le pourcentage de viabilité baisse). Ces graphiques donnent donc clairement à voir que les nanoparticules font mourir les cellules en fonction de leur concentration.

-

Exprimer quantitativement ces relations de cause à effet.

On a, en ordonnée, le pourcentage de cellules encore vivantes pour tous les cas de figure : c’est le pourcentage de viabilité, et, en abscisse, les concentrations croissantes de nanoparticules.

-

Reconnaître que les problèmes analytiques comportent intrinsèquement des variables multiples.

Les variables ici sont : le type de nanoparticules, les concentrations de nanoparticules, le temps de stimulation (ici constant : 48 heures).

-

Rechercher et évaluer des explications alternatives.

Ces opérations sont réalisées non pas sur ces graphiques, mais au moyen d’expériences complémentaires. Par exemple, en testant les produits utilisés pour maintenir les nanoparticules en suspension dans les échantillons. Une série d’expériences « contrôles » a consisté à évaluer la toxicité des excipients des nanoparticules.

Pour l’objet de l’étude, à savoir la mesure de la toxicité des nanoparticules, les courbes constituent une meilleure représentation graphique, car on visualise mieux la pente générale descendante. Cette pente descendante montre que le pourcentage de viabilité diminue quand on augmente les concentrations en nanoparticules. La relation de cause à effet est mieux mise en valeur que dans l’histogramme, alors que ce sont exactement les mêmes données retraitées. Interpréter l’histogramme semble sur ce point plus difficile : on perçoit visuellement moins bien la toxicité croissante des nanoparticules. Il y a donc là un impact argumentatif manifeste dans le fait de privilégier la courbe par rapport aux histogrammes. Cet impact sera largement à approfondir dans les travaux à venir, notamment en mobilisant des cadres d’analyse sémiotiques.

4.3 Les images de figuration

L’intitulé de la catégorie « image de synthèse » mettait l’accent sur le mode de production des images de modélisation et de simulation, et donc sur le fait qu’elles sont générées uniquement à partir d’algorithmes. Ce faisant, je n’insistais guère sur le rapport entre ces images et les entités ou les propriétés qu’elles sont censées permettre de visualiser. Ce qui les distingue des données sources et des données retraitées (et des images que ces catégories incluent), c’est l’absence totale de contact causal entre les images de modélisation, de simulation et les schémas explicatifs, d’une part, et les entités ou les propriétés soumises à investigation, d’autre part. Or, c’est bien là ce qui fait leur spécificité épistémique d’un point de vue génétique. Ces images permettent de « figurer » des éléments du réel, sans inclure aucune opération de détection, comme c’est en revanche le cas pour toutes les images que j’ai classées dans les deux autres catégories (images sources et images retraitées). Pour pouvoir être réalisées, ces images de figuration nécessitent, d’une part, la prise en compte d’informations issues du réel, sans contact causal matériel plus ou moins direct, et, d’autre part, la prise en compte des théories admises dans un domaine scientifique donné. Dans cette catégorie, nous trouvons dès lors :

les images de simulation : à travers elles, on aspire à recréer au plus près les conditions d’une apréhension des phénomènes naturels au moyen d’un matériel expérimental ou observationnel. On vise ainsi à produire une vice-expérience et ces images nécessitent par conséquent, pour leur création, la connaissance la plus complète possible des facteurs expérimentaux et théoriques ;

es images de modélisation qui, pour un système donné, prennent en compte les théories établies et négligent délibérément la plupart des facteurs expérimentaux ;

les schémas explicatifs qui fournissent une explication visuelle des processus à l’oeuvre, en considérant des informations tirées des expériences (des données sources), des informations liées aux théories en vigueur et les conventions représentationnelles propres au domaine disciplinaire au sein duquel l’investigation est réalisée. À tous ces éléments, viennent sans nul doute s’ajouter des éléments idiosyncrasiques liés aux capacités des chercheurs à bien comprendre ce qui est en jeu dans le cadre des opérations instrumentales, en référence à des contextes déterminés, et à en fournir une restitution la plus claire possible.

L’application de cette perspective génétique (et son amendement nécessaire dès lors qu’on souhaite lui conférer une portée plus générale permettant d’inclure l’intégralité des images produites en pharmacologie) me permet de distinguer différents types d’images. Cette typologie me paraît utile, car elle peut servir de boussole en vue de s’orienter au sein du vaste domaine des images scientifiques, et surtout de comprendre que ces images ne sont pas à mettre toutes sur le même plan. Une image de simulation peut formellement ressembler trait pour trait à une image source, mais leurs significations respectives et leurs fonctions pour la communauté des chercheurs seront fondamentalement distinctes, car intimement liées, comme nous l’avons vu, à leur processus de production (rapport causal plus ou moins direct avec une source émettrice d’informations sous forme de traces dans le cas des images sources, décryptage intégral sous forme algorithmique des aspects expérimentaux et des aspects théoriques liés au phénomène investigué dans le cas des images de simulation). Il sera sans doute intéressant d’appliquer cette typologie à d’autres domaines disciplinaires des sciences expérimentales. L’élaboration même d’une telle typologie ne constitue cependant pas une fin en soi. L’intérêt principal qui peut justifier sa prise en compte réside dans le fait qu’on peut espérer mieux comprendre, à partir d’elle, ce que font les chercheurs dans leurs laboratoires. Un scientifique confronté à une image de simulation va se pencher sur le détail des algorithmes produits et va recourir à certaines stratégies en vue d’éprouver sa valeur épistémique. S’il a affaire à une image source obtenue avec un STM, il examinera non pas les algorithmes qui ont contribué à sa réalisation (car ceux-ci posent rarement problème), mais les conditions qui ont présidé à l’expérimentation (préparation de l’échantillon, qualité de l’ultravide dans l’enceinte du microscope, représentativité de la zone visualisée sur l’image par rapport à l’ensemble de l’échantillon, etc.). La signification de l’image et la valeur épistémique que le chercheur lui confère sont donc directement liées à la catégorie de l’image et au mode de production qui lui est associé. Les problèmes qui jalonnent la réalisation des images sont souvent hautement spécifiques en fonction des domaines disciplinaires au sein desquels elles ont été produites, et donnent lieu au développement de stratégies de corroboration elles-mêmes spécifiques.

5. Différences et similitudes entre les processus de production des données sources et des données retraitées en physique des matériaux et en pharmacologie

5.1 Présence d’artefacts à l’occasion de la production des images, à des moments différents du processus de recherche

Un des problèmes récurrents rencontrés par les chercheurs, dans les deux laboratoires à l’occasion de la production des images, est la présence de nombreux artefacts. Cette similitude une fois constatée, le point le plus frappant et qui mérite d’être soumis à l’analyse est constitué par le fait que les artefacts ne se situent pas du tout au même moment du processus de recherche. En physique des matériaux, ils peuvent apparaître en amont du moment de la production des images, au moment même de la prise d’images, et en aval de cette production, au moment du retraitement des images. En pharmacologie, les artefacts potentiels ne se produisent que très peu au moment de la prise d’images ou, en aval, au moment du traitement des données. En revanche, ils sont massivement présents en amont, surtout dans la phase de préparation des échantillons ou dans les multiples opérations instrumentales qui aboutissent finalement à la réalisation d’une image.

Voici une liste non exhaustive des artefacts rencontrés en pharmacologie :

Le fond génétique des souris a évolué au cours des générations, c’est-à-dire que, génétiquement, la descendance ne correspond plus aux reproducteurs initiaux.

Les protocoles d’expérience mobilisés sont inadéquats. Il faut les modifier et les adapter. Les protocoles sont en général issus des publications d’autres chercheurs, mais ce n’est pas pour autant qu’ils donneront tout de suite lieu à des résultats reproductibles. Il est très important d’optimiser un protocole si l’on veut garantir la reproductibilité d’une expérience en pharmacologie. Et certaines des expériences faites ont d’ailleurs pour seul but de parvenir à stabiliser ces protocoles.

Les diverses manipulations mobilisant des savoir-faire précis sont fautives. Par exemple, pipeter correctement, obtenir la bonne pesée, assurer une bonne conservation de l’échantillon biologique, effectuer une perfusion sans problème, etc., sont des éléments-clés de diverses expériences. Comme les manipulations sont extrêmement nombreuses, il est indispensable, mais souvent difficile, d’identifier laquelle ou lesquelles sont fautives.

Un des appareils utilisés lors des manipulations est défectueux (le calibrage d’un appareil a été mal réalisé).

Illustrons le type de situation auquel les scientifiques sont quotidiennement exposés par le cas de la chercheuse qui, dans le cadre de l’étude sur la toxicité des nanoparticules précédemment évoquée, teste un protocole afin d’établir une gamme étalon. Cette gamme doit permettre de doser une protéine, une cytokine, dans le milieu de culture des cellules bronchiques. L’hypothèse est que cette protéine pourrait être produite par les cellules si elles ont été « stressées » par la présence des nanoparticules. Avant de rechercher cette protéine dans des échantillons comportant des cellules humaines « stressées » par des nanoparticules, la chercheuse veut établir une gamme étalon visant à fournir un point de repère quant au degré de concentration de la protéine dans ses échantillons. C’est une sorte d’échelle graduée allant d’un degré zéro à des concentrations de plus en plus élevées de la protéine. Après des manipulations qui durent plusieurs heures, la dernière phase de la méthode de dosage consiste à ajouter un réactif dont l’intensité de coloration, et donc la densité optique, sera proportionnelle à la concentration de cette protéine. Le tout sera analysé dans un spectromètre qui délivrera des données chiffrées sources, qui seront converties à nouveau en courbes ou en histogrammes. Hélas, bien qu’ayant suivi le plus scrupuleusement possible le protocole de test, les résultats sont mauvais et la chercheuse déçue n’arrive pas à obtenir une gamme étalon correcte. Avec l’aide d’une chercheuse confirmée, elle essaie de comprendre pourquoi ce résultat est fautif. Première piste envisagée, un mauvais pipetage : la chercheuse confirmée réévalue la manière de pipeter de l’étudiante, en vérifiant que les volumes corrects sont distribués dans le bon puits. Mais ce n’est pas la seule piste envisagée. Selon la chercheuse confirmée, ce résultat surprenant pourrait également avoir été produit lors de l’agitation de la plaque dans un appareil appelé « agitateur de plaques ». Elle vérifie que le degré d’agitation nécessaire au protocole est bien celui qui a été utilisé par la jeune chercheuse. La plaque a peut-être été secouée trop fortement, elle propose donc d’amender le protocole initial. Dernière piste envisagée, l’hypothèse qu’un appareil, en l’occurrence celui qui permet de rincer automatiquement les puits, soit défectueux. Il s’agit de petits tubes qui descendent automatiquement dans chacun des puits et qui les rincent au moyen d’une solution saline. La chercheuse confirmée sait que ces tubes peuvent parfois se boucher en raison de la présence de résidus de sels, empêchant ainsi le rinçage de certains puits.

De surcroît, il est tout à fait possible que ces différents types d’artefacts soient simultanément présents. Il faut donc que notre jeune chercheuse refasse sa gamme étalon en vérifiant ces différents points. On comprend bien, à travers cet exemple, qu’il n’est pas toujours aisé d’identifier la cause des artefacts. C’est un enjeu majeur, car de cette identification dépend directement la valeur épistémique que le chercheur va accorder aux images sources et retraitées, et ceci est vrai pour les deux domaines d’investigation expérimentale étudiés.

5.2 Une différence majeure : l’absence de flexibilité interprétative quant aux images produites en pharmacologie

Qu’appelle-t-on « flexibilité interprétative » ? Dans les études menées par le sociologue des sciences Harry Collins (1981), la flexibilité interprétative désigne le fait que les données empiriques, produites ou collectées au cours d’une recherche, donnent lieu à des interprétations différentes entre lesquelles il est difficile de trancher. En physique des matériaux, une telle flexibilité interprétative est bien présente, notamment au moment de la réalisation des images. Elle est repérable au sein des conversations multiples qui se déploient à l’occasion de la prise d’image, discussions qui portent sur ce qu’il convient de voir sur une image donnée[17] : les chercheurs confrontés à une même image n’associent pas toujours les mêmes éléments et, par là, le sens conféré à ces éléments diffère. On constate ainsi que la signification d’une image donnée se construit progressivement. Le statut épistémique conféré à une image dépendra, dans ce cas, non seulement de l’identification de tous les artefacts potentiels, mais également de la capacité collective à construire et à stabiliser une signification, stabilisation qui est obtenue en adoptant diverses stratégies évoquées dans la suite de mon propos.

Si nous nous tournons vers la pharmacologie, on ne trouve pas de flexibilité interprétative quant aux images réalisées. Les images sources ou les images dérivées de données sources en pharmacologie ne sont pas « difficiles » à interpréter, interpréter étant pris ici au sens d’identifier les différents éléments présents sur une image[18]. Elles ont plutôt une fonction de sanction de l’expérience. Très rapidement, le chercheur, en voyant son image de microscopie, son image de Western Blot ou encore ses courbes, parvient à donner une signification à ce qu’il voit. Soit l’élément recherché est présent sur l’image, soit il ne l’est pas. Il y aura peu de discussions sur ce qu’il convient de voir sur une image.

En revanche, il y en aura beaucoup sur les artefacts potentiels qu’il faudrait prendre en compte pour expliquer la présence de certains éléments sur l’image et évidemment sur la meilleure méthodologie à adopter afin d’avoir la garantie d’éliminer le plus grand nombre possible d’artefacts. Le statut épistémique d’une image source ou retraitée donnée sera alors directement lié à la faculté du chercheur à débusquer tous les artefacts potentiels.

5.3 Évolution du statut épistémique des images ou des données sources et retraitées en physique des matériaux et en pharmacologie

Au début du processus de recherche, les données sources ou retraitées ont un statut épistémique faible qui n’autorise pas leur utilisation dans le cadre d’une publication, que l’on travaille en physique des matériaux ou en pharmacologie. L’un des enjeux est donc de renforcer ce statut épistémique. Comment ? En mettant en oeuvre un certain nombre de stratégies bien décrites à mon sens par Allan Franklin dans le cadre de son « épistémologie de l’expérimentation » (1986, 1990). Ces stratégies, selon Franklin, ont été développées par les chercheurs tout au long de l’histoire des sciences, en vue de se convaincre de ce que leurs résultats expérimentaux sont fiables et renvoient à des processus et à des phénomènes existant réellement dans la nature. Ces stratégies sont : les vérifications expérimentales et les phases de calibration durant lesquelles un instrument reproduit un phénomène connu ; la reproduction des artefacts déjà connus ; l’élimination des sources d’erreurs plausibles et l’élimination des possibles explications alternatives permettant d’expliquer un phénomène ; la reproductibilité des résultats expérimentaux ; l’intervention durant laquelle l’expérimentateur manipule l’objet étudié ; le recours à des corroborations expérimentales fondées sur d’autres expériences ; le recours à une théorie indépendante et bien corroborée par ailleurs ; le recours à des instruments reposant sur des théories pour le reste bien corroborées ; le recours à des arguments statistiques ; l’analyse des données en aveugle.

Je n’étudierai pas ici dans le détail toutes les stratégies[19], même si presque toutes sont mobilisées dans les deux laboratoires et sont repérables non seulement dans la pratique quotidienne des chercheurs, mais également dans l’argumentaire qu’ils développent dans les publications. Cela dit, certaines stratégies dominent au sein d’une discipline donnée et l’on pourrait envisager de cartographier le champ des sciences expérimentales en étudiant de manière systématique la place qu’y occupent les différentes stratégies et le poids relatif qui est conféré à chacune d’elle. Ainsi, deux d’entre elles sont plus particulièrement mobilisées en pharmacologie :

La reproductibilité. Parvenir à reproduire plusieurs fois une expérience et à obtenir des images équivalentes est très important en pharmacologie, tant la complexité des systèmes vivants rend difficile l’établissement et la maîtrise des paramètres pertinents pour l’investigation.

Le recours à des corroborations fondées sur d’autres expériences. Cette stratégie est présente dans la pratique quotidienne et structure généralement l’argumentaire final des publications. Imaginons qu’un article soit rédigé à l’issue de l’étude de la toxicité des nanoparticules. On y trouvera certainement une image source de microscopie optique destinée à montrer que certaines nanoparticules tuent les cellules bronchiques. On trouvera également, dans la publication, une image dérivée de données sources (un histogramme) permettant de visualiser la présence de cytokine résultant du stress provoqué par les nanoparticules. Ces deux images ont d’abord un statut épistémique faible, mais elles se renforcent l’une l’autre et acquièrent ainsi une valeur épistémique beaucoup plus élevée dans le cadre de l’argumentation qui sera ultérieurement développée dans une publication.

Pour conclure, l’adoption d’une perspective génétique permet tout d’abord de caractériser au moyen d’une même grille de lecture les images réalisées au sein de disciplines très différentes. C’est là un moyen de contourner l’écueil toujours envisageable consistant, lorsqu’on cherche à analyser les images scientifiques, à construire des outils de compréhension ad hoc, variant dès qu’on passe de l’étude d’une discipline scientifique à celle d’une autre. Cette variété des concepts opératoires nuit à la portée de l’analyse, qu’elle soit sémiotique, philosophique, historique, etc. D’autre part, l’adoption d’une perspective génétique permet de comprendre pourquoi toutes les images ne sont pas mises sur un même plan par les scientifiques, dans le cadre de leurs activités de recherche et de validation de leurs hypothèses. Cela exige, de la part de l’analyste, une prise en compte des processus de production des différents types d’images, des problèmes que ceux-ci comportent et des stratégies déployées par les scientifiques en vue de leur apporter des solutions. Cette perspective génétique me paraît donc présenter l’intérêt d’établir un pont entre l’universel (une même typologie pour classer les images quels que soient les domaines scientifiques abordés) et le particulier (souligner les difficultés inhérentes à la production des images et les stratégies de remédiation particulières propres à chaque discipline scientifique)[20].

Appendices

Note biographique

Catherine Allamel-Raffin

Catherine Allamel-Raffin est maître de conférences en philosophie des sciences à l’Université de Strasbourg. Elle est rattachée à l’Institut de recherches interdisciplinaires sur les sciences et la technologie (IRIST). Ses thèmes de recherches sont les images scientifiques dans plusieurs domaines des sciences de la nature : physique des matériaux, astrophysique et, plus récemment, pharmacologie. Elle croise, pour ce faire, des concepts issus de la sémiotique (Peirce, Groupe µ) avec ceux issus de la sociologie et de la philosophie des sciences. Sur ce thème, elle a publié plusieurs articles dans différentes revues : Communication et langages, Philosophia Scientiae, Les Génies de la Science et Visio.

Notes

-

[1]

Du point de vue de la méthodologie, j’ai recouru aux techniques de recueil de données qui sont celles de l’ethnographie de laboratoire. Pour ce faire, j’ai séjourné plusieurs mois dans chaque institut de recherche sélectionné. J’ai effectué des observations participantes et réalisé des entretiens semi-directifs ayant pour objet central l’image scientifique. Les disciplines étudiées sont la physique des matériaux, l’astrophysique et la pharmacologie. Les études se sont poursuivies de 2000 à 2009 (voir Allamel-Raffin, 2003 et suiv.)

-

[2]

Je suis ici en parfait accord avec l’exigence formulée par Luc Pauwels lorsqu’il affirme : « Si l’on considère les représentations scientifiques et les manières dont elles facilitent ou entravent notre compréhension, il est clair qu’une approche objectale, qui voudrait limiter notre attention à la représentation conçue comme un produit autonome du labeur scientifique, est inappropriée. Ce qui est exigé, c’est une approche processuelle : chaque représentation visuelle devrait être reliée à son contexte de production. De surcroît, elle ne peut être comprise hors de son contexte dynamique particulier d’utilisation, de réutilisation et de réception » (2006 : 21 ; ma traduction).

-

[3]

La typologie initiale en question a été élaborée au cours de mes premières recherches, qui portaient initialement sur la production et les fonctions des images en physique des matériaux et en astrophysique. Dans le cadre de ces travaux, j’ai associé les acquis de cette typologie à une approche inspirée de la sémiotique peircienne, en mobilisant en outre les concepts de signe iconique et de signe plastique, tels qu’ils sont définis par le Groupe µ. Pour plus de précisions, voir sur ce point Allamel-Raffin (2003, 2004a, 2004b, 2006).

-

[4]

J’ai séjourné durant une période d’environ six mois dans ce laboratoire entre 2001 et 2004. Le GSI est un laboratoire faisant partie de l’IPCMS (Institut de physique et chimie des matériaux de Strasbourg, unité mixte CNRS-ULP. UMR 7504).

-

[5]

Bien entendu, il existe, dans ce laboratoire, d’autres appareillages couramment utilisés en physique des matériaux : la diffraction des électrons lents (ou LEED), la spectroscopie Auger, le rayonnement synchrotron à Grenoble, etc.

-

[6]

Le laboratoire « Inflammation et environnement dans l’asthme » est une équipe d’accueil (EA 3771) intégrée à la Faculté de Pharmacie de Strasbourg. J’ai séjourné pour l’instant environ deux mois dans ce laboratoire. L’étude est en cours.

-

[7]

Cette classification est pertinente également pour les images produites en astrophysique. Pour plus de précisions, voir Allamel-Raffin (2004a, 2004b, 2006).

-

[8]

En d’autres termes, cette primauté sur le plan génétique est temporelle. Elle inclut également l’idée d’un nombre nécessairement plus réduit de médiations dans l’accès au référent que les images retraitées que je définirai un peu plus loin.

-

[9]

L’ensemble des chercheurs du GSI/IPCMS m’ont autorisée à reproduire les images qui figurent dans cet article.

-

[10]

Je préfère employer le terme « retraité », car les images sources résultent déjà en partie, comme je l’ai souligné plus haut, de traitements informatiques automatiques.

-

[11]

Bruit et artefact sont des effets indésirables qui apparaissent au cours du processus expérimental. Ce qui les différencie, c’est leur caractère : permanent dans le cas du bruit, ponctuel dans le cas de l’artefact.

-

[12]

Dans d’autres travaux (Allamel-Raffin, 2004a, 2004b, 2006), j’ai procédé à une analyse détaillée de ces traitements d’images grâce au concept de signe iconique élaboré par le Groupe µ. « “Le signe iconique possède certains caractères du référent, conformément à la définition classique du signe […]. Il possède aussi certains caractères ne provenant pas du modèle, mais du producteur d’image”. Le signe iconique est un type de représentation qui, moyennant un certain nombre de règles de transformations visuelles, permet de connaître certains objets du monde » (Joly [1994 : 96] citant le Groupe µ). Selon J.-M. Klinkenberg, s’inspirant de ses travaux avec le Groupe µ, la transformation est « un modèle rendant compte des ressemblances et des différences (de forme, de couleur, etc.) que l’on observe entre la représentation et l’objet de la représentation » (2000 : 387). Ces transformations peuvent être de quatre types : géométrique (les projections, les homothéties, les transformations topologiques) ; analytique (reposant sur l’algèbre : la discrétisation, par exemple) ; optique (amélioration de contraste, ajout de couleurs) ; cinétique (c’est l’observateur qui produit la transformation en changeant sa position, et donc l’angle de vision). Sans entrer ici dans le détail, je dirai que le recours aux trois premières catégories de transformation permet de rendre parfaitement compte des traitements d’images en physique des matériaux.

-

[13]

En physique des matériaux, quelques histogrammes figurent par exemple dans des articles consacrés à la croissance de matériaux. Ils ont pour fonction de permettre la comparaison de quantités de dépôts effectués dans des conditions expérimentales différentes.

-

[14]

Les conventions de représentation sont établies au fil du temps par la communauté des chercheurs et évoluent constamment. Certains signes apparaissent, d’autres disparaissent en fonction des besoins de la recherche et de ce qui est estimé constituer la meilleure visualisation possible pour un type de phénomène donné.

-

[15]

J’ouvre ici un champ d’investigation totalement nouveau pour moi, car ce type d’images, par exemple les histogrammes, était pratiquement absent de la physique des matériaux et de l’astrophysique.

-

[16]

Tufte indique en guise d’exemple de conséquence catastrophique l’accident de la navette américaine Challenger. Selon lui, ce dernier résulte du fait que la présentation visuelle des données était inadéquate et n’a pas permis de délivrer en temps utile la bonne interprétation.

-

[17]

À ce sujet, le concept de signe plastique développé par le Groupe µ m’a été particulièrement utile pour comprendre les processus qui menaient à la construction de la signification pour une image donnée. Le concept de signe plastique permet de focaliser son attention sur les caractéristiques matérielles de l’image. On peut définir différentes familles de signes plastiques : les couleurs, les formes et les textures (Groupe µ, 1992 : 196). Pour plus de précision sur ce point, voir Allamel-Raffin (2003, 2004a).

-

[18]

En revanche, ce qui est difficile en pharmacologie, c’est de relier le contenu de l’image à un « effet » donné ou attendu. Par exemple, dans le cas du Western Blot, l’anticorps utilisé est-il spécifique de la protéine recherchée ? Plusieurs expériences contrôles sont nécessaires pour le savoir : la taille de la protéine correspond-elle à la protéine native ? Si plusieurs bandes apparaissent, une bande peut correspondre à la taille attendue, mais d’autres protéines sont marquées par le même anticorps : s’agit-il d’une dégradation de la protéine native ? S’agit-il d’un fragment de cette protéine et de protéines marquées non spécifiquement par l’anticorps ?

-

[19]

Pour un exemple de mise en oeuvre de ces stratégies en physique des surfaces, voir Allamel-Raffin (2005a). Pour un exemple de mise en oeuvre de ces stratégies appliquées à l’invention de deux instruments scientifiques révolutionnaires – la lunette de Galilée et le microscope à effet tunnel –, voir Allamel-Raffin (2005b).

-

[20]

Cette étude devra sans aucun doute être complétée par l’adoption d’une perspective téléologique (dans quels buts les images sont-elles produites ?).

Références bibliographiques

- Allamel-Raffin, C. [2003] : « Comment le sens vient-il à l’image ? Analyse d’une conversation autour d’un microscope en physique des matériaux », Actes du 10e Colloque bilatéral franco-roumain, Supports, dispositifs et discours médiatiques à l’heure de l’internationalisation, Bucarest, 28 juin au 3 juillet. En ligne : http://archivesic.ccsd.cnrs.fr/sic_00000581/en/ (page consultée le 29 septembre 2009) ;

- Allamel-Raffin, C. [2004a] : La production et les fonctions des images en physique des matériaux et en astrophysique, thèse de doctorat, Strasbourg, Université Louis Pasteur. En ligne : http://sciences-medias.ens-lsh.fr/scs/article.php3?id_article=255 (page consultée le 29 septembre 2009) ;

- Allamel-Raffin, C. [2004b] : « La doctrine d’un philosophe expérimentaliste au service d’une science particulière : les images produites en physique des matériaux à la lumière de la sémiotique peircienne », Visio, vol. 9, no 1-2, 159-174 ;

- Allamel-Raffin, C. [2005a] : « De l’intersubjectivité à l’interinstrumentalité. L’exemple de la physique des surfaces », Philosophia Scientiae, vol. 9, no 1, 3-31 ;

- Allamel-Raffin, C. [2005b] : « De la lunette de Galilée au microscope à effet tunnel », Les Génies de la Science, no 23, 10-15 ;

- Allamel-Raffin, C. [2006] : « La complexité des images scientifiques. Ce que la sémiotique de l’image nous apprend sur l’objectivité scientifique », Communication et langages, no 149, 97-111.

- Bastide, F. [1985] : « Iconographie des textes scientifiques. Principes d’analyse », Culture technique, no 14, 133-152.

- Collins, H. M. [1981] : « Stages in the Empirical Programme of Relativism », Social Studies of Science, vol. 11, no 1, 3-10.

- Franklin, A. [1986] : The Neglect of Experiment, Cambridge, Cambridge University Press ;

- Franklin, A. [1990] : Experiment, Right or Wrong, Cambridge, Cambridge University Press.

- Giere, R. N. [1996] : « Visual Models and Scientific Judgment », dans B. S. Baigrie (dir.), Picturing Knowledge. Historical and Philosophical Problems Concerning the Use of Art in Science, Toronto, University of Toronto Press, 269-302.

- Groupeµ, [1992] : Traité du signe visuel. Pour une rhétorique de l’image, Paris, Seuil.

- Jacobi, D. [1985] : « La visualisation des concepts dans la vulgarisation scientifique », Culture technique, no 14, 152-163.

- Joly, M. [1994] : L’Image et les Signes. Approche sémiologique de l’image fixe, Paris, Nathan Université.

- Klinkenberg, J.-M. [2000] : Précis de sémiotique générale, Bruxelles, De Boeck Université, coll. « Points ».

- Latour, B. [1985] : « Les “vues” de l’esprit. Une introduction à l’anthropologie des sciences et des techniques », Culture technique, no 14, 5-29 ;

- Latour, B. [1993] : « Le travail de l’image ou l’intelligence savante redistribuée », LaClef de Berlin, Paris, La Découverte, 145-170.

- Latour, B. et S. Woolgar [1988] : La Vie de laboratoire. La production des faits scientifiques, Paris, La Découverte.

- Pauwels, L. [2006] : « A Theoretical Framework for Assessing Visual Representational Practices in Knowledge Building and Science Communications », dans L. Pauwels (dir.), Visual Cultures of Science. Rethinking Representational Practices in Knowledge Building and Science Communication, Hanover and London, University Press of New England, 1-25.

- Tufte, E. R. [1990] : Envisioning Information, Cheshire (CT), Graphic Press ;

- Tufte, E. R. [1997] : Visual Explanations. Images and Quantities, Evidence and Narrative, Cheshire (CT), Graphic Press ;

- Tufte, E. R. [2007] : The Visual Displays of Quantitative Information, Cheshire (CT), Graphic Press.

List of figures

Figure 1

Image STM d’agrégats de nickel sur cuivre.

Figure 2

Image retraitée. Image AFM représentant la topographie d’un film d’aluminium oxydé par technique plasma.

Figure 3

Figure 4

Image de modélisation d’atomes de cobalt sur or.

Figure 5

Image source de microscopie optique de cellules pulmonaires cultivées en présence de nanoparticules.

Figure 6

Image retraitée en microscopie confoncale représentant une jonction neuromusculaire.

Figure 7

Figure 8

Schéma explicatif.

Figure 9