Abstracts

Résumé

Les dispositifs d’enseignement hybride sont de plus en plus répandus dans l’enseignement supérieur. À notre connaissance, les facteurs responsables de leur efficacité sur les apprentissages ne sont pas clairement définis. Cet article a pour ambition, à travers une revue systématique de la littérature, de proposer des éléments de réponse à cette absence de connaissances. Nous présenterons un inventaire et une synthèse des éléments pédagogiques effectivement mis en place dans ce type de dispositif pour mettre en évidence les composantes pédagogiques en lien avec les performances des étudiants, selon la typologie de Burton et ses collaborateurs (2011). À cet égard, nous interrogeons quatre bases de données bibliographiques afin d’en extraire tous les documents (n = 1767) qui étudient l’enseignement hybride. Le corpus d’articles analysés comprend 21 études dans lesquelles sont comparés des dispositifs d’enseignement hybride à d’autres types d’enseignement (apprentissage en ligne et enseignement traditionnel). Un examen de ces documents met en lumière cinq composantes pédagogiques montrant un effet sur les apprentissages. Sans prétendre à une hiérarchisation de ces catégories, nous en proposons une discussion et une synthèse.

Mots-clés :

- enseignement hybride,

- enseignement supérieur,

- revue systématique,

- performances

Abstract

Blended learning is rapidly gaining popularity in higher education. To our knowledge, responsible factors for its effectiveness on learning do not seem clearly defined yet. This article aims, through a systematic review of the literature, to submit elements of response to this apparent lack of knowledge. We present an inventory and a synthesis of the pedagogical elements actually implemented in blended learning to highlight the pedagogical components related to student performance, according to the typology of Burton et al. (2011). In this regard, four bibliographic databases are being searched to extract all documents (n=1767) studying blended learning. The corpus of articles analyzed includes 21 different studies in which blended learning is compared to other types of educational methods (e-learning or traditional learning). An assessment of these documents highlights five educational components that show an impact on learning. Without claiming to rank them against each other, we put forward a discussion and a synthesis of these components.

Keywords:

- blended learning,

- higher education,

- systematic review,

- performances

Resumo

Os dispositivos de ensino híbrido estão cada vez mais difundidos no ensino superior. Tanto quanto sabemos, os fatores responsáveis pela sua eficácia na aprendizagem não estão claramente definidos. Este artigo tem como objetivo, por meio de uma revisão sistemática da literatura, propor elementos de resposta para esta ausência de conhecimentos. Apresentaremos um inventário e uma síntese dos elementos pedagógicos efetivamente implementados neste tipo de dispositivo para evidenciar os componentes pedagógicos ligados aos desempenhos dos estudantes, de acordo com a tipologia de Burton e dos seus colaboradores (2011). A este respeito, consultamos quatro bases de dados bibliográficos a fim de extrair todos os documentos (n = 1767) que estudam o ensino híbrido. O corpo de artigos analisados inclui 21 estudos nos quais os sistemas de ensino híbrido são comparados a outros tipos de ensino (aprendizagem online e ensino tradicional). Um exame destes documentos destaca cinco componentes pedagógicos que mostram um efeito nas aprendizagens. Sem pretender hierarquizar estas categorias, propomos uma discussão e uma síntese.

Palavras chaves:

- ensino híbrido,

- ensino superior,

- revisão sistemática,

- desempenhos

Article body

Introduction

Entre l’essor des technologies et l’évolution des formations d’une part, et la pression sur les écoles d’enseignement supérieur due aux évaluations internationales d’autre part, la mise en place de dispositifs efficaces devient une nécessité. Ainsi, la question de l’évaluation de l’efficacité de ces dispositifs apparaît centrale. Sur le plan social, de nombreux programmes de financement encouragent les travaux de recherche sur ces questions, par exemple les Initiatives d’excellence en formations innovantes (IDEFI) (Ministère de l’Enseignement supérieur, de la Recherche et de l’Innovation, 2019). Or, quels sont les éléments de réponse qu’apportent les travaux de recherche concernant cette délicate question relative à l’évaluation des dispositifs pédagogiques innovants, notamment les dispositifs d’enseignement hybride ?

L’enseignement hybride est un mode d’enseignement de plus en plus répandu dans l’enseignement supérieur (Charlier, Deschryver et Peraya, 2006 ; McKenzie et al., 2013) puisque de nombreux enseignants et institutions décident de le mettre en place (Gikandi, Morrow et Davis, 2011). En effet, de par leur intégration d’enseignement en présentiel et d’enseignement à distance, les dispositifs[1] hybrides permettent une certaine flexibilité en temps et espace, c’est-à-dire que les étudiants peuvent choisir le moment d’apprentissage en ligne et l’endroit (Al-Qahtani et Higgins, 2013 ; Huang, Lin et Huang, 2012). De plus, le nombre d’heures en classe réduit et l’accès aux ressources en ligne permettent une formation réalisable à certains apprenants, par exemple les parents avec un travail et une vie de famille, les personnes avec des besoins spécifiques ou les personnes pour qui les déplacements peuvent être un obstacle (Deschacht et Goeman, 2015).

Néanmoins, la question de savoir si ces dispositifs sont bénéfiques pour les étudiants en ce qui a trait à la performance ne semble pas tranchée (Burton et al., 2011) et encore moins les facteurs de leur efficacité (Vo, Zhu et Diep, 2017).

McCutcheon, Lohan, Traynor et Martin (2015) ont réalisé une revue systématique sur l’impact de dispositifs hybrides en école de soins infirmiers. Leur étude ne montre pas de différence de performances par rapport à des dispositifs traditionnels. Les mêmes résultats sont retrouvés dans la méta-analyse de Vo et ses collaborateurs (2017). Par la suite, en études de la santé, une méta-analyse de Liu et ses collègues (2016) montre un effet positif de l’enseignement hybride. Deux autres méta-analyses dans des contextes d’enseignement variés montrent un effet modeste mais significatif en faveur de l’enseignement hybride (Bernard, Borokhovski, Schmid, Tamim et Abrami, 2014; Means, Toyama, Murphy et Baki, 2013). Ces différentes études se sont déjà penchées sur les effets des dispositifs hybrides et les comparent à d’autres types d’enseignement, sans pour autant avoir cherché à identifier précisément des liens entre les composantes pédagogiques qui caractérisent les dispositifs d’enseignement et les performances des étudiants.

En somme, à notre connaissance, un inventaire et une synthèse des éléments pédagogiques effectivement mis en place dans ce type de dispositif n’ont pas encore été réalisés, et le lien entre ces éléments et les performances des étudiants n’a pas été identifié.

L’objectif de cet article est de constituer un inventaire des composantes impliquées dans les effets sur les performances dans l’enseignement hybride. Afin d’identifier ces facteurs, nous interrogerons des bases de données bibliographiques en adoptant une méthodologie de revue systématique. Cette exploration nous permettra d’extraire les éléments caractérisant les dispositifs hybrides. Ces éléments pédagogiques seront regroupés sous le terme de « composantes » et, à partir de cette typologie, nous analyserons les liens avec les effets observés sur les performances des étudiants.

Dans cet article, nous avons choisi de définir l’enseignement hybride en adoptant la définition la plus commune (Boelens, Van Laer, De Wever et Elen, 2015 ; Oliver et Trigwell, 2005), à savoir celle qui le caractérise comme l’« apprentissage qui se passe dans un contexte instructionnel caractérisé par la combinaison délibérée d’interventions en ligne et en classe avec pour objectifs de susciter et de soutenir l’apprentissage » (Boelens et al., 2015, p. 2).

La présente étude restreint son champ de recherche à l’enseignement supérieur.

Méthodologie

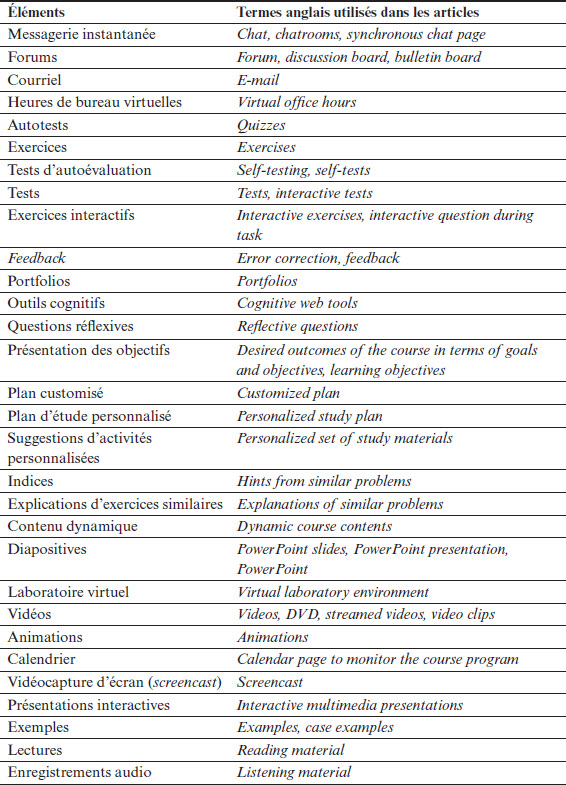

De très nombreux éléments pédagogiques caractérisent les dispositifs hybrides étudiés dans la littérature. Par exemple, certaines interventions sont proposées sous la forme d’enregistrement audio, de capsules vidéo ou de diapositives. D’autres mettent à disposition une messagerie instantanée ou des forums de discussion, tandis que d’autres encore mettent en place des autotests. Les possibilités sont nombreuses et la liste des éléments qui peuvent entrer en compte dans un dispositif hybride est très longue (voir Annexe F).

Régulièrement dans la littérature, les études sur les dispositifs hybrides peuvent attester ou récuser leur efficacité en matière de performances des étudiants. Néanmoins, rares sont les études qui se sont centrées précisément sur l’identification des éléments pédagogiques des interventions en ligne en lien avec l’efficacité de ces dispositifs. C’est pour cette raison que nous avons fait le choix de participer à combler ce manque.

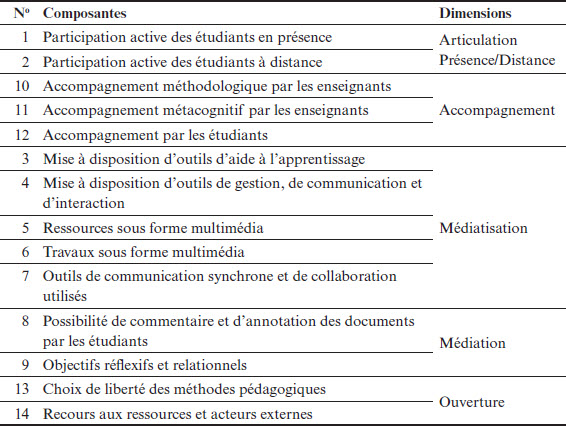

Dans un premier temps, nous allons répertorier les éléments pédagogiques mis en place dans les dispositifs hybrides pour, dans un second temps, les regrouper en catégories dans une typologie. Cela nous permettra de les mettre en lien avec des effets sur les performances des étudiants. Cette catégorisation s’appuiera sur les travaux de Burton et ses collaborateurs (2011).

Dès lors, la présente recherche vise à répondre aux questions suivantes : De quels éléments pédagogiques sont constituées les interventions en ligne des dispositifs hybrides ? Quelles sont les composantes pédagogiques caractérisant les dispositifs hybrides qui peuvent être mises en lien avec les performances des étudiants ?

La méthodologie utilisée pour répondre aux questions de recherche est une revue systématique de littérature, qui comprend plusieurs phases : 1) définition des critères d’inclusion, 2) procédure de recherche, 3) sélection des documents et 4) extraction des données. Ces différentes phases sont décrites dans les sous-sections suivantes. Une présentation des données et une synthèse des résultats seront réalisées ensuite.

Définition des critères d’inclusion

Les différents critères d’inclusion choisis sont largement inspirés par ceux utilisés par Cheung et Slavin (2016) et sont adaptés selon nos questions de recherche :

Les études doivent évaluer des dispositifs hybrides ;

Les études doivent avoir impliqué des étudiants de l’enseignement supérieur, donc postsecondaire, en formation initiale ou continue ;

Les études doivent comparer des étudiants dans des groupes où est mis en place le dispositif hybride donné (groupe expérimental) à des étudiants qui utilisent un autre dispositif (groupe témoin) ;

Les études sans groupe témoin, telles que les comparaisons pré-post, sont exclues ;

Les mesures dépendantes des études (les performances) doivent inclure des mesures quantitatives. Sont exclues les études dont les mesures de performance sont autorapportées[2].

Procédure d’extraction des articles

Quatre bases de données bibliographiques traitant notamment des domaines des sciences de l’éducation et de la psychologie ont été explorées : ERIC, PsycINFO, Academic Search Premier (ASP) et ScienceDirect. Une période de recherche a été identifiée entre 1995 et 2019 puisque la popularité d’Internet et des navigateurs web a commencé à croître dès le milieu des années 1990 (McCutcheon et al., 2015).

Les équations de recherche utilisées dans chaque base de données comprenaient trois concepts : dispositifs hybrides, enseignement supérieur et performances. Les options de recherche étant différentes selon les bases de données, les équations de recherche utilisées dans chacune d’entre elles sont détaillées en annexe (voir Annexes A, B, C et D).

Sélection des documents

De cette recherche bibliographique ont été extraits au total 1767 documents. Le diagramme de flux PRISMA a été utilisé pour présenter les différents tris et choix réalisés tout au long de la sélection des documents (voir Figure 1) (Moher, Liberati, Tetzlaff, Altman et Group, 2009). Un premier tri sur la base de la liste des revues HCÉRES[3] a été exécuté et nous a permis de conserver 471 documents. Un deuxième tri, correspondant à la lecture des titres et des résumés, nous a permis de conserver 138 documents. Ce deuxième tri a été réalisé sur base des critères d’inclusion. La lecture de ces 138 documents nous a permis de choisir les articles inclus dans le corpus de documents analysés sur base des critères d’inclusion, puis 21 articles ont été conservés pour cette analyse.

Figure 1

Diagramme de flux PRISMA

Extraction des données

La sélection terminée, le corpus d’articles analysés pour réaliser cette synthèse comprend 21 documents. Chacun de ces articles étudie un seul dispositif hybride. Dans tous les articles du corpus, les dispositifs hybrides sont comparés avec un ou deux types de dispositifs : 1) des dispositifs dits traditionnels (en présentiel ou en face-à-face) et 2) des dispositifs exclusivement en ligne ou à distance. Les différents aspects des 21 études recensées ont été synthétisés (voir Annexe E) :

L’objectif de l’étude en lien avec les performances ;

Des éléments méthodologiques : conception des groupes témoins et expérimentaux, durée de l’étude, nombre de participants ;

Les éléments pédagogiques du dispositif hybride comparé avec un ou deux autres types de dispositifs ;

La nature et la forme des performances évaluées ;

Les principaux effets observés de l’étude concernant les performances.

Résultats

En suivant l’ordre de nos questions de recherche, nous présentons nos travaux en trois parties : 1) une synthèse et classification des éléments pédagogiques extraits des articles, 2) une synthèse relative aux performances et 3) une synthèse générale.

Classification des éléments pédagogiques

Les éléments pédagogiques sont les éléments constituant les dispositifs hybrides étudiés dans les 21 études recensées, c’est-à-dire les éléments mentionnés par les auteurs des études lorsqu’ils décrivent les dispositifs. Nous avons recensé 30 éléments pédagogiques (voir Annexe F) en nous appuyant sur le niveau de détail exposé dans chacun de ces articles.

Dans les dispositifs hybrides, une partie de l’enseignement est en présentiel, tandis que l’autre est à distance. Parmi les éléments pédagogiques recensés, nous retrouvons principalement des éléments de l’enseignement à distance puisque l’enseignement en présentiel est défini par les auteurs comme de l’enseignement en face-à-face, de l’enseignement traditionnel ou des cours ex cathedra. Dans certains dispositifs sont tout de même mentionnées des activités en présentiel. En effet, cinq dispositifs précisent qu’ils profitent des cours en présentiel pour proposer des discussions aux étudiants ou des moments questions-réponses (Delialioglu et Yildirim, 2008 ; Demirer et Sahin, 2013 ; Harker et Koutsantoni, 2005 ; Makarem, 2015 ; McCutcheon, O’Halloran et Lohan, 2018), tandis qu’un dispositif met en place des jeux et des travaux de groupe (Bortnik, Stozhko, Pervukhina, Tchernysheva et Belysheva, 2017).

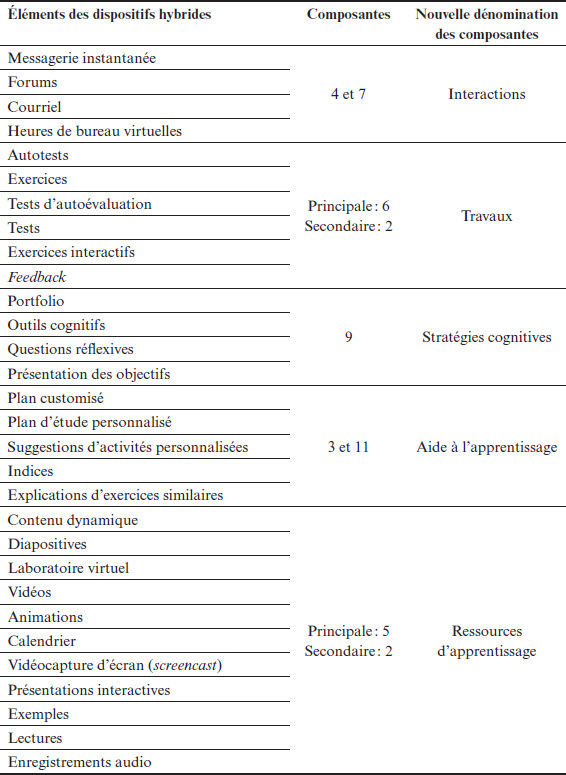

Les 30 éléments pédagogiques recensés dans les articles constituent la première colonne du tableau 2. Afin de les analyser au regard de travaux publiés jusqu’alors et de les synthétiser, nous avons choisi de mobiliser une catégorisation proposée par Burton et ses collaborateurs (2011) puis demandé à 7 juges de relier chacun de ces 30 éléments pédagogiques aux composantes identifiées par ces auteurs.

Burton et ses collègues (2011) ont élaboré une typologie des dispositifs hybrides de formation en enseignement supérieur à partir de « leurs caractéristiques pédagogiques, organisationnelles et matérielles » (p. 73). Ces auteurs mettent en évidence une série de composantes des dispositifs hybrides et les classent selon cinq dimensions proposées par Charlier et ses collaborateurs (2006) : « 1) la mise à distance et les modalités d’articulation des phases présentielles et distantes, 2) l’accompagnement humain, 3) les formes particulières de médiatisation, 4) et de médiation liées à l’utilisation d’un environnement technopédagogique et 5) le degré d’ouverture du dispositif » (Burton et al., 2011, p. 73). Le tableau 1 (extrait de Burton et al., 2011, p. 76) recense ces différentes composantes et les dimensions associées.

Tableau 1

Dimensions et composantes des dispositifs hybrides (Burton et al., 2011)

Les sept juges invités à catégoriser les éléments pédagogiques sont des enseignants de l’enseignement supérieur. Pour permettre cette catégorisation, les juges ont reçu l’intitulé des 14 composantes ainsi que leur description, tirée de l’article de Burton et ses collègues (2011). La consigne était la suivante : « Les éléments pédagogiques ci-dessous proviennent de plusieurs dispositifs d’enseignement hybride et sont utilisés pour caractériser ces dispositifs. Veuillez classer ces éléments pédagogiques selon les composantes proposées dans le tableau. Vous trouverez les détails des composantes sous le tableau. » Enfin, une définition des éléments était donnée aux juges en cas de besoin.

Le mode des composantes choisies pour chaque élément a été conservé ainsi que le second mode lorsque la fréquence était supérieure à 20 %. La composante principale correspond à la composante choisie le plus fréquemment par les juges, tandis que la composante secondaire correspond à la seconde composante choisie le plus fréquemment. Ainsi, les éléments ont pu être regroupés selon les composantes auxquelles ils correspondent selon les juges (voir Tableau 2).

Entre 4 et 11 éléments sont regroupés sous 1 ou 2 composantes. Par souci de facilité de lecture pour la suite de l’article, nous proposons une nouvelle dénomination des composantes (AAP : aide à l’apprentissage ; Int. : interactions ; Res. : ressources d’apprentissage ; SC : stratégies cognitives ; et travaux) ainsi que des deux éléments de comparaison (Dist. : enseignement à distance et Trad. : enseignement traditionnel).

Dans les dispositifs hybrides recensés, nous notons des proportions différentes des enseignements en présentiel et à distance. La figure 2 présente ces disparités. Les enseignements à distance peuvent varier de 30 à 70 % en temps d’enseignement.

Deux dispositifs offrent plus de temps d’enseignement en présentiel, tandis que deux autres dispositifs offrent plus de temps à distance. Les quatre autres dispositifs déclarent passer autant de temps d’apprentissage à distance qu’en présentiel.

Afin de décrire au mieux les études, nous pouvons visualiser les différents éléments qui caractérisent les dispositifs recensés selon les composantes. Les deux figures suivantes (figures 3 et 4) rendent compte des détails fournis dans les articles pour les études qui mentionnent la proportion de temps en présentiel et à distance.

Tableau 2

Synthèse des éléments pédagogiques selon les composantes (d’après Burton et al., 2011)

Figure 2

Proportion en temps de l’enseignement en présentiel et de l’enseignement en ligne

Note. Seuls les dispositifs pour lesquels l’information est disponible sont représentés dans cette figure.

Figure 3

Composantes relatives aux travaux – proportion en temps de l’enseignement en présentiel et de l’enseignement en ligne

Figure 4

Composantes relatives aux interactions – proportion en temps de l’enseignement en présentiel et de l’enseignement en ligne

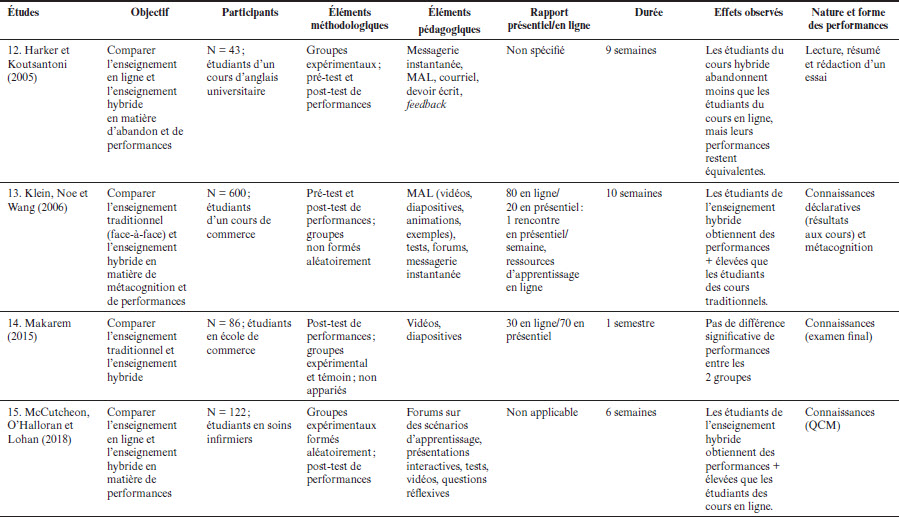

Résultats relatifs aux performances

Le tableau 3 montre à quel type d’enseignement les dispositifs d’enseignement hybride sont comparés (traditionnel ou à distance), la nature des performances évaluées ainsi que les résultats de l’étude. Les articles caractérisent la nature des performances de différentes façons :

La capacité de rétention ou de connaissance des étudiants : Par exemple, le dispositif étudié par Goette, Delello, Schmitt, Sullivan et Rangel (2017) vérifie si les étudiants peuvent identifier des troubles et lister des symptômes ;

La capacité à comprendre et à transférer les connaissances : Par exemple, le dispositif étudié par Bortnik et ses collègues (2017) mesure la compréhension des étudiants à travers des rapports de laboratoire. Ces rapports devaient témoigner de la capacité des étudiants à analyser la qualité de produits et à interpréter des résultats. Le dispositif étudié par Botts, Carter et Crockett (2018) mesure la capacité des étudiants à formuler un modèle mathématique et à résoudre un problème inédit ;

Le taux de réussite : C’est-à-dire le nombre d’étudiants qui réussissent le cours par rapport au nombre d’étudiants qui échouent ;

Le taux d’abandon : C’est-à-dire le nombre d’étudiants qui ne participent pas à l’évaluation finale du cours par rapport au nombre d’étudiants inscrits au cours.

Parmi les 21 dispositifs étudiés, 15 montrent au moins un résultat en faveur des dispositifs hybrides. Parmi ceux-ci, le dispositif de Deschacht et Goeman (2015) révèle un effet délétère du dispositif hybride sur l’abandon, c’est-à-dire que les étudiants qui suivent l’enseignement sous sa forme hybride abandonnent plus que les étudiants du cours traditionnel. Par contre, ce sont les étudiants des dispositifs hybrides qui réussissent le mieux. Cinq résultats ne montrent pas de différence de performances entre les dispositifs hybrides et l’enseignement traditionnel, tandis qu’un résultat ne montre pas de différence de compréhension entre dispositif hybride et enseignement à distance.

Néanmoins, ce travail de synthèse n’est pas indemne d’un biais de publication puisque tous les résultats de recherche ne sont pas publiés dans la littérature, notamment les résultats non significatifs (Slavin, 1995).

Tableau 3

Synthèse relative aux performances

Synthèse des résultats

Le tableau 4 propose une synthèse générale des résultats des 21 études et des composantes présentes dans chaque dispositif analysé :

Au total, 11 articles associent travaux et interactions. Parmi ces 11 articles, 10 montrent toujours au moins un résultat en faveur du dispositif hybride ;

Les 3 articles qui mobilisent l’AAP mobilisent également les travaux. Parmi ces 3 articles, 2 montrent un résultat en faveur du dispositif hybride ;

Les 4 articles qui mobilisent les SC mobilisent également les travaux. Parmi ces 4 articles, 3 montrent un résultat en faveur du dispositif hybride ;

8 articles associent travaux, interactions et ressources d’apprentissage. Parmi ces 8 articles, 7 montrent toujours au moins un résultat en faveur du dispositif hybride ;

Les 2 études où les composantes relatives aux ressources ne sont pas associées à d’autres composantes ne montrent pas de différence entre l’enseignement traditionnel et hybride.

Cette synthèse générale permet de mettre en lien les cinq composantes pédagogiques avec les performances des étudiants, ce qui nous conduit à proposer une discussion théorique de ces différents liens. La section suivante a pour objectif d’analyser et de décomposer ce tableau selon les différentes composantes.

Discussion

Nous proposons de discuter chacune des composantes repérées dans les articles mobilisés dans ce travail. Cette discussion a pour objectif de construire des hypothèses explicatives.

Composantes relatives aux travaux

Les éléments pédagogiques discutés dans cette partie sont placés dans les composantes 2 et 6 (voir tableau 1) de Burton et ses collègues (2011). La composante 2 correspond à la participation active des étudiants à distance et rassemble les activités de groupe et individuelles. La composante 6 correspond aux travaux sous forme multimédia et concerne les travaux exigés des étudiants.

Tableau 4

Synthèse des articles et des composantes

Note. Int. = interactions ; AAP = aide à l’apprentissage ; SC = stratégies cognitives ; Res. = ressources d’apprentissage ; Dist. = enseignement à distance ; Trad. = enseignement traditionnel.

Parmi les 21 dispositifs analysés, 17 précisent qu’ils proposent aux étudiants des travaux et activités à distance sous différentes formes. Parmi ces 17 dispositifs, seuls 3 ne montrent pas de différence en faveur du dispositif hybride par rapport au dispositif comparé.

Plusieurs formes de travaux et d’activités sont proposées aux étudiants. Six dispositifs proposent des autotests ou quiz (1, 5, 8, 11, 16 et 19). Le dispositif étudié par Al-Qahtani et Higgins (2013) précise que les étudiants reçoivent du feedback à la suite des autotests, tandis que le dispositif étudié par Wentao, Jinyu et Zhonggen (2016), réalisé dans le cadre d’un cours de langue, précise qu’il s’agit de questions à choix multiples, de compréhension à la lecture ainsi que d’exercices de grammaire.

Six dispositifs mettent en place des devoirs (3, 5, 8, 12, 20 et 21). Parmi ceux-ci, deux mentionnent simplement la mise en place de devoirs (3 et 8), deux précisent que les devoirs sont des tâches d’écriture (5 et 21) et le dispositif étudié par Harker et Koutsantoni (2005) note que les devoirs sont accompagnés d’un commentaire détaillé de l’enseignant. Enfin, les devoirs mis en place dans le dispositif étudié par York (2008) proposent des exercices visant à mettre en pratique les concepts en situation ainsi que des lectures hebdomadaires accompagnées de questions de réflexion et d’application.

Cinq dispositifs mettent à disposition des exercices (2, 4, 5, 6 et 18) : exercices de type relier ou compléter un texte à trous (2), exercices de laboratoire (4), problèmes et exercices pratiques (5 et 18) et exercices interactifs (6).

Un seul dispositif propose des tâches de simulation dans le cadre d’un cours en ingénierie mécanique (6).

Il semblerait que proposer des travaux et activités aux étudiants leur permet de se tester régulièrement. En effet, nous retrouvons les éléments « feedback après les autotests » (Al-Qahtani et Higgins, 2013, p. 224, trad. libre), « autotests notés immédiatement par le logiciel » (Botts et al., 2018, p. 240, trad. libre) et « autoévaluation pour que les étudiants puissent évaluer leur propre apprentissage par rapport aux objectifs d’apprentissage » (Harker et Koutsantoni, 2005, p. 199, trad. libre). En accord avec les résultats de Roediger et Karpicke (2006), qui étudient l’effet test (testing effect), le fait de se tester constitue un moyen d’optimiser les apprentissages et les performances des étudiants. Ces différents dispositifs ont donc instauré au moins un moyen de s’exercer aux étudiants.

De plus, ces différentes formes de travaux et d’activités permettent aux étudiants de recevoir du feedback sur leurs performances. La définition du feedback utilisée dans cette étude est celle décrite par Hattie et Timperley (2007), selon qui le feedback est une information donnée par un agent (enseignant, pair, expérience) concernant la performance ou la compréhension d’un individu. Les éléments pédagogiques des composantes relatives aux travaux permettent généralement aux étudiants d’obtenir ce type d’information.

Les modalités du feedback peuvent prendre différentes formes. Plus de la moitié des articles (1, 2, 3, 4, 6, 8, 10, 11, 12, 15, 20 et 21) ne précisent pas la forme que prend le feedback donné aux étudiants. Deux articles (16 et 18) proposent une correction et une explication en guise de feedback. L’article de Botts et ses collègues (2018) propose du « feedback immédiat concernant leur résolution de problème et donne l’option aux étudiants de recommencer l’exercice » (p. 240, trad. libre).

L’utilité du feedback formatif a été établie par le passé. Selon Clariana et Koul (2005), répondre à de nombreux tests et donc recevoir du feedback seraient efficaces en ce qui concerne l’apprentissage profond. Dans une méta-analyse, Gikandi et ses collaborateurs (2011) consolident ces résultats et montrent l’impact positif de l’évaluation formative en ligne. En effet, ce type d’évaluation favoriserait les expériences valorisables d’apprentissage, non négligeables pour accroître l’engagement des étudiants dans leurs apprentissages. Ces conclusions avaient été revendiquées antérieurement (Ryan, 1982 ; Sarrazin et Trouilloud, 2006) : le feedback formatif soutient le sentiment d’efficacité ainsi que la motivation intrinsèque, deux concepts qui sont liés à une augmentation des performances scolaires (Bandura, 1993 ; Deci et Ryan, 2000).

Notons tout de même que le simple fait d’apporter du feedback aux étudiants ne semble pas être source d’apprentissage. En effet, parmi les recherches récentes, les études de Calone et Lafontaine (2018) et de Harks, Rakoczy, Hattie, Besser et Klieme (2014) montrent un effet positif du feedback formatif (comparé au feedback normatif), à la condition qu’il soit perçu comme utile par les apprenants. Cette étude prend notamment sa source dans la théorie de l’autorégulation, qui rappelle qu’une fois le feedback transmis, l’apprenant doit analyser l’information (Calone et Lafontaine, 2018). Par le passé, les recherches nous ont montré la dimension des processus humains. D’ailleurs, le paradigme des processus médiateurs (Doyle, 1986) montre que les comportements adoptés par l’enseignant n’affectent pas toujours les apprenants ou ne les affectent pas comme désiré. Ce paradigme distingue deux types de stimuli : les comportements observables de l’enseignant (p. ex., le feedback) et les éléments effectivement traités par les apprenants. Harks et ses collègues (2014) ainsi que Rakoczy, Schütze, Klieme, Blum et Hochweber (2013) montrent que ce traitement du feedback est médié par l’utilité perçue ; cette perception marque un impact sur l’effet du feedback.

Dans cette section, nous avons décrit les différentes formes de travaux que les dispositifs sélectionnés offrent aux étudiants et nous avons rappelé l’intérêt peu contestable de l’apport du feedback, sous la gouverne de certaines nuances apportées par la littérature. Cette argumentation nous conduit à penser que les dispositifs hybrides qui proposent des travaux et du feedback aux étudiants donneront toutes les chances à ceux-ci d’améliorer leurs performances.

Composantes relatives aux interactions

Les éléments pédagogiques discutés dans cette partie sont classés dans les composantes 4 et 7 (voir tableau 1) de Burton et ses collaborateurs (2011). La composante 4 correspond aux outils de gestion, de communication et d’interaction, tandis que la composante 7 correspond aux outils de communication synchrone et de collaboration. De manière générale, les éléments de cette catégorie permettront aux étudiants d’interagir avec leurs pairs et/ou leur enseignant par différents moyens de communication. Parmi les 21 dispositifs, 12 permettent ces interactions. Parmi ces 12 dispositifs, seuls 2 ne montrent pas de différence en faveur du dispositif hybride par rapport au dispositif comparé.

Neuf dispositifs mettent en place un forum de discussion (1, 3, 8, 9, 13, 15, 16, 20 et 21). Parmi ces dispositifs, cinq mentionnent la mise en place du forum, sans ajouter de détails (1, 8, 13, 16 et 20) ; deux précisent que les étudiants peuvent y interagir avec les autres étudiants et avec le formateur (3 et 21) ; et un précise que l’enseignant propose des questions et des devoirs en lien avec les thèmes abordés (9). Enfin, le forum du dispositif étudié par McCutcheon et ses collègues (2015) est spécifiquement conçu pour proposer des scénarios de pratique clinique ainsi que pour permettre aux étudiants et aux formateurs de discuter leurs techniques de résolution.

Cinq dispositifs proposent une messagerie instantanée (1, 9, 13, 19 et 21). Parmi ces dispositifs, trois mentionnent la mise en place de la messagerie, sans ajouter de détails (1, 13 et 19) ; un dispositif précise que les étudiants peuvent y interagir avec les autres étudiants et avec le formateur (21) ; et un dispositif précise qu’après chaque cours, des rendez-vous en ligne sont organisés par le biais de la messagerie instantanée pour permettre aux étudiants et à l’enseignant de discuter régulièrement (9).

Trois dispositifs proposent la possibilité de s’échanger des courriels (1, 8 et 12). Un dispositif précise que les étudiants peuvent échanger de cette manière avec les formateurs (12).

Enfin, l’étude de Deschacht et Goeman (2015) décrit un dispositif qui propose d’interagir en offrant des heures de bureau virtuelles pendant lesquelles les étudiants peuvent discuter, en ligne, avec leur enseignant.

Même si les précisions apportées par les auteurs des études recensées ne nous offrent pas une explication détaillée de ces manières d’interagir, la littérature montre que permettre aux étudiants d’interagir est nécessaire pour répondre au besoin de proximité sociale (un des trois besoins fondamentaux des apprenants, selon la théorie de l’autodétermination) et favorise donc la motivation intrinsèque. Le besoin de proximité sociale correspond au « besoin d’appartenance et à la connexion avec les autres » (Deci et Ryan, 2000, p. 73, trad. libre) ; au « réseautage social » (social networking), qui permet les interactions sociales entre pairs et avec l’enseignant en classe ou en dehors de la classe (Deci et Ryan, 2000).

Ajoutons que les interactions sociales font partie des éléments prédicteurs du succès à l’apprentissage en ligne (Joksimović, Gašević, Kovanović, Riecke et Hatala, 2015). Ces auteurs montrent un lien positif entre les discussions dans un forum et les résultats d’apprentissage. En effet, les interactions permettent aux étudiants de partager leurs connaissances et cette stratégie constituerait du soutien important à l’apprentissage (Ma et Yuen, 2011) Buchs, Lehraus et Crahay (2012) ajoutent que, si les échanges sont organisés, « les dispositifs structurés d’apprentissage entre pairs sont efficaces » (p. 450), par exemple le tutorat. Ces auteurs mettent également en évidence les effets peu contestables de l’apprentissage coopératif, en tenant compte du fait que la coopération est favorisée par le développement des buts de maîtrise (Darnon, Buchs et Butera, 2006).

Aussi, Buchs, Lehraus et Crahay (2012) convergent avec un rapport récent de What Works Clearinghouse (Dabbagh et al., 2019), qui rappelle que les outils d’interaction peuvent, dans certaines conditions, augmenter l’engagement des étudiants en leur permettant de communiquer entre eux et avec leur enseignant autour d’un objectif commun d’apprentissage. Ces interactions influenceraient positivement les performances des étudiants (Dabbagh et al., 2019).

Dans cette section, nous avons décrit différentes manières de permettre aux étudiants d’interagir entre pairs et avec leur enseignant, en ligne, dans un dispositif hybride. Nous avons mis en évidence l’intérêt de proposer d’une part un environnement interactionnel appuyé par la théorie de l’autodétermination et, d’autre part, des pédagogies (partage de connaissances, tutorat, apprentissage coopératif) qui mobilisent les interactions sociales. Ces perspectives nous conduisent à penser que les dispositifs hybrides qui proposent des occasions d’interactions sociales font partie des dispositifs qui montrent des effets sur les performances des apprenants.

Composantes relatives à l’aide à l’apprentissage

Les éléments pédagogiques discutés dans cette partie sont classés dans les composantes 3 et 11 (voir tableau 1) de Burton et ses collègues (2011). La composante 3 correspond aux outils d’aide à l’apprentissage, tandis que la composante 11 correspond à l’accompagnement métacognitif par les enseignants. Parmi les 21 dispositifs, 3 dispositifs se retrouvent dans cette catégorie et, parmi ces 3 dispositifs, 1 seul ne montre pas de différence en faveur du dispositif hybride par rapport au dispositif comparé.

Parmi les articles sélectionnés, trois étudient des dispositifs qui mettent en place des plans personnalisés d’apprentissage pour les étudiants. Sur la base des performances et/ou du profil des étudiants, les dispositifs étudiés par Álvarez, Martín, Fernández-Castro et Urretavizcaya (2013) ainsi que par McKenzie et ses collaborateurs (2013) suggèrent un plan d’apprentissage et des références à certaines parties du cours. Le dispositif étudié par Botts et ses collègues (2018) propose aux étudiants des indices pendant les exercices ainsi que des exemples et explications sur base d’exercices similaires lorsqu’ils en ont besoin.

À notre connaissance, la personnalisation de l’apprentissage selon les performances des étudiants, dans un dispositif hybride, est peu étayée sous cette forme dans la littérature. Dès lors, il nous semble risqué d’émettre des hypothèses quant aux raisons de leur éventuelle efficacité. Cependant, nous supposons que de proposer une aide à l’apprentissage personnalisée aux étudiants peut être apparenté à une forme de différenciation. En effet, le postulat principal de la différenciation précise que « les expériences d’apprentissage doivent être conçues et adaptées pour satisfaire les besoins individuels et variés des étudiants afin de faciliter leur succès » (Santangelo et Tomlinson, 2009, p. 308, trad. libre).

Boelens, Voet et De Wever (2018) rappellent que l’enseignant peut faire correspondre l’enseignement aux différences individuelles en agissant sur quatre aspects : le contenu, les processus, le produit et l’affect. Selon ces auteurs, le contenu peut être adapté en modifiant soit ce que l’étudiant doit apprendre, soit la manière dont il sera présenté. L’enseignant peut également influencer les processus en adaptant ses méthodes pédagogiques et en passant d’un enseignement en grand groupe à un enseignement individuel. Les auteurs désignent le produit comme la démonstration de l’apprentissage de l’étudiant, généralement constatée par l’intermédiaire d’évaluations. Enfin, l’affect correspond au ressenti de l’étudiant concernant l’environnement d’apprentissage. L’enseignant peut agir sur ces quatre aspects de manière à correspondre aux besoins individuels des apprenants.

Sur cette base théorique, nous pouvons affirmer que les dispositifs étudiés dans cette section se basent sur les produits, c’est-à-dire sur les performances des étudiants, pour ensuite adapter le contenu d’apprentissage. Dans les dispositifs, ce n’est pas le contenu en lui-même qui est adapté aux besoins des étudiants, mais la manière dont il est proposé aux étudiants. En effet, un étudiant qui n’a pas besoin d’étudier tel chapitre parce que ses performances montrent qu’il en maîtrise le contenu ne sera pas dirigé vers ces enseignements. À l’inverse, un étudiant pour qui la matière n’est pas limpide sera dirigé vers ce chapitre.

Ces différents éléments nous permettent d’avancer que l’aide à l’apprentissage personnalisée s’inscrit dans une logique de différenciation. C’est pourquoi nous pouvons en déduire qu’intégrer cette aide dans un dispositif hybride peut s’avérer efficace.

Composantes relatives aux stratégies cognitives

Les éléments pédagogiques discutés dans cette partie sont classés dans la composante 9 (voir tableau 1) de l’article de Burton et ses collègues (2011). La composante 9 correspond aux objectifs réflexifs et relationnels. Parmi les 21 dispositifs, 4 dispositifs se retrouvent dans cette catégorie et, parmi ces 4 dispositifs, 1 seul ne montre pas de différence en faveur du dispositif hybride par rapport au dispositif comparé.

Le dispositif étudié par Bortnik et ses collaborateurs (2017) charge les étudiants de réaliser un portfolio contenant des traces de leur apprentissage. Dans le dispositif étudié par Delialioglu et Yildirim (2008), les outils cognitifs renvoient à des éléments tels que : surbrillance, signet, bloc-notes, recherche, glossaire, historique, plan du site et notes à retenir. Le dispositif étudié par McCutcheon et ses collègues (2018) propose des questions de réflexion conçues pour encourager les étudiants à appliquer leurs apprentissages. Enfin, Delialioglu et Yildirim (2008) ainsi que van Niekerk et Webb (2016) précisent que les objectifs des apprentissages sont systématiquement présentés aux étudiants. De plus, ce dernier dispositif est construit de manière à ce que les nouvelles informations soient intégrées à la structure mentale des étudiants.

Généralement, ces dispositifs incitent les étudiants à prendre du recul sur leurs apprentissages et à mettre en place des stratégies cognitives. Ils proposent du soutien à l’une des composantes de l’autorégulation (ou régulation interne), c’est-à-dire l’« aptitude de [l’apprenant] à prendre en charge ses processus cognitifs et motivationnels pour atteindre ses objectifs » (Laveault, 2007, p. 207). Cartier, Butler et Janosz (2007) précisent que l’autorégulation est caractérisée par :

« Un ensemble de pensées et d’actions orientées vers la gestion de l’activité à réaliser et de l’apprentissage proprement dit. Ces stratégies sont utilisées par l’élève pour planifier ses stratégies cognitives et ses ressources matérielles, contrôler l’avancement de son travail et de son apprentissage, faire des ajustements, au besoin, gérer sa motivation et ses émotions et, enfin, autoévaluer ses stratégies et sa performance »

p. 604

Cependant, la construction de ces stratégies n’est pas appliquée de manière spontanée par la plupart des étudiants, encore moins par les étudiants faibles qui se questionnent et qui réfléchissent généralement peu quant à leurs apprentissages (Chi, Bassok, Lewis, Reimann et Glaser, 1989 ; King, 1992) ; parfois en raison d’une absence de motivation (Mayer, 1992, cité par Bednall et Kehoe, 2011).

Ce soutien est nécessaire parce qu’avec l’implantation des dispositifs hybrides, l’étayage n’est plus qu’une affaire d’interactions entre un expert et un apprenant, mais devient un ensemble d’outils et de stratégies qui soutiennent l’apprenant dans l’acquisition de compréhension (Devolder, van Braak et Tondeur, 2012). Il se fait à travers le soutien apporté aux apprenants et pourrait également contrer l’apparition de surcharge cognitive (Lan, 1996, cité par Bednall et Kehoe, 2011).

En effet, notons la complexité de l’environnement en ligne (Schwonke et al., 2013), où les informations proviennent de ressources variées et où différentes représentations des contenus d’apprentissage sont donc proposées. Or, les apprenants ne tirent généralement pas avantage de ces différentes représentations et tendent à les utiliser de manière isolée, plutôt que de construire des liens entre elles. Les apprenants ont beau avoir un contrôle plus important sur leur apprentissage, l’exploitation de ces possibilités requiert des compétences cognitives qu’ils ne possèdent pas nécessairement (Devolder et al., 2012). Dès lors, la mise en place de soutien à l’autorégulation encourage la réflexion à un niveau que les étudiants ne considèrent généralement pas (Vygotsky,1978, cité par Davis, 2000). Par exemple, les apprenants ignorent souvent l’existence des outils mis en place ou les utilisent d’une mauvaise manière (Schwonke et al., 2013). Par exemple, ils n’utilisent pas leurs erreurs comme un signal pour demander de l’aide ou revenir en arrière.

De plus, différents chercheurs montrent que les stratégies d’autorégulation sont nécessaires pour apprendre dans l’enseignement supérieur (van den Boom, Paas, van Merriënboer et van Gog, 2004) ainsi que dans les dispositifs hybrides (Azevedo, 2008, cité par Devolder et al., 2012).

Dans cette section, nous avons noté les différentes formes que prennent les incitations à la réflexion dans les dispositifs hybrides étudiés. Ensuite, nous avons mis en évidence l’importance de la réflexion sur les apprentissages à travers l’apport de la littérature sur l’autorégulation. Nous pouvons affirmer que les dispositifs qui soutiennent l’autorégulation et les stratégies cognitives des apprenants peuvent montrer une certaine efficacité concernant leurs performances.

Composantes relatives aux ressources d’apprentissage

Les éléments pédagogiques discutés dans cette partie sont classés dans les composantes 2 et 5 (voir tableau 1) de Burton et ses collègues (2011). La composante 2 correspond à la participation active des étudiants à distance, tandis que la composante 5 correspond aux ressources sous forme multimédia. Parmi les 21 dispositifs, 18 se retrouvent dans cette catégorie et 3 ne déclarent pas mettre de ressources multimédias à disposition des étudiants.

Neuf dispositifs proposent leur enseignement ou une partie de leur enseignement sous forme de vidéos. Dans sept dispositifs étudiés (9, 10, 13, 14, 15, 16 et 21), les vidéos sont intégrées à l’enseignement au même titre que seraient proposés des contenus en ligne (matériel audio, diapositives, etc.) et ont pour objectif d’apporter une partie des contenus d’apprentissage. Dans deux dispositifs (7 et 15), les vidéos comprennent l’ensemble des contenus d’apprentissage.

L’intégration de vidéos dans des dispositifs hybrides peut être profitable. En effet, Merkt, Weigand, Heier et Schwan (2011)ainsi que van der Meij et van der Meij (2014) montrent que l’apprentissage des compétences procédurales est mieux appris dans des conditions « vidéo » que papier. D’autres études confirment que l’enseignement sous forme de vidéos permet de meilleures performances en matière de rétention et de compréhension que l’enseignement sous forme de lectures uniquement (Hung, Kinshuk et Chen, 2018). Traphagan, Kucsera et Kishi (2010) montrent que l’intégration de webdiffusion (webcast) dans un cours augmente l’absentéisme, mais le fait que les étudiants regardent les vidéos annule l’effet négatif de leur absentéisme sur leurs performances. Notons que les vidéos sont efficaces si les étudiants peuvent contrôler leur interactivité, si elles montrent l’essentiel de l’information et si elles présentent des procédures (Amadieu et Tricot, 2014 ; Hasler, Kersten et Sweller, 2007). De plus, les vidéos doivent être segmentées de manière à créer des segments qui ont du sens dans l’apprentissage et qui permettent à l’apprenant de digérer un segment avant de passer au suivant, pour éviter la surcharge cognitive (Fiorella et Mayer, 2018). Toutefois, les dispositifs identifiés ne précisent pas appliquer ces critères.

Cinq dispositifs mettent en ligne des diapositives comprenant les contenus d’apprentissage (2, 3, 13, 14 et 18). Ces diapositives sont parfois accompagnées de vidéos ou d’enregistrements audio (13 et 14). Notons que graphiques, contenus dynamiques, animations et lectures entrent également dans la catégorie des ressources multimédias. Ces derniers éléments sont proposés en ligne, sont à disposition des étudiants et ont pour objectif de soutenir les apprentissages en offrant d’autres supports d’informations.

Dans cette section, nous avons relevé les différentes ressources multimédias mises à disposition des étudiants dans les dispositifs étudiés et nous avons notamment mis en évidence les ressources proposées sous forme de vidéos puisque de nombreux dispositifs en comportent et qu’un large pan de la littérature traite de ces ressources.

Conclusion

Ce travail contribue modestement, d’une part, à mieux comprendre la mise en oeuvre de l’enseignement hybride et, d’autre part, à établir un état des lieux des facteurs impliqués dans les effets relatifs aux performances dans les dispositifs d’enseignement hybride.

En effet, l’objectif de cet article est de constituer un inventaire des facteurs impliqués dans les effets sur les performances dans l’enseignement hybride en enseignement supérieur. Deux questions de recherche ont été posées : De quels éléments pédagogiques sont constituées les interventions en ligne des dispositifs hybrides ? Quelles sont les composantes pédagogiques caractérisant les dispositifs hybrides qui peuvent être mises en lien avec les performances des étudiants ?

Une méthodologie de revue systématique a été menée. Premièrement, nous avons défini des critères d’inclusion pour sélectionner les articles inclus dans cette revue. Ensuite, des procédures de recherche ont été réalisées dans quatre bases de données, desquelles nous avons extrait 1767 articles. Une sélection manuelle de ces documents nous a permis de recenser 21 études correspondant aux critères d’inclusion. Ces études comparaient chacune un dispositif hybride avec un autre type d’enseignement (traditionnel ou en ligne). Une limite pourrait être formulée à ce choix de critère puisqu’il pourrait être envisagé une revue systématique comprenant les études pré-post. La prise en compte de ce travail pourrait être effectuée dans une étude ultérieure.

Pour cette revue systématique, dans chaque article, les éléments pédagogiques déclarés par les auteurs caractérisant les interventions en ligne de ces dispositifs ont été répertoriés, c’est-à-dire que nous avons compilé tout ce que les auteurs plaçaient concrètement sous le dispositif étudié. Rappelons que cette revue est dépendante des éléments déclarés par les différents auteurs des articles décrivant principalement les activités en ligne et, de manière plus succincte, les activités en présentiel. Cette étape nous a permis de répondre à notre première question de recherche.

Ces éléments ont ensuite été catégorisés par des juges, enseignants de l’enseignement supérieur, en utilisant la typologie proposée par Burton et ses collègues (2011). Cinq catégories ont été identifiées : les composantes relatives 1) aux travaux, 2) aux interactions, 3) à l’aide à l’apprentissage, 4) aux stratégies cognitives et 5) aux ressources d’apprentissage. Les composantes les plus mobilisées sont les composantes relatives aux travaux et aux ressources d’apprentissage.

Enfin, pour répondre à la seconde question de recherche, des liens entre les performances des étudiants et les composantes mobilisées ont été mis en évidence, puis analysés. Les résultats des études sont généralement en faveur des dispositifs hybrides, sauf dans certains cas, où ils sont comparés avec un enseignement traditionnel. Dans ces derniers cas, les auteurs ne trouvent pas de différence entre les performances. Parmi les articles où sont retrouvées les composantes relatives aux travaux et aux interactions, seules deux études ne montrent pas de différence de performances entre le groupe expérimental et le groupe témoin. Les autres études montrent des résultats en faveur des dispositifs hybrides. Les composantes d’aide à l’apprentissage et de stratégies cognitives sont toujours associées avec les composantes relatives aux travaux, et les résultats vont généralement en faveur des dispositifs hybrides. Les deux études où les ressources ne sont pas associées à d’autres composantes ne montrent pas de différence entre l’enseignement traditionnel et hybride.

Limites

Dans cette étude, cinq catégories de composantes ont été dégagées. Ces catégories décrivent une allure globale des dispositifs hybrides mis en place dans l’enseignement supérieur et ne sont pas hiérarchisées, c’est-à-dire qu’un classement selon leurs effets respectifs ne peut être prononcé. La principale limite de cette étude est de constater qu’un classement définitif selon leurs effets respectifs sera difficile puisqu’il existe une grande diversité de dispositifs hybrides et alternatifs. En effet, cette revue ne prétend pas certifier les composantes efficaces d’un dispositif hybride, mais a plutôt pour ambition de dégager des éléments de réponse. La lecture des articles sélectionnés dans le corpus ne permet donc pas une description précise des dispositifs effectivement étudiés.

Il semble également nécessaire de mentionner que, lorsqu’un dispositif propose plusieurs catégories de composantes, on ne peut pas en déduire d’où provient effectivement l’effet du dispositif. Quand un dispositif est comparé avec un autre type d’enseignement, et que l’outil et l’activité associée à cet outil ne sont pas présentés mais simplement nommés ou décrits superficiellement, on ne peut pas affirmer exactement ce qui est mesuré. C’est pourquoi nous suggérons que des recherches futures isolent ces différentes variables de manière à déterminer ce qui est effectivement efficace en établissant des liens de cause à effet. Si l’on garde à l’esprit que l’uniformisation des dispositifs hybrides n’est pas l’objectif, il serait en effet intéressant de déceler des invariants à mettre en place et à adapter dans les dispositifs proposés par les enseignants.

Appendices

Annexes

Équations de recherche

Les termes utilisés dans les équations de recherche précisées dans les annexes A à D sont les termes correspondant aux trois concepts définis dans la méthodologie et traduits en anglais. Seuls des termes anglais sont utilisés puisque les bases de données choisies pour les recherches recensent des documents en langue anglaise.

Le terme « dispositif hybride » est un terme francophone difficilement traduisible. Pour cette raison, selon les bases de données, nous avons utilisé le ou les descripteur(s) proposé(s) ou, en recherche libre, différents termes synonymes : blended learning, hybrid learning et computer assisted instruction.

Annexe A. ERIC

La base de données ERIC fonctionne avec un thésaurus. Dès lors, pour chaque concept intégré à la recherche, les descripteurs correspondants ont été utilisés. Le descripteur blended learning est « largement associé à des combinaisons de méthodes d’enseignement en face-à-face et en ligne » (trad. libre). La base de données précise également que ce descripteur est utilisé pour blended degrees, blended instruction et hybrid learning.

Trois descripteurs expriment le concept de performance : performance, outcomes of evaluation et academic achievement. Nous avons imposé à la recherche deux limites : higher education et journal articles.

Enfin, pour réduire la présence de bruit[4], nous avons intégré la notion d’études comparatives sous différents descripteurs : statistical analysis, quasi-experimental design, control groups, experimental groups, evaluation research et comparative analysis.

Le résultat de cette recherche, réalisée le 5 décembre 2019, nous a permis de recenser 165 documents.

Annexe B. PsycINFO

Dans la procédure utilisée dans PsycINFO, nous distinguons deux informations. Tout d’abord, nous retrouvons le mot clé blended learning, absent du thésaurus et donc utilisé sous sa forme libre. Différentes variantes de descripteurs proposées par la base de données, telles que distanceeducation, computer assisted instruction ou nontraditional education, créaient beaucoup de bruit. Ensuite, nous avons introduit le concept de performance sous les descripteurs performance, academic achievement, educational measurement, academic achievement prediction et academic aptitude.

Annexe C. Academic Search Premier

Dans la procédure utilisée dans Academic Search Premier, nous discernons trois informations. Le concept d’enseignement hybride se retrouve sous les descripteurs blended learning, computer assisted instruction et distance education. Ensuite, le concept de performance est décrit par les descripteurs performance, academic achievement, educational attainment et educational outcomes. Aussi, nous avons utilisé le descripteur higher education pour limiter la recherche. Enfin, nous avons limité la recherche aux articles de recherche (academic journals) puisque les autres documents proposés étaient des articles de presse.

Le résultat de cette recherche, réalisée le 5 décembre 2019, nous a permis de recenser 62 documents.

Annexe D. ScienceDirect

Dans la base de données ScienceDirect, nous avons utilisé les mots clés blended learning, hybrid learning et computer assisted instruction ainsi que higher education. Nous n’avons pas inclus le concept de performance pour éviter le silence. Enfin, nous avons limité la recherche aux articles de recherche (research articles) puisque les autres documents proposés étaient des éditoriaux.

Le résultat de cette recherche, réalisée le 7 mars 2020, nous a permis de recenser 1472 documents.

Annexe E. Synthèse des articles inclus dans le corpus

Tableau 5

Synthèse des articles inclus dans le corpus

Annexe F. Éléments pédagogiques recensés dans les dispositifs

Tableau 6

Éléments pédagogiques recensés dans les dispositifs

Remerciements

Les auteures remercient l’Agence nationale de la recherche du gouvernement français à travers le programme Investissements d’Avenir (16-IDEX-0001 CAP 20-25 – programme LIA) pour son soutien.

Notes

-

[1]

Lorsque nous utilisons le terme « dispositif », nous entendons la définition de Lebrun (2005, cité par Lebrun, Docq et Smidts, 2010), qui le définit comme « un ensemble cohérent constitué de ressources, de stratégies, de méthodes et d’acteurs interagissant dans un contexte donné pour atteindre un but. Le but du dispositif pédagogique est de faire apprendre quelque chose à quelqu’un ou mieux (peut-on faire apprendre ?) de permettre à “quelqu’un” d’apprendre “quelque chose” » (p. 49).

-

[2]

Une mesure de performance autorapportée est une mesure de performance rapportée par l’étudiant, sans échelle objective pour témoigner de cette performance. Par exemple, proposer une échelle de Lickert avec pour item « J’ai acquis des compétences sur les différents contenus de cours » correspond à une mesure de performance autorapportée.

-

[3]

Liste des revues et des produits de la recherche HCÉRES pour le domaine « sciences de l’éducation et de la formation » mise à jour le 3. mai 2016 et liste des revues AERES pour le domaine « psychologie-ethnologie-ergonomie » mise à jour le 12 juillet 2011.

-

[4]

« Le bruit documentaire est évoqué lorsque les résultats d’une recherche documentaire viennent parasiter par leur trop grand nombre ou par leur faible qualité la réponse attendue » (Duplessis et Ballarini-Santonocito, 2007, p. 10).

Références

- Al-Qahtani, A. A. Y., & Higgins, S. E. (2013). Effects of traditional, blended and e-learning on students’ achievement in higher education. Journal of Computer Assisted Learning, 29(3), 220-234. doi : 10.1111/j.1365-2729.2012.00490.x

- Álvarez, A., Martín, M., Fernández-Castro, I., & Urretavizcaya, M. (2013). Blending traditional teaching methods with learning environments : Experience, cyclical evaluation process and impact with MAgAdl. Computers & Education, 68, 129-140. doi : 10.1016/j.compedu.2013.05.006

- Aly, I. (2013). Performance in an online introductory course in a hybrid classroom setting. Canadian Journal of Higher Education, 43(2), 85-99. Retrieved from https://files.eric.ed.gov/fulltext/EJ1013589.pdf

- Amadieu, F. et Tricot, A. (2014). Apprendre avec le numérique : mythes et réalités. Paris, France : Retz.

- Bandura, A. (1993). Perceived self-efficacy in cognitive development and functioning. Educational Psychologist, 28(2), 117-148. doi : 10.1207/s15326985ep2802_3

- Bednall, T. C., & Kehoe, E. J. (2011). Effects of self-regulatory instructional aids on self-directed study. Instructional Science : An International Journal of the Learning Sciences, 39(2), 205-226. doi : 10.1007/s11251-009-9125-6

- Bernard, R. M., Borokhovski, E., Schmid, R. F., Tamim, R. M., & Abrami, P. C. (2014). A meta-analysis of blended learning and technology use in higher education : From the general to the applied. Journal of Computing in Higher Education, 26(1), 87-122. doi : 10.1007/s12528-013-9077-3

- Boelens, R., Van Laer, S., De Wever, B., & Elen, J. (2015). Blended learning in adult education : Towards a definition of blended learning. Gand, Belgique : Université de Gand. Retrieved from http://hdl.handle.net/1854/LU-6905076

- Boelens, R., Voet, M., & De Wever, B. (2018). The design of blended learning in response to student diversity in higher education : Instructors’ views and use of differentiated instruction in blended learning. Computers & Education, 120, 197-212. doi : 10.1016/j.compedu.2018.02.009

- Bortnik, B., Stozhko, N., Pervukhina, I., Tchernysheva, A., & Belysheva, G. (2017). Effect of virtual analytical chemistry laboratory on enhancing student research skills and practices. Research in Learning Technology, 25. doi : 10.25304/rlt.v25.1968

- Botts, R. T., Carter, L., & Crockett, C. (2018). Using the blended learning approach in a quantitative literacy course. PRIMUS, 28(3), 236-265. doi : 10.1080/10511970.2017.1371264

- Buchs, C., Lehraus, K. et Crahay, M. (2012). Coopération et apprentissage. Dans M. Crahay (dir.), L’école peut-elle être juste et efficace ? (pp. 421-454). Bruxelles, Belgique : De Boeck. Repéré à https://archive-ouverte.unige.ch/unige:27711

- Burton, R., Borruat, S., Charlier, B., Coltice, N., Deschryver, N., Docq, F., … Villiot-Leclercq, E. (2011). Vers une typologie des dispositifs hybrides de formation en enseignement supérieur. Distances et savoirs, 9(1), 69-96. doi : 10.3166/ds.9.69-96

- Calone, A. et Lafontaine, D. (2018). Feedback normatif vs feedback élaboré : quel impact sur la performance et le sentiment de contrôlabilité des élèves ? Évaluer : Journal international de recherche en éducation et formation, 4(2), 47-76. Repéré à http://journal.admee.org/index.php/ejiref/article/view/156/86

- Cartier, S. C., Butler, D. L. et Janosz, M. (2007). L’autorégulation de l’apprentissage par la lecture d’adolescents en milieu défavorisé. Revue des sciences de l’éducation, 33(3), 601-622. doi : 10.7202/018960ar

- Charlier, B., Deschryver, N. et Peraya, D. (2006). Apprendre en présence et à distance. Distances et savoirs, 4(4), 469-496. Repéré à https://www.cairn.info/revue-distances-et-savoirs-2006-4-page-469.htm

- Cheung, A. C. K., & Slavin, R. E. (2016). How methodological features affect effect sizes in education. Educational Researcher, 45(5), 283-292. doi : 10.3102/0013189X16656615

- Chi, M., Bassok, M., Lewis, M. W., Reimann, P., & Glaser, R. (1989). Self-explanations : How students study and use examples in learning to solve problems. Cognitive Science, 13(2), 145-182. doi : 10.1016/0364-0213(89)90002-5

- Clariana, R. B., & Koul, R. (2005). Multiple-try feedback and higher-order learning outcomes. International Journal of Instructional Media, 32(3), 239. Retrieved from https://www.learntechlib.org/p/63335

- Cortizo, J. L., Rodríguez, E., Vijande, R., Sierra, J. M., & Noriega, A. (2010). Blended learning applied to the study of mechanical couplings in engineering. Computers & Education, 54(4), 1006-1019. doi : 10.1016/j.compedu.2009.10.006

- Dabbagh, N., Bass, R., Bishop, M., Costelloe, S., Cummings, K., Freeman, B., … Wilson, S. J. (2019). Using technology to support postsecondary student learning : A practice guide for college and university administrators, advisors, and faculty. Washington, DC : Institute of Education Sciences, What Works Clearinghouse/National Center for Education Evaluation and Regional Assistance (NCEE). Retrieved at https://whatworks.ed.gov

- Darnon, C., Buchs, C. et Butera, F. (2006). Apprendre ensemble : but de performance et but de maîtrise au sein des interactions sociales entre apprenants. Dans B. Galand et É. Bourgeois (dir.), (Se) Motiver à apprendre (pp. 125-134). Paris, France : PUF.

- Davis, E. A. (2000). Scaffolding students’ knowledge integration : Prompts for reflection in KIE. International Journal of Science Education, 22(8), 819-837. doi : 10.1080/095006900412293

- Deci, E. L., & Ryan, R. M. (2000). The “what” and “why” of goal pursuits : Human needs and the self-determination of behavior. Psychological Inquiry, 11(4), 227-268. doi : 10.1207/S15327965PLI1104_01

- Deegan, D., Wims, P., & Pettit, T. (2016). Practical skills training in agricultural education : A comparison between traditional and blended approaches. Journal of Agricultural Education and Extension, 22(2), 145-161. doi : 10.1080/1389224X.2015.1063520

- Delialioglu, O., & Yildirim, Z. (2008). Design and development of a technology enhanced hybrid instruction based on MOLTA model : Its effectiveness in comparison to traditional instruction. Computers & Education, 51(1), 474-483. doi : 10.1016/j.compedu.2007.06.006

- Demirer, V., & Sahin, I. (2013). Effect of blended learning environment on transfer of learning : An experimental study. Journal of Computer Assisted Learning, 29(6), 518-529. doi : 10.1111/jcal.12009

- Deschacht, N., & Goeman, K. (2015). The effect of blended learning on course persistence and performance of adult learners : A difference-in-differences analysis. Computers & Education, 87, 83-89. doi : 10.1016/j.compedu.2015.03.020

- Devolder, A., van Braak, J., & Tondeur, J. (2012). Supporting self-regulated learning in computer-based learning environments : Systematic review of effects of scaffolding in the domain of science education. Journal of Computer Assisted Learning, 28(6), 557-573. doi : 10.1111/j.1365-2729.2011.00476.x

- Doyle, W. (1986). Paradigmes de recherches sur l’efficacité des enseignants. Dans M. Crahay et D. Lafontaine (dir.), L’art et la science de l’enseignement (pp. 435-481). Bruxelles, Belgique : Labor.

- Duplessis, P. et Ballarini-Santonocito, I. (2007). Petit dictionnaire des concepts info-documentaires : approche didactique à l’usage des enseignants documentalistes. Repéré à https://www.reseau-canope.fr/savoirscdi/fileadmin/fichiers_auteurs/PDF_manuels/dicoduplessis.pdf

- Fiorella, L., & Mayer, R. E. (2018). What works and doesn’t work with instructional video. Computers in Human Behavior, 89, 465-470. doi : 10.1016/j.chb.2018.07.015

- Gikandi, J. W., Morrow, D., & Davis, N. E. (2011). Online formative assessment in higher education : A review of the literature. Computers & Education, 57(4), 2333-2351. doi : 10.1016/j.compedu.2011.06.004

- Goette, W. F., Delello, J. A., Schmitt, A. L., Sullivan, J. R., & Rangel, A. (2017). Comparing delivery approaches to teaching abnormal psychology : Investigating student perceptions and learning outcomes. Psychology Learning & Teaching, 16(3), 336-352. doi : 10.1177/1475725717716624

- Harker, M., & Koutsantoni, D. (2005). Can it be as effective ? Distance versus blended learning in a web-based EAP programme. ReCALL, 17(2), 197-216. doi : 10.1017/S095834400500042X

- Harks, B., Rakoczy, K., Hattie, J., Besser, M., & Klieme, E. (2014). The effects of feedback on achievement, interest and self-evaluation : The role of feedback’s perceived usefulness. Educational Psychology, 34(3), 269-290. doi : 10.1080/01443410.2013.785384

- Hasler, B. S., Kersten, B., & Sweller, J. (2007). Learner control, cognitive load and instructional animation. Applied Cognitive Psychology, 21(6), 713-729. doi : 10.1002/acp.1345

- Hattie, J., & Timperley, H. (2007). The power of feedback. Review of Educational Research, 77(1), 81-112. doi : 10.3102/003465430298487

- Huang, E. Y., Lin, S. W., & Huang, T. K. (2012). What type of learning style leads to online participation in the mixed-mode e-learning environment ? A study of software usage instruction. Computers & Education, 58(1), 338-349. doi : 10.1016/j.compedu.2011.08.003

- Hung, I.-C., Kinshuk, & Chen, N.-S. (2018). Embodied interactive video lectures for improving learning comprehension and retention. Computers & Education, 117, 116-131. doi : 10.1016/j.compedu.2017.10.005

- Joksimović, S., Gašević, D., Kovanović, V., Riecke, B. E., & Hatala, M. (2015). Social presence in online discussions as a process predictor of academic performance. Journal of Computer Assisted Learning, 31(6), 638-654. doi : 10.1111/jcal.12107

- King, A. (1992). Comparison of self-questioning, summarizing, and notetaking-review as strategies for learning from lectures. American Educational Research Journal, 29(2), 303-323. doi : 10.3102/00028312029002303

- Klein, H. J., Noe, R. A., & Wang, C. (2006). Motivation to learn and course outcomes : The impact of delivery mode, learning goal orientation, and perceived barriers and enablers. Personnel Psychology, 59(3), 665-702. doi : 10.1111/j.1744-6570.2006.00050.x

- Laveault, D. (2007). De la « régulation » au « réglage » : élaboration d’un modèle d’autoévaluation des apprentissages. Dans L. Allal et L. Mottier Lopez (dir.), Régulation des apprentissages en situation scolaire et en formation (pp. 207-234). Bruxelles, Belgique : De Boeck Supérieur. Repéré à https://www.cairn.info/regulation-des-apprentissages-en-situation-scolair--9782804153144-page-207.htm

- Lebrun, M., Docq, F. et Smidts, D. (2010). Analyse des effets de l’enseignement hybride à l’université : détermination de critères et d’indicateurs de valeurs ajoutées. Revue internationale des technologies en pédagogie universitaire, 7(3), 48-59. doi : 10.7202/1003563ar

- Liu, Q., Peng, W., Zhang, F., Hu, R., Li, Y., & Yan, W. (2016). The effectiveness of blended learning in health professions : Systematic review and meta-analysis. Journal of Medical Internet Research, 18(1), e2. doi : 10.2196/jmir.4807

- Ma, W. W. K., & Yuen, A. H. K. (2011). Understanding online knowledge sharing : An interpersonal relationship perspective. Computers & Education, 56(1), 210-219. doi : 10.1016/j.compedu.2010.08.004

- Makarem, S. (2015). Using online video lectures to enrich traditional face-to-face courses. International Journal of Instruction, 8(2), 155-164. doi : 10.12973/iji.2015.8212a

- McCutcheon, K., Lohan, M., Traynor, M., & Martin, D. (2015). A systematic review evaluating the impact of online or blended learning vs. face-to-face learning of clinical skills in undergraduate nurse education. Journal of Advanced Nursing, 71(2), 255-270. doi : 10.1111/jan.12509

- McCutcheon, K., O’Halloran, P., & Lohan, M. (2018). Online learning versus blended learning of clinical supervisee skills with pre-registration nursing students : A randomised controlled trial. International Journal of Nursing Studies, 82, 30-39. doi : 10.1016/j.ijnurstu.2018.02.005

- McKenzie, W. A., Perini, E., Rohlf, V., Toukhsati, S., Conduit, R., & Sanson, G. (2013). A blended learning lecture delivery model for large and diverse undergraduate cohorts. Computers & Education, 64, 116-126. doi : 10.1016/j.compedu.2013.01.009

- Means, B., Toyama, Y., Murphy, R., & Baki, M. (2013). The effectiveness of online and blended learning : A meta-analysis of the empirical literature. Teachers College Record, 115(3), 1-47. Retrieved from https://www.sri.com/work/publications/effectiveness-online-and-blended-learning-meta-analysis-empirical-literature

- Merkt, M., Weigand, S., Heier, A., & Schwan, S. (2011). Learning with videos vs. learning with print : The role of interactive features. Learning and Instruction, 21(6), 687-704. doi : 10.1016/j.learninstruc.2011.03.004

- Ministère de l’Enseignement supérieur, de la Recherche et de l’Innovation. (2019). Initiatives d’excellence en formations innovantes. Paris, France : Ministère de l’Enseignement supérieur, de la Recherche et de l’Innovation. Repéré à https://idefi-anr-2019.fr/les-idefi/

- Moher, D., Liberati, A., Tetzlaff, J., Altman, D. G., & Group, T. P. (2009). Preferred reporting items for systematic reviews and meta-analyses : The PRISMA statement. PLOS Medicine, 6(7), e1000097. doi : 10.1371/journal.pmed.1000097

- Oliver, M., & Trigwell, K. (2005). Can “blended learning” be redeemed ? E-Learning and Digital Media, 2(1), 17-26. doi : 10.2304/elea.2005.2.1.17

- Rakoczy, K., Schütze, B., Klieme, E., Blum, W., & Hochweber, J. (2013). Written feedback in mathematics : Mediated by students’ perception, moderated by goal orientation. Learning and Instruction, 27, 63-73. doi : 10.1016/j.learninstruc.2013.03.002

- Roediger, H. L., & Karpicke, J. D. (2006). The power of testing memory : Basic research and implications for educational practice. Perspectives on Psychological Science, 1(3), 181-210. doi : 10.1111/j.1745-6916.2006.00012.x

- Ryan, R. M. (1982). Control and information in the intrapersonal sphere : An extension of cognitive evaluation theory. Journal of Personality and Social Psychology, 43(3), 450-461. doi : 10.1037/0022-3514.43.3.450

- Santangelo, T., & Tomlinson, C. A. (2009). The application of differentiated instruction in postsecondary environments : Benefits, challenges, and future directions. International Journal of Teaching and Learning in Higher Education, 20(3), 307-323. Retrieved from http://www.isetl.org/ijtlhe/pdf/ijtlhe366.pdf

- Sarrazin, P. G. et Trouilloud, D. (2006). Comment motiver les élèves à apprendre ? Les apports de la théorie de l’autodétermination. Dans P. Dessus et E. Gentaz (dir.), Comprendre les apprentissages : sciences cognitives et éducation (pp. 123-141). Paris, France : Dunod. Repéré à https://www.researchgate.net/publication/284600580_Comment_motiver_les_eleves_a_apprendre_Les_apports_de_la_theorie_de_l’autodetermination

- Schwonke, R., Ertelt, A., Otieno, C., Renkl, A., Aleven, V., & Salden, R. J. C. M. (2013). Metacognitive support promotes an effective use of instructional resources in intelligent tutoring. Learning and Instruction, 23, 136-150. doi : 10.1016/j.learninstruc.2012.08.003

- Singaravelu, G. (2010). Hybrid learning in enhancing communicative skill in English. Journal of Educational Technology, 7(1), 14-18. Retrieved from : https://files.eric.ed.gov/fulltext/EJ1098376.pdf

- Slavin, R. E. (1995). Best evidence synthesis : An intelligent alternative to meta-analysis. Journal of Clinical Epidemiology, 48(1), 9-18. doi : 10.1016/0895-4356(94)00097-A

- Traphagan, T., Kucsera, J. V., & Kishi, K. (2010). Impact of class lecture webcasting on attendance and learning. Educational Technology Research and Development, 58(1), 19-37. doi : 10.1007/s11423-009-9128-7

- van den Boom, G., Paas, F., van Merriënboer, J. J. G., & van Gog, T. (2004). Reflection prompts and tutor feedback in a web-based learning environment : Effects on students’ self-regulated learning competence. Computers in Human Behavior, 20(4), 551-567. doi : 10.1016/j.chb.2003.10.001

- van der Meij, H., & van der Meij, J. (2014). A comparison of paper-based and video tutorials for software learning. Computers & Education, 78, 150-159. doi : 10.1016/j.compedu.2014.06.003

- van Niekerk, J., & Webb, P. (2016). The effectiveness of brain-compatible blended learning material in the teaching of programming logic. Computers & Education, 103, 16-27. doi : 10.1016/j.compedu.2016.09.008

- Vo, H. M., Zhu, C., & Diep, N. A. (2017). The effect of blended learning on student performance at course-level in higher education : A meta-analysis. Studies in Educational Evaluation, 53, 17-28. doi : 10.1016/j.stueduc.2017.01.002

- Wentao, C., Jinyu, Z., & Zhonggen, Y. (2016). Learning outcomes and affective factors of blended learning of English for library science. International Journal of Information and Communication Technology Education, 12(3), 13-25. doi : 10.4018/ijicte.2016070102

- York, R. O. (2008). Comparing three modes of instruction in a graduate social work program. Journal of Social Work Education, 44(2), 157-172. doi : 10.5175/jswe.2008.200700031

- Zhang, W., & Zhu, C. (2018). Comparing learning outcomes of blended learning and traditional face-to-face learning of university students in ESL courses. International Journal on E-Learning, 17(2), 251-273.

List of figures

Figure 1

Diagramme de flux PRISMA

Figure 2

Proportion en temps de l’enseignement en présentiel et de l’enseignement en ligne

Figure 3

Composantes relatives aux travaux – proportion en temps de l’enseignement en présentiel et de l’enseignement en ligne

Figure 4

Composantes relatives aux interactions – proportion en temps de l’enseignement en présentiel et de l’enseignement en ligne

List of tables

Tableau 1

Dimensions et composantes des dispositifs hybrides (Burton et al., 2011)

Tableau 2

Synthèse des éléments pédagogiques selon les composantes (d’après Burton et al., 2011)

Tableau 3

Synthèse relative aux performances

Tableau 4

Synthèse des articles et des composantes

Tableau 5

Synthèse des articles inclus dans le corpus

Tableau 6

Éléments pédagogiques recensés dans les dispositifs

10.7202/018960ar

10.7202/018960ar