Abstracts

Résumé

Les principes théoriques de l’approche par compétences ont été largement documentés depuis les années 1980 ; cependant, peu d’écrits scientifiques portent sur leur transposition vers les outils d’évaluation utilisés en stage. S’appuyant sur le concept d’évaluation des compétences professionnelles (Legendre, 2007 ; Scallon, 2007 ; Tardif, 2006, 2017), cet article a pour but de brosser un portrait des outils d’évaluation en stage en enseignement. Les grilles d’évaluation de 41 programmes offerts dans 11 universités québécoises ont été analysées. L’analyse de contenu a permis de constater la diversité de manières de transposer certaines recommandations de la communauté scientifique vers les outils d’évaluation en stage.

Mots-clés :

- Évaluation,

- compétences,

- outils d’évaluation,

- stages en enseignement,

- formation pratique

Abstract

The theoretical principles of the competency-based approach have been widely documented since the 1980s, however little scientific literature has delt with their transposition into the assessment tools used during teaching internships. Based on the concept of professional competencies assessment (Legendre, 2007; Scallon, 2007; Tardif, 2006, 2017), the purpose of this article is to provide a portrait of the evaluation tools used during teaching internships. The evaluation forms from 41 programs offered in 11 Quebec universities were analysed. The content analysis illustrates the many ways of transposing some of the scientific community recommandations into the evaluation tools used during teaching internships.

Keywords:

- Evaluation,

- competencies,

- evaluation tools,

- teaching internships,

- practicum

Article body

Introduction

En 2020, en prévision de la parution éminente de la deuxième édition du référentiel des compétences professionnelles des enseignants au Québec (MEQ, 2020), le Centre de formation initiale des maitres (CFIM) de l’Université de Montréal a entrepris l’analyse des outils d’évaluation en stages dans tous ses programmes de formation à l’enseignement. L’analyse a mis en lumière une disparité entre les programmes qui a fait émerger un questionnement au sujet de la manière dont procèdent les autres universités québécoises pour évaluer les stagiaires. Une vaste recherche documentaire s’en est donc ensuivie afin de brosser un portrait de l’évaluation en contexte de stage en enseignement au Québec. Cet article présente les résultats de cette entreprise et se décline en cinq sections. La première section retrace l’état des connaissances entourant l’évaluation des compétences et notamment des principes théoriques servant à baliser l’élaboration des outils d’évaluation. La deuxième section présente le cadre conceptuel sur lequel s’appuie cette étude, soit les dimensions interprétative, développementale et formative de l’évaluation des compétences professionnelles. Les aspects méthodologiques sont ensuite abordés dans la troisième section avant de présenter les résultats dans la quatrième section. Enfin, cet article se termine par une discussion qui met en lumière les dimensions des outils d’évaluation analysés les plus en phase avec l’approche par compétences.

Problématique

Plusieurs défis et enjeux entourant l’évaluation des compétences en contexte de stage perdurent dans plusieurs programmes professionnalisants, dont sciences infirmières, médecine et éducation, au Québec comme ailleurs (Boyer, 2013 ; Lacasse et al., 2016 ; Legendre, 2007 ; Tobola et Périsset, 2021). Des enjeux associés à l’opérationnalisation de l’objet d’évaluation ainsi qu’à la compréhension des outils et critères d’évaluation ressortent notamment dans les écrits scientifiques (Boyer, 2013 ; Zinguinian et André, 2018). De plus, des défis en ce qui concerne la progression du développement des compétences et la prise en compte du contexte professionnel sont également soulevés (Bélair et al., 2017 ; Boyer, 2013 ; Lapointe et Guillemette, 2015 ; Scallon, 2007 ; Tobola et Périsset, 2021 ; Tourmen, 2015). Ces défis et enjeux illustrent la complexité entourant l’évaluation en contexte de stage où l’évaluateur est amené à faire preuve de jugement professionnel pour interpréter le niveau de développement des compétences des stagiaires (Lebel, 2009 ; Leroux et al., 2021 ; Maes et al., 2019).

Dans le champ de l’évaluation des compétences en contexte de stage, certaines recherches ont traité du point de vue des acteurs quant à leur appréciation des grilles d’évaluation prescrites par les universités (Bélair et al., 2017 ; Gouin et Hamel, 2015 ; Lapointe et Guillemette, 2015 ; Leshem et Bar-Hama, 2008 ; Monnard et Luisoni, 2013) et d’autres présentent le processus d’élaboration d’outils d’évaluation spécifiquement utilisés dans le cadre des stages (Gouin et Gasc, 2021 ; Tobola et Barras, 2020 ; Zinguinian et André, 2021). Toutefois, peu de recherches permettent de brosser un portrait des manières de tenir compte des principes théoriques de l’évaluation des compétences dans les outils en vigueur pour évaluer les stagiaires en enseignement.

Pourtant, pour guider l’évaluation des compétences, il est possible de s’appuyer sur des principes théoriques tels que 1) l’utilisation d’échelles d’appréciation descriptives, 2) l’opérationnalisation des niveaux de maitrise attendus et 3) l’ajout de commentaires qualitatifs dans le but d’augmenter la rigueur de la démarche évaluative (Legendre, 2007 ; Scallon, 2007 ; Tardif, 2006, 2017). La prise en compte de ces principes théoriques a le potentiel de favoriser la validité et l’équité du processus évaluatif, notamment dans le cadre des stages en enseignement où plusieurs formateurs assument l’évaluation des stagiaires d’une même cohorte (Boyer, 2013 ; Zinguinian et André, 2018). Pour compléter l’état des connaissances, ces trois principes théoriques guidant l’élaboration d’outils d’évaluation des compétences sont présentés, ainsi que les défis identifiés en ce qui concerne leur conception ou leur usage.

1) L’utilisation d’échelles descriptives pour interpréter les niveaux de compétence en contexte

En premier lieu, les échelles d’appréciation descriptives, analytiques ou globales, sont recommandées (Beckers, 2002 ; Maclellan, 2007 ; Scallon, 2007 ; Tardif, 2006). Les échelles analytiques regroupent des critères qui sont accompagnés d’une description qui spécifie ce qui est attendu à chacun des niveaux de l’échelle d’appréciation tandis que les échelles globales présentent une description générale des attentes par niveau (Bélair et al., 2017 ; Gouin et Hamel, 2015). La force de ce type d’échelles réside dans le fait qu’une description spécifie concrètement ce qui est attendu à chacun des niveaux (Scallon, 2007 ; Zinguinian et André, 2018, 2021). Toutefois, l’élaboration de ce type d’échelles demeure un défi puisqu’il est difficile de trouver l’équilibre entre la précision nécessaire pour baliser l’interprétation des niveaux et l’ouverture nécessaire pour tenir compte des spécificités de chaque contexte (Legendre, 2007 ; Zinguinian et André, 2021). Il n’en demeure pas moins que, malgré ce défi, les échelles d’appréciation uniformes, quantitatives ou qualitatives, sont les moins pertinentes pour évaluer les compétences (Boyer, 2013 ; Scallon, 2007 ; Tardif, 2006). Leur pertinence est moindre puisque l’interprétation des niveaux de l’échelle revient aux évaluateurs, en ce sens qu’ils décident ce qui distingue chaque niveau de l’échelle, par exemple ce qui différencie le niveau « excellent », du niveau « très bon », etc. (Boyer, 2013 ; Zinguinian et André, 2021).

2) L’opérationnalisation des niveaux de développement pour penser la progression des compétences en contexte

En deuxième lieu, il est suggéré de définir et d’expliciter des niveaux de développement pour chaque compétence par année de formation. Certains chercheurs proposent d’établir une trajectoire développementale en modélisant les niveaux de maitrise attendus pour chaque compétence de la première à la dernière année de formation du programme (Bélair, 2007 ; Hornby, 2003 ; Legendre, 2007 ; Tardif, 2006 ; Thilakaratne et Kvan, 2006). Ces trajectoires prennent habituellement la forme d’un bref paragraphe qui décrit le profil attendu par compétence à chaque année de la formation. D’autres chercheurs suggèrent d’élaborer quatre ou cinq indicateurs qui précisent le niveau de maitrise attendu pour chaque compétence par année (Baillé, 2001 ; Monnard et Luisoni, 2013 ; Roegiers, 2004). Un défi concernant les indicateurs est qu’ils sont souvent développés sans tenir compte du contexte professionnel, ceux-ci ne reflétant donc pas toujours les gestes professionnels qui seront observés dans le milieu de pratique, ce qui peut nuire par la suite à l’analyse de la progression des stagiaires (Scallon, 2007).

3) L’ajout de commentaires qualitatifs pour soutenir le développement professionnel

Enfin, il est suggéré que les outils d’évaluation tiennent compte du caractère prospectif de l’évaluation des compétences, c’est-à-dire qu’ils permettent de formuler des rétroactions constructives aux stagiaires afin qu’ils poursuivent leur progression au-delà du stage en cours (Legendre, 2007 ; Tardif, 2017). En effet, dans le cadre de l’évaluation des compétences, comme le volet formatif est important, les commentaires qualitatifs font ressortir les principales forces et les principaux points à améliorer des stagiaires (Leroux et al., 2021). Ces commentaires permettent de mieux situer le contexte dans le cadre duquel ont été interprétés les gestes professionnels et le niveau de développement des compétences du stagiaire (Leroux et al., 2021 ; Maes et al., 2019).

But de la recherche

Cet article examine comment ces trois principes théoriques en concordance avec l’approche par compétences sont concrètement transposés dans des grilles d’évaluation utilisées en contexte de stage en formation initiale à l’enseignement au Québec. À l’instar de Tobola et Barras (2020, p. 3), qui soutiennent que les outils d’évaluation en stage « gagnent à être analysés afin de déterminer leur potentiel d’amélioration pour permettre le développement conscient des compétences », cet article contribue à une meilleure compréhension des fondements qui orientent la conception des grilles d’évaluation et de la progression du développement des compétences lors des stages, des questions qui persistent depuis plus de vingt ans (Gervais et al., 1998).

Cadre conceptuel : dimensions de l’évaluation des compétences professionnelles

Afin de décrire la transposition de ces trois principes théoriques vers les outils d’évaluation en contexte de stage réalisée dans le cadre des différents programmes de formation en enseignement québécois, cette recherche s’appuie sur le concept d’évaluation des compétences professionnelles et plus spécifiquement sur ses dimensions interprétative, développementale et formative (Legendre, 2007). Ces trois dimensions sont brièvement définies dans cette section.

Dimension interprétative

L’évaluation des compétences professionnelles regroupe une dimension interprétative puisque la compétence est inobservable, elle est inférée à partir d’observations, de réflexions, de questionnements et de discussions qui permettent de comprendre les intentions sous-jacentes aux actions (Legendre, 2007 ; Scallon, 2007, Tourmen, 2015). En ce sens, outre l’observation du stagiaire en action, l’évaluateur tient compte de sa capacité réflexive et du raisonnement qui permet de comprendre pourquoi il agit d’une certaine manière dans un contexte particulier qui regroupe des ressources spécifiques (Legendre, 2007 ; Leroux et al., 2021). Ainsi, l’évaluation des compétences professionnelles est indissociable du contexte et son interprétation tient compte de la complexité des situations, ce qui implique nécessairement des ajustements évaluatifs lors du processus de jugement professionnel (Lebel et Bélair, 2018 ; Legendre, 2007 ; Maes et al., 2020).

La dimension interprétative permet de considérer que l’évaluation des compétences ne peut se faire par la somme des ressources mobilisées (Legendre, 2007) et que le jugement professionnel déployé en contexte d’évaluation des compétences représente un processus complexe, dynamique et itératif (Maes et al., 2020). Contrairement à une liste de vérification, la grille d’évaluation sert de grille de lecture pour aider l’évaluateur à interpréter les gestes professionnels (Legendre, 2007, Maes et al., 2019). Afin de mieux comprendre comment les formateurs peuvent utiliser la grille d’évaluation pour interpréter le niveau de développement des compétences démontré en contexte par un stagiaire, il est possible d’analyser le type d’échelle d’appréciation privilégié ainsi que les niveaux et les libellés des échelles utilisés dans les grilles d’évaluation.

Dimension développementale

L’évaluation des compétences professionnelles demande que l’évaluateur s’inscrive dans une logique de parcours puisque les compétences se développent graduellement et sur une longue période de temps (Legendre, 2007 ; Scallon, 2007 ; Tardif, 2006, 2017). Cette logique sous-tend que l’évolution progressive permettrait aux professionnels de s’adapter et de composer avec des situations de plus en plus complexes et diversifiées (Legendre, 2007). En ce sens, l’évaluateur reconnait que le profil des stagiaires est différent d’une année de formation à l’autre (Legendre, 2007).

La dimension développementale illustre l’importance d’une compréhension commune du niveau de maitrise attendu à chacune des années de formation et suppose que l’évaluateur tient compte de la progression attendue chez le stagiaire durant sa formation. Il importe donc de cibler les niveaux de développement qui correspondent à tous les profils de stagiaires, de la première à la dernière année de formation. Pour étudier la prise en compte de la dimension développementale dans les grilles d’évaluation actuellement utilisées en stages en enseignement, il est possible de repérer les compétences discriminantes ciblées aux différents stages, c’est-à-dire celles pour lesquelles les stagiaires doivent atteindre le seuil minimal de réussite afin de vivre un succès lors de leur stage. De plus, analyser les indicateurs de développement élaborés par les programmes permet aussi de considérer la dimension développementale présente dans les grilles d’évaluation.

Dimension formative

La fonction d’aide à l’apprentissage est centrale dans le processus d’évaluation des compétences professionnelles (Legendre, 2007). En effet, les évaluations formatives fréquentes sont essentielles pour soutenir le développement des compétences (Allal et Mottiez Lopez, 2005 ; Tardif, 2017). Les rétroactions fournies par l’évaluateur auront certes un impact à court terme lors d’un stage, mais aussi une résonnance à plus long terme. De plus, des autoévaluations régulières permettraient aux stagiaires de prendre conscience de leur propre progression (Allal et Mottiez Lopez, 2005). En ce sens, l’évaluateur peut également tenir compte des manières envisagées par le stagiaire d’assurer son propre développement professionnel, tant dans le stage en cours qu’en prévision de la suite de son parcours professionnel.

La dimension formative met en lumière l’aspect qualitatif de l’évaluation des compétences et repose sur des commentaires pour soutenir le jugement professionnel de l’évaluateur (Legendre, 2007). Afin de concevoir la prise en compte de cette dimension dans les grilles d’évaluation, il est possible d’examiner l’espace accordé aux commentaires ainsi que les types de commentaires demandés dans les grilles.

Méthodologie

La recherche présentée dans cet article est de nature exploratoire et descriptive. Cette section présente les étapes de la recherche documentaire, le corpus des documents analysés ainsi que le processus d’analyse des données.

Étapes de la recherche documentaire

La recherche documentaire a suivi trois étapes successives. D’abord, dans le cadre du projet amorcé par le CFIM, les grilles d’évaluation et les guides de stage de tous les programmes de formation initiale à l’enseignement offerts à l’Université de Montréal ont été recensés. Ensuite, les sites internet des universités québécoises ont été fouillés afin de trouver les outils d’évaluation disponibles en ligne. À cette étape, les pages web des facultés, départements et modules des sciences de l’éducation ont été scrutées, y compris celles des facultés et départements des sciences de l’activité physique. La dernière étape de la recherche documentaire a consisté à contacter directement par courriel les professeurs responsables des stages des programmes pour lesquels les outils d’évaluation n’étaient pas disponibles en ligne[1].

Corpus des documents analysés

Les documents analysés proviennent de 11 universités québécoises et de 41 programmes de formation initiale à l’enseignement. Le tableau 1 présente l’ampleur de l’échantillon analysé.

Tableau 1

Échantillon des documents analysés

Le corpus des documents analysés comporte les grilles d’évaluation sommative des stages 1 à 4 de tous les programmes recensés, ce qui correspond à 164 grilles d’évaluation. De plus, les sections portant sur l’évaluation dans les guides de stages disponibles (31 guides de stage sur 41 programmes) ont été analysées. Les guides de stage ont été analysés dans le but d’obtenir de l’information complémentaire à celle fournie directement dans les grilles d’évaluation.

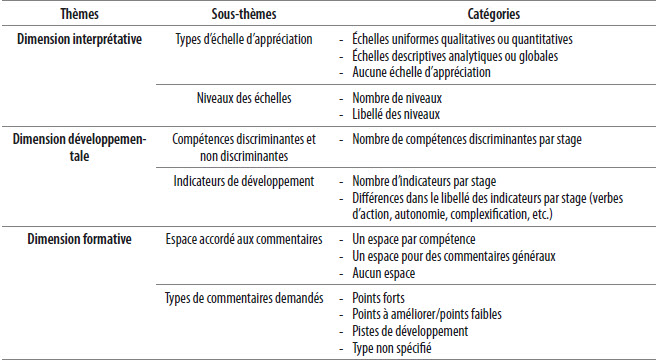

Processus d’analyse

Le corpus des documents recensés a fait l’objet d’une analyse de contenu qui a suivi les étapes proposées par Bardin (2013) : la préanalyse, l’exploitation du matériel et le traitement des résultats. L’analyse des données a suivi une démarche principalement déductive, à partir de catégories préétablies, tout en gardant une ouverture à l’ajustement de la grille d’analyse en cours de route. La phase de préanalyse a permis de cibler les catégories associées à chaque thème issu du cadre conceptuel. La phase d’exploitation du matériel s’est traduite par le codage des documents à l’aide des catégories précédemment identifiées. Lors de cette étape, la grille d’analyse a été peaufinée, notamment en spécifiant certaines catégories. Par exemple, dans la dimension formative, le sous-thème Espace accordé aux commentaires a été scindé en deux et des catégories spécifiquement liées au sous-thème Types de commentaires demandés ont été élaborées. Enfin, la phase de traitement des résultats a consisté à repérer, à travers l’ensemble des documents analysés, les résultats pertinents pour brosser le portrait des outils d’évaluation en stage. Le tableau 2 présente la grille d’analyse qui a été utilisée dans le cadre de cette recherche.

Tableau 2

Grille d’analyse

Résultats

Le portrait des outils d’évaluation des compétences en contexte de stage des programmes de formation à l’enseignement du Québec est présenté dans ce qui suit à partir des trois dimensions retenues de l’évaluation des compétences. Il permet d’identifier les tendances principales retrouvées parmi l’ensemble des programmes documentés.

Dimension interprétative

Les résultats démontrent que la moitié des programmes (21/41 programmes) privilégient une échelle descriptive analytique ou globale pour aider les formateurs à porter un jugement d’évaluation sur le niveau de développement des compétences des stagiaires. Bien que les libellés varient et que certains soient très généraux, ces échelles présentent toutes des balises descriptives qui délimitent ce qui est attendu à chacun des niveaux de l’échelle. Par exemple, dans un programme à l’Université de Sherbrooke, les composantes des compétences ciblées (qui sont subdivisées en différents critères) sont évaluées en fonction d’une échelle à six niveaux où le niveau Très satisfaisant correspond à : répond de façon très satisfaisante aux attentes pour la cible concernée et se situe même au-delà pour certaines attentes. Niveau de fréquence d’apparition de l’indicateur : souvent. Dans cet exemple, la cible concernée représente la composante de la compétence et l’indicateur représente le critère. Un deuxième exemple provenant de l’Université du Québec à Chicoutimi présente la description globale de ce qui est attendu pour un stagiaire de deuxième année au regard de la compétence en lien avec la planification de situations d’enseignement-apprentissage (compétence 3 dans le référentiel du MEQ de 2001) : en collaboration avec l’enseignant associé, il planifie des situations signifiantes d’enseignement-apprentissage qui tiennent compte de la logique des contenus du programme de formation et de la progression des apprentissages des élèves. Il tente d’anticiper les obstacles et les difficultés que risquent de rencontrer certains élèves. Il choisit des approches didactiques qui placent l’élève au centre de ses apprentissages.

Ensuite, les résultats illustrent que 18 programmes favorisent l’utilisation d’une échelle uniforme qualitative ou quantitative du type Insatisfaisant = 1 ; À améliorer = 2 ; Satisfaisant = 3 ; Très satisfaisant = 4 ; Excellent = 5, sans préciser ce que ce signifie chaque niveau. Enfin, l’analyse des grilles d’évaluation a permis de constater que deux programmes ne proposent pas d’échelle d’appréciation pour aider les formateurs à évaluer les compétences des stagiaires.

Au regard des niveaux des échelles, le nombre varie entre deux et six niveaux. Lorsque l’échelle d’appréciation présente seulement deux niveaux, les libellés correspondent à Succès ou Échec. Dans les autres cas, les libellés associés à chacun des niveaux varient d’un programme et d’une université à l’autre. Par exemple, certains programmes présentent des échelles à cinq niveaux allant de Très faible à Exceptionnel, de N’atteint pas les exigences à Au-delà des exigences ou de Maitrise insuffisante à Maitrise supérieure. La spécificité principale de ces échelles est qu’elles proposent un niveau qui correspond au fait de dépasser les attentes. Dans les autres grilles, les libellés vont de Ne correspond pas au niveau de maitrise attendu à Correspond au niveau de maitrise attendu ou de Ne répond pas aux exigences à Répond aux exigences ou encore de Non atteint à Atteint. Dans ces échelles, le niveau qui correspond aux exigences attendues englobe celui de maitrise supérieure.

Dimension développementale

L’analyse des données permet de constater deux manières distinctes d’opérationnaliser la progression à travers les quatre années de formation, soit la progression en nombre et la progression en complexité, en ce qui concerne les compétences ou les indicateurs considérés.

D’abord, au regard de la progression en nombre, seuls trois programmes évaluent de manière discriminante l’ensemble des compétences professionnelles tout au long de la formation, et ce, dès le premier stage. Au contraire, les résultats démontrent que 38 sur 41 programmes privilégient une augmentation du nombre des compétences discriminantes par stage. De ce nombre, la majorité des programmes (28/41) ciblent des compétences discriminantes dans les trois premiers stages, ce qui signifie que c’est seulement lors du quatrième et dernier stage que toutes les compétences sont discriminantes. Dans les autres programmes, des compétences discriminantes sont présentes dans les deux premiers stages (7/41) ou dans le premier stage seulement (3/41 programmes), toutes les compétences étant discriminantes lors des années suivantes.

Une seconde manière de témoigner de la progression en nombre est l’augmentation du nombre d’indicateurs à évaluer par stage. En effet, dans 15 programmes sur 41, il est possible de remarquer une répétition des indicateurs des stages précédents et l’ajout de nouveaux indicateurs à chaque stage. Ainsi, dans ces grilles, l’évaluateur réévalue les indicateurs des stages précédents en plus d’évaluer les indicateurs spécifiques au stage en cours. Cette configuration fait en sorte que lors des stages 3 et 4, le nombre d’indicateurs peut s’élever jusqu’à une quinzaine par compétence par rapport à deux ou trois indicateurs généralement en stage 1.

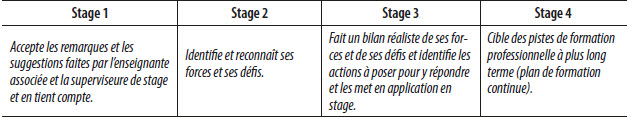

Ensuite, en ce a trait à la progression en termes de complexité, l’analyse des documents expose une augmentation de la complexité des indicateurs par stage dans 17/41 programmes. Cette complexité accrue se perçoit de trois manières différentes. Premièrement, dans certains programmes, les verbes d’action changent ou des attentes en matière d’autonomie dans les indicateurs sont précisées d’un stage à l’autre. Dans ces cas, il est possible de retrouver des verbes tels que s’informe, observe, comprend, pose des questions, etc., en stage 1 comparativement à des verbes tels que anticipe, conçoit, détecte, met en place, etc., en stage 4. Pour ce qui est du niveau d’autonomie, lors des deux premiers stages, plusieurs indicateurs font référence au soutien attendu de la part de l’enseignant associé : par exemple, des précisions telles que sous la supervision ou avec l’aide de l’enseignant associé sont ajoutées aux indicateurs. Deuxièmement, certains programmes privilégient l’élaboration d’indicateurs différents pour chaque stage. Dans ces programmes, le nombre d’indicateurs est d’environ quatre ou cinq par compétence et témoigne d’une complexification des attentes. Le tableau 3 montre un exemple provenant d’une grille de l’Université du Québec en Outaouais tiré de la compétence 11 : s’engage dans une démarche individuelle et collective de développement professionnel (MEQ, 2001).

Tableau 3

Exemple d’indicateurs différents du stage 1 à 4

Troisièmement, quelques programmes ont choisi d’élaborer une trajectoire développementale sous forme de description globale par compétence qui spécifie, à l’aide d’un bref paragraphe descriptif, ce qui est attendu d’un stagiaire à chacune de ses années de formation. Voici une capture d’écran d’un guide de stage de l’Université du Québec à Chicoutimi qui décrit les attentes liées à la compétence 4 : Pilotage des situations d’enseignement-apprentissage (MEQ, 2001) :

Figure 1

Exemple de trajectoire développementale sous forme de description globale

L’analyse des données permet de constater que dans 9 programmes sur 41, il n’est pas possible de distinguer la progression au regard du niveau de maitrise attendu d’un stage à l’autre. Dans ces programmes, il y a le même nombre d’indicateurs à tous les stages et les libellés des indicateurs sont identiques d’un stage à l’autre ou encore aucun indicateur n’est présent dans la grille d’évaluation ni dans le guide de stage, ce qui laisse présager qu’aucune balise de progression d’un stage à l’autre n’est proposée aux évaluateurs.

Dimension formative

Les résultats démontrent que 38 des 41 programmes accordent une place importante aux commentaires des évaluateurs dans les grilles d’évaluation. La majorité de ceux-ci offre un espace de commentaires par compétence. De surcroit, ces 38 programmes offrent aussi un espace supplémentaire à la fin de la grille pour rédiger un commentaire général. L’analyse des données a démontré que deux programmes laissent un espace seulement à la fin de la grille pour consigner des commentaires et qu’un programme n’offre aucun espace explicitement dédié aux commentaires.

Enfin, il est possible de remarquer que dans 25 programmes les grilles d’évaluation spécifient au moins un des trois types de commentaires suivants : les points forts, les points à améliorer ou les pistes de développement à proposer au stagiaire. En contrepartie, l’analyse a également démontré que 15 programmes ne spécifient pas le type de commentaires souhaités (tableau4).

Tableau 4

Synthèse des résultats

Discussion

Cette section discute des résultats selon l’ordre des dimensions les plus en phase avec les trois principes théoriques de l’approche par compétences ciblés dans les grilles d’évaluation en stage, soit d’abord la dimension formative, ensuite la dimension développementale et, enfin, la dimension interprétative.

Transposition manifeste de la dimension formative vers les grilles d’évaluation en stage

D’abord, au regard de la dimension formative, la présente recherche a démontré que la quasi-totalité des programmes accorde une place de premier plan aux commentaires dans les grilles d’évaluation, en accordant généralement un espace par compétence, qu’elle soit discriminante ou pas. Le caractère prospectif lié au concept d’évaluation des compétences laisse présager qu’il s’avère profitable pour le stagiaire de recevoir des commentaires qui ciblent non seulement ses forces, mais également ses points à améliorer ainsi que des pistes de développement pour l’avenir (Legendre, 2007 ; Scallon, 2007), ce qui est actuellement recherché comme type de commentaires dans la majorité des programmes. Il semble, de surcroit, que les formateurs préfèrent les grilles qui mettent l’accent sur les commentaires personnalisés (Bélair et al., 2017 ; Lapointe et Guillemette, 2015).

Par ailleurs, toujours dans un but formatif, la majorité des programmes inclut, en plus des compétences discriminantes, les compétences non discriminantes, c’est-à-dire celles qui ne sont pas évaluées de manière certificative dans leurs grilles. Comme précisé dans le paragraphe précédent, un espace pour offrir des commentaires au sujet de ces compétences est également disponible dans la grande majorité des grilles. Le fait de fournir des rétroactions formatives sur les compétences non discriminantes offre la possibilité de tenir compte du contexte réel dans lequel s’est déroulé le stage. En effet, un contexte en particulier peut solliciter davantage certaines compétences non discriminantes plutôt que certaines compétences discriminantes. Il semble que la consignation d’informations au regard de toutes les compétences à tous les stages comporte le potentiel d’aider le stagiaire à s’autoévaluer en vue de son stage subséquent, en plus d’aider l’évaluateur à procéder à des ajustements évaluatifs lors du processus de jugement professionnel (Maes et al., 2020). En somme, l’ajout des compétences non discriminantes dans les grilles semble favoriser la « dynamique formative » recherchée lors des stages qui sont conçus pour soutenir le développement professionnel et non pas seulement pour valider la maitrise des compétences professionnelles visées (Blondeau et al., 2021, p. 30).

Transposition variée de la dimension développementale vers les grilles d’évaluation en stage

Ensuite, au regard de la dimension développementale, cette recherche illustre la diversité des possibilités pour témoigner de la progression des stagiaires à travers leurs quatre années de formation. Bien que certaines stratégies mobilisées concordent moins avec les trois principes théoriques présentés dans la problématique, comme le fait d’augmenter le nombre d’indicateurs à chaque stage, plusieurs stratégies s’arriment à l’approche par compétences. Par exemple, la majorité des programmes augmentent graduellement le nombre de compétences discriminantes pendant la formation. Cette stratégie concorde avec la perspective mise de l’avant dans le nouveau référentiel des compétences professionnelles qui met l’accent sur le niveau d’acquisition des compétences à différents stades de la carrière (MEQ, 2020).

De plus, plusieurs programmes ont élaboré quatre ou cinq indicateurs par compétence qui évoluent en matière de complexité pour spécifier le niveau de maitrise attendu à chaque année de formation ou encore ont offert une description globale de la progression attendue en guise de trajectoire développementale, ce qui correspond aux principes théoriques liés à cette dimension (Bélair, 2007 ; Boyer, 2013 ; Hornby, 2003 ; Roegiers, 2004 ; Tardif, 2017 ; Thilakaratne et Kvan, 2006). Cette logique permet de concevoir les grilles d’évaluation davantage comme des outils de médiation plutôt que des outils certificatifs pour lesquels les formateurs ressentent parfois la pression de devoir s’assurer qu’ils ont bel et bien observé tous les indicateurs prescrits (Moussay et Blanjoie, 2021). D’ailleurs, en plus de s’arrimer à l’approche par compétences, ces pistes semblent porteuses de sens pour les formateurs. En effet, des recherches qui ont traité du point de vue des formateurs illustrent que ceux-ci préfèrent les grilles qui ne comprennent pas trop d’indicateurs (Bélair et al., 2017 ; Lapointe et Guillemette, 2015 ; Zinguinian et André, 2021).

Transposition précaire de la dimension interprétative vers les grilles d’évaluation en stage

Enfin, en lien avec la dimension interprétative, le portrait qui émerge de l’analyse des données révèle que, bien que la moitié des programmes privilégient des échelles dites descriptives, celles-ci ne correspondent pas exactement aux échelles descriptives au sens de Scallon (2007) et Tardif (2006). Il est certes possible de percevoir le souci d’offrir des balises en matière d’évolution des attentes dans les grilles recensées ; toutefois, dans la majorité des cas, ces balises demeurent très générales et sont les mêmes pour l’ensemble des compétences. Or, elles ne permettent pas de définir ce qui est attendu à chacun des niveaux de l’échelle pour chaque compétence évaluée, comme le recommandent des chercheurs (Bélair et al., 2017 ; Gouin et Hamel, 2015 ; Scallon, 2007 ; Tardif, 2006).

Outre ce résultat, la variété du nombre de niveaux et de libellés des échelles descriptives permet de constater qu’il n’y a pas une manière unique pour aider les formateurs à interpréter le niveau de développement des compétences des stagiaires. Toutefois, ce constat permet aussi de présager que des contraintes liées aux programmes éloignent parfois les concepteurs des grilles d’une approche par compétences. Par exemple, certaines échelles d’appréciation sont conçues pour permettre le transfert de la cote attribuée vers une note (A, B, C, D) comme le proposent les échelles où il est possible de choisir le libellé qui correspond au fait de dépasser les attentes. Pour être en accord avec l’approche par compétences, cette logique est seulement viable si de véritables échelles descriptives sont conçues et utilisées pour évaluer chaque compétence, ce qui n’est pas actuellement le cas (Bélair et al., 2017 ; Scallon, 2007 ; Tardif, 2006). D’autres chercheurs suggèrent plutôt de privilégier la notation Succès ou Échec lors des stages afin que les stagiaires s’inscrivent dans une logique de formation et non pas dans une logique de conformisme simplement dans le but d’obtenir un A lors de leur stage (Portelance et Caron, 2017 ; Vacher, 2017). En contrepartie, il n’est pas rare qu’un programme qui a fait le choix d’une notation par Succès ou Échec propose une échelle uniforme aux formateurs pour interpréter le niveau de développement des compétences des stagiaires, ce qui ne concorde pas davantage avec l’approche par compétences. Ainsi, au regard des résultats de cette recherche, il semble que la dimension interprétative soit celle la moins en phase avec les recommandations de la communauté scientifique au regard de l’évaluation des compétences.

Conclusion

Cet article avait pour but de brosser un portrait des outils d’évaluation en contexte de stage en enseignement au Québec. Il a notamment permis de mieux comprendre comment des principes théoriques liés à l’approche par compétences sont concrètement transposés dans les grilles d’évaluation. La diversité des stratégies mobilisées représente un résultat émergent de cette recherche et permet de constater qu’il semble possible de s’harmoniser à l’approche par compétences lors de l’évaluation en contexte de stage. Il importe de mentionner que les programmes de formation à l’enseignement professionnel ne sont pas représentés dans cette étude et pourraient faire l’objet d’une recherche ultérieure afin de brosser un portrait plus complet. Une autre limite réside dans le fait que cette étude fait ressortir les éléments convergents des écrits scientifiques au regard de la notion de compétence, bien qu’il soit admis que ce concept demeure polysémique, voire en débat (Chaliès et Lussi Borer, 2021). Par ailleurs, d’autres recherches sont à explorer, notamment celles portant sur la transposition des outils prescrits vers leur utilisation réelle ou encore sur l’accompagnement offert aux formateurs pour s’approprier ces outils. Enfin, des recherches pour documenter le déploiement et de la mise en oeuvre du nouveau référentiel des compétences professionnelles (MEQ, 2020) en contexte de stage permettront également de faire avancer les connaissances en matière d’évaluation des compétences dans ce contexte spécifique.

Appendices

Note

-

[1]

Toutes les personnes contactées ont gentiment accepté de partager leurs outils d’évaluation.

Bibliographie

- Allal, L. et Mottier Lopez, L. (2005). L’évaluation formative : revue de publications en langue française. Dans Centre pour la recherche en innovation dans l’enseignement (dir.), L’évaluation formative, pour un meilleur apprentissage dans les classes secondaires (p. 265-290). Organisation de coopération et de développement économiques (OCDE). https://doi.org/10.1787/9789264007420-fr

- Baillé, J. (2001). Les compétences, de nouveaux « objets » pour l’évaluateur. Dans G. Figari et M. Achouche (dir.), L’activité évaluative réinterrogée : regards scolaires et socioprofessionnels (p. 52-67). De Boeck. https://doi.org/10.3917/dbu.figar.2001.01

- Bardin, L. (2013). L’analyse de contenu. Presses universitaires de France. https://doi.org/10.3917/puf.bard.2013.01

- Beckers, J. (2002). Développer et évaluer des compétences à l’école : vers plus d’efficacité et d’équité. Labor.

- Bélair, L. (2007). Défis et obstacles dans l’évaluation des compétences professionnelles. Dans L. Bélair, D. Laveault et C. Lebel (dir.), Les compétences professionnelles en enseignement et leur évaluation (p. 181-212). Presses de l’Université d’Ottawa. https://doi.org/10.2307/j.ctt1cn6tf9

- Bélair, L. M., Lebel, C., Monfette, O., Miron, G. et Blanchette, S. (2017). Analyse des outils d’accompagnement et d’évaluation : point de vue des formateurs de terrain. Évaluer. Journal international de recherche en éducation et formation, 2(2), 9-25.

- Blondeau, M., Laurent, A. et Van Nieuwenhoven, C. (2021). Développer la compétence à faire la classe à travers des épisodes disjoints d’activité de stage. Dans S. Chaliès et V. Lussi Borer (dir.), Activité et compétence en tension dans le champ de la formation professionnelle en alternance (p. 15-32). Octarès.

- Boyer, L. (2013). Coconstruction d’un modèle cognitif de l’apprentissage d’une compétence en vue d’assurer la validité et l’équité de son évaluation : le cas de la compétence « Exercer un jugement clinique infirmier » [thèse de doctorat, Université de Sherbrooke]. SavoirsUdeS. https://savoirs.usherbrooke.ca/handle/11143/6384

- Chaliès, S. et Lussi Borer, V. (dir.). (2021). Activité et compétence en tension dans le champ de la formation professionnelle en alternance. Octarès.

- Gervais, C., Lepage, M. et Blais, J.-G. (1998). Étude de pratiques d’accompagnement et d’évaluation en stage dans des programmes universitaires de formation professionnelle. Actes du colloque de l’Association des enseignant.e.s et chercheur.e.s en sciences de l’éducation (AECSE) [CD-ROM].

- Gouin, J.-A., et Gasc, H. (2021, 3-7 mai). Élaboration de trajectoires de développement pour les stagiaires en enseignement secondaire par un processus collaboratif auprès des formateurs [communication orale]. 88e Congrès de l’Acfas, Sherbrooke, QC, Canada [en ligne].

- Gouin, J.-A. et Hamel, C. (2015). La perception de formateurs de stagiaires quant au développement et à l’évaluation formative des quatre compétences liées à l’acte d’enseigner. Revue canadienne d’éducation, 38(3), 1-27.

- Hornby, W. (2003). Assessing using grade-related criteria: a single currency for universities? Assessment and Evaluation in Higher Education, 28(4), 435-454. https://doi.org/10.1080/0260293032000066254

- Lacasse, M., Renaud, J.-S., Cantat, A. et Saucier, D. (2016). Développement de compétences avancées dans la formation des futurs médecins : l’exemple de la médecine familiale au Canada. Éducation et francophonie, 44(2), 126-151. https://doi.org/10.7202/1039025ar

- Lapointe, J.-R. et Guillemette, F. (2015). L’évaluation des stages par les acteurs de la formation pratique : modalités, supervision, évaluation et guide de stage. Revue des sciences de l’éducation, 41(2), 199-217. https://doi.org/10.7202/1034033ar

- Lebel, C. (2009). L’interprétation d’un référentiel en situation d’évaluation. Les dossiers en sciences de l’éducation, 22, 41-52.

- Lebel, C. et Bélair, L. M. (2018). La recherche collaborative et son apport au développement de l’agir professionnel d’enseignants associés. Phronesis, 7(4), 49-64. https://doi.org/10.7202/1056319ar

- Legendre, M.-F. (2007). L’évaluation des compétences professionnelles. Dans L. Bélair, D. Laveault et C. Lebel (dir.). Les compétences professionnelles en enseignement et leur évaluation (p. 169-179). Presses de l’Université d’Ottawa. https://doi.org/10.2307/j.ctt1cn6tf9

- Leroux, M., Boutonnet, V. et Lapointe, K. (2021). Transition vers une notation succès/échec pour l’évaluation de stages en enseignement au Québec : regards croisés de divers acteurs impliqués. Formation et pratiques d’enseignement en questions, 27, 157-173.

- Leshem. S. et Bar-Hama, R. (2008). Evaluating teaching practice. ELT Journal, 62(3), 257-265. https://doi.org/10.1093/elt/ccm020

- Maclellan, E. (2007). What is a competent « competence standard »? Quality Assurance in Education, 75(4), 437-448. https://doi.org/10.1108/09684880710829992

- Maes, O., Colognesi, S. et Van Nieuwenhoven, C. (2019). Le processus de construction du jugement évaluatif par les superviseurs de stage en enseignement. Mesure et évaluation en éducation, 42(1), 35-61. https://doi.org/10.7202/1066597ar

- Maes, O., Van Nieuwenhoven, C. et Colognesi, S. (2020). La coévaluation de stage… source de préoccupations, de difficultés, voire de tensions pour le superviseur de HEP. Évaluer. Journal international de recherche en éducation et formation, 6(3), 3-23.

- Ministère de l’Éducation du Québec. (2001). La formation à l’enseignement : les orientations, les compétences professionnelles. Gouvernement du Québec.

- Ministère de l’Éducation du Québec. (2020). Référentiel de compétences professionnelles : profession enseignante. Gouvernement du Québec.

- Monnard, I. et Luisoni, M. (2013). Sens attribué à l’évaluation des compétences professionnelles par tâches complexes chez de futurs enseignants en formation. Mesure et évaluation en éducation, 36(2), 1-27. https://doi.org/10.7202/1024413ar

- Moussay, S. et Blanjoie, V. (2021). Le tutorat mixte : tension entre deux logiques comme opportunité d’articulation entre activité et compétence. Dans S. Chaliès et V. Lussi Borer (dir.), Activité et compétence en tension dans le champ de la formation professionnelle en alternance (p. 89-101). Octarès.

- Portelance, L. et Caron, J. (2017). Logique du stagiaire dans son rapport à l’évaluation. Phronesis, 6(4), 85-98. https://doi.org/10.7202/1043983ar

- Roegiers, X. (2004). L’école et l’évaluation : des situations pour évaluer les compétences des élèves. De Boeck Université. https://doi.org/10.3917/dbu.roegis.2010.01

- Scallon, G. (2007). L’évaluation des apprentissages dans une approche par compétences. De Boeck.

- Tardif, J. (2006). L’évaluation des compétences : documenter le parcours de développement. Chenelière.

- Tardif, J. (2017). Des repères conceptuels à propos de la notion de compétence, de son développement et de son évaluation. Dans M. Poumay, J. Tardif et F. Georges (dir.). Organiser la formation à partir des compétences (p. 15-38). De Boeck Supérieur. https://doi.org/10.3917/dbu.pouma.2017.01

- Thilakaratne, R. et Kvan, T. (2006). Competence-based assessment in professional education validation. Quality in Higher Education, 12(3), 315-327.

- Tobola, C. et Barras, H. (2020, 13-14 février). Évaluation des compétences dans une formation à l’enseignement, photographie et propositions d’améliorations [communication orale]. 6e colloque du Groupe pour l’évaluation des pratiques professionnelles (gEvaPP), Fribourg, Suisse.

- Tobola, C. et Périsset, D. (2021). L’évaluation des compétences professionnelles sur le terrain : de la formation à la certification, une progressivité à interroger. Formation et pratiques d’enseignement en questions, 27, 15-33.

- Tourmen, C. (2015). L’évaluation des compétences professionnelles : apports croisés de la littérature en évaluation, en éducation et en psychologie du travail. Mesure et évaluation en éducation, 38(2), 111-144. https://doi.org/10.7202/1036765ar

- Vacher, Y. (2017). Évaluation, norme et accompagnement : effets d’un dispositif de développement de l’analyse réflexive des professeurs stagiaires en enseignement. Phronesis, 6(4), 114-130. https://doi.org/10.7202/1043985ar

- Zinguinian, M. et André, B. (2018). La construction d’échelles descriptives pour évaluer des stages en enseignement : analyse d’un processus à visée consensuelle. Formation et pratiques d’enseignement en questions, 23, 229-247.

- Zinguinian, M. et André, B. (2021). L’impact d’un instrument d’évaluation sous forme d’échelles descriptives sur les évaluations formatives et certificatives de futurs enseignants du secondaire obligatoire en Suisse. Formation et pratiques d’enseignement en questions, 27, 137-155.

List of figures

Figure 1

Exemple de trajectoire développementale sous forme de description globale

List of tables

Tableau 1

Échantillon des documents analysés

Tableau 2

Grille d’analyse

Tableau 3

Exemple d’indicateurs différents du stage 1 à 4

Tableau 4

Synthèse des résultats

10.7202/1039025ar

10.7202/1039025ar