Abstracts

Résumé

Les données sont présentes dans l’environnement informationnel actuel sous différentes formes : données confidentielles commerciales ou gouvernementales, mégadonnées, données ouvertes des gouvernements, données ouvertes liées (Linked Open Data) du Web sémantique. Comment les professionnels de l’information devraient-ils se préparer pour traiter ces divers types de données ? Nous proposons que cette préparation repose sur trois éléments : une connaissance éclairée des différents types de données en jeu, une initiation aux ressources nécessaires pour traiter chaque type et une compréhension de l’impact qu’aura chacun sur la discipline des sciences de l’information et sur la pratique des professionnels de l’information.

Abstract

Various forms of data are presented in the current information environment : confidential commercial or government data, big data, government open data, and linked open data of the Semantic Web. How should information professionals prepare themselves to handle or process the different types of data ? We suggest that this preparation be based on three aspects : a clear understanding of the different types of data, an initiation to the resources required to process each type of data and an understanding of the impact that each type will have on information science as a discipline and on the practice of information professionals.

Article body

Introduction

Nous voici à l’ère de la révolution des données (voir notamment [Borgman 2015 ; Kitchin 2014a ; Hey, Tansley & Tolle 2009]). Elles sont présentes dans l’environnement informationnel actuel sous différentes formes : données confidentielles hébergées par les institutions financières ou gouvernementales, grands ensembles de données (données massives, ou mégadonnées – big data) de diverses sources, données ouvertes (comme celles publiées par les gouvernements municipaux ou nationaux), données ouvertes liées (Linked Open Data) du Web sémantique, données de la recherche universitaire, industrielle ou gouvernementale. Devant le déluge des publications reliées au thème des données, il peut être difficile de s’y retrouver. L’objectif de cet article est de dresser un panorama des types de données auxquelles sont confrontés les professionnels de l’information afin de bien distinguer chacun des types, ainsi que d’étudier les conséquences des particularités de chaque type sur la théorie et la pratique de la gestion de l’information. Spécifiquement, nous tentons de répondre à la question suivante : comment les professionnels de l’information (bibliothécaires, archivistes, gestionnaires de documents) devraient-ils se préparer pour traiter ces divers types de données ? Nous allons faire valoir que cette préparation doit reposer sur trois éléments. Le premier est une connaissance éclairée des différents types de données qui sont en jeu. Le deuxième est une initiation aux ressources nécessaires pour traiter chaque type de données. Le troisième élément clé est une compréhension de l’impact qu’aura chacun de ces types distincts sur la discipline des sciences de l’information et sur la pratique des professionnels de l’information, ainsi que l’impact que ces professionnels peuvent avoir à leur tour sur la gestion des données. Le texte qui suit reprend ces trois éléments, s’appuyant sur une recension des écrits sur les données.

Nous nous intéressons principalement aux quatre types de données suivants : les mégadonnées (big data), les données de recherche, les données ouvertes et les données liées. Ces types de données peuvent facilement être confondus, alors qu’ils se distinguent selon un nombre de dimensions que nous présentons ci-dessous.

La démarche de description et de définition de ces divers types de données a son origine dans un constat que nous avons fait en voulant nous documenter sur la notion de la science des données : d’une part, nous avons relevé plusieurs confusions dans la perception de ce qui relève (ou non) de la science des données ; d’autre part, nous avons constaté que le rôle potentiel des professionnels de l’information pouvait être interprété différemment selon le contexte relatif aux données. Nous avons donc voulu éclaircir le sujet, ce qui a mené à une recension extensive des écrits relatifs aux données et qui s’inscrivent dans le champ des sciences de l’information.

La présente mise au point nous apparaît primordiale aujourd’hui : en effet, la prévalence du terme « données » dans les nombreux écrits récents (soulevée entre autres par Frederick 2016a) peut donner l’impression que ces données représentent une entité monolithique. Dans les faits, les différents types de données possèdent des caractéristiques différentes, bien que certains aspects soient partagés partiellement. Les articles qui leur sont consacrés ne précisent pas toujours suffisamment de quel type de données il s’agit. Or, sans une compréhension des différents types de données et des distinctions entre elles, le traitement qui leur est apporté peut être déficient. Également, les compétences que les professionnels de l’information doivent développer pour traiter chaque type de données de manière appropriée ne sont pas les mêmes ; ceux-ci doivent donc s’adapter en fonction du contexte et des objectifs. Voilà la motivation principale du présent article.

La section ci-dessous détaille les types de données visées. La section suivante, pragmatique, identifie les ressources appropriées pour chaque type de données. Enfin, la dernière section sera consacrée à l’étude des impacts pour les sciences de l’information et pour la pratique professionnelle. La conclusion fera un retour sur les expertises mobilisées et suggérera des actions à prendre pour les divers intervenants impliqués.

Différents types de données

Nous définissons ici les quatre types de données visés, en donnant quelques exemples de collections existantes. Une attention spéciale sera accordée au contexte canadien et québécois.

Chacun des types de données dont nous allons discuter a des caractéristiques particulières, qui sont définies dans la section « Définitions ». Des liens et des distinctions sont établis entre les types à la section « Premiers liens et contrastes entre les types ». Les enjeux soulevés par les différents types font l’objet de la section « Les enjeux », alors que la section « Retour sur les distinctions et mises en garde » fait un retour sur les distinctions entre les types pour motiver davantage la pertinence de la mise au point présentée dans cet article.

Définitions

Bien que certaines caractéristiques puissent être partagées par les différents types de données, il est plus utile ici de les présenter séparément.

Mégadonnées

Les mégadonnées (Gandomi & Haider 2015 ; Chen & Zhang 2014 ; Kim, Jeong & Kim 2014 ; Boyd & Crawford 2012) peuvent être définies comme suit : « Ensemble des données produites en temps réel et en continu, structurées ou non, et dont la croissance est exponentielle. » (Office de la langue française 2015b) On les dénote également par le terme de données massives ou big data. Typiquement, elles sont produites par des méthodes automatiques, plutôt que manuelles ; par exemple, elles peuvent être le produit d’appareils de captation de données (satellites, sondes, etc.) ou de logiciels[1]. Voici quelques exemples d’ensembles de données massives :

Données océanographiques captées par des sondes sous-marines.

Données polaires colligées de diverses sources.

Données astronomiques provenant d’observatoires ou de satellites.

Données géologiques issues d’analyses tectoniques, géomorphologiques, structurelles et sismiques.

Données économiques extraites de transactions financières ou commerciales.

Données météorologiques produites par les senseurs, capteurs, thermomètres, etc.

Données de réseaux complexes émanant des médias sociaux.

La nomenclature des « trois V » (Laney 2001) a été proposée pour caractériser les mégadonnées : volume, vitesse et variété. Le volume fait référence à la quantité de données ; la vitesse, au rythme d’ajout de nouvelles données ; la variété dénote l’éventail de sources et de types de données. Certains ajoutent d’autres « V » pour caractériser les mégadonnées : véracité (liée à l’incertitude des données) ou valeur (potentiel d’avantages liés à leur utilisation) (Marr 2014).

Les réseaux sociaux tels que Twitter peuvent être considérés comme une source de mégadonnées, alimentées en continu par les contributions de millions d’utilisateurs et composées de données de types variés (textes et images, notamment). Par le passé, des ensembles importants de données ont été constitués (par exemple, des données personnelles liées aux clients des institutions financières, des corpus linguistiques, des dossiers médicaux, des bases de données bibliographiques) sans en faire pour autant des mégadonnées. Ces ensembles ne satisfont pas aux critères de définition des mégadonnées, soit les trois V, en particulier la variété et la vitesse. Elles sont alimentées par des ajouts manuels et non automatiques, ce qui limite dans les faits le potentiel de croissance incontrôlée caractéristique des mégadonnées. Le propre des données massives, c’est le fait qu’elles croissent de manière importante, en continu. Cela soulève des problèmes quant à leur gestion (voir la section « Mégadonnées » sous la rubrique « Les ressources pertinentes ».).

Les applications des données massives comprennent typiquement la recherche scientifique fondamentale, l’administration publique et le développement de stratégies marketing ou économiques (Chen & Zhang 2014), et aussi l’évaluation du risque et les analyses prévisionnelles, par exemple en météorologie ou en séismologie. Une bonne partie des efforts de développement se réalisent en entreprise et non dans le monde académique (systèmes de recommandation pour les achats en ligne, évaluation des cotes de crédit). Un néologisme révélateur de l’importance que prennent les données à l’heure actuelle est « datafication » (ou « mise en données » [Office de la langue française 2014]), qui désigne la transformation de « plusieurs aspects de notre vie quotidienne[2] » en données.

Données de recherche

Les données de recherche (Erway et al. 2016 ; Strasser 2015 ; Ray 2014 ; Guindon 2013) font référence aux données générées à l’intérieur d’un projet de recherche, en milieu académique, gouvernemental ou industriel : par exemple, des observations sur le terrain, des réponses à des sondages ou questionnaires, des données créées par des processus de simulation par ordinateur, etc.

Certaines données sont faciles à répliquer, par exemple des phénomènes physiques courants (chutes de corps, jeux d’optique, etc.). D’autres demandent de l’équipement spécial ou une collecte sur une longue période. Ce sont pour ces dernières en particulier que la préservation et la diffusion seraient les plus profitables à la recherche subséquente (Heidorn 2011, 664). Il est reconnu que la présente ère est celle de la recherche axée sur les données (data-intensive research) (Hey, Tansley & Tolle 2009).

Un précurseur, l’ICPSR (Inter-university Consortium for Political and Social Research[3]) collige depuis 1962 des données provenant de projets de recherche en politique et en sciences sociales ; leur collection dépasse les 250 000 fichiers[4].

Parfois, les données de recherche sont des mégadonnées (Meyer & Schroeder 2014) comme celles colligées pour l’année polaire internationale (dont certaines sont disponibles sur le site de la NASA[5] et sur le site du Canadian Cryospheric Information Network[6]) et les données générées par le grand collisionneur de hadrons (LHC) du CERN[7], le plus puissant accélérateur de particules du monde. Cependant, elles peuvent aussi être des « petites données » (little data) (Borgman 2015) : des jeux de données individuels liés à un individu en particulier, ou de petits ensembles de données liés à des activités de recherche, des enquêtes, etc. On peut donc y retrouver des ensembles comme les suivants :

Données statistiques générées automatiquement par des appareils de mesure ou par ordinateur.

Ensembles de réponses courtes ou fixes à des questions.

Ensembles de textes (p.ex., réponses longues à des questions ou transcriptions verbatim d’entrevues).

Texte balisé comme des journaux de consultation de sites Web ou d’exécution de logiciels.

Contenu multimédia (p.ex., vidéos d’observations ou enregistrements d’entrevues).

Code informatique généré dynamiquement.

Les formes sont aussi variées que les méthodologies de recherche possibles pour chaque discipline. Un exemple digne de mention en informatique consiste en ReScience, un dépôt de codes sources disponible pour répliquer les expériences et ainsi mettre à l’épreuve les résultats annoncés par les chercheurs originaux (Rougier et al. 2017).

Les données de recherche sont souvent la base de publications comme des articles de revues ou des actes de congrès. Ainsi, elles sont naturellement accompagnées de texte correspondant (les articles publiés) ; elles sont d’ailleurs de plus en plus publiées avec ces mêmes articles (voir une discussion des problèmes relatifs aux liens entre données et publications dans [Mayernik, Phillips & Nienhouse 2016]).

Parmi les caractéristiques importantes des données de recherche, on note qu’elles sont liées à un chercheur, à un projet de recherche, à une méthodologie spécifique et souvent à des politiques institutionnelles ou gouvernementales. Par exemple, la Déclaration de principes sur la gestion des données numériques[8] des organismes subventionnaires CRSNG, CRSH et IRSC du Canada a été publiée en décembre 2016. Une politique « sur la gestion des données numériques s’appliquant à la recherche financée par l’entremise de conseils subventionnaires[9] » est également en cours d’élaboration. Aux États-Unis, la National Science Foundation exige depuis 2011 qu’un plan de gestion des données[10] soit inclus dans toute demande de subvention (Heidorn 2011, 665).

Les liens entre les données et le projet de recherche ont des conséquences importantes sur le traitement adéquat des données. Le lien à un chercheur entraîne des préoccupations liées à la propriété intellectuelle : le chercheur est en droit de se voir attribuer la « paternité » des données. Le projet de recherche duquel les données sont issues leur confère le contexte d’interprétation nécessaire à une bonne compréhension de leur nature et de leur portée ; il est donc primordial que les données soient accompagnées de documentation qui décrit le projet et la méthodologie de collecte ou de création des données. Également, le projet peut impliquer des sujets humains à propos desquels les données doivent être protégées. Enfin, les politiques de gestion des données peuvent par exemple dicter le mode de diffusion ou d’accès, la durée de conservation, etc.

Données ouvertes

Le terme « données ouvertes » (Dickner 2017 ; Comité OGGO 2014 ; Peugeot 2014 ; Janssen, Charalabidis & Zuiderwijk 2012 ; Mercier 2011) fait référence à des « [d]onnées qu’un organisme met à la disposition de tous sous forme de fichiers numériques afin de permettre leur réutilisation » (Commission d’enrichissement de la langue française [France], FranceTerme, 2014). C’est typiquement de l’information, surtout sous forme de statistiques, chiffriers ou autres formats tabulaires, qui provient d’un organisme public (mais parfois privé) et qui est rendue disponible publiquement sur le Web. De plus en plus, ces données ouvertes sont associées aux administrations publiques (comme les gouvernements municipaux, provinciaux ou fédéraux), notamment le gouvernement britannique[11], américain[12] (voir notamment [Holdren, Orszag & Prouty 2009]), canadien[13] et autres. Également, des organismes comme les Nations Unies publient de telles données[14].

La diffusion de données s’inscrit dans un mouvement de « gouvernement ouvert » :

[…] au début de 2009 paraît aux États-Unis ce que plusieurs considèrent comme un jalon dans le mouvement des données ouvertes : le mémorandum présidentiel sur la transparence et le gouvernement ouvert (Executive Office of the President, Holdren, Orzag & Prouty 2009). Ce document, publié peu après l’élection de Barack Obama, déclenche un important mouvement d’ouverture des données aux États-Unis et donnera une visibilité sans précédent au phénomène.

Dickner 2017, 14

Quelques exemples typiques de données ouvertes sont énumérés ci-dessous :

Budgets d’un gouvernement

États financiers d’une société sans but lucratif

Horaires de services municipaux

Infrastructures publiques comme les piscines, parcs et bibliothèques

Statistiques de fréquentation d’un événement

Données météorologiques nationales pour une année entière

Aux données ouvertes publiées par les administrations publiques s’ajoutent un nombre croissant de données provenant d’autres sources : celles d’entreprises privées et des organisations non gouvernementales comme le réseau de transport en commun de Longueuil[15] et le service de bicyclette en autopartage Bixi à Montréal[16], ou encore des compilations d’images (Google Earth) ou des contributions individuelles d’utilisateur sur le Web (sous la forme de liens dans les réseaux sociaux ou d’entrées dans Wikipédia par exemple). L’objectif invoqué pour ouvrir les données est souvent l’innovation : la possibilité pour différents acteurs de faire davantage avec des données existantes détenues par un organisme.

À strictement parler, les données sont « Ouvertes » (Open Data, avec majuscules initiales) quand elles sont non seulement disponibles librement, mais aussi en formats informatiques qui peuvent être traités aussi aisément par ordinateur que par les humains. Comme contre-exemple, un fichier comprimé (ZIP) qui contient un fichier PDF-image d’un document DOCX que l’on pourrait télécharger d’un site Web, même gratuitement, serait certes « ouvert », mais pas « Ouvert ».

Il est largement reconnu que pour la recherche financée sur fonds publics, les données issues de cette recherche devraient être diffusées librement. Elles représenteraient donc une forme de données ouvertes.

Données liées

Enfin, les données liées (Harth, Hose & Schenkel 2016 ; Bizer, Heath & Berners-Lee 2011) correspondent à une infrastructure technologique utilisée pour encoder des données à l’aide de normes spécifiques développées par le World Wide Web Consortium[17] (W3C). La définition affichée sur le site Web de la communauté des données liées est la suivante : « […] a term used to describe a recommended best practice for exposing, sharing, and connecting pieces of data, information, and knowledge on the Semantic Web using URIs and RDF[18]. »

Cette définition introduit donc les noms des normes spécifiques pertinentes (dont RDF et URI, définies à la section « Donnée liées » ci-dessous) et elle fait également référence à la notion de Web sémantique, intrinsèquement associée à la notion de données liées (et que nous abordons à la section « Web sémantique » de la rubrique « Concepts connexes » ci-dessous).

Les données liées peuvent représenter n’importe quel type d’information : des données bibliographiques à des listes de lieux géographiques en passant par des entités biomédicales :

Données catalographiques d’une bibliothèque

Données sur des artistes, leurs oeuvres et autres informations reliées

Grille horaire des programmes d’un télédiffuseur

Données relatives aux génomes d’espèces spécifiques

Sites touristiques et informations sur leur géolocalisation, leurs spécialités, etc.

Informations statistiques sur divers pays

Ontologies géopolitiques

Données et relations extraites des articles de Wikipédia

L’intérêt de construire un jeu de données liées, c’est lorsqu’elles entretiennent des liens avec d’autres données, ce qui permet d’étoffer les descriptions. Les données liées consistent en de larges jeux d’informations élémentaires (jeux de données ou datasets) sur des « entités » individuelles, entités qui peuvent être tout autant des objets du monde réel que des concepts abstraits ou des documents disponibles sur le Web. Par exemple, pour une entité « livre », les informations élémentaires utilisées dans les jeux de données bibliographiques comprennent le titre d’un ouvrage, son auteur, sa date de publication (en d’autres termes, toutes les métadonnées bibliographiques traditionnelles), chaque information encodée de manière individuelle et non rassemblée dans une fiche, contrairement à la tradition bibliothéconomique. Dans le cas d’informations géographiques, pour une entité « lieu » on pourra avoir le nom de ce lieu, sa latitude, sa longitude, le nom de la région dont il fait partie, le climat qu’on y retrouve, etc. Chaque pièce d’information représente une unité distincte dans le jeu de données. Ce morcellement des informations est une caractéristique importante des données liées.

Les données sont encodées à l’aide de triplets, dont les trois éléments sont les suivants : l’entité décrite (ou le « sujet »), une de ses propriétés (ou la « relation ») et la valeur de cette propriété (ou l’« objet »). Des exemples sont présentés au Tableau 1.

Tableau 1

Exemple de triplets sujet-relation-objet

Une caractéristique de la technologie utilisée pour les données liées permet de relier les entités entre elles, d’où le nom « données liées ». Par exemple, on pourra lier Molière à la France à partir des informations présentes dans le Tableau 1 (cela représente une information nouvelle, non représentée explicitement dans les données du tableau, mais que l’on peut inférer à partir de celui-ci). Plusieurs autres types de liens sont possibles, par exemple relier ce jeu de données sur Molière à un autre jeu de données sur les dramaturges ou sur le mythe d’Amphitryon ou encore sur les événements survenus en 1622.

Le but de l’entreprise est que les données liées soient Ouvertes aussi et donc l’idéal visé est les données Ouvertes liées (Linked Open Data).

Un exemple important de données liées est DBPedia[19] : il s’agit de l’encodage d’informations tirées de Wikipédia (par exemple, des informations sur les populations des villes, les dates et lieux de naissance d’individus et bien d’autres choses encore).

Premiers liens et contrastes entre les types

On pourrait faire le résumé caricatural suivant :

Les mégadonnées, c’est quand il y en a une grande quantité qui est augmentée en continu.

Les données ouvertes, c’est quand un gouvernement veut se donner bonne conscience.

Les données liées, c’est quand un groupe veut profiter des ressources disponibles sur le Web, afficher les siennes et se faire reconnaître comme une autorité en la matière ; ou encore, quand il veut apporter de la valeur ajoutée à ses propres données.

Les données de recherche, c’est là où les institutions exigent que le financement de la recherche soit bien administré et mieux géré.

Il devrait être clair à la lecture des sections précédentes que les différents types de données décrits possèdent des caractéristiques propres distinctes et soulèvent des problématiques différentes, ce qui sera étoffé dans la suite. Soulignons d’abord néanmoins les caractéristiques qui les unissent.

Sur le plan des traits partagés, notons d’abord que les données ne représentent pas des documents dans le sens traditionnel du terme[20]. Il est donc normal qu’elles soulèvent, en sciences de l’information, des questionnements nouveaux.

Le premier rapprochement qu’on peut faire aisément, c’est de regrouper les données de recherche et les mégadonnées d’une part, et les données ouvertes et les données liées d’autre part. En effet, il existe une intersection non nulle entre les mégadonnées et les données de recherche : certaines données de recherche sont également des mégadonnées. Cependant, le défi lié aux mégadonnées réside dans leur gestion en cours de traitement (Chen & Zhang 2014, 318) : la collecte et l’analyse (Gandomi & Haider 2015), la fouille (Kim, Jeong & Kim 2014), alors que pour les données de recherche il est davantage dans la planification de leur gestion (Digital Curation Centre 2013 ; Guindon 2013, 194), dans leur préservation et dans leur diffusion (Guindon 2013, 191), une fois la recherche terminée. Les données liées, étant pratiquement toujours ouvertes, peuvent être rapprochées des données ouvertes, bien que leur provenance diffère considérablement.

Selon une autre dimension, les données de recherche et les données ouvertes peuvent être rapprochées, en ce qu’elles sont naturellement regroupées en ensembles cohérents. Pour les données liées, bien que des jeux de données soient constitués, il y a à la fois un morcellement des données dans les triplets RDF et un éclatement des données à cause des liens établis entre les jeux. Les ensembles sont donc moins bien clairement définis. Dans le cas des mégadonnées, elles sont bien sûr regroupées en ensembles, mais la taille de ceux-ci défie en quelque sorte leur gestion. Pour ces raisons, il est souvent plus simple de décrire de manière cohérente et utile les données ouvertes et les données de recherche que les deux autres types.

Enfin, les données (ouvertes) liées sont plus spécifiques que les trois premières, puisqu’elles impliquent des technologies spécifiques ; toutefois, leurs propriétés d’ouverture et d’interrelations sont désirables pour tous les types. Les motivations pour l’ouverture sont différentes : pour les données de recherche, c’est la conduite plus efficace de la recherche qui est visée ; pour les données ouvertes (gouvernementales ou publiques), c’est la transparence d’une administration ou encore le potentiel d’innovation.

Cette présentation des différentes caractéristiques distinctes et partagées des types de données soulève la question des enjeux posés par la gestion de ces données, que nous abordons maintenant.

Les enjeux

Comme la nature des jeux de données ainsi que les modes de gestion et les objectifs diffèrent selon les types de données, il est naturel que les enjeux soient différents aussi. Les défis posés par les mégadonnées font l’objet d’un grand nombre de travaux récents dans différentes disciplines (par exemple [Hilbert 2016 ; Chen & Zhang 2014 ; Marx 2013 ; Tole 2013 ; Bizer et al. 2012 ; Labrinidis & Jagadish 2012]). Les enjeux posés par les données de recherche préoccupent particulièrement les chercheurs et les professionnels de l’information en milieu universitaire (Koltay 2017 ; Weller & Monroe-Gulick 2014 ; Guindon 2013 ; Borgman 2012 ; Swan & Brown 2008). Pour les données ouvertes, les communautés particulièrement impliquées dans l’étude des enjeux sont celles intéressées par le gouvernement ouvert et la participation citoyenne (Janssen, Charalabidis & Zuiderwijk 2012 ; Zuiderwijk et al. 2012) ou celle de la recherche où les impacts sociaux sont importants (Reichman, Jones & Schildhauer 2011). Enfin, les données liées soulèvent divers enjeux technologiques et sociologiques (Bizer, Heath & Berners-Lee 2011) et leur développement, bien qu’alimenté davantage par les informaticiens, est perçu de plus en plus désirable par des communautés d’utilisateurs différents, par exemple en éducation (Dietze et al. 2013) et pour les milieux documentaires (Gracy 2015 ; Bermès, Isaac & Poupeau 2013 ; Stuart 2011 ; Hannemann & Kett 2010) ; ce qui unit tous ces utilisateurs des données liées, c’est la plateforme du Web.

Cependant, certains enjeux sont partagés par tous les types de données. Nous en énumérons un certain nombre ci-dessous, déclinés selon les dimensions suivantes : enjeux pratiques, éthiques ou juridiques, technologiques, épistémologiques et enfin économiques.

Enjeux pratiques

Nous avons regroupé ici toutes les considérations pratiques relatives à la gestion des données, qui exigent une certaine planification ou qui demandent de tenir compte de certaines propriétés des données : le défi du volume important (ou non) des données, l’importance de l’effort de collecte, les exigences du partage et de l’accessibilité et les enjeux liés à l’évaluation de la qualité des données.

Volume : le volume des données représente un défi pour des raisons différentes selon les types de données. Bien que certains jeux de données ouvertes soient de taille modeste, les données de recherche peuvent être de très grands ensembles alors que les mégadonnées sont énormes par définition. Ce n’est pas tant le stockage de quantités énormes de données qui pose problème, mais bien les outils de traitement utilisés ; ceux qui sont disponibles ne réussissent pas toujours le passage « à l’échelle » pour des téraoctets de données. Cela est pourtant primordial si l’on veut extraire les informations pertinentes ou produire de la connaissance à partir des données. Enfin, les jeux de données liées croissent souvent de manière imprévue, étant donné la fragmentation des informations en triplets élémentaires, dont plusieurs sont nécessaires pour décrire une entité donnée. De plus, la taille sans cesse croissante du réseau Linked Data[21] complexifie l’établissement de relations entre les jeux de données.

Efforts de collecte : les différents types de données ne demandent pas le même type d’effort pour la collecte. Les données de recherche proviennent d’initiatives individuelles ou collectives, sujettes aux aléas de la recherche (disponibilité des subventions, activités de chercheurs individuels ou d’équipes à géométrie variable, etc.), qui sont aussi influencées par des facteurs contextuels variés. Par exemple, les données pour l’année polaire internationale seraient incomplètes : celles datant d’avant 1882 ne seraient pas disponibles, certaines ont été détruites lors des conflits mondiaux dans les années 1930 et 1940, et une bonne partie des données de 1957-1958 auraient été perdues (Brown 2009, 115). Pour les données liées, ancrées dans le Web, il n’existe aucune autorité centralisée pour assurer que la collecte soit homogène, complète, équilibrée, ni démocratique. La collecte ou la mise à disponibilité des données ouvertes, elle, est tributaire des organismes qui publient les données, qui obéissent à leurs propres motivations, selon leur calendrier soumis à différentes contraintes internes politiques, économiques, etc. Enfin, dans les cas où les mégadonnées sont générées de manière automatique, l’effort de collecte dépend de l’appareil utilisé ; peu important pour les clics des réseaux sociaux, il est extrêmement coûteux pour un appareil comme le collisionneur du CERN.

Partage et accessibilité : en règle générale, tous les types de données sont vouées à être accessibles, diffusées, partagées. Par contre, pour les données de recherche, l’objectif de partage peut aller à l’encontre, jusqu’à un certain point, des intérêts des chercheurs, qui pourraient par exemple vouloir être assurés de pouvoir publier leurs résultats avant que leurs données ne soient réutilisées par d’autres (Borgman 2012) ; du coup, comme ce sont les publications (articles ou communications) qui sont davantage valorisées, les chercheurs ont peu de motivation pour préparer leurs données afin de les partager (Guindon 2013, 191).

Qualité des données : la qualité des données est un enjeu primordial pour tous les types étudiés ici. La problématique a été étudiée plus en détail pour les données de recherche (voir notamment National Academy of Sciences, National Academy of Engineering & Institute of Medicine 2009). Des jeux de données ouvertes sont ajoutés sans nécessairement qu’il y ait une autorité pour valider leur intégrité et pour les mettre à jour lorsque nécessaire. Cela entraîne des exigences quant au nettoyage des données : la préparation des données pour la diffusion peut révéler des erreurs, des incohérences, des duplicata, etc., problèmes qui doivent être corrigés avant la publication (van Hooland & Verborgh 2014).

L’évaluation de la qualité doit tenir compte du processus de production des jeux de données et d’éventuelles transformations qu’elles auraient pu subir (anonymisation, compilations statistiques, etc.) qui auraient pu altérer les données, ce qui peut être impossible à déterminer par les responsables de la publication. Comme solution à ce problème, la documentation disponible devrait pouvoir fournir les informations nécessaires pour rétablir, au besoin, l’information correcte.

Dans tous les cas, la prolifération des données est à redouter. Pour les données de recherche, même des données liées à des résultats négatifs, qui ne seront vraisemblablement pas publiés, feront l’objet d’une gestion dans un plan de gestion des données. Cela représente une mutation importante dans l’organisation des données (Heidorn 2011, 665). En fin de compte, la disponibilité des données n’assure en rien leur qualité ni l’utilité pour un utilisateur donné. Cependant, des données de mauvaise qualité minent de manière importante la confiance que pourraient avoir les utilisateurs envers les jeux de données et les organismes qui les produisent.

Enjeux éthiques et juridiques

Les données à gérer sont peut-être confidentielles ou la propriété d’ayants droit à considérer.

Confidentialité : certaines données issues de la recherche, surtout en sciences sociales (Parry & Mauthner 2004), sont liées à des individus particuliers (comportements personnels, lieu de résidence, etc). Il n’est pas souhaitable que ces individus puissent être identifiés à partir des données récoltées. Différentes solutions sont utilisées pour préserver la confidentialité des personnes et des organismes visés, dont l’anonymisation et l’agrégation des informations.

Propriété intellectuelle : le respect de la propriété intellectuelle est une problématique partagée par toutes les données amenées à être ouvertes ou partagées. Des moyens doivent être mis en place par les diffuseurs pour respecter ces droits (Carroll 2015 ; Maurel 2012 ; McGeever 2007).

L’ouverture des données exige également un comportement éthique de la part de l’utilisateur : « Just because it is accessible does not make it ethical. » (Boyd & Crawford 2012, 671)

Enjeux technologiques

Les données sont des objets numériques, soumis aux contraintes de gestion informatiques : soucis de préservation à long terme, garantie de sécurité, choix d’outils de traitement automatique combinés à des approches manuelles.

Pérennité ou préservation : l’information numérique est encodée sur des médias instables, lisibles par des logiciels particuliers développés pour des plateformes informatiques particulières. Sans une attention portée au mode de stockage et aux méthodes de préservation à long terme, les données peuvent devenir illisibles dans un horizon temporel relativement court (c’est tout le problème de la préservation de l’information numérique) (Bachimont 2017 ; Corrado & Moulaison Sandy 2017). Pour les données de recherche en particulier, l’IWGDD a identifié les problèmes inhérents à l’accès et à la préservation des données numériques de la recherche (Interagency Working Group on Digital Data 2009). Dans le cas des données ouvertes, une situation particulière se présente. D’un côté, ce sont des données produites par une organisation que celle-ci voudra protéger. D’un autre côté, comme elles sont diffusées souvent pour des raisons politiques liées à la transparence ou pour témoigner du dynamisme d’une administration, leur durée de vie utile peut être jugée limitée par les décideurs. Leur valeur est davantage dans l’immédiat que dans la durée. Elles seront conservées à long terme, sans doute, mais dans une base de données dédiée, dans un format qui peut être différent de celui diffusé aujourd’hui. Ainsi, les opérations liées à la préservation de ces données ne seront pas nécessairement appliquées aux jeux repérables en ligne.

Sécurité des données : à cause des enjeux éthiques et juridiques, il est essentiel que les données soient conservées de manière sécuritaire, à l’abri d’utilisateurs mal intentionnés. On pense également aussi, ici, à l’intégrité des données : avec des quantités impossibles à inspecter de manière exhaustive, comment s’assurer qu’il n’y a pas de corruption dans les données ? Il y a un lien à faire ici avec la question de la qualité des données.

Traitement : pour être utiles (et utilisées), les données doivent être décrites, organisées, analysées, stockées de manière appropriée. Les défis se présentent de manière différente pour les mégadonnées (défi de mise à l’échelle des techniques, pour traiter de très grandes quantités de données), pour les données de recherche (défis liés à la documentation pour la diffusion et le partage subséquent) ou pour les données liées (qui reposent souvent sur la transformation dans un nouveau format de données existantes). Dans le cas des données ouvertes, c’est la publication (plutôt que le stockage) qui représente le traitement crucial.

Une question connexe est celle du type de traitement, humain vs automatique, approprié pour les données : si certains traitements exigent une intervention humaine (par exemple documenter un jeu de données), d’autres sont plus aisément faits par des logiciels de traitement automatique, notamment les traitements d’analyse sur les mégadonnées afin d’en extraire de la connaissance (traitement automatique de la langue, apprentissage automatique, fouille de données ou de documents, extraction de métadonnées). Ces derniers risquent cependant d’introduire des avaries dans les données (voir un exemple bien décrit dans Nunberg 2008), ce qui peut remettre en question leur qualité.

Enjeux épistémologiques

La prévalence des données dans toutes les sphères professionnelles et personnelles aujourd’hui soulève bien des questions sur leur statut ontologique (voir notamment Borgman 2015, 17-30). Si on peut reconnaître que, dans le cas des données ouvertes ou des données de recherche, la nature des données n’est pas différente de ce qu’elle a pu être dans le passé, dans le cas des mégadonnées la situation est différente. En particulier, celles-ci amènent des modifications importantes dans la façon de mener la science (Boyd & Crawford 2012 ; Hey, Tansley & Tolle 2009) et dans la définition même de la connaissance (Boyd & Crawford 2012, 665). Les observations encodées dans les données revêtent un caractère objectif et une précision qui occultent en réalité la subjectivité et l’imprécision inhérentes à la sélection et à la préparation des données (Boyd & Crawford 2012, 666-68). Tout cela réactualise la discussion sur la distinction entre les données, l’information et la connaissance (Rowley 2007 ; Zins 2007).

D’autres questions épistémologiques soulevées dans ce dossier des mégadonnées portent sur l’impact de la taille des jeux de données sur la conduite de la recherche (Leonelli 2014 ; Boyd & Crawford 2012, 668), avec l’illusion que les grands volumes de données impliquent que celles-ci soient complètes ; sur l’avantage conféré aux institutions et organismes de grande taille (en moyens matériels et humains) pour le traitement des mégadonnées et pour la direction qu’elles pourront ainsi donner au développement de la science et au déploiement de la technologie (Boyd & Crawford 2012, 674) ; ou encore sur les nouvelles formes d’empirisme centrées uniquement sur les données (« la fin des théories ») (Frické 2015 ; Kitchin 2014b ; Anderson 2008), ce qui peut être sévèrement critiqué : « […] data-driven science, the “fourth paradigm,” is a chimera. Science needs problems, thoughts, theories, and designed experiments. If anything, science needs more theories and less data. » (Frické 2015, 661) En sciences de l’information, l’impact potentiel des mégadonnées sur l’organisation des connaissances a été évoqué par Ibekwe-Sanjuan & Bowker (2017).

Les enjeux épistémologiques des données de recherche gravitent autour des questions du partage et de la réutilisation des données (Irwin 2013 ; Mauthner & Parry 2013), questions aussi pertinentes pour les données ouvertes.

Enfin, les aspects épistémologiques du Web sémantique et de ses données liées ont été moins étudiés jusqu’à présent ; ils sont abordés dans d’Aquin et Motta (2016), qui relèvent notamment le fait que de tout encoder de la même manière en RDF suggère une homogénéité dans les données qui n’existe tout simplement pas.

Somehow, there is one aspect of scalability which is much harder to address by means of purely technical means. In d’Aquin et al. [2014a] we called it diversity : the fact that data and knowledge not only come in different formats and subscribe to different modeling principles, but also that they originate from different sources, might be of different scope and quality, and might be distributed under different constraints, with different regulations applying to them, etc.

d’Aquin & Motta 2016, 53

Ajoutons également deux réflexions : d’abord, le fait que les URI (identifiants d’entités) sont utilisés non seulement pour décrire les objets (ce qui tombe sous le sens), mais aussi pour représenter les relations ; or, le statut d’entité rattaché à la notion de relation est pour le moins surprenant (Da Sylva 2017). Ensuite, notons que les représentations sont basées sur une vision simpliste de la sémantique (dont la démonstration dépasse la portée de cet article, mais voir Almeida, Souza & Fonseca 2011).

L’interprétation de la valeur des données doit tenir compte de leur contexte (Boyd & Crawford 2012, 670-71). Pour les professionnels de l’information (en particulier les archivistes), cela va de soi. Les données ne sont, finalement, que la représentation d’une réalité dont les paramètres sont déterminés par le fournisseur du jeu de données.

Enjeux économiques

Les bénéfices économiques de l’information, et plus particulièrement des données ouvertes (Dickner 2017, 30-31), s’ajoutent à leurs avantages politiques (associés à la transparence et à la bonne gestion).

En termes de coûts, la gestion des données de recherche soulève minimalement la question de la formation des intervenants impliqués. Pour les données de recherche, des coûts sont à prévoir à la fois pour les chercheurs, les centres de données et les bibliothèques (Brown 2009, 114).

On peut soutenir que les bibliothèques se doivent de participer au mouvement d’ouverture et de création de biens communs que représentent les données ouvertes (Peugeot 2014). Cependant, des dérives potentielles sont à surveiller (Mercier 2011).

En conclusion : les différents types de données décrites ici possèdent des caractéristiques différentes et soulèvent des enjeux qui, s’ils peuvent s’apparenter, prennent des formes distinctes selon le cas.

Retour sur les distinctions et mises en garde

Certaines publications apportent bien les distinctions nécessaires entre certains types de données : par exemple, données ouvertes vs mégadonnées, dans le contexte des archives (records management) (McDonald & Léveillé 2014) ; ou encore, données de recherche et mégadonnées (Federer 2016).

Par contre, la distinction et les parallèles qui peuvent être faits entre les types de données sèment parfois de la confusion dans les écrits. Une confusion fréquente consiste à amalgamer les données de recherche et les mégadonnées (par exemple Koltay 2014), et même les données ouvertes, liées et massives (Janssen & Kuk 2016). Plusieurs auteurs (par exemple [Klapwijk & IFLA Big Data Special Interest Group 2016 ; Zetterlund 2016]) utilisent le terme de « mégadonnées » pour de grands ensembles qui ne sont pas des mégadonnées ; cela démontre une incompréhension du phénomène qui se répercute sur l’évocation de techniques et outils inappropriés pour traiter les données de manière adéquate. En particulier : les algorithmes d’apprentissage automatique développés pour les mégadonnées n’offrent pas des performances optimales sur des ensembles qui sont de taille inférieure à celle des mégadonnées. Notons également la présentation faite par Pouyllau (2013) des données du Web, des données ouvertes et des mégadonnées : l’auteur propose de considérer aussi bien les données de la physique que celles de l’histoire parmi les mégadonnées, bien que la taille des ensembles ne soit pas comparable ; or, même les grands jeux de données de l’histoire ne répondent pas à la définition présentée ci-dessus pour les mégadonnées. Notons enfin que, bien que l’ouverture des données soit un thème récurrent dans la gestion des données, les enjeux ne sont pas les mêmes pour les données gouvernementales (publiques), pour les données de recherche (parfois hautement confidentielles et pas toujours publiques) ou pour les données liées (habituellement ouvertes, pratiquement par définition).

À notre connaissance, aucun article à ce jour n’a été consacré à la caractérisation et à la comparaison systématique des quatre types de données que nous présentons ici.

Nous reviendrons sur l’importance de bien clarifier le type de données dans un contexte donné lorsque nous aborderons, dans la section « La science des données », la question de la science des données.

Les ressources pertinentes

Les professionnels de l’information doivent être outillés pour traiter les différents types de données. Nous recensons dans les quatre prochaines sous-sections ci-dessous les ressources principales dans chaque cas. Une cinquième sous-section couvrira les ressources générales pertinentes pour tous les types de données, notamment les schémas de métadonnées, les licences encadrant l’utilisation et les occasions de formation pour les professionnels de l’information. Cette présentation sera forcément assez succincte, pour nous permettre de couvrir la base dans chaque cas.

Données ouvertes

Les données ouvertes sont habituellement regroupées en ensembles de données de diverses natures : des rapports financiers annuels, des procès-verbaux de réunions périodiques, des plans ou cartes géographiques situant les services gouvernementaux, des chiffriers contenant des données financières ou statistiques, etc. Chaque ensemble constitue un « jeu de données », soit une collection d’informations de même nature sur un sujet unique. Ainsi, le Calendrier de la cuisine de rue à Montréal pour une année donnée[22] représente un premier jeu de données, la Liste des lots, camions et types de cuisine[23] en est un deuxième, et le Taux d’occupation des sites de cuisine de rue pour l’été 2016[24], un troisième. Les sites Web de données ouvertes peuvent être caractérisés selon le nombre de jeux de données qu’ils contiennent (263 jeux dans le cas de la Ville de Montréal en date du 13 juillet 2017).

La notion du format des données est importante ici. Le troisième jeu de données présenté ci-dessus est contenu dans un fichier XLSX (format Excel de Microsoft) alors que les deux premiers sont disponibles en format JSON (JavaScript Object Notation). Certains sont « plus ouverts que d’autres ». L’organisme The Linux Information Project précise les caractéristiques suivantes pour les formats ouverts (The Linux Information Project 2017) : un format ouvert est un format de fichier pour stocker des données numériques, défini par une spécification publiée (habituellement maintenue par un organisme de normalisation) et qui peut être utilisé et mis en oeuvre par quiconque. Un format ouvert peut être mis en place par des logiciels propriétaires ou par des logiciels gratuits et libres, en utilisant les licences de logiciels typiques utilisées par chacun. Contrairement aux formats ouverts, les formats fermés sont considérés comme des secrets commerciaux. Les formats ouverts sont également appelés formats de fichiers libres s’ils ne sont pas assujettis à des droits d’auteur, des brevets, des marques déposées ou d’autres restrictions afin que quiconque puisse les utiliser sans frais pour un but souhaité.

Les formats ouverts rendent l’accès aux données et leur réutilisation plus faciles. Spécifiquement, les formats ouverts sont préconisés pour les données ouvertes (Obama 2013 ; Braunschweig et al. 2012 ; Open Government Working Group 2007). Berners-Lee a proposé un programme de déploiement en cinq étoiles[25] pour les données d’ouverture croissante : une étoile signifie que les données sont simplement disponibles (même en format image) avec une licence ouverte ; deux étoiles, qu’elles sont encodées dans un format de données structurées lisible facilement par ordinateur (par exemple, des données tabulaires en format Excel [XLS] plutôt qu’une image de la même table) ; pour mériter trois étoiles, des formats ouverts (comme CSV plutôt que XLS) doivent être utilisés ; les spécifications « quatre étoiles » et « cinq étoiles » sont réservées aux jeux de données qui exploitent les technologies des données liées, qui seront présentées à la section « Données liées ».

Ressources globales principales

L’Open Knowledge Foundation[26] et l’Open Data Network[27] sont des organismes internationaux impliqués dans la problématique des données ouvertes.

Pour qui veut s’informer davantage ou constituer des jeux de données ouvertes, les ressources de l’Open Data Handbook[28], le site Web de la Open Knowledge Foundation[29] et le portail d’Open Knowledge International[30] sont des ressources d’intérêt général. Un logiciel comme OpenRefine[31] permet de nettoyer et transformer des données avant de les rendre disponibles. Un autre, LODRefine[32], ajoute aux fonctionnalités de OpenRefine celles d’ajouter facilement des liens avec DBpedia, d’extraire des entités nommées (ou noms propres de divers types) et d’exporter les données en RDF.

Ressources canadiennes ou québécoises

Une bonne présentation de la situation des données ouvertes de l’administration publique au gouvernement du Québec et à la Ville de Montréal est donnée dans Dickner (2017) : format, qualité, couverture et licence des jeux de données disponibles ainsi que discussion des politiques et des pratiques.

Tableau 2

Données ouvertes d’administrations publiques au Canada

Données liées

Les données ouvertes liées reposent sur les technologies du Web sémantique (une extension du Web à l’aide de standards définis par le W3C ; voir la section « Web sémantique » de la rubrique « Concepts connexes ») : ces technologies sont principalement les identifiants URI et le modèle de données RDF. La notion d’identifiant n’est pas nouvelle : il s’agit d’un numéro ou d’une chaîne alphanumérique qui sert à identifier de manière unique une entité, comme un numéro d’assurance sociale (pour une personne), un ISBN (pour un livre) ou le numéro d’immatriculation d’un véhicule. Les identifiants URI (Uniform Resource Identifier[38]) sont des chaînes alphanumériques qui peuvent prendre plusieurs formes (selon différents schèmes[39]) ; le plus souvent, il s’agit d’une adresse URL (Uniform Resource Locator) qui est un lien permettant de localiser la ressource sur le Web. D’ailleurs, la ressource décrite par un URI est souvent une page Web ou un document, mais il peut s’agir aussi d’une entité du monde réel, extérieure au Web (une personne, un lieu, un événement, une date). En fait n’importe quelle entité peut être représentée par un URI, dont quelques exemples sont donnés au Tableau 3.

Tableau 3

Exemples d’URI

Certains URI empruntent à des schèmes d’identifiants préexistants (par exemple les numéros ISSN ou ISBN). De plus, alors que certains sont des chaînes ininterprétables générées aléatoirement ou séquentiellement, d’autres sont construits à l’aide de règles qui permettent d’interpréter leur contenu, et même de localiser la ressource sur le Web (on les dit alors « résolvables »). Les URI servent ainsi à identifier les entités ou les données. Celles-ci entretiennent des relations entre elles ; rappelons les exemples présentés ci-dessus, comme le fait que l’oeuvre « Amphitryon » soit le titre d’une pièce écrite par Molière. Dans les technologies des données liées, ce triplet est exprimé par une syntaxe particulière, RDF (Resource Description Framework [W3C 2004 ; Powers 2003]). Dans l’exemple suivant, encodé en XML, on voit une description RDF où la relation « a-écrit » (ou « auteur ») est exprimée par la relation creator puisée au schéma de métadonnées Dublin Core[40] (identifié par dcterms).

On y lit donc que l’entité http://viaf.org/viaf/181287382/ (« Amphitryon ») a été écrite (creator) par l’entité urn :isni : 0000000123197131 (Molière). Bien qu’intimidante au premier abord pour un non-initié, cette technologie ne représente finalement que des encodages de paires de valeurs reliées par une relation, comme Molière-a-écrit-Amphitryon, et qui peuvent par exemple exprimer l’équivalent des données des enregistrements d’un format comme le MARC.

Plusieurs autres technologies participent à l’entreprise des données liées (et du Web sémantique). Parmi celles-ci, on trouve les ontologies, qui revêtent une certaine importance pour les milieux documentaires. On peut définir les ontologies comme un ensemble structuré des termes et concepts qui décrivent un domaine, ou encore « une spécification formelle d’une conceptualisation partagée » (Gruber 1993). Par exemple, l’ontologie FOAF (Friend of a Friend[41]) décrit les propriétés générales des personnes et les liens que celles-ci peuvent entretenir ; elle peut être utile pour établir des liens entre des instances de personnes spécifiques. L’ontologie exprime les relations en général et permet de faire des inférences sur des cas particuliers. Le langage de définition d’ontologies, OWL (Web Ontology Language[42]), qui est une recommandation du W3C, est construit sur le modèle de données de RDF.

La notion d’URI ou d’identifiant unique peut être rapprochée de celle du contrôle d’autorité familier aux institutions documentaires. Une différence notable entre les deux, c’est qu’avec les URI, il n’y a pas d’ambition de proposer une forme canonique des étiquettes utilisées (les noms), ni d’en repérer toutes les variantes, mais simplement de définir un endroit précis où l’existence d’une entité est déclarée et à laquelle on peut rattacher les propriétés que l’on veut. Des duplicata peuvent d’ailleurs être créés par des fournisseurs différents de données liées ; par exemple, on recense différentes déclarations d’auteurs ou d’oeuvres dans différents jeux de données bibliographiques (ceux de la BnF et de la bibliothèque nationale d’Allemagne contiennent tous les deux des données sur l’oeuvre « Amphitryon » de Molière). Une relation définie dans le langage OWL, « sameAs », joue un rôle important dans l’association d’URI distincts qui réfèrent néanmoins à la même entité. Cette relation, on l’espère, devrait permettre d’établir les liens nécessaires, mais son usage polysémique pose en fait plusieurs problèmes (Halpin, Herman & Hayes 2010).

Les jeux de données liées sont emmagasinés dans des bases de données spéciales, appelées triplestores (ou entrepôts de triplets). Celles-ci sont essentiellement des implémentations spéciales de bases de données relationnelles. Un langage de requêtes spécialisé (SPARQL[43], semblable à SQL) permet de repérer des données dans ces entrepôts.

Ressources globales principales

Plusieurs jeux de données sont disponibles. Une présentation globale est offerte sur la page The Linking Open Data cloud diagram[44]. Le portail des données ouvertes de l’Union européenne[45] donne accès à des milliers de jeux de données. Parmi les jeux de données liées associées aux milieux documentaires, citons les informations bibliographiques de la Bibliothèque nationale de France[46], les données de WorldCat[47] de l’OCLC, le thésaurus AAT sur l’art et l’architecture du Getty Research Institute[48], le plan de classification IconClass pour les oeuvres d’art[49], ainsi que des notices d’autorité et divers vocabulaires de la Library of Congress[50] tels que son répertoire de vedettes-matière.

Divers « vocabulaires[51] » sont utilisés pour décrire les données liées : l’ensemble Dublin Core utilisé pour décrire des documents numériques ; l’ontologie FOAF mentionnée ci-dessus, qui sert à décrire des personnes (leur nom, leurs coordonnées, leur titre, etc.) et les liens entre elles (par exemple, le fait qu’une personne en connaît une autre) ; divers vocabulaires contrôlés de la Library of Congress, mentionnés ci-dessus. La page Linked Open Vocabularies[52] de la Open Knowledge Foundation présente une collection de ces vocabulaires.

Plus spécifiquement pour les bibliothèques, le regroupement Linked Data for Libraries[53] recense différentes ressources sur son site Web : des ontologies, des sources de données liées, du code, et d’autres ressources utiles pour les bibliothèques.

Pour apprivoiser la recherche par SPARQL dans son entrepôt de données RDF, le portail Persée[54] fournit l’interface Sparklis[55], plus conviviale que SPARQL. L’interface peut soutenir également l’apprentissage de ce langage, puisque chaque requête construite à l’aide de l’interface peut être ensuite visualisée en SPARQL natif.

BIBFRAME (Library of Congress 2016, 2012), un nouveau modèle de données pour la description bibliographique développé par la Bibliothèque du Congrès américain, vise à remplacer les formats MARC (MAchine Readable Cataloging) et à fournir un format compatible avec le Web de données : « […] l’arrivée de BIBFRAME 2.0 joue inévitablement un rôle important dans la mesure où elle permet d’envisager l’encodage des métadonnées de bibliothèque de manière à ce qu’elle soit [sic] déjà prêtes à la publication dans le Web sémantique. » (St-Germain 2017, 148) Exprimé en RDF, BIBFRAME reprend en partie l’approche à la description de ressources proposée par FRBR (IFLA Study Group on the Functional Requirements for Bibliographic Records 2009). BIBFRAME est basé sur trois catégories de base, soit « oeuvre » (qui correspond à peu près à la notion d’oeuvre de FRBR), « instance » (qui en fusionne les notions d’expression et de manifestation) et « item » (soit un exemplaire particulier). BIBFRAME y ajoute trois classes : agent (pour désigner les auteurs par exemple), sujet et événement, chacune se rapportant aux catégories de base. L’introduction de ce modèle de données est assez récente et il n’est pas encore très répandu ; il n’est d’ailleurs pas tout à fait au point, des dires mêmes de la Bibliothèque du Congrès :

BIBFRAME is far from an environment that you could move to yet. The model and its components are still in discussion and development—a work in progress. When it is more mature, vendors and suppliers will need time to adjust services to accommodate it. And then we can expect a mixed environment for some time.

Bibliographic Framework Transition Initiative, Library of Congress 2017, paragr. #q09

Il est donc trop tôt pour évaluer l’impact qu’il pourra avoir dans les milieux documentaires.

Ressources canadiennes ou québécoises

Le groupe Canadian Linked Data Initiative[56] regroupe les services des bibliothèques de cinq universités canadiennes, Bibliothèque et Archives Canada ainsi que Bibliothèque et Archives nationales du Québec. Son objectif est de planifier et de trouver un financement pour une série de projets qui coordonneront les activités de production de métadonnées de leurs unités de services techniques, en anglais et en français. Le groupe francophone de cette initiative se penche sur l’identification de ressources en français et vise potentiellement à augmenter le nombre de ces ressources.

Données de recherche

La ressource fondamentale nécessaire à la gestion des données de recherche est le plan de gestion des données (PGD), que l’on peut définir comme suit : « […] un plan formel qui décrit comment les données de recherche sont gérées au cours du cycle de vie d’un projet de recherche. Les plans portent sur des thèmes comme la collecte de données, les métadonnées, la documentation, l’échange de données et la préservation[57]. »

Les organismes subventionnaires de nombreux pays dont le Royaume-Uni[58] et le Canada sont en voie d’exiger des candidats de développer des plans de gestion des données, comme c’est déjà le cas aux États-Unis. Des outils en ligne soutiennent les chercheurs dans la rédaction de leur plan (voir des exemples ci-dessous). Perrier et al. (2017) offrent un panorama détaillé des écrits sur la gestion des données de recherche dans les institutions universitaires.

Ressources globales principales

Diverses ressources sont disponibles pour gérer et repérer les données de recherche, dont des dépôts disciplinaires ou multidisciplinaires, des moteurs de recherche fédérée d’ensembles de données dans plusieurs dépôts et des normes de citation[59]. Plus précisément :

-

Dépôts de données : certaines données sont entreposées par le chercheur lui-même, sur un poste de travail personnel par exemple. Cela peut être suffisant, selon l’ampleur du jeu de données, et à condition qu’une infrastructure adéquate soit disponible (suffisamment d’espace de stockage, bonnes descriptions et organisation des fichiers, copies de sauvegarde fréquentes, etc.). Il existe également des dépôts collectifs utiles aux chercheurs ne détenant pas l’expertise ou le temps pour maintenir un dépôt de données (Cragin et al. 2010) : dépôts institutionnels (au sein d’un centre de recherche ou d’une université), nationaux (par exemple le UK Data Archive[60] au Royaume-Uni regroupant les données en sciences humaines et sociales) ou encore disciplinaires (par exemple, DATAONE[61] pour les données environnementales).

Plusieurs plateformes sont disponibles pour gérer les données de recherche, chacune comportant des forces et des faiblesses (Amorim et al. 2015). Entre autres, Dataverse est une application Web de logiciel libre qui permet de partager, de préserver, de citer, d’explorer et d’analyser des données de recherche (Crosas 2011). Le projet est hébergé par l’Université Harvard et est développé par l’équipe Dataverse à l’Institute for Quantitative Social Science (IQSS). Des plateformes génériques développées au départ pour des bibliothèques numériques comportant davantage des documents textuels numériques, comme DSpace et Invenio, peuvent également gérer des données.

Identification : les jeux de données reçoivent un identifiant unique DOI (Digital Object Identifier), fourni par DataCite[62], qui est utilisé notamment pour citer cette ressource.

Documentation, guides, etc. : plusieurs documents sont disponibles auprès du Digital Curation Centre, au Royaume-Uni[63]. D’autres guides ont été publiés par l’organisme américain NISO (Strasser 2015) et par les académies nationales de recherche américaines (National Academy of Sciences, National Academy of Engineering & Institute of Medicine 2009).

Ressources canadiennes ou québécoises

Les organismes suivants oeuvrent à la gestion des données recherche :

Le réseau Portage de l’Association canadienne des bibliothèques de recherche[64] « rassemble le milieu des bibliothèques pour coordonner l’expertise, les services et la technologie dans le domaine de la gestion des données de recherche et, dans ce contexte, cherche à collaborer avec d’autres acteurs de ce domaine ». Il comprend plusieurs groupes d’experts[65] : sur la planification de la gestion des données, sur la préservation, sur la découverte des données, sur la formation en gestion des données de recherche, sur « la recherche et l’intelligence » (ou planification stratégique), et sur l’organisation des données ;

Research Data Canada (Données de recherche Canada) « veille à ce que les données scientifiques engendrent des innovations dont profitera chaque Canadien[66] ». Il s’agit d’une « organisation dirigée et appuyée par des intervenants déterminés à améliorer la gestion des données scientifiques au Canada[67] ». Les partenaires incluent plusieurs universités canadiennes, l’Association canadienne des bibliothèques de recherche, certains ministères et agences gouvernementaux, des fournisseurs d’infrastructure de recherche et de services (dont CANARIE et Calcul Canada, présentés à la section « Mégadonnées - Ressources canadiennes ou québécoises ») et plusieurs autres membres.

Le Réseau canadien des centres de données de recherche[68] (RCCDR) « permet aux chercheurs d’accéder à une multitude de microdonnées sociales, économiques et liées à la santé, qui sont recueillies et administrées par Statistique Canada ».

Le Sous-comité des bibliothèques du Bureau de coopération interuniversitaire (BCI) du Québec « a pour mandat spécifique de favoriser le développement concerté des collections et des services des bibliothèques universitaires québécoises, en appui à la mission d’enseignement et de recherche des établissements universitaires québécois[69] ». La Journée de réflexion sur la gestion des données de recherche[70] (organisée par le Sous-comité des bibliothèques du BCI) a réuni à Montréal le 21 novembre 2016 une centaine de participants, provenant des quatre coins du pays afin d’aborder spécifiquement les défis de la gestion des données de recherche au Québec et au Canada.

Mis de l’avant par Portage, l’Assistant PGD[71] (ou DMP Assistant) est un outil bilingue d’aide à la préparation d’un plan de gestion des données (PGD). Le canevas de base (template) incorporé dans l’Assistant amène les chercheurs à définir les aspects suivants du PGD :

Collecte de données

Documentation et métadonnées

Stockage et sauvegarde

Conservation

Partage et réutilisation

Responsabilités et ressources

Conformité aux lois et à l’éthique

Une plateforme pour la gestion des données a été développée par les bibliothèques universitaires de l’Ontario. Le portail Scholars (Scholars Portal développé par l’Ontario Council of University Libraries [OCUL]) fournit une infrastructure technologique partagée et des collections partagées pour les 21 bibliothèques universitaires de la province. Il a été certifié comme un dépôt numérique fiable (Trustworthy Digital Repository[72]). C’est un ensemble de services, contenant des publications aussi bien que des données. Il incorpore une base de données en sciences sociales (odesi pour Ontario Data Documentation, Extraction Service and Infrastructure) ainsi qu’une implémentation de Dataverse[73]. Il a été conçu principalement pour les données de recherche recueillies par des chercheurs et des organisations affiliées aux universités de l’Ontario, bien que n’importe qui dans le monde soit invité à utiliser le portail Scholars Dataverse pour déposer, partager et archiver des données[74]. Le Sous-comité des bibliothèques du BCI, au Québec, tente d’amorcer des travaux visant la mise sur pied d’une plateforme analogue pour le Québec, mais les travaux sont toujours en cours.

Une plateforme nationale fédérant les dépôts de données de recherche canadiens[75] est en cours de préparation ; son lancement est prévu pour janvier 2018 et une version bêta est disponible[76]. Une recherche effectuée avec un terme donné permet d’y repérer des jeux de données provenant de différents dépôts. Par exemple, avec le terme « polar bear » on peut repérer des jeux de données provenant du réseau Polar Data Network, du UBC Circle et du ministère des Ressources naturelles du Canada.

Mégadonnées

La manipulation de très grands ensembles de données requiert un équipement informatique important et de très grandes capacités de calcul. Les outils et technologies pour traiter les mégadonnées peuvent être regroupés dans les quatre groupes suivants (Chen & Zhang 2014, 321-31) : techniques « directes », techniques appliquées en lots, techniques appliquées en continu et techniques interactives. Le premier groupe représente en fait les techniques de base appliquées aux données : optimisation (relevant de la recherche opérationnelle), statistiques avancées, fouille de données (éventuellement fouille de texte), apprentissage automatique, techniques de visualisation et analyses de réseaux sociaux (ancrées dans la théorie des réseaux et des graphes). Dans le deuxième groupe de techniques de traitement, on trouve des logiciels et plateformes spécifiques (comme Hadoop, Dryad ou Pentaho) qui sont particulièrement robustes et sont optimisés pour fonctionner sur de très grands ensembles. Le troisième groupe d’outils et de technologies sont ceux conçus pour appliquer des traitements continus, en temps réel et de manière incrémentale. Enfin, les technologies interactives permettent aux utilisateurs d’ajouter leur propre analyse en interagissant avec le système. Des principes fondamentaux pour soutenir la conception d’outils de traitement sont énoncés dans Chen & Zhang (2014, 331-32).

Ressources globales principales

Les ressources principales pour les mégadonnées sont plus intéressantes pour les informaticiens et les mathématiciens appelés à appliquer des traitements sur les données (présentées brièvement ci-dessus). Certaines bibliothèques universitaires, en particulier celles associées à des chercheurs en sciences axées sur des mégadonnées, pourront toutefois être amenées à appliquer leur expertise en termes de description et d’organisation des données (voir alors la section sur les données de recherche). Graduellement, des bibliothèques reconnaissent que les bénéfices de traiter de grandes quantités de données peuvent s’appliquer à la gestion des bibliothèques elles-mêmes : ainsi, à partir par exemple de statistiques de fréquentation ou de prêt, des connaissances pourraient être extraites pour améliorer les services offerts (Klapwijk & IFLA Big Data Special Interest Group 2016 ; Zetterlund 2016). Bien que ces données ne répondent pas à la définition des mégadonnées données ci-dessus, nous mentionnons ces initiatives ici.

Ressources canadiennes ou québécoises

Les organismes suivants sont actifs au Canada et au Québec en particulier : Institute for Big Data Analytics[77] à l’Université Dalhousie et IVADO (Institut de valorisation des données, pôle scientifique et économique[78]), associé à l’Université de Montréal, à l’École Polytechnique de Montréal et HEC Montréal. Notons également, le Leadership Council for Digital Infrastructure ou Conseil du leadership sur l’infrastructure de recherche numérique[79], qui « regroupe plusieurs organisations et institutions qui veillent à ce que les chercheurs du Canada aient un accès à des technologies numériques de pointe et à des compétences reconnues dont ils ont besoin pour réaliser des projets qui comportent des calculs complexes et un imposant volume de données[80] ».

Par ailleurs, les chercheurs canadiens peuvent compter sur CANARIE[81], organisme à but non lucratif responsable d’un réseau de télécommunications à haut débit qui fédère les réseaux scientifiques provinciaux et ainsi les universités, instituts de recherche, laboratoires publics et écoles au pays. Enfin, Calcul Canada[82] est responsable de la plateforme nationale de calcul à haute performance employée pour la recherche au pays. Elle permet aux chercheurs canadiens d’effectuer des travaux de recherche de calibre mondial à l’aide de stratégies de calcul informatique de pointe.

Ressources générales pour tous les types de données

Nous avons reporté jusqu’ici la description de trois types de ressources qui sont utiles pour tous les types de données et qui s’ajoutent aux ressources énumérées dans les sections qui précèdent. Il s’agit des métadonnées, des licences encadrant l’utilisation des données (ouvertes ou partagées) et des occasions de formation (webinaires, ateliers, vidéos, etc.).

Les métadonnées et les schémas de métadonnées

Les métadonnées (Riley 2017) consistent en des ensembles de données structurées dont l’objectif est de décrire un document ou un jeu de données. Elles correspondent essentiellement aux informations de description (ou de catalogage) familières aux bibliothécaires et aux archivistes (il y a donc plusieurs parallèles à faire avec les vocabulaires contrôlés).

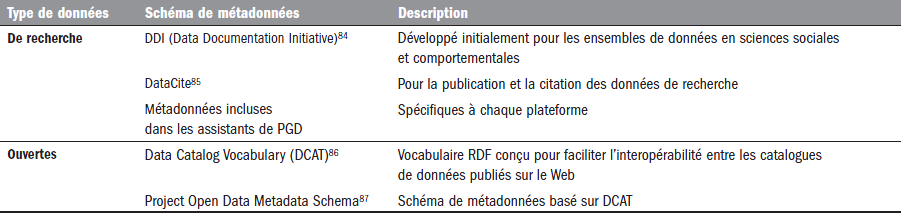

À côté de schémas de métadonnées généraux comme celui du Dublin Core ou de MODS[83], tous deux particulièrement utiles pour décrire des documents, certains schémas de métadonnées spécialisées ont été créés spécifiquement pour les données de recherche et les données ouvertes (voir le Tableau 4).

Tableau 4

Schémas de métadonnées pour les données de recherche et les données ouvertes

Des métadonnées seraient utiles pour les mégadonnées, mais elles ne sont pas toujours disponibles (Rousidis et al. 2014). Dans le cas des données liées, la question des métadonnées sera abordée à la section « Les métadonnées : une réflexion ciblée ».

Les licences encadrant l’utilisation

Les données ouvertes ou disponibles peuvent être protégées par des formes de licences encadrant la propriété intellectuelle, sans pour autant empêcher leur (ré)utilisation, ce qui est particulièrement important pour les données de recherche. Les plus importantes sont les suivantes :

Licences CreativeCommons[88] (CC) : le groupe CC, une association à but non lucratif, a développé une solution juridique alternative pour les auteurs d’oeuvres, afin de libérer ces oeuvres des droits de propriété intellectuelle standard. Plusieurs licences sont incluses dans l’offre de CC, selon quatre critères : mention de l’auteur original (« attribution »), usage commercial interdit (« non commercial »), modification de l’oeuvre interdite (« no derivative works ») et transmission obligatoire de la licence originale dans toute réutilisation (« share alike »). Les licences sont définies sur le Web et leur adresse URL peut être incluse aisément dans du code HTML ou RDF et donc associée sans difficulté à des jeux de données.

Open Data Commons[89]Attribution Licence[90] : cette ressource regroupe trois licences ayant le caractère des licences Creative Commons, mais conçues spécifiquement pour les données et les bases de données.

Pour exprimer les licences et les associer aux données, divers mécanismes sont disponibles (Ball 2014, 12-15), dont l’utilisation d’un langage d’expression des droits (Rights Expression Language) comme les suivants :

Langage ODRL (Open Digital Rights Language[91]) : fruit d’un effort international visant à développer et promouvoir un standard ouvert pour l’expression de politiques relatives à la publication, à la distribution et à la consommation de contenu, applications et services.

Langage MPEG-21 REL (International Organization for Standardization 2004)

METSRights schema[92] de la Library of Congress.

Un guide utile portant sur les licences pour les données de recherche est publié par le Digital Curation Centre au Royaume-Uni (Ball 2014).

Les formations disponibles

Pour la formation initiale, dans l’information disponible en ligne sur les programmes de maîtrise en sciences de l’information au Canada, nous avons recensé quelques exemples de cours liés à la gestion des données : Indexation de collections numériques[93] (U. de Montréal) ; Data Mining (McGill) ; Data Management et Introduction to Data Science, Business Analytics and Data Visualization (Dalhousie) ; Data Analytics : Introduction, Methods and Practical Approaches et Data Librarianship (Toronto) ; Information Visualization and Visual Analytics et Research Data Management for Information Professionals (UBC). Il y a aussi des cours sur des thématiques reliées : Fouille de documents (U. de Montréal) ; Digital Curation et Digital Libraries (McGill) ; Data Modeling and Database Design et Digital Preservation and Curation (Toronto) ; Digital Libraries (Western) ; Text Analytics (UBC).

Sur le plan de la formation continue, un grand nombre d’occasions sont offertes aux professionnels de l’information pour se former sur l’une ou l’autre des thématiques abordées dans cet article. D’abord, les associations professionnelles offrent des webinaires sur ces thématiques : la Corporation des bibliothécaires professionnels du Québec (dont « Web sémantique et bibliothèques numériques ») ; Données de recherche Canada[94] ; ASIS&T[95] ; l’ASTED (dont « Quand les sciences de l’information se mettent au service de la recherche »). Ensuite, des ateliers sont organisés par l’Association des bibliothèques de recherche du Canada sur les données de recherche[96]. Enfin, voici quelques exemples de vidéos en ligne :

La vidéo « Introduction à la gestion des données de recherche » sur le site du service des bibliothèques de l’Université de Montréal[102] fournit une initiation utile à la problématique ; des initiatives semblables se retrouvent dans les bibliothèques d’autres universités de recherche au Canada.

Une recherche sur le Web utilisant les mots-clés « formation », « webinaire » ou « atelier », combinés aux concepts clés identifiés dans cet article, révélera d’autres occasions de formation imminentes.

Cette section a présenté les ressources de base utiles pour gérer les différents types de données. L’exercice visait à fournir un point de départ pour explorer les problématiques et s’outiller selon le cas.

Impact des données sur les professionnels de l’information ou vice versa

La prolifération des données a un impact sur plusieurs groupes : les citoyens de manière générale, les chercheurs, les gouvernements, les sociétés privées ; cet impact se fait ressentir de manière particulière à chaque groupe. Ce qui nous préoccupe particulièrement ici, c’est l’incidence sur les professionnels de l’information. Nous examinons la question pour chaque type de données, relevant en particulier les différents intervenants et leurs tâches respectives, ainsi que les connaissances et compétences des professionnels de l’information mobilisées pour la gestion des données. Enfin, nous abordons des concepts qui sont connexes à notre propos et qui seront examinés à la lumière de la présentation que nous avons faite des données.

Données de recherche

Les organismes subventionnaires en sont venus à reconnaître l’importance de préserver les données issues de la recherche pour permettre leur réutilisation, rendant ainsi plus performantes les différentes initiatives de recherche subventionnée. Pour ce faire, la description et l’indexation de ce type de données sont cruciales, car elles sont bénéfiques pour les chercheurs, pour les gestionnaires des systèmes et pour les organismes subventionnaires. Les bibliothèques (en particulier les bibliothèques universitaires) se sont trouvées à être les institutions tout indiquées pour préserver et diffuser les données. Cela s’inscrit dans leur mission d’acquisition et de diffusion de l’information pour répondre aux besoins de ces institutions d’enseignement et de recherche (Heidorn 2011, 663). Les bibliothèques et les centres d’archives « sont des institutions reconnues pour le rôle dans la préservation et le partage des connaissances » (Guindon 2013, 191).

Les professionnels de l’information seront graduellement appelés à soutenir les chercheurs, non seulement dans le stockage de leurs propres données, mais aussi dans la réutilisation de données provenant d’ailleurs (Lucic & Blake 2016).