Abstracts

Résumé

L’immersion a toujours été un programme central, tant dans la recherche et le développement des images techniques que dans la consommation. Comme l’indiquent certains développements technologiques et biotechnologiques récents (les masques, les lunettes et les interfaces faciales, les verres de contact et les interfaces cornéennes, les implants oculaires et les interfaces cristallines ou rétiniennes, les implants cérébraux et les interfaces neuronales), l’horizon de ce programme pourrait bien être la disparition de l’écran et l’incorporation de l’interface – ce que nous pourrions appeler une sorte de cinéma neuronal. Il pourrait nous obliger à mettre en question les notions mêmes de média, de médiation et d’image. Mais il convient en retour d’interroger l’utopie biotechnologique qui le sous-tend.

Abstract

Immersion has always been a central program, in both the research and development of technical images and their consumption. As seen in various recent technological and biotechnological developments (masks, eyeglasses and facial interfaces, contact lenses and cornea interfaces, ocular implants and crystalline or retinal interfaces, cerebral implants and neuronal interfaces), the horizon of this program could well be the disappearance of the screen and incorporation of the interface, or what we might call a kind of neuronal cinema. It may oblige us to call into question the very concepts media, mediation and image. At the same time, we should interrogate the biotechnological utopia underlying it.

Article body

Cinéma. Il faut résister à l’attraction de ce nom commun, et s’efforcer de penser au-delà ou en deçà du concept de média et des modèles territoriaux et narratifs qu’il ne manque jamais de reconduire (selon lesquels un média serait une sorte de territoire avec des frontières plus ou moins poreuses ayant une histoire relativement linéaire et autonome). Le cinéma a toujours été éclaté : il constitue en effet une sorte de réseau qui met en relation des éléments hétérogènes – des agents, des matériaux, des formes, des appareils, des dispositifs, des lieux, des procédés, des protocoles, des inscriptions, des référents, des traductions – suivant des chaînes de coopération réglées par des conventions, dont la stabilité comme l’extension sont très variables, et qui n’excluent pas les asymétries et les hiérarchies. Dans ce contexte, le cinéma a une autonomie bien relative. Il n’est qu’une partie d’un vaste réseau sociotechnique, qui communique lui-même avec d’autres réseaux et avec l’ensemble du réseau social. Il n’existe donc pas de distinction ferme entre les modes de production et de consommation des différentes images techniques.

Le développement des réseaux sociotechniques est un processus complexe, qui met en jeu de multiples contraintes, notamment technologiques, économiques et esthétiques[1]. Il est soumis aux possibilités et aux limites de la technologie, mais aussi aux désirs des producteurs et des consommateurs, aux lois de l’offre et de la demande, comme au jeu de la compétition. Évidemment, l’offre et la demande sont intimement liées, l’une et l’autre s’informant incessamment. Mais les désirs à l’égard des images techniques sont variés et parfois incompatibles : la communication, la portabilité, l’interactivité, etc., ne sont pas toujours conciliables. Or l’immersion a toujours été un programme central dans la recherche et le développement cinématographiques, puisqu’elle est également souhaitée par les consommateurs[2]. Et comme l’indiquent certains développements technologiques et biotechnologiques récents, que nous examinerons ici, l’horizon de ce programme pourrait bien être la disparition de l’écran et l’incorporation de l’interface – ce que nous pourrions appeler, pour rester dans le cadre de ce dossier, une sorte de cinéma neuronal[3], lequel pourrait nous obliger à interroger les notions mêmes de média, de médiation et d’image en tant que surface limitée par un cadre.

Le programme immersif

Définie rapidement, l’immersion est une expérience qui donne la sensation d’entrer physiquement dans un espace autre, différent de celui où nous nous trouvons (Grau 2003 ; Griffiths 2008). Mais le terme, très général, couvre en fait une variété d’expériences. Dans son étude sur les rapports entre la littérature et la réalité virtuelle, Marie-Laure Ryan (2001) distingue déjà trois types d’immersion – spatiale, temporelle et affective. Gordon Calleja (2011), qui s’intéresse aux jeux vidéo, identifie quant à lui six dimensions de ce qu’il préfère appeler « l’engagement », lequel peut être spatial, narratif, affectif, kinesthésique, ludique et partagé. La condition première de l’immersion est évidemment spatiale, mais peu d’auteurs s’y sont spécifiquement intéressés. Dans le cadre de son étude sur la fiction, Jean-Marie Schaeffer (1999) procédait déjà à une typologie des « dispositifs fictionnels » selon les « postures d’immersion » qu’ils assignent au récepteur, ce qui lui permettait de distinguer l’immersion théâtrale du point de vue du spectateur de celle expérimentée par l’acteur, de même que l’immersion des enfants dans leurs jeux de rôles, en fonction de la position qu’ils assignent au récepteur par rapport à l’univers fictionnel – de simple observateur extérieur à l’acteur intérieur à la scène. C’est toutefois Paul Milgram (1994), dans son étude du « reality-virtuality continuum », qui propose le modèle le plus prometteur pour penser l’immersion spatiale : il y fait une typologie des écrans (displays) selon plusieurs critères, dont le degré d’immersion, c’est-à-dire la position de l’observateur par rapport à l’image. Ce critère oppose ainsi les écrans exocentriques, qui maintiennent l’observateur à l’extérieur du monde représenté, et les écrans égocentriques, qui placent l’observateur au coeur du monde représenté. Cette distinction simple permet de désigner et de mieux penser l’horizon du programme immersif : celui-ci devrait viser non pas tant l’illusion de la profondeur ou du relief que l’inscription de l’usager, au-delà de la surface et du cadre, en plein centre du monde virtuel – ce qu’il faudrait ainsi nommer une immersion spatiale égocentrique.

Les dispositifs monumentaux et les dispositifs rapprochés

Les images traditionnelles, parce qu’elles sont généralement planes et limitées, ne peuvent offrir une telle immersion ; elles laissent toujours le spectateur devant l’image, de ce côté-ci de la surface et du cadre. Par contre, elles peuvent, grâce à divers moyens, faire oublier leurs limites et ainsi permettre au spectateur d’entrer dans l’espace représenté par l’imagination. Historiquement, deux stratégies ont principalement été déployées pour faciliter cette immersion imaginaire. La première consiste à agrandir l’image. Elle a donné lieu à un dispositif familier qui, suivant le modèle du théâtre, propose une image monumentale et généralement localisée, un spectacle public, une expérience collective dans des lieux consacrés, souvent avec un prix d’entrée. C’est donc ainsi que la fresque, la peinture d’histoire, le paysage de grand format, la lanterne magique, le panorama, le cinéma, le cinéma 3D, le cinéma IMAX et tous les dispositifs monumentaux ont pu, sans cesser d’être des surfaces limitées, offrir au spectateur une expérience nouvelle qui participe de l’immersion spatiale égocentrique – ou l’évoque, à tout le moins. La seconde stratégie consiste à rapprocher l’image. Elle a généré un autre type de dispositif qui, sur le modèle du livre et du jouet, propose une image miniature et souvent portative, un spectacle privé, une expérience individuelle ou familiale, qui peut être vécue n’importe où, dans l’espace domestique ou en arcade, toujours au plus près du corps, impliquant fréquemment l’acquisition d’une technologie par l’usager et offrant des contenus à la carte. La peinture miniature, le paysage de petit format, les jouets optiques, la photographie, le stéréoscope, le kinétoscope, la télévision, le Sensorama et tous les autres dispositifs rapprochés ont ainsi pu, malgré leurs dimensions, faciliter l’immersion imaginaire du spectateur dans l’image[4].

Ces deux grands dispositifs sont évidemment des types idéaux. Entre l’un et l’autre, il existe une infinité de dispositifs, qui varient selon la distance par rapport au spectateur, la taille de l’image, le champ de vision (field of view) et l’interface : de l’image éloignée à l’image rapprochée, de l’image monumentale à l’image miniature, avec ou sans cadre, du dispositif immeuble à l’appareil meuble, de l’appareil de table à l’appareil portatif, à main ou têtier, etc. Certains dispositifs sont même hybrides, comme le cinéma 3D, où se rencontrent l’écran géant et les lunettes. D’ailleurs, si elles peuvent sembler opposées, ces deux stratégies – agrandir ou rapprocher l’image – sont, en fin de compte, identiques : il s’agit, chaque fois, de rapprocher les limites de l’image des limites du champ visuel, d’augmenter l’espace virtuel et de réduire l’espace réel, pour permettre au spectateur de s’imaginer au centre du monde représenté. Et il est particulièrement révélateur que la plupart de ces dispositifs immersifs, qu’ils soient monumentaux ou rapprochés, soient fondés sur des opérations de séparation et d’occultation de l’espace réel occupé par le spectateur : l’image est entourée d’un cadre, la visionneuse comporte des oeillères, la salle est jetée dans la pénombre, etc.

À l’origine, les deux modèles sont concurrents. Or, au xxe siècle, le dispositif monumental est devenu dominant et le dispositif rapproché, marginal. Le stéréoscope, le kinétoscope et bien d’autres appareils à image miniature et individuelle ont été déclassés par l’institutionnalisation du cinéma de salle, des écrans géants et collectifs. Mais la diffusion de la télévision dans les années 1950 et 1960, tout comme celle de l’ordinateur personnel et des consoles de jeu vidéo (de deuxième génération) dans les années 1980 et 1990, ont constitué des moments de renouveau du dispositif rapproché. Et aujourd’hui, le développement rapide des plateformes mobiles, c’est-à-dire des écrans portés, à la main – console portative, tablette, téléphone –, confirme la viabilité du modèle.

Mais, dans leurs versions courantes, les deux dispositifs constituent des réponses également imparfaites au programme immersif : qu’elle soit monumentale ou miniature, qu’elle fasse oublier la surface (par la stéréoscopie) ou non, l’image est encore limitée par un cadre – par le cadre de l’écran de cinéma, aussi grand soit-il ; par celui de la télévision, de l’ordinateur, de la tablette ou du téléphone, aussi proche soit-il. L’idéal de l’immersion spatiale égocentrique est loin d’être atteint, parce que sa condition principale n’est pas remplie : l’identification des limites de l’image et des limites du champ visuel. Le champ visuel excède toujours l’écran.

Masques, lunettes et interfaces faciales

Les choses semblent être sur le point de changer, du côté du dispositif rapproché. Une nouvelle génération d’écrans portés, têtiers, à visière et/ou oculaires – qui sont approchés de la tête, mis en contact direct avec le visage et les yeux –, pourrait renouveler le dispositif[5].

La majorité des instruments d’optique traditionnels sont oculaires, qu’il s’agisse d’instruments de grossissement – comme le microscope et le télescope – ou de correction – comme les lunettes. Mais du côté des jouets optiques ou des appareils de consommation des images, les dispositifs oculaires sont plus rares. Citons le kaléidoscope (Brewster, 1817), construit sur le modèle de la longue-vue ; les premiers stéréoscopes, de table ou à main, qui demandent à l’usager de se coller le visage sur l’appareil, sur deux miroirs en angle (Wheatstone, 1838), deux oculaires (Brewster, 1849) ou une visière (Holmes, vers 1850) ; et la visionneuse stéréoscopique (le View-Master de Mayer, 1939).

Peu après sa commercialisation, la télévision se miniaturise et se rapproche elle aussi : elle devient portative (Sentinel, 1948 ; Philco, 1959 ; Sony, 1961), de poche (Panasonic, 1981 ; Sony, 1982) et bracelet (Seiko, 1983). Mais le dispositif têtier ne dépasse pas le stade du prototype. En 1936, Hugo Gernsback a l’idée des « television eyeglasses », dont il fera plus tard construire un modèle, non fonctionnel. Henry J. de N. McCollum dépose, en 1943, un brevet pour un appareil analogue, « a stereoscopic television apparatus », avec deux tubes cathodiques miniatures installés dans une simple monture de lunettes. En 1957, peu de temps avant son célèbre Sensorama, Morton Heilig dépose à son tour un brevet pour un « stereoscopic-television apparatus for individual use » (qui présente non seulement des images et des sons, mais aussi des odeurs, par des tubes placés sous le nez). William E. Bradley met au point en 1961 un « remotely controlled viewing system » de télévision en circuit fermé qui, en liant les mouvements de la tête et les mouvements de la caméra, permet à l’usager de contrôler à distance la captation de l’image. C’est ainsi dans les marges de la télévision, à la rencontre du dispositif têtier et de l’interactivité, que sont faites les premières expériences de réalité virtuelle. La suite de l’histoire est déjà canonique : en 1968, Ivan E. Sutherland conçoit un « head-mounted display », avec deux tubes cathodiques et une interface binoculaire. Même s’il présente une image générée par ordinateur, le dispositif rappelle celui de Bradley : grâce à un système de suivi (mécanique, puis à ultrasons), il associe en temps réel les mouvements de la tête et ceux de la caméra (virtuelle)[6].

Les recherches sur le dispositif têtier ont été ralenties ou abandonnées, pour des raisons variées : la lourdeur de l’appareil, la faible définition de l’écran, etc. En revanche, d’autres technologies – moins immersives, mais plus communicationnelles et interactives, comme l’ordinateur personnel, les consoles de jeu et les plates-formes mobiles – ont monopolisé l’attention des producteurs et des consommateurs. Mais actuellement, le dispositif têtier effectue son retour, sous une forme bien améliorée. Avec le perfectionnement des processeurs, des piles, des écrans et du design, les casques d’antan, rudimentaires, encombrants et hors de prix, sont devenus des lunettes et des masques confortables, performants et économiques. La production de ces appareils n’est plus le fait de quelques laboratoires dans les universités ou de petites compagnies spécialisées, mais est maintenant prise en charge par de grosses corporations. Et elle vise non plus le marché restreint des amateurs et des professionnels, mais le marché de grande consommation.

Si le succès d’Oculus Rift (Oculus VR, 2016) est récent, cette nouvelle génération de lunettes et de masques – stéréoscopiques, avec des capteurs de mouvements, pour la plupart – est le fruit d’un effort de recherche et de développement qui s’est poursuivi sur une vingtaine d’années, surtout dans le domaine du jeu vidéo. Les appareils sont nombreux : Stuntmaster (Victormaxx, 1993[7]) ; Sega VR (Sega, 1993 – pour la présentation publique du prototype, qui ne sera jamais commercialisé) ; Jaguar VR (Atari, 1995 – pour le prototype) ; Virtual Boy (Nintendo, 1995) ; Glasstron (Sony, 1997); VFX3D (Interactive Imaging Systems – qui deviendra Icuiti, puis Vuzix, 2000) ; HMZ-T1 (Sony, 2011) ; Vive (Valve et HTC, 2016) ; Project Morpheus, qui deviendra PlayStation VR (Sony, 2016) ; etc. Il faut aussi mentionner les masques qui sont de simples montures sur lesquelles on fixe un téléphone : Google Cardboard (Google, 2015) ; Samsung Gear VR (Oculus VR et Samsung, 2015), etc. Le téléphone, qui était déjà le lieu d’une convergence technologique forte, intègre maintenant la réalité virtuelle.

Figure 1

Verres de contact et interfaces cornéennes

Ainsi certains chercheurs, dans les laboratoires universitaires ou industriels, de technologie et de biotechnologie, travaillent déjà sur la prochaine génération d’images techniques, qui rapprochent encore l’écran en le posant directement sur les yeux.

L’idée des verres de contact est séculaire, mais elle devient praticable au xixe siècle : en 1800, Thomas Young conçoit une « cornée artificielle » constituée d’une double lentille convexe, collée sur l’oeil à l’aide de cire et remplie d’eau ; en 1823, John Herschel imagine de poser directement sur l’oeil une capsule remplie de gelée animale ou de quelque médium transparent moulé ; et en 1888, Xavier Galezowski invente des pansements constitués de « rondelles de gélatine préalablement imprégnées de sublimé et de cocaïne », lesquelles sont appliquées directement sur la cornée. Bientôt, plusieurs prototypes fonctionnels sont réalisés en verre soufflé (Müller, 1887 ; Girard, 1887 ; Fick, 1888 ; Kalt, 1888 ; Müller, 1889 ; Dallos, 1929). Dans les années 1930 et 1940, les verres de contact en plastique font leur apparition (Feinbloom, 1936 ; Rohm et Hass, 1936 ; Mullen, 1938 ; Obrig, 1938 ; Wöhlk, 1940 ; Tuohy, 1948 ; Butterfield, 1948). Les verres de contact souples sont mis au point dans les années 1950 et 1960 (Wichterle et Lim, 1959) et manufacturés dans les années 1970 (Bausch & Lomb, 1971), puis viennent les verres perméables (Gaylord, 1979). Ainsi, les verres de contact sont manufacturés depuis la fin du xixe siècle (notamment par la compagnie Carl Zeiss AG), mais il faudra attendre les années 1960 pour qu’ils soient produits et vendus sur une grande échelle (Barr 2005 ; Olboeter et al. 2013).

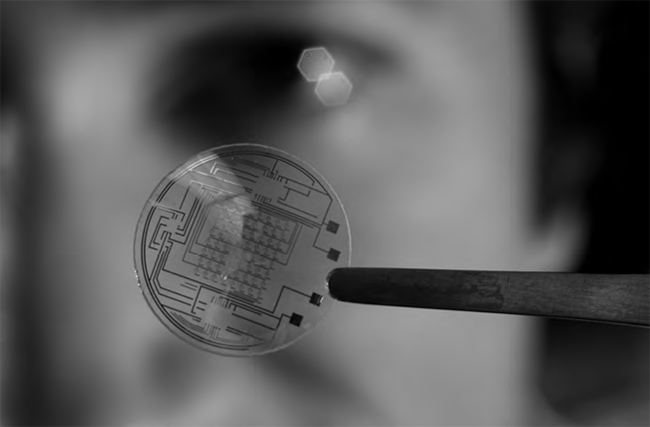

Jusque-là, les verres de contact sont développés pour corriger des faiblesses de l’oeil, comme les lunettes. Mais certains laboratoires travaillent aujourd’hui sur des verres qui peuvent augmenter la vue et même la redonner aux aveugles. En 2008, Babak A. Parviz et quelques autres chercheurs de l’Université de Washington, à Seattle, présentent des verres de contact « bioniques », avec un écran DEL (semi-transparent), une puce électronique (un circuit intégré), divers capteurs et une antenne (qui assure l’alimentation sans fil et les échanges d’information), dont les principaux usages anticipés sont la réalité augmentée et le suivi médical. Peu après, Parviz est recruté par Google, où il travaille au développement des Google Contact Lenses à l’usage des diabétiques (qui mesurent en permanence le taux de glucose dans les larmes ; Google et Verily, présenté en 2014), puis à la Google Glass.

En 2013, Eric Tremblay et une équipe de chercheurs de l’École polytechnique fédérale de Lausanne, de l’Université de Californie à San Diego et de plusieurs compagnies mettent au point un prototype de verres de contact dotés d’une sorte de « télescope miniature » qui zoome automatiquement. En 2015, l’équipe présente un deuxième prototype encore plus avancé – mais plus lourd, puisqu’il doit être jumelé à des lunettes – qui permet de zoomer et de dézoomer à volonté en clignant d’un oeil ou de l’autre. En 2013, la compagnie Innovega présentait d’ailleurs au Consumer Electronics Show un dispositif apparenté, iOptik, des verres de contact qui reçoivent des images projetées par des lunettes.

Figure 2

Tous ces verres sont encore en développement, mais ils devraient être commercialisés sous peu – compte tenu des compagnies impliquées et des investissements – et pourraient trouver bien des applications – médicales, industrielles, militaires, domestiques, comme dans le domaine du divertissement.

Implants oculaires et interfaces cristallines ou rétiniennes

Il existe également certains dispositifs rapprochés qui transgressent les limites de la peau et de la cornée pour implanter l’interface à l’intérieur même de l’oeil. Ces implants oculaires peuvent être localisés en amont ou en aval, selon la condition de l’oeil à traiter : les implants cristallins sont posés sur le cristallin (les implants phaques) ou le remplacent (pseudophaques) ; les implants rétiniens sont posés sur la rétine (épirétiniens) ou derrière elle, près du nerf optique (sous-rétiniens).

Du côté des implants cristallins, les résultats sont déjà nombreux. Isaac Lipshitz conçoit un télescope miniature qui, implanté à la place du cristallin, agrandit sur la rétine les images perçues et peut contrer les effets de la dégénérescence maculaire. En 2010, le dispositif est approuvé et il est commercialisé sous le nom de CentraSight. En 2014, Google dépose un brevet pour un « intraocular device », mis au point par Andrew Jason Conrad, qui remplace le cristallin par un verre électronique dont le foyer artificiel est contrôlé par les forces naturelles de l’accommodation oculaire. En 2015, Ocumetics Technology présente un implant analogue, mais mécanique. Selon l’inventeur Garth Webb, ces verres peuvent non seulement corriger, en temps réel, la vue mais aussi l’augmenter, jusqu’à « 3 times better than 20/20 ».

Du côté des implants rétiniens, les recherches sont aussi abondantes. Au début des années 1990, à l’Université John Hopkins, Mark Humayun et son équipe démontrent la viabilité des implants électroniques épirétiniens, qui transmettent directement à la rétine les informations visuelles captées par une caméra. Dans les années 2000, ces recherches vont mener à l’ambitieux Artificial Retina Project, qui rassemble quatre universités, six laboratoires nationaux du U.S. Department of Energy et une entreprise privée pour la production et la commercialisation des prothèses. Cette rétine artificielle de 60 électrodes est la première prothèse rétinienne approuvée, en 2011, et elle est aussitôt commercialisée. Au même moment, une équipe allemande de l’Université RWTH Aachen, le EPIRET Group, développe un implant double qui transmet les données lumineuses d’une caméra externe au cristallin et du cristallin à la rétine.

Depuis la fin des années 1990, Eberhart Zrenner développe à l’Université de Tübingen un implant électronique sous-rétinien (de 1 500 diodes) qui amplifie la lumière entrant dans l’oeil et stimule directement (avec 16 électrodes) les cellules ganglionnaires du nerf optique. En 2002, Alan et Vincent Chow mettent au point une rétine artificielle similaire (de 5 000 diodes et autant d’électrodes) qui, placée sous la vraie rétine, capte et amplifie la lumière qui entre dans l’oeil. Au même moment, John L. Wyatt travaille au M.I.T. sur un implant sous-rétinien qui stimule aussi le nerf optique, mais à partir des données lumineuses captées par une caméra externe. D’autres équipes mettent au point des dispositifs apparentés, comme celles de Daniel Palanker à l’Université Stanford, de Claude Veraart à l’Université catholique de Louvain ou de la compagnie Bionic Vision Australia.

Figure 3

L’implant rétinien Argus II (Second Sight, 2011).

Si les implants sous-rétiniens sont toujours en développement, les implants cristallins et épirétiniens sont sur le point d’être commercialisés. Pour l’instant, ces recherches ont des objectifs médicaux : redonner la vue, la corriger, l’améliorer. Mais les technologies dont elles accouchent ouvrent également la voie à la création d’une réalité augmentée ou virtuelle.

Implants cérébraux et interfaces neuronales

Enfin, certains implants sont placés au-delà de l’organe sensoriel et directement sur le cerveau. Ils sont simplement posés ou implantés, installés en surface sur le cortex visuel primaire (sur la face interne du lobe occipital, dans la scissure calcarine) ou alors au plus profond du cerveau (sur le corps géniculé latéral du thalamus) (Lewis et Rosenfeld 2016). Ils permettent ainsi de voir sans yeux.

L’idée d’agir sur le cerveau par l’électricité se développe au xviiie siècle. Galvani découvre l’« électricité animale » et établit que la stimulation électrique des nerfs entraîne la contraction des muscles. Mesmer tente de guérir divers maux en appliquant sur le corps de ses patients des plaques aimantées ou en les mettant en contact avec le « baquet », une bouteille de Leyde géante. Il tente même de guérir une pianiste aveugle – sans succès. En 1753, Jean-Baptiste Le Roy fait passer à travers le corps d’un aveugle, de la jambe à la tête, puis de la nuque au front, une décharge électrique, qui provoque de violentes commotions et d’étranges visions. Pour lui, ces « fantômes » ne peuvent être produits que par « une impression sur les nerfs optiques », comme s’ils avaient été « ébranlés par des objets extérieurs de façon à produire de semblables images, à peu près comme dans les rêves » (Le Roy 1755, 81-95). Il découvre ainsi ce qu’on appellera les phosphènes.

Il faudra toutefois attendre la fin du xixe siècle pour que le cerveau lui-même soit soumis directement à l’électricité et que se précise enfin la localisation des fonctions cérébrales. En 1870, Eduard Hitzig et Gustav Fritsch établissent, sur un chien vivant dont le crâne est ouvert, une topographie qui lie les aires cérébrales et les différentes parties du corps. David Ferrier systématisera par la suite ces recherches dans The Functions of the Brain (1876). La plupart de ces expériences sont menées sur des animaux. Mais ce sont les expériences sur les humains – lesquels peuvent communiquer par la parole leur expérience subjective –, et notamment sur les blessés de guerre, qui vont permettre de préciser le rapport entre la stimulation électrique du cortex et les sensations visuelles (Clarac et Ternaux 2008, 201-13).

En 1878, Hermann Munk découvre l’importance pour la vue du lobe occipital. Les recherches se poursuivent avec Luigi Luciani et Augusto Tamburini, Sanger Brown et E. A. Schäfer, Salomon Eberhard Henschen, Kurt Löwenstein et Marda Borchardt, et d’autres. Elles culminent dans la « carte » de Gordon Morgan Holmes (1918), qui établit une correspondance spatiale entre le cortex visuel et le champ visuel – ce qu’on appellera la rétinotopie. Au même moment, Tatsuji Inouye arrive à des résultats apparentés. En 1929, Otfrid Foerster les précise : la stimulation de l’aire occipitale produit des phosphènes immobiles au centre du champ visuel ; celle du cortex strié produit des phosphènes à la périphérie. Ces hypothèses sont confirmées par les expériences de Fedor Krause et Heinrich Schum (1931), de même que par les recherches de Wilder Penfield et Theodore Rasmussen, présentées dans The Cerebral Cortex of Man: A Clinical Study of Localization of Function (1950). Une fois établie cette possibilité – de produire des phosphènes par la stimulation électrique du cerveau –, l’idée a germé de redonner la vue aux aveugles par une neuroprothèse électrique. Les développements de l’électronique et de l’informatique vont donner une impulsion décisive à ces recherches.

Dès 1953, Joseph D. Shaw dépose le brevet d’un appareil pour les aveugles avec quatre « tubes photo-électriques » placés au fond d’une camera obscura portative qui captent la lumière devant le patient et la transmettent au cortex visuel, à l’aide d’électrodes internes ou externes (par induction), disposées selon la même configuration. Shaw suppose que le patient pourra apprendre à lire ces configurations d’ombres et de lumières comme des images du monde. En 1957, John C. Button et Tracey Putnam fabriquent une prothèse qui associe de même des cellules photo-électriques et des électrodes branchées sur le cerveau. La patiente, aveugle, peut ainsi « voir » une source lumineuse (une ampoule électrique) « somewhat as the sun might appear to a sighted person through closed eyelids » et même la localiser, avec un peu de temps. Grâce à un appareil amélioré, Button et Putnam produisent des phosphènes colorés et plus complexes.

En 1967, Giles Brindley et Walpole Lewin posent sur le cerveau d’une patiente aveugle, sur le lobe occipital de l’hémisphère droit, un bonnet de silicone rassemblant 80 électrodes et autant de récepteurs qui, stimulés à distance et à travers la peau par ondes radio, peuvent provoquer des phosphènes dans la moitié gauche du champ visuel. Brindley continuera jusque dans les années 1980 à parfaire son implant – en augmentant le nombre d’électrodes jusqu’à 151. Dans les années 1970 et 1980, Harvey Dobelle travaille dans le même sens avec des implants – et des résultats – similaires. En 2000, il perfectionne le dispositif en y ajoutant des lunettes avec une caméra vidéo miniature, qui capte et relaie l’information visuelle vers l’implant cortical.

Figure 4

Depuis 2010, Arthur Lowery développe une prothèse corticale analogue : une caméra et un processeur installés sur une paire de lunettes captent des images et les transmettent à un ensemble de puces électroniques avec plus de 600 électrodes implantées dans le cerveau qui stimulent le cortex visuel et permettent au patient de « voir » des points de lumière et des images rudimentaires. En 1999, Yang Dan utilise des implants neuronaux (ciblant 177 cellules dans le corps géniculé latéral du thalamus qui reçoit les signaux de la rétine) pour enregistrer, décoder et revisualiser des images filmées présentées à des chats.

Le potentiel des prothèses neuronales est établi. Il reste à raffiner le contrôle sur l’apparence des phosphènes (la forme, la luminosité, la couleur et la persistance) en jouant sur les électrodes (le nombre, la taille, la localisation et la profondeur) et les signaux électriques (l’intensité, la durée, le rythme et l’espacement). Il faut alléger le dispositif et le rendre plus sécuritaire. Le développement des communications sans fil et de la stimulation transcrânienne, qui permet d’agir sur l’implant à travers le crâne sans liaison filaire, constitue de ce point de vue une avenue prometteuse.

Pour l’instant, le but de ces recherches est thérapeutique. Mais en trouvant l’algorithme d’encodage et de décodage entre les images et les signaux électriques, il serait possible non seulement de présenter des images captées et diffusées en direct (comme à la télévision) et des images enregistrées et différées (comme au cinéma), mais aussi des images entièrement construites (comme dans le jeu vidéo) ; non seulement de reproduire les sensations « naturelles », mais aussi de produire de nouvelles sensations, entièrement artificielles. À l’heure actuelle, même si les implants se perfectionnent avec un nombre grandissant de cellules photo-électriques et d’électrodes, les sensations produites sont encore rudimentaires et très pixellisées. Mais elles sont déjà reconnaissables en tant qu’images, comme des signes analogiques, des icônes ressemblantes.

L’utopie biotechnologique : Brains in a vat

Ces développements technologiques et biotechnologiques – lunettes, verres de contact, implants – transforment le dispositif de réception des images. Ils opèrent un rapprochement entre le sujet et l’objet, un déplacement de l’interface entre l’appareil et le corps, une incorporation et même une intériorisation de l’interface : elle est située au plus près de la peau avec les masques et les lunettes ; au-delà de la peau avec les implants oculaires ; et au-delà des organes et directement sur le cerveau avec les dispositifs neuronaux. Nous sommes bien loin de « l’écran ultime » dont rêvait Sutherland (1965) et au plus près de l’utopie d’un cinéma neuronal.

Cette utopie biotechnologique – telle qu’elle s’esquisse dans les laboratoires – suscite bien des réflexions. Déjà, sur le plan méthodologique, elle nous oblige à revenir sur la définition même de l’écran et de l’image en général, alors que disparaissent la surface et le cadre, le support et l’appareil, et toute interface perçue. Mais elle suscite surtout des réflexions épistémologiques, en actualisant un ensemble de faits scientifiques décisifs : le corps humain est largement électrique ; le système nerveux, sensori-moteur, est régi par des impulsions électriques, il traduit les données du monde (électromagnétiques, chimiques, mécaniques) en électricité et l’électricité en mouvement. Mais la stimulation électrique du cerveau et la production artificielle de phosphènes jettent un doute sur le témoignage des sens : la vue, comme tous les autres sens, a une autonomie relative par rapport au monde, et il est possible de produire artificiellement des images, des sensations, des expériences par l’électricité.

La célèbre Gedankenexperiment d’Hilary Putnam souligne la portée philosophique de cette utopie biotechnologique du cinéma neuronal. Imaginez qu’un « savant fou » retire votre cerveau de votre corps pour le placer dans une cuve d’éléments nutritifs et qu’il en connecte toutes les terminaisons nerveuses à un superordinateur. Imaginez que cet ordinateur envoie et reçoit des impulsions électriques si nuancées que votre cerveau a l’impression qu’il y a vraiment autour de lui des choses, des gens, un monde et qu’il est toujours lui-même partie d’un corps qui peut agir dans ce monde. Notre expérience vive pourrait bien n’être qu’une telle illusion électrique (Putnam 1981).

Malgré son hypothèse technologique, cette expérience de pensée n’est pas nouvelle. Elle renoue avec le scepticisme antique et, surtout, avec le doute baroque, avec les réflexions de Descartes qui, déjà, remettait en question le témoignage des sens, la réalité du corps et du monde avec l’hypothèse du « malin génie », et celles de Berkeley qui, au contraire, ne croyait qu’à la réalité des sensations, pour lui avérées non pas par quelque objet extérieur (comme le veut ce qu’on appellera plus tard la « théorie-correspondance » de la vérité), mais par d’autres sensations (la « théorie-cohérence »), et produites non pas par le monde, mais par Dieu lui-même.

Il peut sembler surprenant de voir resurgir aujourd’hui des réflexions apparentées à celles de Descartes et de Berkeley. Or ce n’est pas fortuit. De tout temps, les illusions d’optique, les hallucinations et surtout les rêves ont nourri le scepticisme et constitué, pour la philosophie, un vrai problème. Aussi, certains développements des sciences et des technologies ont joué un rôle décisif dans la reprise de ces interrogations : l’essor de l’anatomie au xvie siècle ; la découverte de l’électricité animale au xviiie siècle ; les avancées de la neurologie aux xixe et xxe siècles ; et puis, plus récemment, le développement de l’informatique et des biotechnologies.

Le mind-body problem

Comme l’expérience de pensée de Putnam, le cinéma neuronal est ainsi épistémologique. Il nourrit deux positions apparemment contradictoires, également indémontrables. En un premier temps, il affirme une position empiriste forte. Contre le dualisme, qui supposait une hétérogénéité fondamentale entre l’âme et le corps, entre les substances pensante et étendue, entre l’esprit et le cerveau, le cinéma neuronal est résolument matérialiste : la conscience, les pensées et les sensations sont les effets de processus neuronaux, électriques, etc.

Cette causalité est difficile à démontrer, comme la causalité en général. Si la cause et l’effet sont des objets du monde, perceptibles, la causalité elle-même ne vient pas du monde, mais de l’esprit. Elle est, comme le pensait Hume, un concept empirique dérivé de l’expérience – une habitude – ou, comme le pensait Kant, un concept a priori imposé à toute expérience – une catégorie. Et la causalité particulière qui lie le cerveau et la conscience est encore plus difficile à démontrer, parce que la conscience n’est pas un objet comme les autres, elle est intérieure, elle n’est pas observable ni partageable. Mais la causalité a néanmoins pour elle une forte présomption de vérité, parce qu’elle est reproductible – comme la causalité entre le cerveau et la conscience.

En un deuxième temps, le cinéma neuronal nous invite à adopter une position transcendantale, grâce à un raisonnement par analogie ou une mise en abyme (un saut conceptuel). En nous montrant des cerveaux soumis sans le savoir à l’électricité, il jette un doute sur l’objectivité même de notre conscience actuelle (contrairement à ce qu’en pense Putnam) : si l’électricité peut produire des sensations dans ce cerveau-là, toutes les sensations que nous éprouvons nous-mêmes actuellement – notre corps, les autres, le monde et même ce cerveau dans une cuve – pourraient bien n’être qu’un rêve électrique.

En réaffirmant le lien entre la conscience et le cerveau, le cinéma neuronal met en question l’autonomie de la conscience, mais en même temps il réaffirme son hégémonie : il n’est rien en dehors de la conscience, toute expérience du monde est conditionnée par une conscience, tout est dépendant de l’esprit (mind-dependant). Et le monde en soi, tel qu’il est en dehors des sens et de la conscience – de ce que Kant appelait les formes de la sensibilité, les schémas de l’imagination et les catégories de l’entendement –, est inconnaissable, comme d’ailleurs la nature même de la relation entre le monde en soi et les apparences pour moi – entre le noumène et les phénomènes.

Le cinéma neuronal est ainsi une sorte de « présentation négative » du sujet transcendantal, dont nous ne pouvons pas vraiment faire l’expérience, mais que toute expérience présuppose ; que nous ne pouvons pas sentir, penser, décrire, mais que toute sensation, toute pensée, tout discours, toute action même postulent – pratiquement ou pragmatiquement. Il serait sublime, au sens kantien du terme, un spectacle qui manifeste à la fois la finitude du sujet – les limites de la connaissance et du pouvoir humains, les limites de la sensibilité et la faiblesse du corps – et l’ambition et le pouvoir infinis du sujet – capable de concevoir, au-delà de toute intuition, de toute expérience possible, et de vouloir, au-delà du corps et de la nature.

Le fantasme

Mais cette utopie biotechnologique du cinéma neuronal suscite aussi des réflexions politiques. On le sait, les producteurs de technologie, comme les consommateurs, sont nourris par des désirs, des rêves et des fantasmes. Le fantasme qui se formule ici, dans le cinéma neuronal, est sans doute un rêve d’omnipotence. Il vise la reproduction parfaite du monde, la simulation intégrale de l’expérience, comme s’il s’agissait de se débarrasser du corps et du monde tout entier. Et, au-delà de cela, il vise aussi le contrôle total du corps et de l’âme.

Le champ émergent des neuroprothèses et des « interfaces neuronales directes » (DNI) semble bien confirmer l’existence de ce programme « fort », étendu au-delà du cinéma neuronal. Il concerne non seulement les implants entrants (qui vont du monde au cerveau), mais aussi les implants sortants (qui vont du cerveau au monde), non seulement les prothèses sensorielles, mais aussi les prothèses motrices et même cognitives. Aujourd’hui, il est possible de redonner la vue aux aveugles, d’activer à distance un bras robotique ou un ordinateur par la simple volonté, d’augmenter la mémoire et d’autres capacités intellectuelles par la microstimulation neuronale. Et il serait possible, en retour, de contrôler à distance les gestes et les pensées[8]. L’humain réparé et augmenté est aussi un humain surveillé et contrôlé. Le sens du courant a une dimension politique. (Et il n’est pas surprenant que l’armée finance un bon nombre de ces recherches biotechnologiques.)

Le cinéma traditionnel peut sembler avoir anticipé ces développements – et sa propre disparition, la fin de la salle, de l’écran et de l’interface – dans un grand nombre de films, dont The Lady and the Monster (1944), Donovan’s Brain (1953), The Brain (1962), The Brain that Wouldn’t Die (1962), Brainstorm (1983), Total Recall (1990), Strange Days (1995), La Cité des enfants perdus (1995), The Matrix (1999), eXistenZ (1999), Possible Worlds (2000), Inception (2010). Mais il a plus probablement contribué à forger l’imaginaire techno-scientifique lui-même qui a guidé ces recherches et mené au développement des implants neuronaux. Cette utopie du cinéma neuronal est une création conjointe de l’art et de la science, elle s’est formulée dans un singulier dialogue entre les salles de cinéma et les laboratoires scientifiques.

Ainsi, le cinéma neuronal, comme tout fantasme, n’est peut-être qu’un écran, au sens psychanalytique du terme, qui nous protège du réel traumatique et nous dispense d’avoir à subir les effets que le réel ne manquerait pas d’avoir sur l’imaginaire et le symbolique, sur le sujet et l’ordre social. Mais lorsqu’il est mis en abyme – comme dans les expériences de pensée philosophique, les expériences techno-scientifiques ou les fictions cinématographiques –, le cinéma neuronal pourrait bien être le lieu d’un apprentissage : il pourrait nous apprendre à traverser le fantasme ou, du moins, à en sentir les limites.

Appendices

Notes

-

[1]

À ce sujet, voir notamment le « three-circuits model » de Stephen Kline, Nick Dyer-Witheford et Greig De Peuter, dans Digital Play: The Interaction of Technology, Culture, and Marketing, Montréal/Kingston : McGill/Queen’s University Press, 2003.

-

[2]

L’immersion est entendue ici non pas comme une fin a priori de l’histoire, comme un telos historique ou transhistorique, mais comme une fin empirique des pratiques de production et de consommation des images techniques, ainsi que peuvent l’être un programme de recherche et de développement ou un horizon d’attente. Ce n’est pas la seule fin de ces pratiques – la communication, l’interactivité, la jouabilité, la portabilité, par exemple, sont des fins concurrentes, parfois privilégiées –, mais l’immersion reste centrale.

-

[3]

L’expression est, évidemment, imparfaite, puisqu’elle succombe à l’attraction du nom commun cinéma. Néanmoins, elle a le mérite d’être imagée – en plus de rendre hommage au « mythe du cinéma total » d’André Bazin. Il est sans doute pertinent de rappeler ici que, pour Bazin, l’« obsession » du « réalisme intégral » travaille non seulement le cinéma, mais aussi toutes les technologies de restitution de la réalité au xixe siècle, et que cette lecture n’est pas pour autant téléologique ; elle appelle au contraire à sortir du déterminisme technologique pour considérer l’interaction entre la technologie et l’imagination – de même que la force historique des mythes.

-

[4]

Encore une fois, il ne s’agit pas ici d’affirmer que tous ces dispositifs sont identiques, mais bien de rappeler qu’ils ont tous été conçus et perçus, à certains moments, dans divers contextes et à des degrés différents, comme des moyens non seulement de faire illusion, mais aussi d’entrer dans l’image – pas uniquement comme des fenêtres, mais comme des portes également. L’analyse comparée des dispositifs de vision et des discours qui permettent de les penser montre que l’imitation est une question récurrente en histoire de l’art, constamment réactualisée, reformulée et déplacée (il faudrait relire ici notamment : Erwin Panofsky, Idea. Contribution à l’histoire du concept de l’ancienne théorie de l’art, Paris : Gallimard, 1984 [1968] ; et Georges Didi-Huberman, Devant l’image. Questions posées aux fins d’une histoire de l’art, Paris : Éditions de Minuit, 1990), et qu’elle est intimement liée à celle de l’immersion (voir à ce sujet, entre autres : Hubert Damisch, L’origine de la perspective, Paris : Flammarion, 1993 [1987] ; Giovanni Careri, Envols d’amour. Le Bernin : montage des arts et dévotion baroque, Paris : Usher, 1990; Michael Fried, Absorption and Theatricality. Painting and Beholder in the Age of Diderot, Berkeley/Los Angeles : University of California Press, 1980; et Jonathan Crary, Techniques of the Observer: On Vision and Modernity in the Nineteenth Century, Cambridge : M.I.T Press, 1990).

-

[5]

Traditionnellement, en physique, on distingue entre les instruments d’optique subjectifs ou oculaires et les instruments objectifs ou de projection.

-

[6]

Pour la plupart des inventions mentionnées ici et dans la suite du texte, voir notamment les brevets déposés sur le site de la United States Patent and Trademark Office : https://www.uspto.gov/.

-

[7]

Sauf indication contraire, la date renvoie au moment de la commercialisation de l’appareil.

-

[8]

Voir par exemple les recherches du Laboratory of Neural Prosthetics Research, dirigé par Philip Troyk à l’Institut de technologie de l’Illinois.

Bibliographie

- Barr, Joseph T. 2005. « History and Development of Contact Lenses ». Dans Clinical Contact Lens Practice, sous la direction de Edward S. Bennett et Barry A. Weissman, 1-10. Philadelphia : Lippincott, Williams and Wilkins.

- Calleja, Gordon. 2011. In-Game: From Immersion to Incorporation. Cambridge : M.I.T. Press.

- Clarac, François, et Jean-Pierre Ternaux. 2008. L’encyclopédie historique des neurosciences. Bruxelles : Boeck.

- Grau, Olivier. 2003. Virtual Art: From Illusion to Immersion. Cambridge : M.I.T. Press.

- Griffiths, Alison. 2008. Shivers down your Spine: Cinema, Museums, and the Immersive View. New York : Columbia University Press.

- Lewis, Philip M., et Jeffrey M. Rosenfeld. 2016. « Electrical Stimulation of the Brain and the Development of Cortical Visual Prostheses: A Historical Perspective ». Brain Research 1630 : 208-24. https://doi.org/10.1016/j.brainres.2015.08.038.

- Le Roy, Jean-Baptiste. 1755. « Mémoire où l’on rend compte de quelques tentatives faites pour guérir plusieurs maladies par l’électricité ». Dans Histoire de l’Académie royale des sciences avec les mémoires de mathématiques et de physique pour la même année, section sur les Mémoires, 60-98. Paris : Imprimerie Royale.

- Milgram, Paul, Haruo Takemura, Akira Utsumi et Fumio Kishino. 1995. « Augmented Reality: A Class of Displays on the Reality-Virtuality Continuum ». Proceedings of SPIE 2351 (« Telemanipulator and Telepresence Technologies ») : 282-92. https://doi.org/10.1117/12.197321.

- Olboeter, Nicole, Sibylle Scholtz et Gerd U. Auffarth. 2013. « Contact Lenses ». Dans The Eye in History, sous la direction de Frank Joseph Goes, 146-58. London : Jaypee Brothers Medical Publishers.

- Putnam, Hilary. 1981. « Brains in a Vat » et « Two Philosophical Perspectives ». Dans Reason, Truth and History, 1-21 et 49-74. Cambridge : Cambridge University Press.

- Ryan, Marie-Laure. 2001. Narrative as Virtual Reality: Immersion and Interactivity in Literature and Electronic Media. Baltimore : Johns Hopkins University Press.

- Schaeffer, Jean-Marie. 1999. Pourquoi la fiction ? Paris : Seuil.

- Sutherland, Ivan E. 1965. « The Ultimate Display ». Proceedings of IFIP Congress 2 : 506-8.

List of figures

Figure 1

Figure 2

Figure 3

Figure 4