Abstracts

Résumé

Cet article analyse les instruments de quantification de l’action publique contre le décrochage scolaire en France et au Québec. Cette comparaison d’une instrumentation replacée dans son contexte national permet de s’interroger sur les effets de perspective engendrés par le recours à une grande variété d’outils de quantification. L’évaluation de l’ampleur du phénomène appelle une démarche multiscalaire : nationale certes, mais indissociablement supranationale et régionale, ou même locale. Il s’avère que les exigences de l’instrumentation statistique se sont déplacées au cours du temps d’une priorité donnée à la comparaison interétatique vers une priorité donnée à l’estimation d’indicateurs régionaux ou locaux en vue de mobiliser et d’outiller les acteurs de terrain. Est ainsi révélé le rôle politique de la variété des définitions (des mises en équivalence), des indicateurs (fréquences ou pourcentages), des échelles d’ordonnancement et seuils de comparaison : ils fournissent in fine des répertoires rhétoriques aux acteurs nationaux et régionaux qu’ils mobilisent tantôt pour accréditer l’urgence d’agir tantôt pour démontrer l’efficacité de l’action entreprise.

Mots-clés :

- décrochage scolaire,

- quantification,

- instrumentation,

- rhétorique,

- statistiques,

- politiques publiques

Abstract

This article analyzes the quantification instruments of public action to fight against school dropout in France and in Quebec. This comparison of an instrumentation within its national context enables us to discuss the effects of perspective generated by the use of a wide variety of quantification instruments. The assessment of the scope of the phenomenon calls for a multi-scalar approach on a national, supranational, regional and local level. It shows that the exigencies of a statistical instrumentation moved from a priority given to interstate comparison to a priority given to the estimation of regional or local indicators aimed at mobilizing and enabling field actors. It reveals the political role of the variety of definitions (categories of equivalence), indicators (frequencies or percentages), ranking scales and thresholds of comparison. They provide, in fine, rhetorical repertoires to national and regional actors mobilized either for accrediting an emergency to act or to demonstrate the efficacy of the action undertaken.

Keywords:

- school dropout,

- quantification,

- instrumentation,

- rhetoric,

- statistics,

- public policy

Resumen

Este artículo analiza los instrumentos de medición de la acción pública contra la deserción escolar en Francia y en Quebec. Esta comparación de una instrumentación reubicada en su contexto nacional permite interrogarse acerca de los efectos de perspectiva generados por el uso de una gran variedad de herramientas de cuantificación. La evaluación de la magnitud del fenómeno requiere un enfoque multiescalar : nacional, pero indisociablemente supranacional y regional, o incluso local. Resulta que, con el tiempo, las exigencias de la instrumentación estadística se desplazaron de la prioridad dada de la comparación interestatal hacia la prioridad de la estimación de indicadores regionales o locales para movilizar y habilitar a los actores de terreno. Así se manifiesta el papel político de la variedad de definiciones (de las puestas en equivalencia), de los indicadores (frecuencias y porcentajes), de las escalas de ordenamiento y umbrales de comparación : éstos proporcionan in fine directorios retóricos a los actores nacionales y regionales que ellos movilizan algunas veces para acreditar la urgencia de actuar, u otras para demostrar la eficacia de la acción emprendida.

Palabras clave:

- Deserción escolar,

- cuantificación,

- instrumentación,

- retórica,

- estadísticas,

- políticas públicas

Article body

Au Québec comme en France, la lutte contre décrochage scolaire est devenue une priorité des politiques éducatives nationales[2]. À cette fin, des outils de quantification du décrochage doivent être mis en place, qui permettent d’évaluer l’ampleur du phénomène à l’échelle nationale, régionale et même locale, ainsi que d’observer son évolution au fil des ans. Ces politiques et ces outils conduisent en outre à comparer aussi bien la France et les autres pays membres de l’Union européenne que le Québec et les autres provinces canadiennes. Enfin, dans la mesure où ces politiques font explicitement appel à des intervenants régionaux, elles exigent de mettre en oeuvre des outils de diagnostic et d’évaluation fiables sur le plan territorial et peuvent conduire à comparer les territoires administratifs ou les institutions éducatives compétentes (commissions scolaires/académies ou établissements). Ainsi apparaît une possible tension entre exigences internationales, nationales et locales de quantification.

Cet article se propose d’examiner les recompositions des statistiques en matière de décrochage scolaire induites tant par la montée des régulations supranationales que par les processus de décentralisation et de déconcentration de l’action publique. Nous adoptons ici un cadre d’analyse conventionnaliste inspiré de la sociologie de la quantification : l’action de quantifier est ici définie comme visant à « faire exister sous une forme numérique ce qui, auparavant, était exprimé par des mots et non par des nombres », en portant attention aux comparaisons, compromis, traductions, codages, négociations, procédures et calculs qui rendent possible cette transmutation (Desrosières, 2008 : 10). À ce titre, nous articulons trois éléments d’analyse : les jeux d’échelle ; la comparaison des instruments de l’action publique ; et les effets de perspective.

Desrosières (2003) distingue deux formes de l’État selon qu’elles sont « dotées d’un centre » (ce qu’ont en commun l’État ingénieur, le libéralisme classique, l’État providence et le keynésianisme) ou qu’elles sont pensées « au contraire comme un ensemble de pôles administratifs ou territoriaux différents, dont les relations sont négociées, contractuelles, réglées par le droit » (Desrosières, 2003 : 218). De fait, la nature de l’information statistique d’une administration publique est configurée ou reconfigurée aussi bien par le maintien ou l’émergence d’institutions supranationales de régulation tant politiques que statistiques, que par les processus de décentralisation et de déconcentration (Bornand et al., 2012). Selon Desrosières (1994), « se dessine une tension entre d’une part, le territoire, espace d’équivalence associé à une action institutionnelle et susceptible d’être découpé [selon des normes nationales], et d’autre part, la localité, comme support d’une vie sociale, économique et politique [spécifique] aux composantes et interactions multiples » (Desrosières, 1994 : 46).

Les jeux d’échelle entre, d’une part, le palier fédéral (au Canada) ou européen et, d’autre part, le palier régional, municipal ou local influencent le travail de production des statistiques, tant dans le contexte français que dans le contexte québécois (Doray et Verdier, 2012). Dans les deux sociétés, la lutte contre le décrochage est devenue une priorité en éducation, et cette politique fait explicitement appel aux intervenants de différentes échelles d’action, et particulièrement aux acteurs régionaux. Cependant, cette mobilisation n’a ni commencé au même moment ni fait face aux mêmes défis de quantification. Au Québec, la mobilisation remonte au lancement en 1992 du plan d’action visant l’enseignement secondaire Chacun ses devoirs[3]. La lutte contre le décrochage s’est traduite par la mise en oeuvre d’une gestion des établissements axée sur les résultats et par la création progressive des Instances régionales de concertation (IRC), les différents acteurs se fondant sur les données produites par le ministère de l’Éducation, du Loisir et du Sport (MELS) pour leurs diagnostics et évaluations, y compris à l’échelle régionale (Doray et al., 2011). En France, la définition du décrochage scolaire comme problème éducatif n’a succédé à celui de l’échec scolaire que sous l’effet de l’européanisation partielle de l’action publique en matière d’éducation (Bernard, 2011), puis des données statistiques qui s’en sont suivies, après le sommet de Lisbonne en 2000 (Moulin et al., 2014). Étudier les indicateurs de la réussite et du décrochage scolaire, loin de ramener à une question purement technique, conduit au contraire à analyser l’action publique contre le décrochage scolaire à travers ses instruments (Lascoumes et Le Galès, 2004). La comparaison des instruments de quantification dans les deux contextes nationaux et à différentes échelles permet ainsi d’interroger la mise en oeuvre des politiques de la réussite.

Dans un tel contexte de différents niveaux d’action publique, les changements d’échelle sont susceptibles de créer des « effets de perspective ». Tels qu’ils sont conceptualisés par Prévost (2011), ces effets ne constituent pas des biais, « des fautes de raisonnement ou des erreurs logiques », mais sont « consubstantiels aux instruments cognitifs mis en oeuvre, procèdent de choix méthodologiques » nécessaires ou inévitables (Prévost, 2011 : 21) et sont liés à la « rhétorique de la quantification » (McCloskey, 1985). Suivant Prévost (2011), nous distinguons ici quatre catégories d’effets de perspective : les effets des mises en équivalence des décrocheurs ; les effets d’abstraction des mises en pourcentage ; les effets d’ordonnancement (notamment ceux induits par les rangs et palmarès par lesquels les pays, les régions, les commissions scolaires et les établissements sont comparés les uns les autres) ; et les effets de seuils (les cibles de référence ou benchmarks que les différentes instances de gestion publique — de l’État central à l’établissement local — se donnent comme objectifs à moyen et long terme et les seuils de référence que les institutions publiques et scolaires considèrent symboliquement comme « critiques »). Les instruments quantifiés peuvent être vus non seulement comme des outils de diagnostic, mais aussi comme des moyens de persuasion « cherchant à produire des effets pathétiques ou éthiques sur le public pour mieux justifier une politique publique déjà mise en oeuvre ou mieux faire apparaître l’urgence d’agir » (Moulin, 2011 : 10).

Quels sont les instruments quantifiés de l’action publique contre le décrochage scolaire de la France et du Québec et comment ces instruments ont-ils varié au cours du temps et aux différentes échelles ? Quels sont les principaux effets de perspective que l’on peut identifier ? Sur le plan de l’analyse historique des jeux d’échelle, nous avançons l’hypothèse selon laquelle les exigences de l’instrumentation statistique se sont déplacées au cours du temps d’une priorité donnée à la comparaison interétatique à l’outillage des acteurs infraétatiques. Sur le plan des effets de perspective, nous faisons l’hypothèse qu’en tirant parti de la variété des instruments de quantification disponibles, les acteurs de la lutte contre le décrochage scolaire tendent à dramatiser leur action. Cette dramatisation, dans laquelle on peut voir une variante des procédés d’identification (naming), d’accusation ou d’attribution de blâme (blaming) et d’humiliation (shaming) consubstantiels à la production de classements, vise tantôt à accréditer l’urgence d’agir en mobilisant des instruments qui assombriront le tableau du décrochage scolaire — par exemple en se référant à un effet de perspective associé à un mauvais classement de telle région ou de tel pays ; tantôt, en mobilisant des lunettes qui feront voir les choses positivement — comme passer en dessous d’un seuil de référence hautement symbolique tel que celui de 10 % de décrocheurs —, elle vise au contraire à démontrer l’efficacité de l’action ou à justifier une politique publique. Nous analyserons successivement les instruments de quantification utilisés sur le plan supranational, la quantification de l’évolution du décrochage scolaire sur le plan national, et les instruments de quantification utilisés sur le plan infranational (de l’échelle de la région à celle de l’établissement). En conclusion, nous reviendrons sur les principales similitudes et différences entre le Québec et la France.

Les comparaisons des systèmes nationaux d’éducation

Sur le plan supranational (européen ou fédéral), l’enjeu principal de la quantification du décrochage scolaire consiste à construire un espace d’équivalence entre les différents systèmes éducatifs en vue de les comparer. Deux espaces d’équivalence peuvent être distingués : l’espace européen dans lequel s’intègre la France et, pour le Québec, l’espace canadien.

La France dans l’Union européenne

Pour comparer la situation de la France avec celle des autres pays européens, un indicateur mesurant les « sortants précoces » a été mis en place à la suite du sommet de Lisbonne en 2000. Selon cette définition, un décrocheur est un jeune de 18 à 24 ans qui n’a suivi aucune formation au cours des quatre semaines précédant l’enquête et qui a terminé, au maximum, le premier cycle du secondaire. La catégorisation statistique de référence pour les niveaux d’éducation est celle de la Classification internationale type de l’éducation (CITE). Le niveau d’éducation secondaire inférieur se réfère à la CITE 2011, soit les niveaux 0 à 2 pour les données à partir de 2014 et à la CITE 1997, soit les niveaux 0 à 3C court pour les données jusqu’en 2013.

L’indicateur est basé sur les Enquêtes sur les forces de travail de l’UE qui sont réalisées par les instituts nationaux de statistiques dans toute l’Europe et sont traitées de manière centralisée par Eurostat. Ces instituts sont ainsi responsables du tirage de l’échantillon, de la préparation des questionnaires, de l’organisation de la collecte (interviews) auprès des ménages et de l’envoi des résultats à Eurostat. Il s’agit d’une harmonisation de définitions et de résultats davantage que d’une harmonisation des procédés, les modes de tirage et de collecte variant significativement d’un institut à l’autre.

L’utilisation de la CITE a conduit à déstabiliser les pratiques antérieures de comptage des non-diplômés. C’est en Angleterre que la controverse a été la plus vive (Melnik et al., 2010). Jusqu’en 2013, la distinction entre niveau 3C court et niveau 3C long a été d’autant plus délicate à manier que « le niveau 3C n’est pas défini dans la CITE elle-même, mais dans les manuels d’utilisation de la classification, qui d’une institution internationale utilisatrice (UNESCO, Eurostat et OCDE) à l’autre ne retiennent pas les mêmes acceptions » (Melnik et al., 2010 : 19). Par ailleurs, certains pays peuvent classer certaines formations professionnelles qui durent moins de deux ans au niveau 3 de la CITE alors qu’elles devraient être logiquement au niveau 2, comme cela a pu être le cas du Royaume-Uni, les organismes internationaux corrigeant ou non les statistiques nationales ainsi configurées (voir CERC, 2008 : 18). Compte tenu d’une application hétérogène de ces notions de niveaux de diplôme d’un pays européen à l’autre, la comparabilité du taux de décrochage est restée problématique, comme en atteste la médiocre note C que lui accordait Eurostat (Tréhin-Lalanne, 2010)[4].

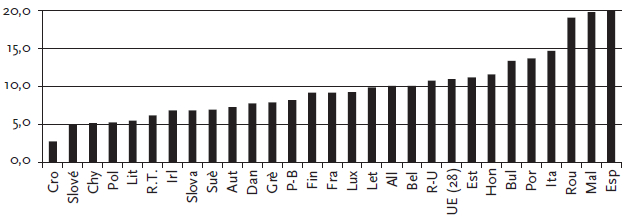

En France, le calcul de ce taux est réalisé à partir des enquêtes sur l’emploi de l’Insee : c’est la part des jeunes de 18 à 24 ans qui n’ont pas obtenu au minimum un CAP[5], un BEP[6] ou leur équivalent (Dardier, 2013). L’analyse comparée des taux dans les différents pays de l’Union européenne (UE) conduit à situer la France au quinzième rang, en dessous de la moyenne de l’UE, soit 9,2 % (voir Graphique 1). Pour l’ensemble de l’UE, une cible a été fixée à 10 % en 2020. L’UE module les cibles nationales : elles passent de 16 % pour l’Italie et 15 % pour l’Espagne à 4 % pour la Croatie et 4,5 % pour la Pologne. Certains pays avaient déjà atteint en 2015 la cible fixée en 2020 : c’est le cas de la France, mais aussi de la Croatie, de la Slovénie, de Chypre, de la Lituanie, de l’Irlande, de la Suède, de l’Autriche, du Danemark, de la Grèce, du Luxembourg, de la Lettonie et de l’Italie. Dès lors, ces pays ont une cible plus ambitieuse à atteindre ; ainsi la cible a changé à 9,5 % pour la France, déjà atteinte par ailleurs puisqu’en 2016, le taux se fixait à 8,8 %.

Graphique 1

Jeunes ayant quitté prématurément l’éducation et la formation (% de la population âgée de 18 à 24 ans, 2015)

In fine, on peut évaluer la performance d’un pays comme la France de différentes manières : en comparant le taux de décrochage à la moyenne des pays de l’Union ; en situant le taux par rapport à la cible de 2020 ; en situant la place relative du pays par rapport aux autres ; ou en analysant la progression de la baisse du taux par rapport à celle des autres pays membres. Selon l’indicateur choisi, il est possible de changer la perspective sur la performance d’un pays en comparaison des autres pays membres de l’UE. Ainsi, on peut mettre l’accent sur la place relativement médiocre de la France (15e) ou plutôt sur le fait que celle-ci a un taux de décrochage inférieur à la moyenne de l’UE et qu’elle a déjà atteint l’objectif qui lui était initialement fixé.

Le Québec au sein du Canada

Si l’on compare la situation de la France en Europe avec celle du Québec au sein du Canada, la principale différence tient au fait qu’aucune cible n’a été fixée sur le plan fédéral, puisque l’éducation est, selon la Constitution, un champ de compétence provincial. C’est donc aux provinces d’établir des cibles, si elles le désirent. Sur le plan interprovincial, deux grands ensembles de données peuvent être distingués selon le type de source : données administratives ou ministérielles dans le cas de l’Enquête sur l’enseignement primaire et secondaire (EEPS) ; ou bien enquêtes menées par Statistique Canada avec, en premier lieu, l’enquête sur la population active (EPA) et, secondairement et ponctuellement, l’Enquête sur les jeunes en Transition (EJET).

La première source qui permet de comparer le Québec aux autres provinces du Canada est l’EEPS : elle recueille chaque année des données agrégées auprès de chaque ministère provincial-territorial ou département de l’Éducation. Trois indicateurs peuvent être utilisés : le taux brut et le taux net d’obtention d’un diplôme de fin d’études secondaires et l’achèvement réussi d’un programme de deuxième cycle du secondaire.

Le premier indicateur utilisé est le taux brut d’obtention d’un diplôme de fin d’études secondaires : il s’obtient en divisant le nombre de nouveaux diplômés, peu importe leur âge, par la population ayant l’âge typique d’obtenir ce diplôme. Comme les personnes scolarisées au Québec obtiennent leur diplôme un an avant les jeunes scolarisés dans les autres provinces, cet âge typique était établi à 17 ans au Québec et à 18 ans dans les autres. Cet indicateur a été utilisé dans les deux premières éditions des Indicateurs de l’éducation du Canada : une perspective internationale, soit celles de 2009 et 2010.

L’indicateur qui lui a succédé dans cette série est le taux net d’obtention d’un diplôme de fin d’études secondaires. Il est obtenu en divisant le nombre de diplômés d’un âge spécifique par les effectifs de la population ayant cet âge spécifique, et s’interprète comme « une estimation de la probabilité qu’un individu obtienne un diplôme d’études secondaires au cours de sa vie, et ce, dans l’hypothèse d’un maintien des conditions actuelles d’obtention de ce type de diplôme » (Statistique Canada, 2012). Cet indicateur correspond à l’indicateur A2 du taux d’obtention du diplôme de fin d’études qui provient de l’exercice UOE (UNESCO, OCDE et Eurostat) de collecte de données statistiques sur l’éducation mené conjointement par les trois organisations internationales. C’est aussi l’indicateur que l’on retrouve dans les « Indicateurs de l’éducation » (fiches 5.1 à 5.4, édition 2013) publiés depuis 1986 par le ministère de l’Éducation, du Loisir et du Sport (MELS). Ce taux est défini comme la proportion de la population qui obtient un premier diplôme ou une première qualification d’études secondaires, et est présenté par sexe et par âge (avant l’âge de 20 ans et après l’âge de 20 ans).

Le troisième indicateur est l’indicateur de l’achèvement réussi d’un programme de deuxième cycle de l’enseignement secondaire. Cet indicateur est basé sur une cohorte synthétique pour les écoles publiques. Il est calculé en divisant le nombre de diplômés âgés de 16 à 19 ans (15 à 18 ans au Québec) par le nombre d’inscrits en grade 10 (3e secondaire au Québec) trois ans auparavant. Ce ratio est ensuite ajusté de manière à prendre en considération les décès de même que les flux migratoires interprovinciaux et internationaux (Statistique Canada, 2016).

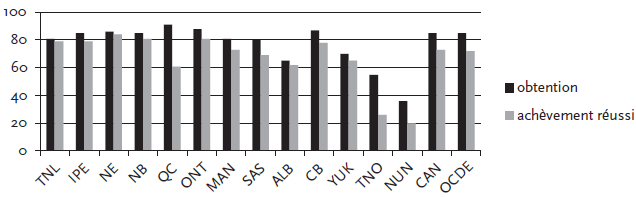

Quand on compare les valeurs de ces indicateurs, on voit d’abord que de fortes disparités existent entre les provinces et territoires : le taux net était de 91 % au Québec contre seulement 36 % au Nunavut et la proportion d’élèves ayant terminé leurs études dans les temps prévus varie de 20 % au Nunavut à 84 % en Nouvelle-Écosse. On observe aussi et surtout des écarts entre les deux indicateurs qui varient beaucoup selon la province considérée (voir Graphique 2). Ainsi, alors que le Québec affiche le meilleur score quand on examine le taux net d’obtention du diplôme avec 91 %, il affiche le moins bon score au sein des provinces sur le plan de l’achèvement dans les délais prescrits avec 61 % seulement. Cette différence d’appréciation s’explique d’abord par la proportion importante de personnes qui obtiennent le diplôme d’études secondaires après 20 ans au Québec (entre 15 et 16 %). Elle résulte aussi du fait que les diplômés des établissements non publics ne sont pas pris en compte par ces calculs.

Graphique 2

Taux net d’obtention d’un diplôme de fin d’études secondaires et achèvement réussi d’un programme de deuxième cycle dans les écoles publiques des provinces canadiennes, 2012

Des travaux ont aussi mobilisé l’enquête sur la population active (EPA) de Statistique Canada. Bowlby (2005) définit le décrocheur comme un jeune de 20 à 24 ans qui ne fréquente pas l’école la semaine de référence de l’enquête et qui n’a pas obtenu son diplôme d’études secondaires. Il précise que : « même si les élèves terminent habituellement leurs études secondaires à l’âge de 18 ans, ce n’est pas le cas de tous, et ce, pour différentes raisons. Toutefois, entre 20 et 24 ans, les chances de terminer le secondaire sont en grande partie compromises. Les taux de décrochage sont donc habituellement calculés à l’aide des données concernant ce groupe d’âge » (Bowlby, 2005 : 2).

En plus des enquêtes sur la population active, de nombreuses études ont exploité dans les années 2000 les données de l’Enquête auprès des jeunes en transition (EJET) afin de comparer les taux de décrochage sur le plan pancanadien. Cette enquête longitudinale a été conduite de 2000 à 2010 en opérant des ré-interrogations tous les deux ans de deux cohortes de jeunes nés respectivement en 1984 (cohorte A) ou entre 1979 et 1981 (cohorte B). Bushnik (2003) est le premier à calculer des taux de décrochage à partir des premières données sur la cohorte B et définit le décrocheur comme « un jeune âgé de 18 à 20 ans qui ne fréquentait pas une école secondaire en décembre 1999 et qui ne satisfaisait pas aux exigences minimales pour l’obtention du diplôme d’études secondaires » (Bushnik, 2003 : 6). De même, Bushnik et al. (2004), tirant parti de la nature longitudinale de l’EJET relative à la cohorte A, définit le décrocheur comme « un jeune âgé de 17 ans qui ne fréquentait pas l’école secondaire en décembre 2001 et qui ne satisfaisait pas aux exigences minimales pour l’obtention du diplôme d’études secondaires ». L’utilisation de cette cohorte pour une comparaison des taux de décrochage par province se heurte cependant à une difficulté : la population de référence de l’enquête est constituée exclusivement de jeunes qui fréquentaient l’école à 15 ans, et exclut donc les jeunes déscolarisés[7] au moment de l’enquête.

Sur le plan européen, on l’a vu, les États membres se sont fixé un objectif commun, soit une proportion des jeunes en décrochage scolaire inférieure à 10 % en 2020 (Commission européenne 2010). Au Québec, le MELS avait abandonné la cible de référence, soit atteindre en cinq ans un taux de diplomation de 80 % chez les jeunes de moins de 20 ans, énoncée dans son plan de 1992, mais l’a finalement réintroduite sous la pression du Groupe d’action sur la persévérance et la réussite scolaires (GAPRS) dont le porte-parole était le banquier Jacques Ménard. Le rapport proposait un objectif bien précis : augmenter le taux de diplomation avant 20 ans à 80 % en 10 ans (Ménard, 2009). Ce rapport a décrit la situation en se présentant comme le fruit d’une initiative citoyenne, en développant une approche étiologique du décrochage et en adoptant une perspective économiciste qui chiffrait les pertes du décrochage en milliards de dollars, en utilisant des indicateurs qui comparent le Québec aux autres provinces et en identifiant les « meilleures pratiques » prônant la réalisation d’un suivi continu des effets des actions entreprises (Doray et al., 2011).

Le rapport Ménard positionne le Canada au sein des pays de l’OCDE en reprenant un classement établi en fonction du pourcentage de la population ayant obtenu l’équivalent d’un diplôme de fin d’études secondaires ou professionnelles dans les délais prescrits : c’est ainsi que l’Allemagne se place en tête, le Canada au 16e rang, et la France au 28e rang sur 30. Cependant, il est précisé que « le Canada passe en 5e position si l’on considère le taux de diplomation pour la tranche d’âge 25 à 34 ans, en raison des programmes d’éducation des adultes » (Ménard, 2009 : 10). Les différentes provinces sont, pour leur part, classées en fonction du taux de diplomation des 20-24 ans : selon ce critère, la Colombie-Britannique est en tête, l’Ontario deuxième et le Québec avant-dernier (neuvième), suivi du Manitoba. Il est ajouté que le Québec « a glissé du 7e au 9e rang canadien depuis 1992 » (Ménard, 2009 : 10). Dans son document, L’école, j’y tiens !, le MELS reprend certes la cible initiale (80 % de taux de diplomation à 20 ans), mais le ton est pondéré, par rapport à celui, alarmiste, du rapport Ménard (MELS, 2009).

L’évolution du décrochage sur le plan national

Sur le plan national, l’évolution du décrochage peut être évaluée à partir de certains des indicateurs précédents, mais cette quantification peut aussi tenir compte de formes de certification propres à chaque système d’éducation et inclure des personnes plus jeunes, en se référant à l’ensemble des flux de sortants du système éducatif. Quels sont donc les instruments privilégiés dans les deux contextes sociétaux et quels effets de perspective engendrent-ils ?

Les quantifications du décrochage en France

En France, quatre sources sont utilisées sur le plan national : les enquêtes emploi de l’Institut national de la statistique et des études économiques (Insee) ; les panels de la Direction de l’évaluation, de la prospective et de la performance (DEPP) ; les enquêtes Génération du Centre d’études et de recherches sur les qualifications (CEREQ) ; et le système interministériel d’échange d’informations (SIEI) mis en oeuvre à l’initiative du ministère de l’Éducation nationale (MEN).

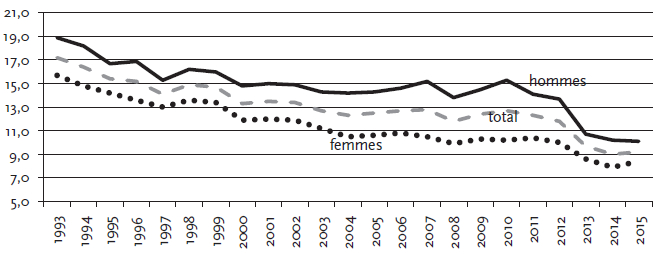

Comme indiqué plus haut, le calcul du taux de décrochage, utilisé dans le cadre des comparaisons intraeuropéennes, est réalisé à partir des enquêtes Emploi de l’Insee : c’est la part des jeunes de 18 à 24 ans qui n’ont pas obtenu au minimum un CAP, un BEP ou équivalent. Comme en témoigne le Graphique 3, ce taux a substantiellement baissé jusqu’en 2004 puis s’est stabilisé à 12 % environ de 2004 à 2012, et enfin, a connu une baisse significative en 2013 et en 2014. Cependant, cette baisse est en partie due à un changement dans la méthode de l’enquête Emploi entre 2012 et 2013. Des questions sur la participation à des formations formelles ou non formelles ont en effet été ajoutées au questionnaire. « Ce changement a eu pour conséquence d’augmenter le nombre de jeunes considérés comme étant en formation, et donc de diminuer le nombre de jeunes sortis du système scolaire » (Fondation Alphaomega, 2017). Le nouveau taux de décrochage s’élève en 2015 à 9,2 %.

Graphique 3

Jeunes ayant quitté prématurément l’éducation et la formation, % de la population âgée de 18 à 24 ans, France, 1993-2015

L’exploitation des enquêtes Emploi de l’Insee conduit aussi à calculer le décrochage sur la base de flux en rapportant les sans-diplôme au flux de sortants d’une année donnée : ainsi « on estime à 16 % la proportion des sortants de formation initiale qui quittent le système éducatif sans diplôme de l’enseignement secondaire (moyenne estimée sur les sortants en 2009, 2010 ou 2011) : 9 % n’ont aucun diplôme et 7 % ont seulement le brevet des collèges » (Dardier et al., 2013 : 12). Ici, la ventilation de la catégorie des décrocheurs en deux sous-catégories (titulaires ou non du brevet des collèges) permet de relocaliser la quantification dans le contexte propre au système scolaire français. L’évolution est aussi à la baisse : « sur l’ensemble des 677 000 jeunes sortant de formation initiale, en moyenne annuelle 2010, 2011 et 2012, 15 %, soit 101 000 jeunes, n’ont aucun diplôme ou au mieux le brevet. Ce taux était de 17 % en moyenne 2007, 2008 et 2009 » (Lefresne, 2015 : 2).

Depuis 1998, le CEREQ réalise tous les trois ans une enquête Génération auprès de jeunes qui ont en commun d’être sortis du système éducatif la même année, quel que soit le niveau ou le domaine de formation atteint ; la dernière enquête a été réalisée en 2016 auprès des sortants de formation initiale de 2013, soit les jeunes de moins de 35 ans inscrits dans un établissement en France en 2012-2013 qui n’ont pas repris leurs études l’année suivante et qui n’avaient jamais interrompu leurs études avant cette date. Parmi ces derniers, le CEREQ dénombre les « sans-diplôme », soit les sortants qui n’ont pas obtenu au moins un CAP ou un BEP et qui, de ce fait, peuvent être assimilés à des décrocheurs. Les résultats sont similaires à ceux obtenus sur la base de l’enquête Emploi : au sein de la génération sortie en 2010, 119 800 jeunes n’avaient obtenu aucun diplôme, soit 17 % des 700 800 jeunes ayant quitté le système éducatif. Retraçant les parcours durant trois ans, cette enquête indique que 8 % de ces décrocheurs ont repris des études à temps plein et 27 % une formation hors emploi d’au moins un mois et susceptible de déboucher sur l’obtention d’une certification professionnelle : ces retours en formation, autrement dit ce raccrochage, contribuent à faire baisser le stock des décrocheurs parmi les 18-24 ans (indicateur européen).

Depuis 1973, la DEPP a mis en place des panels d’élèves afin de retracer les parcours scolaires des cohortes d’élèves entrés en classe de 6e (première année de l’enseignement secondaire). Le dernier panel utilisable pour la quantification du décrochage scolaire est celui de 1995 dans la mesure où celui mis en place en 2007 ne permet de suivre les élèves que pendant 6 années. L’exploitation du panel de la DEPP conduit à calculer la part des jeunes entrés en 6e en 1995 qui

ont suivi un cursus de lycée sans obtenir un baccalauréat, mais tout en ayant un diplôme en poche (CAP ou BEP),

ont suivi un cursus menant à un CAP ou à un BEP (ou équivalent) sans en obtenir le diplôme,

ont quitté l’école au niveau du collégial (avec ou sans le brevet). Au total, 10 ans après avoir entrepris les études secondaires, il s’avère que 17 % de la cohorte est « sans diplôme » (Lemaire et al., 2007).

Ces trois sources diffèrent donc significativement à la fois selon leurs temporalités et selon les définitions adoptées. Alors que l’enquête Emploi est annuelle, les sources longitudinales que sont l’enquête Génération et le panel de la Direction de l’évaluation, de la prospective et de la performance (DEPP) relèvent d’une périodicité beaucoup plus faible (tous les trois ans dans le cas des enquêtes Génération du CEREQ), centrées qu’elles sont sur l’analyse de processus (parcours éducatifs et orientation pour l’un, insertion professionnelle pour l’autre). Par ailleurs, elles diffèrent substantiellement dans la définition des populations concernées : non seulement les sources longitudinales sont focalisées sur la détention ou non d’un diplôme, mais en outre, le décrocheur tel que catégorisé par le panel de la DEPP peut inclure des diplômés de CAP ou BEP, en référence au Code de l’éducation qui définit comme « décrocheurs » les jeunes qui ont quitté un cursus de formation de l’enseignement secondaire sans obtenir le diplôme visé par cette formation, soit possiblement des jeunes qui ont suivi un cursus de lycée après un BEP sans obtenir le baccalauréat professionnel qu’ils visaient.

C’est à cette même définition que se réfère le système interministériel d’échange d’informations (SIEI)[8]. C’est la source la plus récente en matière de décrochage. La mise en oeuvre du SIEI a été autorisée par la Commission nationale de l’informatique et des libertés (CNIL) en décembre 2010. C’est d’abord le constat d’un manque de données fiables sur les plans régional ou local qui a conduit à la mise en place de ce dispositif de quantification tourné vers l’action, consistant à repérer les décrocheurs en vue de leur proposer des actions de remédiation et donc d’envisager leur raccrochage. D’ailleurs, c’est sur la base des listes de décrocheurs établies par le SIEI que les 383 plates-formes de suivi et d’appui aux décrocheurs (PSAD) réunissent les acteurs des bassins de formation concernés[9] pour coordonner les stratégies locales des diverses parties prenantes afin de trouver une action pour chaque jeune. La production de statistiques est un effet secondaire de la mise en place d’un système de repérage nettement tourné vers le déclenchement d’actions opérationnelles. Dans ce contexte, l’exactitude de la mesure importe moins[10], ce qui va d’ailleurs autoriser le ministre de l’époque, Luc Chatel, à produire, à l’intention des médias, des chiffres nationaux incontrôlés mais qui, gonflant très sensiblement les effectifs de décrocheurs[11], visent à créer un choc au sein de l’opinion et des acteurs du système éducatif en vue de les mobiliser et de les enrôler, à tous les étages du système, dans la lutte contre le décrochage.

Les quantifications du décrochage au Québec

Au Québec, le décrocheur est une personne qui n’a pas obtenu de diplôme ni de qualification durant l’année scolaire considérée et qui n’est pas réinscrit dans la province l’année suivante, ni en formation générale (jeunes ou adultes), ni en formation professionnelle, ni au collégial. En plus du diplôme d’études secondaires (DES), deux autres diplômes sont pris en compte : les diplômes d’études professionnelles (DEP) et les attestations de spécialisation professionnelle (ASP). Cinq formes de qualification sont aussi reconnues : les certificats de formation en entreprise de récupération (CFER) ; les certificats en insertion socio-professionnelle des jeunes (ISPJ) ; les attestations de formation professionnelle (AFP) ; les certificats de formation en métiers semi-spécialisés (CFMS) ; et les certificats de formation en préparation au marché du travail (CFPT). Actuellement, ce sont surtout deux indicateurs qui sont officiellement utilisés : le taux de décrochage annuel et les taux de diplomation 5, 6, 7 ou 8 ans après le début du secondaire.

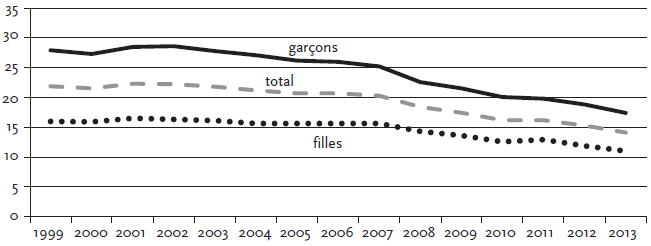

Le taux de décrochage annuel représente, parmi l’ensemble des sortants de formation initiale, la proportion de ceux et celles qui n’obtiennent durant l’année considérée ni diplôme ni qualification du secondaire et qui ne sont pas réinscrits l’année suivante dans le système scolaire québécois. C’est en 2012 que la décision a été prise de remplacer dans la publication des Indicateurs de l’éducation l’indicateur de décrochage à un âge donné par celui des sorties sans diplôme ni qualification au secondaire. L’indicateur de taux de décrochage précédent, publié depuis l’édition 2000 des Indicateurs de l’éducation, ne pouvait être calculé qu’à la seule échelle provinciale. De plus, jusqu’en 2012, il n’y avait pas de taux unique pour l’ensemble de la population du Québec mais plutôt une série de taux : le taux de décrochage à 16 ans, à 17 ans, à 24 ans, etc. Le nouvel indicateur reflète mieux la réalité des organismes scolaires du Québec et peut être calculé par école, par commission scolaire et par région administrative. De 1999-2000 à 2013-2014, le taux de décrochage annuel a baissé de 21,9 % à 14,1 % (voir Graphique 4).

Graphique 4

Taux de décrochage annuel selon le sexe, 1999-2013

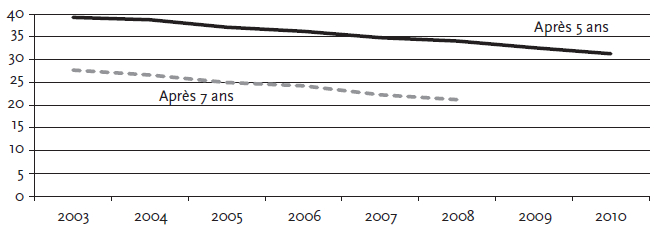

Le deuxième type d’indicateur utilisé est le taux de non-diplomation 5, 6, 7 ou 8 années après le début du secondaire. Il est calculé en rapportant les effectifs de décrocheurs au nombre de jeunes de la cohorte de secondaire considérée. Il est indiqué dans les rapports « Diplomation et qualification » que « cette méthode a été conçue en 1991 pour permettre aux commissions scolaires de se comparer et d’effectuer leur reddition de comptes » (MELS, 2016 : 3). L’indicateur de la diplomation par cohorte se distingue de l’indicateur du taux d’obtention d’un premier diplôme ou d’une première qualification du secondaire dans la population, utilisé pour mesurer la performance globale du système et se comparer aux autres provinces et aux pays de l’OCDE, et publié dans les Indicateurs de l’éducation (fiche 5.2). Le taux de non-diplomation après 7 ans représente la proportion des jeunes qui, 7 ans après leur première inscription au Québec, ne sont ni inscrits ni titulaires d’un diplôme ou d’une qualification du secondaire. Ce sont surtout les taux de diplomation après 5 et 7 ans qui sont utilisés : le taux de diplomation après 5 ans permet de mesurer la diplomation à l’âge normal de fin des études secondaires ; quant au taux de diplomation après 7 ans, c’est « l’indicateur qui se rapproche le plus de l’indicateur de diplomation avant 20 ans pour lequel la cible de 80 % d’ici 2020 a été fixée par le ministère de l’Éducation, du Loisir et du Sport en 2009 » (CartoJeunes, 2016). Comme on peut le voir dans le Graphique 5, le taux de non-diplomation et qualification après 7 ans a baissé de 27,7 % au sein de la cohorte de 2003 à 21,2 % au sein de la cohorte de 2008 tandis que le taux après 5 ans a baissé de 39,3 % au sein de la cohorte de 2003 à 31,3 % au sein de la cohorte de 2010.

Graphique 5

Taux de non-diplomation et qualification après 5 et 7 ans, 2003-2010

En somme, un renversement semble s’être opéré quant à la manière de présenter l’évolution nationale du décrochage et de la diplomation. D’une part, l’indicateur de décrochage à un âge donné a été remplacé en 2012 par celui des sorties sans diplôme ni qualification du secondaire. D’autre part, les taux de diplomation et de qualification par cohorte tendent à supplanter les taux d’obtention de premier diplôme dans la population. Ces derniers avaient été retenus parce qu’ils permettaient de faire des comparaisons interprovinciales, mais ils ne pouvaient être calculés qu’à l’échelle provinciale alors que les nouveaux indicateurs peuvent être déclinés à différentes échelles. Ainsi, la priorité en matière de quantification du décrochage scolaire semble s’être déplacée au cours du temps d’une priorité donnée à la comparaison interétatique à une priorité donnée à des instruments outillant les acteurs infraétatiques dans un contexte de diffusion d’une gestion centrée sur les résultats au sein du système éducatif (Maroy, 2013).

Il est important de noter que les taux sont largement tributaires du type de diplôme et de qualification pris en compte, l’ajout de nouvelles certifications contribuant à faire baisser mécaniquement le décrochage ou la non-diplomation. En 2007, l’ajout de nouvelles qualifications (CFMS, CFPT) reconnues par le MELS a eu un impact à la baisse sur l’évolution du nombre de décrocheurs. Dans le dernier rapport « Diplomation et qualification », la hausse du taux de diplomation et qualification est décomposée selon le type de sanction. Il y est montré que de la cohorte de 2003 à la cohorte de 2006, l’augmentation de la diplomation après 7 ans de 72,3 % à 75 % est causée exclusivement par la hausse des qualifications de 1,4 % à 4,1 %. À l’inverse, de la cohorte de 2006 à la cohorte de 2008, l’augmentation de la diplomation est seulement attribuable à la hausse des diplômés du secondaire, le taux d’obtention du DES après 7 ans passant de 69,9 % à 72,7 % (MELS, 2016).

Ceci peut aussi expliquer en partie des contradictions apparentes en matière de diagnostic sur l’évolution du décrochage. Ainsi, le rapport du MELS de 2009 fait état de taux d’obtention de diplôme ou de qualification avant 20 ans à la hausse, ce qui conduit les auteurs à parler de « réussite à la hausse » : plus exactement, le taux d’obtention de diplôme ou de qualification avant 20 ans passe de 66,7 % en 2002-2003 à 72,2 % en 2007-2008 dans le rapport du MELS (MELS, 2009). Pour sa part, le rapport Ménard ne comptabilise dans le taux de diplomation que l’obtention du DES et du DEP des 16-20 ans, ce qui le conduit à soutenir que « le taux d’obtention du diplôme avant l’âge de 20 ans reste pratiquement inchangé ». Même s’il est mentionné que l’éducation des adultes a contribué à diminuer le nombre de « décrocheurs à vie », il est avancé que « de façon générale, la situation s’est peu améliorée depuis deux décennies » (Ménard, 2009 : 9). Ainsi, le mode de comptabilisation des décrocheurs, en ne tenant pas compte de l’obtention des certificats de qualification, contribue à aider le GAPRS à porter un regard différent de celui du Ministère, ce qui permet de dire que la situation est tout aussi problématique, voire dramatique, que plusieurs années avant. A contrario, avec le nouveau mode de comptabilisation, le MELS est régulièrement accusé de manipuler les statistiques ou de « jouer le rôle de prestidigitateur » (Journet, 2017).

En 2009, la stratégie d’action L’école, j’y tiens ! avait fixé un taux de diplomation ou de qualification de 80 %, chez les élèves de moins de 20 ans, d’ici 2020. Dans le cadre de sa nouvelle Politique de la réussite éducative, le gouvernement du Québec s’est fixé en 2017 comme premier objectif deux nouvelles cibles d’ici 2030 : « porter à 90 % la proportion des élèves de moins de 20 ans qui obtiennent un premier diplôme ou une première qualification, et à 85 % la proportion de ces élèves titulaires d’un premier diplôme (DES et DEP) » (MELS, 2017 : 32). Le fait de se fixer une double cible, en faisant varier les types de certification et de qualification pris en compte, permet ainsi de répondre aux critiques de manipulation des chiffres de diplomation et de qualification.

Notons aussi qu’au Québec, les décrocheurs incluent les jeunes de 15 ans et moins qui ne sont pas inscrits aux études en dépit de l’obligation scolaire et des jeunes de 16 ans et plus qui ont quitté les études obligatoires sans avoir obtenu de diplôme ou de qualification (les décrocheurs au sens strict). Ainsi, la catégorie québécoise du décrochage inclut également les déscolarisés, contrairement à toutes les définitions françaises qui conduisent à exclure les 15 ans et moins de la population de référence. Cette différence conduit à rendre encore plus difficile la comparabilité des indicateurs d’une société à l’autre. Par ailleurs, en France comme au Québec, il n’est pas possible de différencier les décrocheurs de l’intérieur (jeunes toujours en présence à l’école sans engagement dans les études) et les décrocheurs au sens strict (Bernard, 2011). Dans tous les cas, la puissance de la catégorie légitime du « décrocheur » produit des effets d’hyperréalisme voyant les acteurs aligner leurs pratiques et leurs prises de position sur des indicateurs dont les limites sont manifestes au vu des bricolages dont ils sont issus et des réalités qu’ils ignorent ou masquent — ici la déscolarisation ou le décrochage de l’intérieur.

L’échelle infranationale

Les instruments de quantification du décrochage sur le plan infranational conduisent à comparer les régions, les institutions scolaires (commissions scolaires ou académies) ou encore les quartiers et les établissements dans lesquels il faut prioritairement intervenir. Quels sont les instruments mobilisés à cette échelle ?

La performance comparée des territoires au Québec

Comme indiqué précédemment, sur le plan infranational, les trois indicateurs utilisés sont les mêmes que ceux utilisés sur le plan national. En effet, le taux de décrochage annuel et les taux de diplomation à 5 ou 7 ans peuvent être calculés par territoire administratif (région, municipalités régionales de comté ou municipalités locales) ou institution scolaire (commission scolaire ou établissement). Au Québec, les données à différentes échelles administratives par sexe et type de réseau (public ou privé) peuvent être consultées en ligne grâce au travail collaboratif d’enseignants chercheurs, du Ministère et d’acteurs régionaux. À l’origine de ce site, on trouve le groupe de recherche ECOBES, dont Suzanne Veillette et Michel Perron qui ont contribué à créer en 1996 le Conseil régional de prévention de l’abandon scolaire (CREPAS) au Saguenay-Lac-Saint-Jean, la première IRC. À partir de 2005, le site interactif d’indicateurs spatialisés de persévérance et de réussite scolaires est créé, puis devient Cartodiplôme en 2010, et enfin CartoJeunes en octobre 2014. Ce site constitue une plate-forme de cartographie interactive qui peut être utilisée comme outil de diagnostic et de soutien à l’action publique en matière de lutte contre le décrochage scolaire.

Les IRC regroupent tous les intervenants régionaux mobilisés autour de la lutte contre le décrochage et de la persévérance. Elles regroupent des intervenants éducatifs des différents ordres d’enseignement, des groupes communautaires qui oeuvrent auprès des jeunes, des organismes de santé publique, des représentants des municipalités, des centres locaux d’emploi. Selon les régions, la configuration des organismes varie. Les sites internet des IRC de chaque région présentent aussi des statistiques sur le décrochage, la persévérance et la réussite. Les comparaisons sont historiques (on compare plusieurs années) ou territoriales (on compare sa région avec d’autres).

Grâce à CartoJeunes, les disparités territoriales sont très facilement saisissables. Sur le plan régional, le Nord-du-Québec se distingue par ses très faibles taux de diplomation et ses taux de décrochage très élevés : dans la cohorte 2007, seuls 27,9 % des élèves ont un diplôme ou une qualification après 5 ans et 39,2 % après 7 ans et le taux de décrochage annuel s’élevait à 58,8 % en 2012-2013. Les écarts sont moins élevés entre les autres régions. Effet de perspective notable, la performance d’une région varie en fonction de l’indicateur pris en compte. C’est l’Abitibi-Témiscamingue qui, après le Nord-du-Québec, a le plus faible taux de diplomation après 5 ans (52,6 %) et après 7 ans (67,6 %), mais c’est la région de la Côte-Nord qui se classe au deuxième rang pour ce qui est du taux de décrochage annuel (26,3 %), loin derrière l’Abitibi-Témiscamingue (16,4 %). La région de la Capitale-Nationale (Québec) affiche la meilleure performance sur le plan de la diplomation à 5 ans (67,8 %), mais Chaudière-Appalaches la détrône sur le plan de la diplomation après 7 ans (79,7 %), tandis que c’est la région du Bas-Saint-Laurent qui affiche le plus faible taux de décrochage annuel en 2012-2013 (9,9 %). De même, la performance des municipalités peut varier substantiellement selon l’indicateur pris en compte.

Les cibles sont définies dans les plans de mobilisation et d’action adoptés par les acteurs régionaux, soit les tables de concertation interordres en éducation ainsi que les IRC. La définition de cibles quantitatives est très variable suivant les IRC considérées. Ainsi, aucune cible quantitative n’est présente dans les rapports annuels du CREPAS, alors que le Réseau réussite Montréal (RRM) se contente d’une seule et même cible au fil des ans, et qu’à l’opposé, les cibles sont plurielles et mouvantes dans une région comme l’Estrie.

En 2009, le Réseau réussite Montréal naît de la fusion de la Table des partenaires pour la persévérance scolaire (créée en 2002) et du Carrefour de lutte au décrochage scolaire (créé en 2004). Le rapport annuel 2010-2011 du RRM mentionne une cible seulement pour son plan d’action 2011-2013 : il s’agit d’« atteindre et dépasser la cible ministérielle montréalaise de diplomation des jeunes fixée à 77 % d’ici 2020 » (RRM, 2011 : p.5). Mais, dès le plan d’action subséquent (2011-2012), des cibles ministérielles sont mentionnées pour chacune des cinq commissions scolaires, de 67 % à Pointe-de-l’Île à 88 % à English-Montréal et Lester B. Pearson. En 2014, le réseau annonce qu’il a quasiment atteint sa cible à Montréal, puisque le taux de diplomation avant 20 ans atteint alors 76 % et qu’il a légèrement dépassé sa cible dans la commission scolaire de la Pointe-de-l’Île avec 68 %.

En Estrie, la « Table estrienne de concertation interordres en éducation » (TECIÉ) est formée en 2005, se dotant la même année d’une structure de concertation, soit le Projet PRÉE « Partenaires pour la réussite éducative en Estrie ». Pilotées par la Conférence régionale (CRE) des élus de l’Estrie, deux ententes spécifiques, d’une durée de cinq ans chacune, ont regroupé les partenaires pour assurer la mise en oeuvre des deux plans quinquennaux de mobilisation et d’action. Les cibles définies régionalement sont plurielles, et déterminées en fonction du type de taux (taux de décrochage, diplomation après 5 ans ou diplomation après 7 ans), du genre (garçons versus filles) et du type de réseaux (réseau public versus réseau privé). Par ailleurs, les cibles définies régionalement sont mouvantes car elles varient d’un plan quinquennal à un autre : dans le plan 2006-2011, les indicateurs utilisés sont le taux de décrochage annuel (total et garçons) et le taux de diplomation après 5 ans[13], alors que dans le plan 2011-2016, ce sont seulement des cibles dans le secteur public et les indicateurs sont les taux moyens de décrochage sur 3 ans et le taux de diplomation après 7 ans[14].

Si l’évolution des taux de décrochage est globalement favorable, cela ne se traduit pas forcément en termes de rangs relatifs. Ainsi, il est constaté en 2001 : « En 2006-2007, l’Estrie se classait au 14e rang sur 17 au Québec avec un taux de décrochage scolaire de 33,1 %. La situation se serait améliorée, le taux de décrochage chutant à 23,2 % en 2009-2010. Pour autant, compte tenu des progrès réalisés dans toutes les autres régions, le classement de l’Estrie ne s’est pas amélioré, celle-ci se plaçant même au 15e rang québécois » (CRE de l’Estrie, 2013 : 14). Là encore, l’effet d’ordonnancement s’avère très puissant alors qu’il pourrait être singulièrement pondéré au regard d’un problème d’estimation[15].

La performance comparée des régions en France

À la différence du Québec, les objectifs nationaux de lutte contre le décrochage scolaire ne font pas l’objet d’une déclinaison régionale, et cela, pour deux raisons majeures. D’abord, les circonscriptions d’action de l’Éducation nationale, les académies, correspondent de moins en moins au découpage de la France en régions, collectivités territoriales dont les responsables sont élus au suffrage universel direct et qui se voient transférer des responsabilités croissantes, notamment en matière de formation professionnelle des jeunes et d’orientation scolaire et professionnelle. Avant la réforme de 2015, ce déphasage était une spécificité des seules trois plus grandes régions, l’Île-de-France avec trois académies (Créteil, Paris et Versailles), Rhône-Alpes avec deux académies (Grenoble et Lyon), tout comme Provence-Alpes-Côte d’Azur (Aix-Marseille et Nice). Depuis 2015, seules quatre des treize régions métropolitaines ne comptent qu’une seule académie (Bretagne, Centre-Loire, Corse et Pays de Loire).

Par ailleurs, les projets des académies qui couvrent la période 2013-2017 font tous du recul du décrochage un objectif majeur de leur action. Mais si le diagnostic chiffré est posé à leur échelle, en référence à l’indicateur national issu de la politique européenne, pour l’avenir, aucune cible statistique de cet ordre n’apparaît, publiquement du moins, dans les engagements souscrits. Chaque projet académique affiche sa volonté expresse de mobiliser les dispositifs d’action publique conçus sur le plan national mais oeuvrant sur le plan régional ou local, comme les plates-formes de suivi et d’appui aux décrocheurs, le dispositif d’accès à la qualification (DAQ) et les réseaux FOQUALE (composés d’établissements, de l’inspection, de conseillers d’orientation, des missions de lutte contre le décrochage scolaire) destinés à faciliter l’accès de décrocheurs à des places de formation professionnelle vacantes. Cette configuration s’inscrit clairement dans une logique de territoire au sens de Desrosières, chaque recteur étant chargé de décliner, moyennant un pouvoir d’interprétation non négligeable, les objectifs nationaux de lutte contre le décrochage en s’appuyant sur la mise en oeuvre d’instruments conçus sur le plan ministériel.

S’impose, avant tout, une rhétorique de la mobilisation générale autour de la lutte contre le décrochage scolaire, dont les Semaines de la persévérance scolaire, manifestement inspirées des pratiques québécoises, sont, depuis 2014-2015, le symbole médiatique. Cette mobilisation se nourrit d’une dramatisation appuyée par des statistiques du décrochage déclinées sur le plan académique. C’est notamment le cas dans la publication régulière Géographie de l’École du MEN (dont la dernière livraison, toutefois, remonte à 2014). Deux approches différentes du décrochage y sont développées. La première l’aborde dans le cadre de comparaisons entre académies sur les parcours scolaires en termes de fréquences de scolarisation, de retards scolaires, de poursuite d’études et de niveaux atteints à l’issue de l’enseignement secondaire. Ainsi, en 2010, si 12 % des jeunes âgés de 18 à 24 ans n’avaient pas de diplôme et n’étaient pas inscrits dans un établissement d’enseignement, dans trois académies — Nantes, Lyon et Toulouse —, cet indicateur était inférieur à 10 %, à 8 % à Rennes et à 5 % à Paris, tandis qu’il dépassait 15 % dans les académies d’Amiens, de Corse et des départements d’outre-mer. En désignant les espaces au sein desquels l’urgence de contrer le décrochage est la plus vive, ce classement comparatif établit une convention de priorité pour l’action publique.

La seconde approche prend la forme d’un dossier public qui analyse les disparités territoriales en matière de décrochage, en l’occurrence à l’échelle des 3 689 cantons qui composent la France métropolitaine. Le décrochage scolaire est calculé à partir des données du recensement de la population de 2006, afin de pouvoir concerner ce niveau géographique particulièrement fin. Ce travail, coordonné par Boudesseul (2014) dans le cadre du réseau de centres de recherche associés au Céreq, s’efforce d’identifier les « zones à risques d’échec scolaire » au regard de l’intensité des difficultés économiques, sociales et culturelles, ainsi que des parts de non-diplômés parmi les jeunes de 15 à 24 ans non scolarisés. Avec cet indicateur, la base de calcul est plus étroite que dans l’indicateur européen qui se réfère à la classe d’âge tout entière ; en outre, est retenu l’ensemble des jeunes de 15 à 24 ans et non pas seulement ceux âgés de 18 à 24 ans. Il en résulte des taux de décrocheurs nettement plus élevés qu’avec l’indicateur standard (27 % en moyenne pour la France métropolitaine au recensement de 2006), soit un effet potentiel de dramatisation politique plus puissant. Au total, sont ainsi identifiées six catégories de cantons à risque particulièrement élevé de décrochage : au sein de chaque académie, elles désignent des cibles territoriales privilégiées pour l’action publique. D’ailleurs, un atlas détaille cette approche académie par académie, avec notamment un système de cartes permettant d’identifier d’emblée les « cantons à risque ». D’une certaine manière, cette approche, dont il importera de vérifier qu’elle dépasse le stade de l’expérience pour accéder à celui d’un dispositif institué, rejoint des approches québécoises développées dans la perspective d’une action en faveur de la persévérance scolaire, au plus près des établissements de formation.

L’échelle de l’établissement : Québec versus France

Au Québec, l’action des acteurs régionaux et locaux s’est construite à l’échelle de quartiers ciblés par le degré de vulnérabilité au décrochage des élèves des établissements de leurs ressorts. La statistique de base, qui détermine la sélection des quartiers et, en leur sein, des secteurs dont les écoles sont considérées comme à risque, s’appuie sur des indicateurs variés de défavorisation dont la prise en compte conjointe justifie le choix des cibles[16]. Tous les acteurs s’appuient sur une batterie d’indicateurs distincts, comme l’illustre la stratégie de prévention du RRM, sans cesse affinée depuis sa création.

Afin de pallier le déficit de données nécessaires au calcul de la « défavorisation sociale et matérielle de la population dans le recensement général du Canada (indice « Pampalon »), le RRM s’appuie sur deux indices d’origine provinciale. Il s’agit en premier lieu de l’indice global de défavorisation (IGD). Dans le cas de Montréal, cet indice est établi par le comité de gestion de la taxe scolaire qui prend en compte la résidence des élèves et non pas la localisation de l’école. Il résulte de la composition de quatre indicateurs de base que sont les proportions de familles à faible revenu après impôt, de familles monoparentales dont le chef est une femme, de mères n’ayant aucun diplôme du secondaire ou équivalent, et de familles dont aucun des parents ne travaille à temps plein. Il en ressort un classement des écoles en six niveaux de défavorisation. Intervient également un « indice de milieu socio-économique » (IMSE) qui permet de « refléter le niveau de défavorisation d’un établissement scolaire » en composant deux indicateurs : la proportion de familles avec enfants dont la mère est sans diplôme et la proportion de ménages dont les parents étaient sans emploi au moment du recensement canadien. Les établissements sont répartis sur une échelle comportant dix déciles.

Deux taux propres au système scolaire interviennent également dans le choix des cibles. L’un concerne l’amont de la scolarité : il s’agit du taux de vulnérabilité des enfants de maternelle, calculé à partir de l’instrument de mesure du développement de la petite enfance (IMDE) qui repose sur un questionnaire rempli par l’enseignante de maternelle ou de prématernelle dans le cadre d’une enquête québécoise sur le développement des enfants à la maternelle (EQDEM). Cinq domaines de développement de l’enfant y sont pris en compte : le développement cognitif et langagier ; les habiletés de communication et les connaissances générales ; la santé physique et le bien-être ; les compétences sociales ; la maturité effective. L’autre taux caractérise l’aval et joue évidemment un rôle crucial, puisqu’il s’agit du taux de sorties sans diplôme ni qualification qui permet de faire le lien avec l’échelle régionale.

Cette batterie d’indicateurs et de taux permet donc d’établir un classement de l’ensemble des quartiers, secteurs et écoles, et d’identifier, dans une logique avant tout préventive, les cibles à privilégier en fonction des moyens financiers et humains disponibles. C’est ainsi qu’à terme, le RRM compte intervenir dans 19 quartiers représentant 55 % des décrocheurs potentiels et 89 % des zones à « concentration importante de défavorisation », témoignant ainsi d’une montée en charge progressive du dispositif de prévention. Ce dernier ciblait 6 quartiers en 2009, 9 quartiers en 2011 et 11 quartiers en 2015 concernant 63,7 % des zones à risque. Le classement est donc traduit en action par l’intermédiaire d’une convention de priorité dont la mise en oeuvre par l’instance régionale, RRM, est plus ou moins rigoriste en fonction de la capacité effective d’intervention conditionnée par les ressources disponibles.

On retrouve cette même logique dans les autres régions au Québec, même si les instruments sur lesquels s’appuient les autres IRC sont parfois moins variés et l’analyse moins systématique. Ainsi, dans la Commission scolaire de la Région-de-Sherbrooke (CSRS), c’est l’école secondaire de la Montée qui est ciblée dans la prévention du décrochage scolaire. Pour justifier son action de prévention dans cet établissement, la maison des jeunes responsable du programme « Accès 5 » s’appuie également sur plusieurs indicateurs. Il est d’abord rappelé que le taux de décrochage à l’école secondaire de la Montée est le plus élevé des quatre principales écoles secondaires de la CSRS. Il est ensuite précisé que pour agir en prévention du décrochage, ce sont les trois communautés les plus défavorisées, tant sur le plan matériel que social, qui ont été ciblées, soit les communautés de Saint-Michel, des Jardins-Fleuris et de Saint-Jean-Baptiste. Enfin, il est indiqué que les IMSE de leurs trois écoles primaires (Desjardins, Pie-X-de-l’Assomption et de la Sainte-Famille) sont les plus défavorables.

En France, la prévention s’appuie en premier lieu sur le repérage et la mesure de l’absentéisme scolaire qui « constitue une priorité absolue qui doit mobiliser tous les membres de la communauté éducative » puisque « le droit à l’éducation (…) a pour corollaire le respect de l’obligation d’assiduité, condition première de la réussite scolaire »[17]. C’est d’abord sur le plan de l’établissement que s’établit cette prévention fondée en premier lieu sur le repérage de l’absentéisme, c’est-à-dire sur l’enregistrement des absences des élèves qui, dans le secondaire, s’effectue avec l’application « Vie scolaire » fournie par les services informatiques de l’éducation nationale. La statistique qui en ressort doit être analysée « dans chaque école et établissement, les taux d’absentéisme [étant] suivis classe par classe et niveau par niveau », sachant que le conseil d’établissement « doit présenter une fois par an un rapport d’information sur l’absentéisme scolaire » (circulaire ibid.). Alors que la stratégie québécoise consiste à établir à l’échelle du Québec un taux de défavorisation pour tous les établissements publics en fonction d’une analyse des facteurs de risque, on privilégie ici un décompte des manquements individuels relativement à la norme d’assiduité scolaire, signes précurseurs jugés cruciaux des risques de décrochage. Dans le cadre du plan national de lutte contre le décrochage scolaire, l’absentéisme devient l’une des préoccupations majeures du groupe de prévention du décrochage scolaire (GPDS) que chaque établissement doit mettre en place et qui de facto donne lieu à des mises en oeuvre fortement variables (Maillard et al., 2016).

Dans les deux contextes, le travail statistique contribue à produire une dramatisation des situations en cause, légitimant des modalités d’intervention, l’une et l’autre conçues à d’autres échelles, régionale au Québec, nationale et académique en France ; elles s’inscrivent donc dans une logique décroissante de territoire, au sens de Desrosières. Au Québec, une convention de priorité justifie la sélection de cibles privilégiées constituées des écoles de zones exposées à la défavorisation en vue de développer une action publique multidimensionnelle. Joue ainsi un puissant effet d’ordonnancement, éminemment variable, puisque le seuil d’accès à l’aide varie en fonction des ressources disponibles. Côté français, les cibles sont d’abord des individus avant d’être des entités collectives. La quantification vise à amener les responsables d’établissements à repérer puis à cadrer les comportements individuels dérogeant à la norme d’assiduité scolaire et dont l’agrégation a un sens sur le plan de l’établissement en cause dans un rapport annuel sur l’absentéisme que doit rédiger le chef d’établissement. Les ressources dont dispose un chef d’établissement varient en fonction du classement ou non de son école, de son collège ou de son lycée en zone prioritaire d’éducation. Cette caractérisation relève d’une autre politique que celle de la lutte contre le décrochage : elle a trait à la lutte contre les inégalités à l’école, qu’elles soient liées au fonctionnement du système éducatif et à des causes externes, telles que la ségrégation urbaine.

Conclusion

En somme, la quantification du décrochage scolaire doit faire face à une double tension, liée d’une part à la montée des régulations supranationales et d’autre part, à la nécessité de se doter de statistiques fiables sur le plan local et régional pour déconcentrer l’action publique. Cependant, cette double tension ne semble pas s’être traduite de la même manière en France et au Québec.

En France, l’analyse révèle surtout deux instruments de référence de l’action publique contre le décrochage scolaire, le premier induit par la régulation européenne et le second exigé par la déconcentration de l’action publique. L’action de l’UE a conduit à construire des indicateurs descriptifs, mais aussi des cibles, dans une logique de bench-marking. À l’échelle supranationale, l’instrument demeure la part des jeunes de 18 à 24 ans qui, au minimum, n’ont pas obtenu de CAP ou BEP ou équivalent, soit l’indicateur des sortants précoces mis en place dans le cadre de la stratégie de Lisbonne (devenue « Stratégie 2020). Mais à l’échelle territoriale (académique), en matière de raccrochage, c’est le système interministériel d’échange d’informations (SIEI) qui sert d’instrument-phare. Cependant l’action publique est absorbée par l’exigence du nombre de « vrais décrocheurs ».

Au Québec, ce sont surtout le taux de décrochage annuel et les taux de diplomation et de qualification après 5 ans et 7 ans qui sont mobilisés comme instruments et cibles de l’action publique. Cela traduit d’abord une absence de régulation supra-provinciale. Le Conseil des ministres de l’Éducation du Canada contribue bien avec Statistique Canada à construire des indicateurs comparatifs entre les provinces, mais aussi entre le Canada et d’autres pays. Ainsi, de nombreux indicateurs sont calculés pour comparer le Québec aux autres provinces et aux autres pays de l’OCDE, mais tout se passe comme si ces indicateurs, n’étant pas utilisés comme instruments de l’action publique, sont produits avant tout pour remplir les obligations du Canada en matière de production des statistiques internationales. Cela traduit aussi au Québec la volonté de déconcentrer l’action sur le plan des écoles, des commissions scolaires et par région administrative. De fait, les taux de diplomation ont été conçus pour permettre aux commissions scolaires de se comparer et d’effectuer leur reddition de comptes.

Les différences sont encore plus nettes en matière de prévention du décrochage. À partir de taux témoignant « dramatiquement » de risques de décrochage, la quantification a pour but de légitimer des cibles pour l’action publique : au Québec, des écoles et des jeunes exposés à la défavorisation sociale, économique et éducative ; en France, des individus dont le degré d’absentéisme témoigne d’une possible rupture relativement à la norme d’assiduité scolaire que l’établissement doit alors prendre en charge en mobilisant des outils et des ressources conçus nationalement.

Dans les deux cas cependant, la priorité en matière de quantification du décrochage scolaire semble s’être déplacée au cours du temps d’une priorité donnée à la comparaison interétatique, dont le poids est variable selon les sociétés, vers une priorité donnée à l’estimation de fréquences et d’effectifs régionaux ou locaux en vue de mobiliser et d’outiller les acteurs infraétatiques. Ce changement de priorité se manifeste en France par la création du SIEI en 2010, et au Québec par la décision prise en 2012 de privilégier des sorties sans diplôme ni qualification du secondaire plutôt que l’indicateur de décrochage à un âge donné. Notons qu’au Québec, il s’agit moins d’un changement de priorité que de l’approfondissement d’une tendance plus précoce et prononcée à la déconcentration : l’action régionale était envisagée dès 1992 au moment de la publication du premier plan d’action pour contrer le décrochage, L’école, chacun son devoir ; et la méthode de calcul des taux de diplomation après 5 ou 7 ans permettant de comparer les écoles, les régions et les commissions scolaires a été conçue dès 1991.

Sur le plan des effets de perspective, on peut conclure en soulignant le rôle politique de la variété des définitions (des mises en équivalence), des indicateurs (des mises en pourcentage), et des échelles d’ordonnancement et de seuils de comparaison : ils fournissent in fine des répertoires rhétoriques aux acteurs nationaux et régionaux qu’ils mobilisent tantôt pour accréditer l’urgence d’agir tantôt pour démontrer l’efficacité de l’action.

Les mises en équivalence des décrocheurs créent un effet de réalisme alors que les définitions changent au cours du temps. En France, la baisse du décrochage, calculé à partir des enquêtes emploi de l’Insee, est en partie due à un changement dans la méthode de l’enquête, des questions sur la participation à des formations formelles ou non formelles ayant en effet été ajoutées au questionnaire. Au Québec, ces changements sont surtout reliés à l’ajout en 2007 de nouvelles qualifications reconnues par le ministère de l’Éducation et de l’Enseignement supérieur qui a eu un impact à la baisse sur l’évolution du nombre de décrocheurs. Alors que le retrait des qualifications contribue à aider le GAPRS à dramatiser la situation, leur intégration dans les statistiques du MELS crée l’illusion d’une croissance du nombre de diplômés.

Les mises en pourcentage créent des effets d’abstraction et masquent de cette façon d’importantes différences. Ainsi, tandis que le taux de décrochage au Québec se rapporte à l’ensemble des sortants de la formation générale au secteur des jeunes, ce qui inclut également les déscolarisés, les définitions françaises conduisent à exclure les 15 ans et moins de la population de référence et ainsi séparent la problématique de la déscolarisation de celle du décrochage. Par ailleurs, le choix d’une base de calcul plus étroite peut contribuer à dramatiser le problème du décrochage comme c’est le cas de l’indicateur de l’Atlas géographique en France, rapportant les non-diplômés aux jeunes non scolarisés seulement.

Enfin, les effets d’ordonnancement et de seuil contribuent eux aussi à la dramatisation politique du problème du décrochage scolaire. Concernant la France, on peut mettre l’accent sur sa place relativement médiocre ou, au contraire, sur le fait que la France a déjà atteint l’objectif qui lui était initialement fixé. Alors que le Québec affiche le meilleur score sur le plan du taux net d’obtention du diplôme, il affiche également le moins bon score au sein des provinces sur le plan de l’achèvement dans les délais prescrits. Sur le plan régional, si toutes les régions peuvent démontrer l’efficacité des efforts de mobilisation en mettant en avant le fait que les objectifs sont atteints ou dépassés, certaines régions tendent aussi à insister sur leur classement relativement médiocre, surtout lorsqu’il s’agit de justifier l’octroi de plus grandes ressources. En somme, pour les comparaisons tant interprovinciales qu’internationales, les effets d’ordonnancement ne cessent donc de varier selon l’indicateur privilégié en vue de justifier une orientation politique destinée, de manière plus ou moins explicite, à mobiliser les parties prenantes dans cette lutte contre le décrochage.

Appendices

Annexe

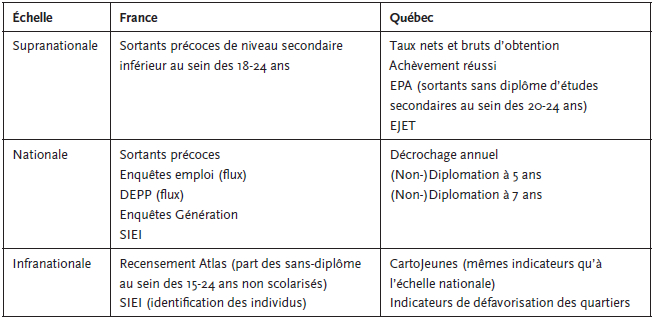

Annexe 1. Tableau synthétique des indicateurs

Notes

-

[1]

Ce travail a bénéficié du soutien de la coopération France-Québec (65e session de la commission permanente de coopération franco-québécoise (CPCFQ), Biennum 2015-2016), du programme de recherche « Territoires et décrochage scolaire », coordonné par Pierre-Yves Bernard et financé par l’Agence nationale de la recherche (ANR) et de subventions de recherche du Conseil de recherches en sciences humaines du Canada (CRSHC) et du Fonds de recherche Québec — Société et culture (FRQSC)

-

[2]

Le qualificatif de national se justifie d’autant plus dans le cas du Québec que l’éducation relève d’une compétence provinciale, même si le fédéral n’est pas absent du jeu, tout comme l’Union européenne qui, sans disposer d’un pouvoir de décision et encore moins de prescription en la matière, tente d’influencer les politiques des États membres, dont la France, en s’appuyant sur la méthode ouverte de coordination (voir infra). Comme de part et d’autre de l’Atlantique, s’est fait jour un processus de régionalisation, trois niveaux de régulation sont donc bien présents dans les deux contextes sociétaux, comme en témoignent d’intenses jeux d’échelle que cet article s’efforce d’analyser. En outre, la comparaison entre le France et le Québec se justifie également par le fait que l’action publique française s’est inspirée de certaines catégorisations québécoises — la notion de décrochage au premier chef qui supplante progressivement celle d’« échec scolaire » — comme de certaines des pratiques de cette province canadienne, telles que « les semaines de la persévérance scolaire », introduites en France dans les années 2010.

-

[3]

Au Québec, la lutte contre le décrochage scolaire dans l’enseignement collégial est devenue une priorité l’année suivante et presque dix ans plus tard sur le plan universitaire.

-

[4]

Le maximum étant la note A.

-

[5]

Certificat d’aptitude professionnelle.

-

[6]

Brevet d’études professionnelles.

-

[7]

Les jeunes ayant abandonné l’école avant l’âge limite de la fréquentation scolaire obligatoire.

-

[8]

Le SIEI repère les jeunes décrocheurs en dressant des listes de jeunes de plus de 16 ans ayant abandonné leur formation avant d’avoir obtenu le diplôme de l’enseignement secondaire visé et qui ne sont pas réinscrits dans un établissement public ou privé sous contrat, relevant du ministère de l’Éducation nationale ou du ministère de l’Agriculture, ni dans un centre de formation d’apprentis (CFA).

-

[9]

La circulaire ministérielle qui instaure ces plates-formes souligne que « le dispositif gagne à associer à son fonctionnement les acteurs suivants : « Éducation au sens élargi (réseaux FOQUALE, personnels de la MLDS chefs d’établissement, animateurs de district et coordinateurs de bassin de formation, etc. (…)), Emploi et Formation professionnelle (mission locale pour les jeunes, Direction régionale du ministère, Pôle Emploi, organismes de formation, etc.), sous-préfet d’arrondissement et délégué du préfet, Santé / Social (assistants de service social, représentants d’associations, etc.). » Cette mobilisation est évidemment variable selon les bassins.

-

[10]

Il est symptomatique qu’un récent article sur le rôle des caractéristiques des établissements dans le décrochage scolaire et prenant l’exemple de l’académie d’Aix-Marseille (Khouaja et Moullet, 2016) ait renoncé à utiliser les données du SIEI pour privilégier une base de données ad hoc permettant de « répondre aux besoins de cette recherche » (Khouaja et Moullet, 2016 : 11).

-

[11]

« Entre juin 2011 et octobre 2011, il y a exactement 223 000 jeunes qui sont sortis du système éducatif, 223 000 jeunes qui sont sortis sans diplôme », déclare Luc Chatel, ministre de l’Éducation nationale, de la Jeunesse et de la Vie associative, invité du « Grand Jury RTL, LCI, Le Figaro », et le dimanche 13 novembre 2011. « En 2010, entre juin et septembre, le nombre de jeunes “décrocheurs” s’élevait à 306 000. » Citations rapportées dans « Les déchiffreurs de l’éducation » (2012).

- [12]

-

[13]

Dans le plan quinquennal de mobilisation et d’action 2006-2011, les 3 cibles à atteindre d’ici 2011 sont les suivantes : « 1) Une réduction de 20 % du nombre de jeunes qui quittent annuellement l’école secondaire sans qualification ni diplôme, soit passer d’un taux de décrochage de 34 % à 27 % ; 2) Une réduction de 20 % du nombre de garçons qui décrochent annuellement, de 46 % à 36,8 % ; 3) Une hausse du taux de qualification ou de diplomation de 50 % à 55 % après cinq ans de scolarisation au secondaire » (TABLE estrienne de concertation interordres en éducation, 2008, p.3).

-

[14]

Dans le plan quinquennal de mobilisation et d’action 2011-2016, les 4 cibles à atteindre d’ici 2016 sont les suivantes : « 1) Réduire de 4 points de pourcentage le taux moyen sur trois ans des sorties sans diplôme ni qualification, pour le réseau public, soit passer d’un taux de décrochage de 25,5 % à 21,5 % ; 2) Réduire de 5 points de pourcentage le taux moyen sur trois ans des sorties sans diplôme ni qualification des garçons, pour le réseau public, soit passer d’un taux de décrochage de 32,2 % à 27,2 % ; 3) Réduire de 3 points de pourcentage le taux moyen sur trois ans des sorties sans diplôme ni qualification des filles, pour le réseau public, soit passer d’un taux de décrochage de 18,6 % à 15,6 % ; 4) Hausser de 9,5 points de pourcentage le taux de diplomation et qualification après 7 ans, pour le réseau public, soit passer d’un taux de 67,5 % à 77 % ». http://www.reussiteeducativeestrie.ca/dynamiques/A_propos/CiblesPREE_2011-2016.pdf

-

[15]

Ce dernier est, entre autres, lié à la « disparition » des élèves québécois qui poursuivent leurs études aux États-Unis (ou dans un autre pays) ou dans la province voisine de l’Ontario. Ce problème se pose de manière particulièrement aiguë dans le cas des régions frontalières, en particulier dans la région de l’Outaouais, car de nombreux jeunes suivent leurs études à Ottawa. Ainsi, l’estimation des taux de décrochage en Estrie est majorée : « les données de la ligne Estrie privée incluent celles des écoles privées internationales de l’Estrie telles que Stanstead College et Bishop’s College Secondary. Cela majore le taux compte tenu qu’une partie de leur clientèle quitte le Québec en cours de scolarisation » (Table estrienne : 31). Sur le plan local, les données de taux de décrochage sur le plan de la MRC de Memphrémagog (ou de la municipalité de Stanstead) doivent être corrigées pour tenir compte des déménagements aux États-Unis.

-

[16]

Ces indices ont été créés afin d’allouer de manière équitable les budgets associés à une autre politique éducative, Agir Autrement, du ministère de l’Éducation du Québec.

-

[17]

Circulaire interministérielle relative à la prévention de l’absentéisme scolaire n° 2014-159 du 24-12-2014.

Bibliographie

- Bernard, P.-Y. (2011), Le décrochage scolaire, Coll. « Que sais-je ? », Paris, PUF.