Abstracts

Résumé

Malgré les différences paradigmatiques significatives entre méthodes qualitative et quantitative, les deux approches demeurent confrontées à la réduction et à la restauration de la complexité et partagent un fond commun d’opérations de recherche : identification des unités, description, exploration et analyse. Les sciences sociales ayant une vocation herméneutique, il importe de ne pas opposer interprétation et explication. Loin de s’opposer, ces deux processus interagissent dans l’élaboration d’une compréhension de l’objet. L’interprétation ne peut être réduite au sens donné aux résultats ou à la compréhension globale au terme de la recherche. Il existe divers actes herméneutiques adoptant des formes différentes et se logeant aux différentes étapes du processus de recherche aussi bien dans le qualitatif que dans le quantitatif. Une démarche mixte qui combine les attributs du quantitatif et du qualitatif est susceptible de dépasser l’opposition entre le raisonnement inductif et le raisonnement déductif en adoptant la forme abductive favorisant ainsi la découverte.

Mots-clés :

- Complexité,

- explication,

- interprétation,

- méthodes mixtes,

- sérendipité

Article body

Introduction

Sans revenir au dualisme méthodologique de Dilthey (1947) opposant le projet d’explication des sciences naturelles et celui de compréhension des sciences de l’esprit, il convient de distinguer la vocation herméneutique des sciences sociales en opposition à la perspective nomologique des sciences de la nature. Nous entendons la vocation herméneutique comme voie d’accès privilégiée à la connaissance du social. Le social se caractérise ultimement par sa capacité réflexive, c’est-à-dire son autoreprésentation. Les sciences sociales n’ont d’autres moyens de connaître le social que par une représentation dédoublée de cette autoréflexion. Giddens (1987) parle à ce sujet d’une double herméneutique. Cependant, cela ne saurait signifier que le chercheur n’a qu’à produire, par la voie d’une appropriation pour-soi de l’objet à l’étude, un commentaire sur le commentaire. On a trop souvent tendance à représenter l’herméneutique comme pratique de l’interprétation immédiate. Au contraire, cette dimension herméneutique des sciences sociales n’exclut en rien les procédures explicatives. Ricoeur (1986) a montré magistralement que la compréhension ne peut être confondue avec l’interprétation et que cette dernière, tout comme l’explication, forme un arc herméneutique allant de l’objet à connaître vers sa compréhension. Weber (1978) n’utilise-t-il pas le terme explication compréhensive pour définir sa méthode? Il signifie par là qu’il est possible de combiner explication des événements et compréhension du sens. Si les sciences sociales se prêtent mal à l’expérimentation comme voie de validation de la causalité, elles peuvent s’en approcher en construisant des protocoles empiriques définissant des unités d’observation, un système de catégorisation, l’établissement de relations et de comparaisons empiriques, en somme en adoptant une approche quasi nomologique.

Rappeler la vocation herméneutique des sciences sociales conduit souvent à distinguer les approches méthodologiques, en opposant le qualitatif (Qual) et le quantitatif (Quan). Nous soumettons que cette opposition, si elle est fondée sur des différences de points de vue concernant la nature des objets, la démarche et les opérations, n’est ni fondée épistémologiquement ni utile sur le plan de la recherche (Duchastel & Laberge, 2014). Certes il n’est pas inutile de se référer à la posture ontologique, épistémologique et méthodologique des chercheurs pour discriminer les démarches de recherche. Mais les dimensions qualitative ou quantitative de cette démarche dépendent avant tout de la nature de l’objet et des données plutôt que d’un quelconque credo analytique. De plus, un même projet de recherche peut combiner les approches qualitative et quantitative en fonction des diverses dimensions et des données disponibles.

Pourtant les écrits abondent dans la description de ce contraste entre quantitatif et qualitatif. Évoquons sommairement ces caractérisations des méthodes formulées sur les plans de l’épistémologie, de la démarche méthodologique et des opérations de recherche. Sur le plan épistémologique, on distingue les approches quantitative et qualitative en opposant respectivement objectivité et subjectivité, distanciation et empathie, lois universelles et situations contextuelles, généralisation et unicité, validité et crédibilité/transférabilité, neutralité et engagement axiologique. Sur le plan de la démarche, on propose un même système d’oppositions entre réduction et complexité, déduction et induction/abduction, analyse en largeur (thin analysis) et analyse en profondeur (thick analysis). Enfin sur le plan des opérations, les variables sont opposées aux actions intentionnelles, la mesure au processus, les tests statistiques à l’exploration, les relations causales au sens. On ne peut nier que ces oppositions existent et caractérisent jusqu’à un certain point des traditions de recherche différentes. Néanmoins, nous doutons qu’elles déterminent de manière absolue le tracé des différentes recherches concrètes. D’une part, ce jeu d’oppositions a tendance à caricaturer la position adverse. S’intéresser aux subjectivités n’exclut pas entièrement toute mesure d’objectivité. Réduire la complexité n’équivaut pas à nier cette dernière. Les tests statistiques ne s’opposent pas en soi aux processus exploratoires. Les relations causales (ou quasi causales) ne récusent pas toute dimension sémantique. D’autre part, la question de recherche, sa problématisation et les données produites déterminent en eux-mêmes le choix des moyens pour l’analyse.

Plutôt que de nous en tenir à ce tableau des oppositions, nous entendons formuler quatre questionnements qui s’emboîtent les uns les autres. Le premier concerne la posture ontologique défendue dans les sciences sociales. Après avoir dressé un tableau de ces postures vis-à-vis quatre questions concernant le statut accordé à la réalité, à l’objectivité, à la vérité et à la cumulativité, nous définirons notre propre posture concordataire, ce qui permettra d’éclairer la suite de notre raisonnement. La seconde interrogation concerne le traitement de la complexité en recherche. Il nous semble que ce problème synthétise le coeur du conflit apparent entre qualitatif et quantitatif. Nous défendrons l’idée que la réduction de la complexité est inévitable dans tout processus de recherche et que les diverses opérations de recherche peuvent aussi bien réduire que restaurer cette complexité dans le déroulement même du processus de recherche. La troisième interrogation porte sur le problème de l’interprétation. Nous avons déjà affirmé la vocation herméneutique des sciences sociales. Il nous revient maintenant de voir en quoi l’interprétation ne s’oppose pas nécessairement à l’explication et de distinguer les diverses formes d’interprétations logées aux diverses étapes du processus de recherche. La quatrième interrogation porte sur la capacité de découverte (sérendipité). Alors que l’on attribue habituellement le raisonnement déductif au quantitatif et le raisonnement inductif au qualitatif, il devient intéressant de voir en quoi une troisième forme de raisonnement (abductif) peut se loger dans une démarche mixte qui combine les attributs du quantitatif et du qualitatif.

Postures ontologiques en sciences sociales

L’ensemble de notre argumentaire ne peut se concevoir dans le cadre d’un positivisme radical ni dans celui d’un constructivisme tout aussi radical qui rendraient tout rapprochement entre qualitatif et quantitatif improbable. Cela nous impose de faire un détour par la carte qu’ont pu dessiner certains auteurs à partir de questions ontologiques fondamentales. Cette présentation nous permettra de montrer une certaine convergence entre les diverses réponses apportées à ces questions et de délimiter un espace commun désigné sous diverses appellations : post-positivisme, théorie critique, constructivisme réaliste ou concordat.

Nous partons de notre propre contribution (Duchastel, & Laberge, 1999b) pour la définition de ces postures, ainsi que de celles de Guba et Lincoln (1994) et d’Oliver de Sardan (2008)[1]. L’idée de départ est que le chercheur doit répondre à quatre questions ontologiques : qu’en est-il de la réalité, de l’objectivité, de la vérité et de la cumulativité? Les réponses à ces questions peuvent être regroupées selon plusieurs paradigmes. Guba et Lincoln en déterminent quatre : le positivisme, le post-positivisme, la théorie critique et le constructivisme. Olivier de Sardan en définit trois : le positivisme, le constructionnisme réaliste et le post-modernisme. Quant à nous, nous en retenons trois : le réalisme néo-positiviste, l’approche concordataire et le post-modernisme. Ces typologies n’ont pas été construites selon les mêmes principes, mais on peut sans difficulté en extirper des réponses aux questions formulées. La première question est celle de la réalité : quel est le régime d’existence prêté à la réalité? La position constructiviste radicale, manifestée dans le paradigme constructiviste ou postmoderniste, insiste sur le caractère construit de la réalité, localement et spécifiquement, ce qui entraîne un relativisme plus ou moins radical selon Guba et Lincoln, un anarchisme épistémologique selon Oliver de Sardan, une non-indépendance de la connaissance selon nous. Au contraire, le paradigme positiviste postule cette indépendance de la réalité. La réalité est censée exister en dehors de toute appréhension. Le paradigme intermédiaire, différemment nommé post-positiviste, critique, constructionniste-réaliste ou concordataire, parle d’une réalité « réelle » appréhendée approximativement, d’une réalité « virtuelle » influencée par le contexte spatio-temporel (Guba et Lincoln), d’une existence factuelle interprétée (Duchastel et Laberge), d’un réel de référence connaissable par l’enquête (Olivier de Sardan).

La seconde question interroge la possibilité d’une démarche objective. Pour les constructivistes, la connaissance produite est de nature transactionnelle et subjective (Guba et Lincoln), interprétative (Olivier de Sardan), relative à un schéma conceptuel (Duchastel et Laberge). Pour les positivistes, elle est fondée sur le dualisme sujet de connaissance/objet de connaissance et l’objectivisme (Guba et Lincoln), sur l’établissement de lois (Olivier de Sardan), sur la transparence et la complétude (Duchastel et Laberge). Dans le paradigme intermédiaire, la réponse oscille entre un dualisme modifié doublé d’une forme d’objectivisme et une approche transactionnelle appuyée sur le subjectivisme (Guba et Lincoln), ou elle prend la forme d’une double relation entre le réel de référence et les données produites et entre ces dernières et les énoncés interprétatifs (Olivier de Sardan), ou encore elle combine explication et interprétation (Duchastel et Laberge).

La troisième question concerne le rapport à la vérité. Le paradigme postmoderniste considère que la vérité n’existe pas (Duchastel et Laberge), que n’existent que des résultats construits (Guba et Lincoln) alors que le paradigme positiviste croit à la vérité des résultats (Guba et Lincoln) ou à la vérité tout court (Duchastel et Laberge). Dans le paradigme post-positiviste, il existerait une vérité probable et, dans la pensée critique, des résultats fondés sur des valeurs (Guba et Lincoln). Pour ce qui est du constructionnisme réaliste ou de l’approche concordataire, il y aurait une véridicité, « une forme particulière que prend la vérité dans l’exemplification empirique d’une proposition sociologique » (emprunté à Passeron, 1994, par Olivier de Sardan, 2008, p. 266), ou l’existence d’un « plan de vérité » (en référence à Foucault, 1971, chez Duchastel et Laberge, 1999b, p. 66).

La question de la cumulativité ne reçoit pas une réponse directe chez tous les auteurs. Guba et Lincoln s’emploient plutôt à caractériser la présence ou l’absence de méthodes expérimentales dans l’ensemble des courants. Celles-ci caractérisent le paradigme positiviste qui est fondé sur la vérification d’hypothèses et sur la mesure. Mais elle est aussi présente dans le paradigme post-positiviste dont les multiples méthodes s’appuient cette fois sur la falsification des hypothèses et sur une approche qualitative. Par contraste, ni la théorie critique ni le constructionnisme ne mobilisent l’expérimentation, privilégiant une approche dialectique fondée pour la première sur la dialectique, pour le second sur l’herméneutique. Olivier de Sardan (2008) propose, en guise de substitution au terme falsification, celui de quasi-réfutabilité propre à valider les propositions interprétatives. Il trace ainsi un axe allant du plus au moins réfutable, comme « mise en question empiriquement fondée de l’adéquation empirique d’un énoncé socioanthropologique » (p. 268). On peut déduire de ce qui précède que seule l’approche positiviste est susceptible d’établir la commensurabilité des phénomènes et ainsi permettre une certaine cumulativité des résultats d’analyse. Par opposition, les résultats produits par la démarche constructionniste ne peuvent en aucun cas être commensurables et, par conséquent, cumulables. On trouve, de nouveau, dans la position intermédiaire une position concordataire. Le caractère quasi expérimental des méthodes qualitatives permet la comparaison interne ou externe, ce qui présuppose une certaine commensurabilité. Nous affirmions, pour notre part, que ce modèle permet l’application de la mesure aux phénomènes qualitatifs (Duchastel & Laberge, 2011). Ce sont ces propriétés de la méthode, la comparaison et la mesure, qui permettent de penser une certaine cumulativité de la connaissance des objets sociaux.

Pour résumer, il nous semble important de renoncer à l’opposition entre positivisme radical et constructivisme radical. La position intermédiaire, quelle qu’en soit la désignation (post-positiviste, critique, constructivisme réaliste ou concordataire), est la plus appropriée pour penser le rapport de connaissance entre les sciences sociales et leur objet. On peut ainsi accorder à la réalité une présomption d’existence indépendante de toute construction ultérieure; on peut permettre l’élaboration d’opérations d’établissement des données, de spécification, de catégorisation, d’exploration et d’analyse, impliquant une mise à distance relative du chercheur par rapport à son objet; on peut faire l’hypothèse d’une approximation progressive d’un plan de vérité, conçu comme socle explicite d’intelligibilité; on peut espérer développer une approche idéaltypique appuyée sur la capacité d’établir des écarts aux modèles proposés sur la base d’une certaine commensurabilité et d’une certaine comparabilité. C’est la position que nous adopterons dans les développements ultérieurs.

Réduction et restauration de la complexité

Un des arguments centraux de la querelle Qual/Quan réside dans l’opposition entre réduction et complexité. La visée première du qualitatif étant de nature compréhensive, c’est-à-dire visant l’appréhension en profondeur des phénomènes par l’appropriation pour soi de leur signification, toute réduction du phénomène à certaines de ses dimensions apparaît compromettre cette visée compréhensive. Par contraste, la quantification suppose une réduction de la complexité par une décomposition des phénomènes dans leurs diverses dimensions ou propriétés, susceptible de permettre ultimement leur mesure. L’approche qualitative favorisera la singularité ou, tout au moins, un nombre limité de cas qui seront traités avec plus ou moins de profondeur. L’approche quantitative visera un grand nombre de cas, traitant en largeur un nombre limité de dimensions. Les deux logiques peuvent être opposées en regard de la nature même de la validation des connaissances ainsi produites. Dans la première, on fait valoir la cohérence interne d’un phénomène dont toutes les dimensions sont explorées. Dans la seconde, c’est par addition des tendances se manifestant dans un grand nombre d’occurrences que l’attestation des résultats devient possible.

Cependant, si l’on accepte que le qualitatif ne consiste pas simplement à apposer sur un objet du monde une interprétation; si l’on considère que la connaissance scientifique ne peut être réduite à la connaissance ordinaire dont les schèmes de précompréhension suffisent à traiter l’information qui provient de la réalité ambiante, alors, il faut admettre que la démarche de connaissance scientifique, qu’elle soit Qual ou Quan, se décompose en un ensemble d’opérations de découpage, de description, d’exploration et d’analyse. Il est même rare qu’aucun raisonnement de nature arithmétique ne soit investi dans la description des données. Dire « il y a plus ou moins », « un plus grand nombre », « plus ou moins souvent », « de manière habituelle », implique toujours un raisonnement quasi métrique. Ce qui rapproche les méthodes, c’est l’empiricité ou la matérialité des données analysées. Nous rappelons au point de départ la conception de Olivier de Sardan (2008) concernant les deux principes de l’analyse socioanthropologique, l’empiricité et la véridicité. Le premier implique qu’il n’y a pas d’interprétation valable qui ne repose sur un « réel de référence », c’est-à-dire un réel qui n’est pas un pur construit. Deux liens doivent alors s’établir entre le réel et l’interprétation. Le premier est un lien de représentation entre le réel de référence et les données produites à l’aide de procédures. On pourrait parler ici du moment empirique d’établissement des données. Il y a donc nécessairement des procédures conduisant du réel à sa représentation dans des données, donc un choix, un découpage, une réduction contrôlée. Le deuxième lien est celui qui va des données construites vers les interprétations. Ce lien relève de l’attestation et de l’argumentation, la seconde étant fondée sur la première. On peut parler ici du moment théorique ou herméneutique d’interprétation des données. Enfin, le deuxième principe, la véridicité, est alors la forme de vérité fondée sur la relation d’exemplification empirique d’une proposition interprétative, plus ou moins théorique.

Nous insistons, pour notre part, sur la matérialité des données construites dans le processus de la recherche. Cette idée de matérialité renvoie à deux choses principalement. D’une part, cela signifie que la réalité existe matériellement, qu’il s’agisse d’institutions, de conduites, de représentations symboliques ou idéologiques. La réalité ne peut être conçue comme pure idéalité qui pourrait se refléter dans une seconde idéalité herméneutique. La matérialité implique l’existence d’un ensemble de couches successives prenant des formes matérielles : la langue, l’écriture, la codification, les normes, les règles, les rôles, les institutions, les formes de production, le pouvoir, la culture sont autant d’exemples de la matérialité du social. D’autre part, la matérialité implique que c’est à travers elle que le social devient lisible. Les sciences sociales doivent s’arrêter aux manifestations matérielles de la réalité. Comme le propose Foucault (1969), elles ne peuvent éviter une démarche archéologique. Plutôt que de partir de concepts relevant de l’histoire des idées, comme celui d’oeuvre, d’auteur, d’idéologie, il faut partir des énoncés comme événements et reconstruire leur régime d’existence, les règles de leur formation. La même idée est mise de l’avant par Ricoeur qui propose « l’occultation du monde circonstanciel par le quasi-monde des textes » (1986, p. 141), invitant les chercheurs à faire abstraction d’un ensemble de dimensions de la complexité du monde pour se concentrer sur la matérialité textuelle. Molino (1989) propose également d’accéder au sens par l’intermédiaire des traces laissées par le texte.

À l’instar d’Olivier de Sardan, nous pensons que des propositions analytiques ou interprétatives sont conditionnelles à l’établissement de données à travers des procédures. Par contre, nous poursuivons cette idée en suggérant que ces procédures ne se limitent pas à l’établissement des données, mais qu’elles constituent une chaîne d’opérations prenant en charge la matérialité des données tout au long du processus de recherche. Ces opérations sont autant d’étapes dans la réduction de la complexité des phénomènes étudiés, mais paradoxalement elles peuvent conduire également à une restauration progressive de la complexité au terme du processus.

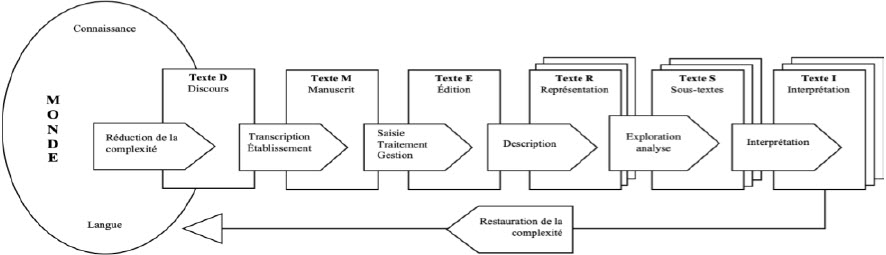

Afin d’illustrer ce double processus de réduction et de restauration de la complexité, nous proposons la Figure 1[2] montrant les diverses étapes de réduction et de restauration de la complexité dans le cas d’une analyse de discours[3]. On pourrait reprendre un tel schéma pour décrire d’autres types de matériaux pouvant faire l’objet d’analyse. Nous choisissons de nous en tenir à la catégorie large d’analyse du discours parce qu’elle est abondamment utilisée dans le domaine de l’analyse qualitative et parce qu’elle nous évite de complexifier un schéma déjà compliqué.

Figure 1

Les formes du texte, restauration de la complexité

Toute analyse du discours porte sur un discours dans le monde qui est caractérisé par des conditions de production/énonciation, usant du langage et témoignant d’un certain savoir. Ce discours, qu’il soit le produit de la parole en situation d’interlocution ou le résultat d’un processus d’écriture dans l’institution, est un objet complexe. Il exprime et produit à la fois les rapports sociaux dans un contexte déterminé. Cet environnement du discours constitue ce que nous appelons la complexité en tant qu’entrelacement d’un grand nombre de dimensions. Le chercheur espère donner un sens à la structure ou à l’action qui la constitue en tant que complexité. Il ne peut le faire qu’à condition de « suspendre le monde » du discours en le restituant en tant que matérialité textuelle. Il doit isoler méthodiquement le texte de son lieu d’émergence. Pour que ce travail méthodique puisse être accompli, le chercheur doit suspendre pour un temps l’existence des conditions de possibilités du discours sans pour autant les oublier. Il doit se saisir du texte/discours, tel qu’il apparaît dans son contexte social et le transcrire. Cette transcription sera littérale s’il s’agit d’un discours oral. Le chercheur devra s’appuyer sur des conventions de transcription pour rendre au plus près la texture du discours parlé. Il devra accepter de considérer ce texte écrit, comportant plus ou moins de traces de la situation d’interlocution, comme étant le dépôt d’une parole extirpée de son contexte. Dans le cas de discours écrits, en particulier si la saisie est informatisée, le chercheur en normalisera l’écriture afin d’effacer les scories non signifiantes et de rendre les diverses parties du discours comparables les unes aux autres. Cette transcription du texte/discours produira le texte/manuscrit, les données analysables. Ce premier pas constitue la première étape de l’établissement des données.

Une seconde étape d’établissement des données consiste à éditer le texte, c’est-à-dire à marquer les diverses conditions de production/énonciation et les éléments de sa structure. Dans le premier cas, il s’agit d’établir les métadonnées, c’est-à-dire les conditions de sa production (lieu, temps, situation) et de son énonciation (locuteur, interlocuteur). Dans le deuxième, il s’agit de rendre compte de la structure interne du texte (dialogue, débat, récit, etc.). Le texte/manuscrit devient ainsi texte/édition. Il comporte une image du discours et de ses conditions. L’édition du texte servira, entre autres, à le partitionner à des fins de comparaison ultérieure. Là commence le travail de description du texte lui-même. Le chercheur doit faire le choix des unités qui feront l’objet de cette description. S’intéressera-t-il aux mots (parties de mots, mots complexes), aux segments, aux répliques, etc.? Le fera-t-il sur la base de la forme (existence d’unités grammaticales ou textuelles) ou du sens (clôture des unités par le sens)? Une fois les unités déterminées, il devra élaborer un système de catégories. Celles-ci peuvent émerger de l’examen empirique des données et se constituer progressivement en un système. Elles peuvent également être projetées à partir d’un système a priori de catégories provenant d’un cadre théorique. Les catégories grammaticales sont un bon exemple de catégories a priori.

Ce sont ces unités décrites qui constitueront progressivement des représentations élaborées du texte/édition. On doit comprendre qu’à cette étape, les textes/représentations peuvent être démultipliés à l’infini. C’est bien l’illustration que la réduction progressive du texte/discours à ses divers états successifs peut conduire à une augmentation des représentations du même objet. Sur la base des descriptions apposées sur le texte (métadonnées, structure, unités catégorisées), les textes/représentations peuvent être explorées, comparées et analysées, produisant autant de nouveaux textes. Chaque exploration, chaque comparaison, chaque analyse produit des résultats prenant la forme métaphorique de sous-textes, chacun interprétable. Enfin, les sous-textes produits à titre de résultats sont à leur tour l’objet d’une dernière transformation dans de nouveaux textes/interprétation qui sont cette fois le fait du chercheur. Ces textes/interprétations sont produits au terme d’une longue démarche de découpage et de réduction de l’objet de départ, mais aussi à partir d’une profusion d’images du discours initial transformées, catégorisées, mises en comparaison, recoupées selon divers principes descriptifs. Les interprétations conservent le lien avec la matérialité de départ, mais comprennent une valeur ajoutée dépendante d’un processus de connaissance qui ne peut être assimilé à celui de la connaissance ordinaire. Enfin, au terme de ce processus, le chercheur est appelé à redonner un sens global aux données en restituant les conditions initiales de la production et de l’énonciation du discours. Cet acte herméneutique correspond au projet compréhensif. Il ne s’agit toutefois que d’une étape dans la spirale herméneutique qui tente d’ajouter à la précompréhension une compréhension enrichie, quitte à reprendre indéfiniment le chemin qui va de l’une à l’autre.

Revenons, en terminant, sur cette question de la complexité qui semble distinguer fortement les approches quantitative et qualitative. Nous croyons que tout processus de connaissance, a fortiori la connaissance scientifique, comporte une part de réduction de la complexité du réel. Deux aspects de tout processus de connaissance imposent ce passage obligé. D’une part, on ne peut saisir le réel qu’à travers une forme de matérialité, qu’elle relève des institutions, des pratiques ou des discours. Cette saisie réduit nécessairement la complexité de tout réel. D’autre part, le processus de connaissance passe nécessairement par la médiation de procédures de découpage, de description et d’analyse de cette matérialité. Évidemment, les démarches de connaissance peuvent viser à conserver plus ou moins de dimensions en fonction du nombre des observations produites. Mais la réduction de la complexité demeure inévitable. Paradoxalement, les opérations de la recherche, soit le découpage des objets, la description ou la catégorisation et l’analyse des données décrites, produisent de nouvelles formes de complexité, comme autant de nouveaux aspects de l’objet étudié. Compilation, tableaux, plans factoriels, concordances, lexiques, extraits sont autant d’aperçus nouveaux de l’objet d’étude. Enfin, la confrontation des observations et des descriptions à des cadres théoriques ou interprétatifs ajoute de nouveau à la complexité. Ainsi, tout processus de connaissance oscille entre réduction et restauration de la complexité.

Les deux axes de l’interprétation

Le problème de l’interprétation est le plus souvent abordé sous l’angle de la sous-interprétation ou de la surinterprétation. Soulet (2012) nous prévient du danger de sous-interpréter, c’est-à-dire de rester campé dans une attitude uniquement descriptive. À l’encontre des avertissements d’Olivier de Sardan, il préconise une attitude méthodique de surinterprétation des données susceptible de faire surgir le nouveau. « Interpréter est toujours en ce sens réviser l’existant et proposer, quand ce n’est pas imposer une autre consistance de l’existant » (Soulet, 2012, p. 32), quitte à « faire l’objet d’une confrontation au réel et [à] s’affronter à sa résistance » (p. 33). Le projet d’Olivier de Sardan est tout autre. Il constate que tous les énoncés du discours expert sont susceptibles de porter des interprétations. Constatif ou descriptif, le discours du chercheur, par le choix des mots, des propriétés ou des relations, peut porter en lui des interprétations. Lorsqu’il est directement interprétatif, de type hypothétique, explicatif ou comparatif, il ne peut faire l’économie du lien qu’il entretient avec l’empirie. Il faut donc faire preuve de méfiance et de vigilance. Dans le cas de la projection de préconceptions sur les objets du monde (le cas des énoncés apparemment constatifs), il faut activer la police épistémologique capable de débusquer les idéologies et les idiosyncrasies. Dans le cas des interprétations ouvertes, il faut exercer une vigilance capable d’esquiver la paresse méthodologique, en mobilisant le recoupement des sources, les contre-exemples, les compétences linguistiques. Ce qui inquiète Olivier de Sardan, ce sont les diverses figures de la surinterprétation. Surinterpréter c’est faire trop dire aux données, ne pas tenir compte des faits avérés, imposer un excès de sens ou un sens erroné. Après avoir noté les diverses figures de la surinterprétation, la réduction à un facteur unique, l’obsession de la cohérence, l’inadéquation significative, la généralisation abusive, il conclut qu’il y a difficilement de socioanthropologie sans recherche de facteurs plus ou moins dominants, sans recherche de cohérence, sans traduction, sans généralisation, sans recherche de sens non visible. En somme, le chercheur trouve à chaque pas le danger, par son projet même, de surinterpréter. Il s’en remet à un mélange de métier et de vigilance empirique comme moyen de se prémunir contre les surinterprétations, faute de règles formelles ou de procédures méthodologiques. Il n’y a peut-être pas tant de différences entre les deux auteurs cités. Dans les deux cas, la fonction interprétative est première. Ce qui les distingue, c’est l’insistance que l’un met sur l’audace interprétative, quitte à la valider, et la préoccupation du second par rapport aux dangers de mésinterpréter, faute d’avoir activé les fonctions de méfiance et de vigilance.

Pour notre part, nous abordons la question de l’interprétation selon un axe transversal allant de l’interprétation locale à l’interprétation globale (Duchastel & Laberge, 1999a). Nous voulons distinguer ainsi la portée des diverses interprétations produites à propos d’un objet d’étude. Lorsque l’on pense au processus d’interprétation, on a tendance à ne considérer que la phase de l’interprétation des données telles qu’elles ont été traitées, catégorisées, explorées et comparées, ou encore à s’en référer à l’interprétation globale surgissant au terme du processus de recherche. Nous suggérons que l’interprétation ne saurait être limitée au sens donné aux résultats produits par la méthode ou à la compréhension d’ensemble du phénomène étudié. Elle traverse l’ensemble des procédures de description et d’analyse appliquées à un objet. Elle est active dans l’établissement des données, dans la définition des unités, dans leur catégorisation, leur exploration, leur analyse. Olivier de Sardan a cette intuition lorsqu’il affirme que les énoncés constatifs ou descriptifs peuvent être imprégnés d’interprétations. De même, Ricoeur partage cette intuition lorsqu’il affirme que le processus de connaissance menant à la compréhension de l’objet se développe selon un arc herméneutique, entre interprétation et explication. Nous en revenons ainsi au point de départ, les sciences sociales sont avant tout des sciences interprétatives. Chaque opération, aussi objective soit-elle, implique une dimension interprétative. La question devient celle du contrôle des interprétations ou, autrement dit, celle du retour réflexif sur les opérations de la recherche. Plus nous sommes près des interprétations localisées, plus ce contrôle peut être exercé. Plus nous nous rapprochons des interprétations globales, moins ce contrôle peut exister. Nous tenterons d’illustrer cela en nous penchant sur les divers ordres d’interprétation.

Nous pouvons de nouveau parcourir notre schéma sur les transformations du texte pour illustrer en quoi les interprétations traversent l’ensemble des opérations de la recherche. L’idée même d’une question de recherche constitue un acte préinterprétatif. Il s’agit d’une projection par anticipation d’une précompréhension de l’objet. Une question, fut-elle ouverte, comporte en creux une hypothèse (interprétation anticipée) plus ou moins structurée. La question surdétermine a priori la lecture à venir de l’objet. Mais, l’utilité du processus de connaissance scientifique est d’enrichir cette lecture à l’aide de procédures objectivées. Une première interprétation est donc projetée dans l’objet, mais tout est mis en branle pour mettre à l’épreuve cette précompréhension. Ainsi, la délimitation de l’objet, son établissement en tant que données, la déclinaison des unités qui seront prises en charge procèdent d’un cadre problématisé, appuyé sur la théorie et sur le corpus des recherches connexes. En somme, les éléments du schème de précompréhension doivent être explicités, ouvrant sur leur contrôle et leur réplication. Les autres éléments de la procédure de recherche s’appuient également sur des choix qui doivent être explicités. Nous avons parlé plus haut de l’étape de la transcription des données discursives. On voit bien que celle-ci est déterminante pour la suite de l’analyse. Le fait de retenir ou non certains indices prosodiques, les hésitations ou les répétitions par exemple, permettra un traitement ultérieur fort différent. De la même manière, la prise en charge des caractéristiques structurelles d’un texte aura des incidences sur ce qui pourra en être dit.

La catégorisation est probablement l’exemple par excellence d’un processus interprétatif « embarqué » dans une opération en toute apparence descriptive. On peut distinguer la catégorisation factuelle et la catégorisation référentielle (Seidel & Kelle, 1995). La première renvoie à l’attribution de valeurs de propriété à des unités sur la base d’un cadre de référence théorique. Ces systèmes de catégories peuvent tendre vers l’objectivité, mais ils dépendent toujours d’une construction théorique qui les détermine. L’attribution de catégories grammaticales est probablement l’exemple se rapprochant le plus de l’objectivité. Mais, ces catégories grammaticales peuvent varier en fonction de théories morphosyntaxiques différentes, donnant lieu à des analyses divergentes. Par contre, l’attribution de catégories énonciatives, argumentatives ou plus largement rhétoriques variera davantage en fonction du schéma théorique de référence. En somme, aucune catégorisation n’échappe au cadre interprétatif qui la détermine. La catégorisation référentielle est plus difficilement objectivable. Elle consiste à attribuer une catégorie sémantique à une unité de sens. L’acte même d’attribution mobilise l’interprétation. Si l’on décompose cet acte d’attribution d’une valeur de propriété à l’unité, on peut distinguer trois relations interprétatives à l’oeuvre. Le codeur doit considérer d’abord la dimension paradigmatique des significations possibles d’une même unité. Un mot, un segment, renvoie à un espace sémantique, linguistique ou logique, comprenant un certain nombre de significations possibles. Le codeur doit choisir (interpréter) le sens le plus approprié. Mais, il ne peut le faire qu’en considérant l’axe syntagmatique, c’est-à-dire le contexte d’énonciation. Le choix d’un sens parmi d’autres dépend de l’environnement de l’unité (cotextuelle ou contextuelle). Enfin, le choix d’une catégorie dépend ultimement du cadre problématique de la recherche. Une unité doit recevoir une valeur correspondant à l’intention descriptive investie dans la recherche. La référence cumulée à ces dimensions paradigmatique, syntagmatique et problématique, est de nature proprement herméneutique. Cela n’enlève cependant pas la dimension objective et reproductible de l’attribution de catégories. C’est en cela qu’on peut parler d’interprétation contrôlée.

L’exploration des données, leur mise en comparaison et leur analyse comportent également des hypothèses interprétatives. Il est rarement avisé de croiser toutes les données selon toutes les variables descriptives (métadonnées, données structurelles, données discursives). Si un tel découpage permet d’observer des phénomènes inattendus, il convient rarement de circuler à l’aveugle. C’est donc à un cheminement progressif allant des descriptions générales aux croisements successifs des données que le chercheur est convié. Il effectuera ce cheminement en effectuant des choix guidés par des hypothèses de nature théorique ou empirique. C’est par voie d’anticipation interprétative qu’il pourra tester ces hypothèses. On constate de nouveau que ce travail d’interprétation est médiatisé par des opérations objectivables. Au contraire d’une interprétation spontanée, le processus de la recherche tente de valider progressivement la démarche de construction du sens. La présence d’un processus interprétatif dans le travail de description et d’analyse est rarement réfléchie de cette manière. Elle est plutôt occultée derrière l’objectivité apparente des procédures. Pourtant, c’est leur explicitation qui permet le contrôle des interprétations, du moins leur justification permanente. Affirmer le caractère interprétatif embarqué dans les procédures n’invalide en rien leur mise en oeuvre.

Là où l’interprétation semble devenir une opération avouée, c’est dans l’activité de donner sens aux résultats compilés de la recherche. Qu’il s’agisse de recueils de citations, de tableaux de données, de collections d’exemples, le chercheur est requis d’en restituer un sens. Il confirme ou infirme des hypothèses déjà formulées, il atteste certaines régularités, il établit une adéquation entre données et propositions théoriques. En somme, il procède à l’interprétation systématique des données. Plus nombreux et raffinés sont les outils qu’il met en place pour parcourir, dans tous les sens, la texture des données, plus riches seront les interprétations. Au terme de la recherche, un retour vers la complexité s’impose. La complexité du monde qui a été réduite et découpée doit désormais être restaurée. Ce travail est celui de la compréhension globale de l’objet. Elle ne peut se réaliser qu’en resituant l’objet dans le monde, en lui rendant toute sa complexité. Si le chercheur relève ce défi, il le fait par la mobilisation de moyens qui ne relèvent plus proprement des procédures empiriques. Il fait appel à ses connaissances larges du monde, aux références théoriques et sociographiques préalables. Il recompose un récit qui n’est plus celui qu’il a proprement analysé. Il donne sens sociologique à une réalité qui redevient maintenant un réel de référence. Il complète, en somme, un nouveau tour dans la spirale herméneutique qui va de la précompréhension de l’objet à sa compréhension enrichie. Certes, comme le conçoit Olivier de Sardan, le débat, la critique, la controverse, l’appel aux contre-exemples et aux cas négatifs peuvent aider à la validation de ce travail interprétatif. Mais il échappe proprement au contrôle opérationnel qui était possible dans l’exercice des interprétations locales. Un hiatus inévitable se crée entre empiricité et interprétation.

La sérendipité ou l’art de découvrir[4]

Dans l’univers du qualitatif on parle de plausibilité plutôt que de falsifiabilité, de quasi-réfutabilité plutôt que de confirmation/infirmation des hypothèses, de crédibilité/transférabilité plutôt que de validité. Mais dans tous les cas, il est question d’un degré quelconque d’adéquation entre empirie et proposition théorique. Cette adéquation est pensée sur le mode de l’inférence. Peut-on inférer la valeur d’une théorie en la projetant dans l’empirie ou peut-on, à l’inverse, inférer, à partir de l’empirie, des propositions théoriques? Le raisonnement inférentiel fonctionne comme un jeu de miroir. Il est à l’oeuvre tout au long du processus de recherche. On le retrouve, par exemple, au moment de la catégorisation. Nous avons vu que celle-ci peut être de nature factuelle. Alors elle propose, dans un mouvement déductif, l’application de valeurs de propriétés prédéterminées par la théorie aux unités empiriques. La catégorisation peut être de nature référentielle et remonter de l’empirie, dans un mouvement inductif, vers la construction progressive d’un système de catégories. On peut enfin concevoir un ensemble de cas intermédiaires où la catégorisation puise aux deux démarches, proposant un ensemble de catégories établies préalablement tout en restant ouverte à des ajustements progressifs de la grille. On trouve également le même raisonnement inférentiel au moment de l’interprétation des données. Ou bien les données représentent une valeur probatoire de la théorie, ou bien elles servent à construire des propositions théoriques, comme c’est le cas dans la démarche ancrée. Il y a certes une différence de perspective entre raisonnement déductif et raisonnement inductif. Mais, ils appartiennent tous deux au même modèle causal aussi longtemps que la recherche reste fondée sur une logique expérimentale ou quasi expérimentale (Tacq, 2011). C’est toujours la force du lien d’adéquation entre empirie et théorie qui est en jeu.

La force de l’approche déductive est de pouvoir prétendre à une certaine validation théorique à travers l’infirmation ou la confirmation des hypothèses. Elle comporte en revanche une limitation dans la possibilité de découvrir. Elle a avant tout valeur probatoire ou confirmatoire. L’approche inductive permet d’inférer, à partir de l’observation des données, des propositions théoriques nouvelles. Mais cette ouverture se fait rarement en l’absence de toute préconstruction. La question de recherche, le domaine, la problématique conduisent l’observateur vers des objets particuliers et des propriétés particulières de ces objets. Il y a certes davantage d’ouverture dans le sens où aucun schème compréhensif formalisé n’est proposé au point de départ. Cela permet assurément l’identification de phénomènes inattendus que le chercheur doit savoir capter. On trouve cependant dans un grand nombre de recherches une combinaison des deux approches, soit dans des phases indépendantes, exploratoire et probatoire, soit au sein même des opérations de la recherche, dans une certaine mixité des méthodes.

Qu’en est-il, dans ce contexte, de la sérendipité? Ce mot étrange, fabriqué de toutes pièces au dix-huitième siècle par Horace Walpole dans le récit des trois princes de Serendip (Sri Lanka actuel), signifie découvrir par accident et sagacité. Il s’agit d’une découverte heureuse d’une chose totalement inattendue et de grande importance, alors qu’on cherchait toute autre chose. Il s’agit donc de chance ou de hasard, mais d’une chance saisie par la sagacité de l’observateur, c’est-à-dire sa capacité intuitive et perspicace. Dès 1945, Merton utilise le terme pour décrire des découvertes fortuites, mais qui ont un impact théorique (Merton, 1945). C’est en 1948, dans un article qui porte sur la contribution de la recherche empirique sur le développement de la théorie sociologique, qu’il élabore systématiquement la notion de sérendipité. Merton y décrit un type d’expérience concrète souvent faite par les chercheurs : « Le modèle de sérendipité fait référence à l’expérience assez commune d’observer une donnée imprévue, anormale et stratégique qui donne l’occasion de développer une nouvelle théorie ou de complexifier une théorie existante »[5] [traduction libre] (Merton, 1948, p. 506). Si les qualificatifs d’imprévu et d’anomal s’inscrivent fort bien dans la démarche des trois princes, Merton s’éloigne légèrement de la notion originelle en y inscrivant l’exigence stratégique : dans le conte, les princes de Serendip observaient à partir de leur seule curiosité, alors que la posture du chercheur est marquée par l’intention, elle s’inscrit à l’intérieur d’un projet de connaissance.

Quelles sont les conditions de possibilité de ces découvertes inattendues, anomales et stratégiques? Comment s’ouvrir à la chance? Comment saisir cette chance? Quel type de raisonnement est susceptible de conduire à la découverte? Nous avons affirmé que la recherche s’appuie toujours sur un raisonnement causal de nature inférentielle qui prend une forme déductive ou inductive. Nous avons ajouté que le raisonnement déductif est moins susceptible que le raisonnement inductif d’ouvrir à de nouvelles découvertes. La sérendipité renvoie à une troisième catégorie de raisonnement logique, le raisonnement abductif. C’est ce type de raisonnement que les princes de Sérendip mettent en oeuvre dans leur recherche. Il s’agit d’observer un ensemble de faits qui, mis ensemble, conduisent de manière indépendante de toute visée orientée de l’observateur à construire des hypothèses. Peirce, dans Essays on the philosophy of science, donne une définition de l’abduction :

La première amorce d’une hypothèse et son développement, qu’il s’agisse d’une simple interrogation ou qu’elle comporte un degré de confiance quelconque, est un type d’inférence que je propose d’appeler abduction. Cela implique une préférence pour une hypothèse plutôt qu’une autre qui expliquerait également les faits, pour autant que cette préférence ne repose sur aucune connaissance antérieure portant sur la véracité de l’hypothèse ni sur aucun test d’hypothèse dans un processus probatoire. J’appelle ce type d’inférence du nom d’abduction parce que sa légitimité dépend de principes tout à fait différents de ceux des autres types d’inférences[6] [traduction libre]

Peirce, 1957, cité par Swedberg, 2012, p. 17

Le raisonnement abductif repose sur les dispositions des chercheurs. Paveau nous dit que « la sérendipité est une véritable disposition au sens philosophique du terme […], une quête active même si elle n’a pas de but connu et non une attente passive devant l’inconnu » (Paveau, 2011, p. 227). Elle rappelle la métis grecque chez Morin, un « ensemble d’attitudes mentales qui combinent le flair, la sagacité, la prévision, la souplesse d’esprit, la débrouillardise, l’attention vigilante, le sens de l’opportunité » (1999, p. 24). Peirce parle d’une « qualité biologique » des humains, celle de pouvoir sélectionner les hypothèses les plus appropriées parmi un grand nombre possible. Cependant, ces qualités humaines ne sauraient suffire. Il faut un environnement sociocognitif favorable et une configuration particulière de la recherche. C’est ainsi que la sérendipité est devenue une stratégie de recherche. Les sciences naturelles développent des méthodologies susceptibles de favoriser la découverte d’éléments inattendus. Qu’en est-il des sciences sociales?

Nous soumettons l’hypothèse que c’est dans la réduction/restauration de la complexité que les conditions d’émergence de faits nouveaux sont favorisées. La transformation progressive des formes du texte démultiplie les angles de lecture de l’objet permettant ainsi le surgissement de faits inattendus. Nous donnerons deux exemples. Le premier découle de l’application de deux systèmes de catégories et d’une analyse grammaticale automatique dans le cas d’un discours politique (Bourque & Duchastel, 1988). Les mots pleins du discours politique ont été catégorisés à l’aide d’une grille sémantique enrichie progressivement au fur et à mesure du déroulement de l’opération. Les mots avaient été préalablement indexés en fonction d’une grille morphosyntaxique et les phrases ont fait l’objet d’une analyse syntaxique déterminant les positions thématiques et les relations de détermination dans le discours. Un premier examen des données a montré l’importance égale des mots catégorisés sous l’étiquette de progrès et de celle de tradition. Cependant, l’application de l’analyseur indiquait que les mots catégorisés sous l’étiquette progrès se trouvaient en position thématique (selon l’approche de la grammaire fonctionnelle) alors que les mots de la catégorie tradition se trouvaient en position de déterminant. Il s’agissait là d’une découverte fortuite, permise par le dispositif complexe de description et d’analyse. Elle ne pouvait être anticipée à cette étape. Il restait à l’interpréter et c’est là que la sagacité du chercheur a été sollicitée. Cet arrangement syntaxique des catégories sémantiques renvoyait à une subsomption, dans le discours, d’une catégorie par une autre. Le discours en question appartient à la période duplessiste fortement caractérisée par l’orientation libérale de l’État doublé d’un attachement aux institutions prémodernes. Cette articulation donnait sens au slogan du ministre des Finances de l’époque : « Restons traditionnels et progressifs ». Elle permettait de comprendre comment la tradition était articulée au progrès en mode secondaire : le progrès d’abord, mais dans le respect de la tradition.

Un second exemple renvoie aux automatismes mis en oeuvre à l’occasion de l’analyse multidimensionnelle de données. Lorsque la méthode a permis le découpage des objets et leur catégorisation aux trois niveaux des métadonnées, des données structurelles et des données proprement discursives, il est possible de produire des analyses capables d’explorer un grand nombre de dimensions de l’objet. Ces analyses à l’aveugle, qu’elles soient de nature hypertextuelle ou factorielle, fournissent au chercheur des faits inusités qui peuvent éveiller chez lui la curiosité ou l’intuition. Le contrôle des opérations étant assuré, il est alors possible d’établir des plans quasi expérimentaux susceptibles de valider ces intuitions.

Conclusion

Nous avons tenté d’établir au point de départ que les oppositions entre démarche qualitative et démarche quantitative, pour pertinentes qu’elles puissent paraître dans un premier temps, s’épuisent rapidement dans le processus réel de la recherche qui mobilise les outils les plus utiles au moment opportun. Nous avons plutôt insisté sur les postures ontologiques des chercheurs en sciences sociales, avouant notre préférence pour une posture intermédiaire entre positivisme et constructivisme, une posture que nous avons dénommée concordataire. Nous accordons à la réalité une présomption d’existence indépendante de toute construction, nous pensons que le processus de connaissance scientifique implique la production d’opérations d’objectivation. Nous croyons qu’il est possible d’approximer la réalité dans des modèles de représentation qui permettent la comparaison sur la base de modèles idéaltypiques. Nous avons établi que la connaissance scientifique procède à une nécessaire réduction de l’objet de départ par l’application d’un ensemble d’opérations. Comme nous l’avons vu, ces opérations conduisent paradoxalement à une restauration de la complexité de l’objet. Ce n’est que sur une base empirique, en reconnaissant la matérialité des objets à l’étude, qu’il est possible de dépasser la simple interprétation spontanée des données. L’interprétation se déploie selon deux axes. Le premier est de nature épistémologique et concerne les écarts au maintien d’une adéquation entre empirie et théorie. Le chercheur doit se prémunir à la fois d’une sous-interprétation trop collée sur les données et d’une surinterprétation qui excède ce que les données autorisent. Le deuxième axe est plus empirique. Il consiste à discriminer entre les niveaux d’interprétation en relation avec les opérations de la recherche. Les interprétations locales sont susceptibles d’un contrôle et d’une réplication alors que les interprétations globales dépassent l’espace de validation dans la mesure même où elles restaurent une complexité difficilement maîtrisable. Nous avons conclu en interrogeant les diverses formes du raisonnement scientifique. Nous avons affirmé qu’aussi bien le qualitatif que le quantitatif relèvent d’une logique causale de nature inférentielle, plus ou moins inductive ou déductive. Nous avons indiqué que la logique inductive est plus ouverte à la découverte, mais ne peut suffire à valider les interprétations. Nous avons enfin exploré les voies de l’abduction, forme du raisonnement difficilement cernable. Nous avons tenté de montrer que cette forme de raisonnement ouvre sur la découverte et nous avons proposé quelques illustrations sur les conditions de l’environnement de recherche susceptible de faire émerger des faits inusités qui devront être saisis intuitivement et validés par la méthode quasi expérimentale. Il nous resterait à réfléchir davantage sur les diverses formes que peut prendre le raisonnement abductif et déterminer les stratégies particulières pouvant favoriser son développement. Cela fera l’objet d’une autre réflexion.

Appendices

Notes biographiques

Jules Duchastel est un chercheur réputé internationalement qui a fait sa marque dans le domaine de la sociologie politique appliquée à l’étude des transformations de la régulation politique dans l’histoire des cinquante dernières années au Canada et, plus récemment, dans le contexte de la mondialisation. Il s’est également distingué par une abondante production méthodologique en analyse du discours assistée par ordinateur dont il a fait la base de son travail de recherche.

Danielle Laberge a été, pendant plus de vingt ans, professeure au Département de sociologie de l’UQAM où elle a enseigné les méthodes de recherche et l’épistémologie aux trois cycles. Ses recherches ont porté sur la pauvreté et l’exclusion sociale. Entre 2001 et 2008, elle a assumé la fonction de vice-rectrice à la vie académique et de vice-rectrice exécutive à l’UQAM. Depuis 2008, son enseignement et ses recherches ont porté sur la gestion de projet.

Notes

-

[1]

Notre choix de ces auteurs est motivé par la couverture de leurs réflexions. Le chapitre de Guba et Lincoln a été publié dans un des plus importants ouvrages collectifs sur la recherche qualitative (Denzin & Lincoln, 1994). La contribution d’Olivier de Sardan se situe dans le contexte européen. En ce qui concerne notre contribution, elle permet de mieux situer notre posture.

-

[2]

Cette figure s’inspire de Meunier (1993). L’explication de cette figure reprend certains éléments présentés dans Duchastel et Laberge (2014).

-

[3]

Nous nous inspirons ici de notre pratique d’analyse du discours à l’aide de systèmes informatiques, mais les opérations formelles peuvent aisément être transposées dans tout autre contexte d’analyse de données discursives. Les opérations décrites dans la Figure 1 s’appliquent mutatis mutandis à toute démarche d’établissement des données, de leur description et analyse et de leur interprétation.

-

[4]

La question de la découverte était au centre du questionnement du 4e Congrès du Réseau international francophone de recherche qualitative, en 2013, dont le thème était La logique de la découverte en recherche qualitative. Nos réflexions ont été développées dans ce cadre.

-

[5]

« The serendipity pattern refers to the fairly common experience of observingan unanticipated, anomalous and strategic datum which becomes the occasion for developing a new theory or for extending an existing theory » (Merton, 1948, p. 506).

-

[6]

« The first starting of a hypothesis and the entertaining of it, whether as a simple interrogation or with any degree of confidence, is an inferential step which I propose to call abduction. This will include a preference for any one hypothesis over others which would equally explain the facts, so long as this preference is not based upon any previous knowledge bearing upon the truth of the hypothesis, nor on any testing of the hypothesis after admitting them on probation. I call all such inferences by the peculiar name, abduction, because its legitimacy depends upon altogether different principles from those other kinds of inferences » (Peirce, 1957, pp. 236-237).

Références

- Bourque, G., & Duchastel, J. (1988). Restons traditionnels et progressifs. Pour une nouvelle analyse du discours politique : le cas du régime Duplessis au Québec. Montréal : Boréal.

- Denzin, N K., & Lincoln, Y. S. (1994). Handbook of qualitative research. Thousand Oaks, CA: Sage Publications.

- Dilthey, W. (1947). Le monde de l’esprit. Paris : Aubier.

- Duchastel, J., & Laberge, D. (1999a). Des interprétations locales aux interprétations globales : combler le hiatus. Dans N. Ramognino, & G. Houle (Éds), La normativité dans les sciences sociales (pp. 51-72). Toulouse : Presses de l’Université Toulouse LeMirail.

- Duchastel, J., & Laberge, D. (1999b). La recherche comme espace de médiation interdisciplinaire. Sociologie et sociétés, 31(1), 63-76.

- Duchastel, J., & Laberge, D. (2011). La mesure comme représentation de l’objet. Analyse et interprétation. SociologieS. Repéré à http://sociologies.revues.org/3435

- Duchastel, J., & Laberge, D. (2014). Au-delà de l’opposition quantitatif/qualitatif. Convergence des opérations de la recherche en analyse du discours. Corela, HS-15. Repéré à https://journals.openedition.org/corela/3524

- Foucault, M. (1969). L’archéologie du savoir. Paris : Éditions Gallimard.

- Giddens, A. (1987). Social theory and modern sociology. Stanford, CA: Stanford Unversity Press.

- Guba, E. G., & Lincoln, Y. S. (1994). Competing paradigms in qualitative research. Dans N. K. Denzin, & Y. S. Lincoln (Éds), Handbook of qualitative research (pp. 105-117). London: Sage Publications.

- Merton, R. K. (1945). Sociological theory. American Journal of Sociology, 50(6), 462-473.

- Merton, R. K. (1948). The bearing of empirical research upon the development of social theory. American Sociological Review, 13(5), 505-515.

- Meunier, J.-G. (1993). Le traitement et l’analyse informatique des textes. Revue de liaison de la recherche en informatique cognitive des organisations (ICO Québec), 6(1-2), 19-41.

- Molino, J. (1989). Interpréter. Dans C. Reichler (Éd.), L’interprétation des textes (pp. 9-52). Paris : Éditions de Minuit.

- Morin, E. (1999). La Tête bien faite. Repenser la réforme, réformer la pensée. Paris : Seuil.

- Olivier de Sardan, J.-P. (2008). La rigueur du qualitatif. Les contraintes empiriques de l’interprétation socio-anthropologique. Louvain-la-Neuve : Academia Bruylant.

- Paveau, M.-A. (2011). Ce lumineux objet du désir épistémique. Archives ouvertes, Repéré à http://hal.archives-ouvertes.fr/hal-00596738

- Peirce, C. (1957). Essays in the philosophy of science. New York, NY: Bobbs-Merrill.

- Ricoeur, P. (1986). Du texte à l’action. Paris : Éditions du Seuil.

- Seidel, J., & Kelle, U. (1995). Different functions of coding in the analysis of textual data. Dans U. Kelle (Éd.), Computer-aided qualitative data analysis (pp. 52-61). London: Sage Publications.

- Soulet, M.-H. (2012). Interpréter sous contrainte ou le chercheur face à ses données. Recherches qualitatives, Hors-série « Les Actes », 12, 29-39.

- Swedberg, R. (2012). Theorizing in sociology and social science: Turning to the context of discovery. Theory and Society, 41(1), 1-40.

- Tacq, J. (2011). Causality in qualitative and quantitative research. Quality and Quantity, 45(2), 263-291.

- Weber, M. (1978). Economy and society. An outline of interpretive sociology. Berkeley, CA : University of California Press.

List of figures

Figure 1

Les formes du texte, restauration de la complexité

10.7202/001205ar

10.7202/001205ar