Abstracts

Résumé

L’utilisation des Interventions Fondées sur les Preuves (IFP) est de plus en plus encouragée dans le domaine psychosocial, mais leur validation demeure controversée. La recherche sur les IFP est dominée par les études d’efficacité qui visent à tester les effets des interventions dans des conditions optimales. Cependant, les conclusions de ces études peuvent difficilement s’appliquer en pratique. La recherche d’efficacité doit être complétée par la recherche d’effectivité qui vise à tester les effets des interventions dans des conditions de la pratique courante (dans le « vrai monde »). Cet article vise à définir la recherche d’effectivité, à présenter ses principales stratégies de recherche et à dégager ses implications dans la validation des IFP. La recherche d’effectivité représente souvent un premier test de réalité pour une intervention survenant entre la recherche d’efficacité et le transfert éventuel de cette intervention de la recherche vers la pratique. Cette recherche exige un travail d’équilibriste entre des orientations méthodologiques contradictoires : maximiser la validité écologique, la validité externe et l’utilité pratique des résultats et, d’autre part, préserver un bon niveau de validité interne. Réussir cet équilibre permet de produire une preuve pertinente, applicable, généralisable, mais aussi robuste quant aux effets d’une intervention dans un contexte de pratique courante. La recherche d’effectivité est dorénavant incontournable et mérite d’être priorisée au Québec comme ailleurs.

Mots-clés :

- Efficacité,

- effectivité,

- interventions fondées sur les preuves,

- interventions factuelles,

- meilleures pratiques

Abstract

The use of evidence-based interventions is increasingly valued in the psychosocial domain, but their process of validation remains controversial. Research on evidence-based interventions has been dominated by efficacy trials, which aim to test the effects of interventions under optimal conditions. However, conclusions from these studies may be difficult to translate in ordinary clinical practice. It is increasingly recognized that efficacy trials should be complemented by effectiveness trials, which aim to test the effects of interventions under real-world conditions. Effectiveness research now occupies an important place in the international scientific literature, but this type of research still has limited visibility in the francophone literature in Quebec and around the world. The aims of this article are to define effectiveness research, to present its main methods, and to highlight its implications for the validation and definition of evidence-based interventions. Effectiveness research often represents the first ‘reality check’ for an intervention occurring between efficacy research and dissemination or implementation research. This research involves attempting to find a balance between contradictory methodological orientations: to maximize ecological validity, external validity, and practical utility on one side and to preserve internal validity on the other. Through this balance, effectiveness research has the potential to produce evidence that is relevant, applicable, and generalizable, yet also robust. Effectiveness research is increasingly playing a key role in the validation of evidence-based interventions and should become a priority in Quebec.

Keywords:

- Efficacy,

- effectiveness,

- randomized-controlled trials,

- evidence-based interventions,

- evidence-based practice,

- best practices,

- practice guidelines

Article body

Si l’on veut davantage de pratiques fondées sur des preuves, il faut davantage de preuves fondées sur la pratique.

Lawrence Green (2008)

La mise en place de services d’excellence est devenue prioritaire dans le domaine social (Institut National d’Excellence en Santé et Services Sociaux [INESSS], 2012). Les professionnels doivent de plus en plus appuyer leurs décisions cliniques sur des données probantes et recourir autant que possible à des interventions dont les bénéfices ont été formellement démontrés par la recherche. Ces interventions sont identifiées par plusieurs expressions : interventions fondées sur les preuves (IFP), interventions factuelles, interventions fondées sur les données probantes, interventions soutenues empiriquement ou meilleures pratiques (Rabin, Brownson, Haire-Joshu, Kreuter et Weaver, 2008). Ces interventions peuvent prendre différentes formes, mais renvoient le plus souvent à des interventions relativement standardisées, telles que des programmes manualisés (Chambless et Ollendick, 2001; DeRubeis et Crits-Christoph, 1998; Rabin et al., 2008).

La manière de définir et de valider les IFP demeure cependant controversée. Jusqu’à maintenant, la recherche sur les IFP a été dominée par les études d’efficacité (Glasgow, Lichtenstein et Marcus, 2003; Green, 2001; Marchand, Stice, Rohde et Becker, 2011; Roy-Byrne et al., 2003; Ruggeri, Lasalvia et Bonetto, 2013). Ces études visent à maximiser la validité interne en testant les effets des interventions dans des conditions optimales (Flay, 1986; Flay et al., 2005). Les études d’efficacité impliquent typiquement le recours à un essai contrôlé randomisé (ECR), un contrôle serré des conditions de mise en oeuvre grâce à un personnel de recherche hautement qualifié, des interventions rigoureusement standardisées, de même que des participants motivés et aux prises avec un problème unique (Glasgow et al., 2003). En aval, les recensions systématiques (recensions des collaborations Cochrane et Campbell, www.cochrane.org), répertoires des meilleures pratiques (Blueprints for violence; www.blueprintsprograms.com) et guides de pratique (National Institute for Health and Clinical Excellence [NICE], 2009) qui résument typiquement la preuve existante définissent aussi typiquement les IFP en fonction de critères de validité interne (Mercer, DeVinney, Fine, Green et Dougherty, 2007). Par exemple, les recensions systématiques des collaborations Cochrane/Campbell ne résument que la preuve provenant d’essais contrôlés randomisés (Higgins et Green, 2008), ce qui revient souvent à négliger la majorité des études publiées dans la littérature scientifique (Glasgow et al., 2003).

Ce modèle de validation des IFP, centré sur la validité interne et les études d’efficacité, s’attire des critiques véhémentes de la part des chercheurs et des praticiens de différents domaines (Dubé, 2012; Glasgow et Emmons, 2007; Glasgow et al., 2006; Glasgow et al., 2003; Green, 2001; Norcross, Beutler et Levant, 2006; Treweek et Zwarenstein, 2009; Tunis, Stryer et Clancy, 2003; Victora, Habicht et Bryce, 2004). Ces critiques portent avant tout sur le caractère artificiel de la preuve d’efficacité et la difficulté de transférer des IFP évaluées dans des conditions optimales dans des conditions de pratique souvent variables et contraignantes. Ce problème est particulièrement significatif dans le domaine social où les interventions sont typiquement complexes et dépendantes de leur contexte comparativement au domaine biomédical où les interventions peuvent faire l’objet d’un haut degré de standardisation (p.ex. médication) (Green, 2001). De nombreux résultats montrent d’ailleurs que les effets des interventions psychosociales développées et validées en milieu universitaire tendent à se dissiper lorsque ces interventions sont évaluées dans des conditions de pratique courante (voir un exemple sur la prévention de la dépression dans Merry, 2013).

De plus en plus de chercheurs et de praticiens font valoir l’importance de la recherche d’effectivité dans la validation des IFP (Clarke, 1995; Glasgow et al., 2003; Marchand et al., 2011; Roy-Byrne et al., 2003). Cette recherche occupe une place grandissante dans la littérature scientifique internationale. Le nombre d’études d’effectivité publiées dans la littérature scientifique a dramatiquement augmenté au cours des vingt dernières années (Patsopoulos, 2011), des journaux et numéros spéciaux dédiés à ce sujet sont apparus (p. ex : Journal of Comparative Effectiveness Research; Evaluation and the Health Professions; Bausell, 2006) et cette recherche fait maintenant l’objet d’investissements massifs des gouvernements canadiens, américains et anglais, particulièrement dans le domaine de la santé (Chalkidou et Walley, 2010; Instituts de Medicine [États-Unis], 2009; Whicher, Chalkidou, Dhalla, Levin et Tunis, 2009). En revanche, le concept d’effectivité est plus ou moins absent de la littérature scientifique francophone. Par exemple, les écrits portant sur les IFP dans le contexte des guides de pratique font très peu référence à ce type de recherche (Dubé, 2012; INESSS, 2012). De plus, les termes efficacité et effectivité sont souvent utilisés comme des synonymes (Delphin-Combe, Roudaud, Martin-Gaujard, Fortin, Rouch et Krolak-Salmon, 2013; Farkas, Cyr, Lebeau, Lemay et McDuff, 2009; Falissard, 2009; Nagloo, Valero, Rexhaj et Favrod, 2013; Tremblay et Ben Amar, 2007). Cela ne veut pas dire qu’il n’existe pas d’études d’effectivité au Québec : certaines études peuvent être qualifiées comme tel (Archambault, Janosz, Pascal, Lecoq, Goulet et Christenson, 2015; Moisan, Poulin, Capuano et Vitaro, 2014; Provencher, St-Amand, Hawke, Baruch et Tremblay, 2010), incluant certaines évaluations de programmes bien connus (Fluppy; Poulin, Capuano, Vitaro, Verlaan, Brodeur et Giroux, 2013; Vers le Pacifique; Bowen et al., 2006). Cependant, ces études ne sont généralement pas décrites et interprétées à la lumière des concepts d’efficacité et d’effectivité.

Cet article vise à définir la recherche d’effectivité, à présenter ses principales stratégies de recherche et à dégager ses implications dans le processus de validation des IFP. Ce manuscrit se veut avant tout un texte de référence pour des professeurs, des chercheurs et des étudiants gradués dans le domaine de la recherche interventionnelle (les valideurs des IFP), mais il peut également intéresser les praticiens et les décideurs (les utilisateurs éventuels de ces IFP) peu familiers avec ce type de recherche et intéressés à en apprendre davantage. Les concepts dont il est question peuvent s’appliquer à la recherche sur des interventions provenant de diverses disciplines connexes (psychologie, psychoéducation, travail social, santé publique, etc.), qu’elles soient préventives ou curatives. Quelques recommandations générales sont présentées en conclusion.

Qu’est-ce que la recherche d’effectivité?

Contrairement à la recherche d’efficacité qui vise à évaluer les effets d’une intervention dans des conditions optimales, la recherche d’effectivité vise à évaluer les effets d’une intervention dans un contexte de la pratique courante (« vrai monde ») (Flay, 1986; Flay et al., 2005; Glasgow et al., 2003). La recherche d’efficacité répond à la question « est-ce que l’intervention peut fonctionner? », tandis que la recherche d’effectivité répond à la question « est-ce que l’intervention fonctionne vraiment? » (Haynes, 1999). Dans la littérature clinique, les termes « essais pragmatiques » ou « essais pratiques » (practical or pragmatic trials) sont aussi utilisés pour désigner les études d’effectivité et le terme « essai explicatif » (explanatory trial) pour désigner les études d’efficacité (Dunn, 2013; Hotopf, 2002; Patsopoulos, 2011; Treweek et Zwarenstein, 2009; Tunis et al., 2003).

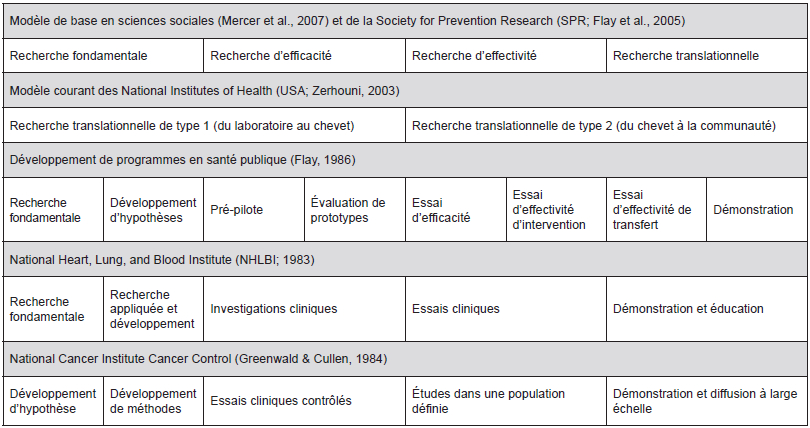

La recherche d’effectivité n’est pas nouvelle. On la retrouve décrite dans plusieurs modèles de développement et de validation d’interventions en étapes, inspirés de la recherche biomédicale ou pharmaceutique (Figure 1) (Flay, 1986). Nonobstant certaines distinctions d’un modèle à l’autre, la recherche d’effectivité se situe généralement entre la recherche d’efficacité et la recherche portant sur la diffusion d’une intervention à large échelle (Mercer et al., 2007). Elle représente le plus souvent un premier test, à moyenne échelle, d’une intervention dans la pratique courante précédent sa diffusion dans l’ensemble d’une population. Cela dit, certains modèles récents proposent un développement moins linéaire dans lequel la recherche d’effectivité ne suit pas forcément la recherche d’efficacité (Flay et al., 2005; Mercer et al., 2007; Zerhouni, 2003). Par exemple, la Society for Prevention Research (SPR) définit l’efficacité, l’effectivité et la diffusion (scale up) des interventions préventives en trois paliers dont chacun acquiert des critères supplémentaires, sans que ceux-ci découlent nécessairement de phases séquentielles (Flay et al., 2005; Gottfredson et al., 2015). Selon ce modèle, il n’est pas nécessaire d’effectuer une étude d’efficacité préalable si une première étude convient à la fois aux critères vérifiant l’efficacité ET l’effectivité d’une intervention donnée.

Figure 1

Phases de développement des interventions selon différents modèles en santé et en sciences sociales (adapté de Flay, 1986; Mercer et al., 2007)

La recherche d’effectivité est décrite de différentes façons, plus ou moins précises, d’un écrit à l’autre. Dans cet article, les caractéristiques de cette recherche sont décrites sous l’angle de quatre grandes orientations méthodologiques qui intègrent la majorité des concepts évoqués dans la littérature. Ces orientations sont introduites ici, approfondies dans la prochaine section et résumées dans le Tableau 1.

Tableau 1

Maximiser la validité écologique. La recherche d’effectivité vise à maximiser la validité écologique des méthodes utilisées dans une étude afin de produire des résultats qui reflètent le fonctionnement et les effets réels des interventions dans la pratique courante (Flay et al., 2005; Marchand et al., 2011). Cette visée est partagée par l’ensemble des études d’effectivité.

Maximiser la validité externe. La recherche d’effectivité vise à maximiser la validité externe et donc à déterminer la généralisation potentielle des effets d’une intervention aux différents milieux, intervenants et populations à qui elle est destinée (Glasgow, 2013; Glasgow et Emmons, 2007; Segal, Weiss et Varadhan, 2012). Cette centration explicite sur la validité externe est l’un des éléments les plus distinctifs de la recherche d’effectivité par rapport à d’autres types de recherche, comme la recherche d’efficacité et l’évaluation de programmes, lesquelles mettent avant tout l’accent sur la validité interne (Glasgow et al., 2003; Dagenais et Ridde, 2012).

Maximiser l’utilité et la pertinence pratique des résultats. La recherche d’effectivité vise à maximiser l’utilité et la pertinence pratique des résultats (Treweek et Zwarenstein, 2009; Tunis et al., 2003) en dégageant une information susceptible d’éclairer les décideurs et les praticiens quant à leur priorités concrètes sur le terrain. Les termes « essais pragmatiques / pratiques » ont été proposés pour mettre en évidence cette visée.

Préserver un bon niveau de validité interne. Tout en respectant les orientations précédentes, la recherche d’effectivité vise à préserver un bon niveau de validité interne et à fournir une preuve convaincante des effets d’une intervention (Flay et al., 2005; Glasgow, 2013). Le verbe préserver est utilisé parce que le contrôle expérimental sera souvent moins strict dans la recherche d’effectivité comparativement à la recherche d’efficacité. En fait, l’un des principaux défis de la recherche d’effectivité réside dans l’équilibre à trouver entre, d’une part, la validité écologique, la validité externe et l’utilité pratique (qui impliquent de laisser libre cours aux conditions les plus naturelles possibles) et, d’autre part, la validité interne (qui exige un haut degré de contrôle expérimental) (Clarke, 1995; Marchand et al., 2011). Dans la recherche d’effectivité, il s’avère souvent nécessaire d’utiliser un devis moins strict que le devis expérimental classique, emblématique des essais contrôlés d’efficacité.

Les orientations présentées dans cet article concordent avec la conception de l’effectivité décrite par la SPR (Flay et al., 2005; Gottfredson et al., 2015), qui valorise un équilibre entre validités interne et externe. D’autres descriptions mettent l’accent sur la validité externe et opposent plus directement validités interne (efficacité) et externe (effectivité) (Thorpe et al., 2009). Dans les faits, la plupart des études partagent dans une certaine mesure des caractéristiques d’efficacité et d’effectivité (Marchand et al., 2011; Thorpe et al., 2009). Il est donc plus utile de situer une étude sur un continuum efficacité-effectivité que d’utiliser ces termes en opposition. Un outil utile à cet égard est la grille PRECIS (Pragmatic-Explanatory Continuum Indicator Summary; Figure 2) qui permet de représenter schématiquement la nature d’une étude selon son positionnement méthodologique relativement à des pôles extrêmes d’efficacité et d’effectivité (Thorpe et al., 2009).

Figure 2

Schéma d’une étude d’effectivité à partir de la grille de critères PRÉCIS (adapté de Thorpe et al., 2009)

Note. Les critères sont indiqués en caractère gras. Les pôles centraux représentent une position « explicative » (efficacité) et les pôles éloignés du centre représentent une position « pragmatique » (effectivité). Le schéma représente une étude ayant une position pragmatique extrême pour chacun des critères.

Stratégies de recherche d’effectivité

La présente section fait état de différentes stratégies de recherche qui permettent d’actualiser les quatre orientations méthodologiques introduites précédemment. Compte tenu de l’espace disponible, ces stratégies ne sont que brièvement décrites. Des renvois vers des descriptions plus détaillées apparaissent dans le texte et à l’annexe 1.

Orientation 1. Maximiser la validité écologique

Une des orientations méthodologiques les plus fondamentales de la recherche d’effectivité est de maximiser la validité écologique. La validité écologique est définie de différentes manières (Bronfenbrenner, 1979; Brunswick, 1956), mais réfère le plus souvent au degré de similitude entre le contexte dans lequel un phénomène est étudié et son contexte naturel (Shadish, Cook et Campbell, 2002). Dans une étude d’effectivité, la validité écologique augmente lorsque les conditions de l’étude d’une intervention s’approchent des conditions de la pratique courante dans lesquelles cette intervention sera utilisée. Cela signifie avant tout que cette intervention devrait être livrée par de vrais intervenants dans de vrais milieux de pratique plutôt que par des assistants de recherche en contexte universitaire (Flay, 1986; Flay et al., 2005; Glasgow et al., 2003). Il s’agit probablement de la caractéristique la plus emblématique de la recherche d’effectivité. Certains auteurs recommandent aussi de restreindre l’usage de procédures pour augmenter l’observance des participants à l’intervention (p. ex. la relance de participants qui ne se présentent pas à certaines rencontres ou le recours à des incitatifs financiers), de limiter les contraintes imposées aux intervenants pour augmenter leur adhésion au protocole d’intervention (p. ex. la supervision intensive par l’équipe de recherche) et, de limiter les ressources et l’intensité du soutien qui leur est offert (Thorpe et al., 2009).

Cela dit, il importe de retenir ici qu’il ne s’agit pas de retirer toute forme de soutien aux milieux et aux intervenants, mais bien de retirer tout soutien « artificiel » de l’équipe de recherche qui n’existera plus une fois l’étude terminée (Roy-Byrne et al., 2003). Cet enjeu n’est pas trivial. Au final, une étude d’effectivité sera d’un intérêt limité si elle ne sert qu’à confirmer qu’une intervention ne fonctionne pas en l’absence de soutien aux intervenants et milieux, puisqu’il est clair que l’absence d’un soutien adéquat garantit virtuellement l’échec de la mise en oeuvre d’une IFP en pratique (Gottfredson et al., 2015). Il est beaucoup plus utile d’effectuer un travail préalable avec les milieux afin de déterminer les modalités de soutien qui devront (et pourront réalistement) être mises en place dans la pratique courante et d’évaluer l’intervention telle que mise en oeuvre sur la base de ces modalités de soutien. L’étude peut alors contribuer à valider l’intervention et les conditions permettant de la mettre en oeuvre de manière satisfaisante en pratique. Déterminer la nature et le dosage du soutien à offrir aux milieux et intervenants représente un enjeu important en recherche d’effectivité et il est souvent pertinent d’en faire un objet de recherche en soi, ce qui peut être fait dans une étude hybride effectivité-transfert (voir la section « méthodes et analyses complémentaires »).

Enfin, une dernière stratégie destinée à maximiser la validité écologique est de réduire l’influence de la collecte de données sur le contexte naturel d’intervention. Il est préférable de simplifier les procédures de recherche en effectuant des évaluations par téléphone ou par le biais d’internet (Marchand et al., 2011; Roy-Byrne et al., 2003 et en privilégiant le recours aux mesures de suivi courantes (dossiers électroniques, systèmes de données administratives, etc.) (Thorpe et al., 2009). Lorsqu’elles sont disponibles et accessibles, ces mesures augmentent aussi l’utilité pratique des résultats. Idéalement, l’ensemble des procédures de recherche, incluant le recrutement et la collecte des mesures, devraient approximer les procédures mises en place en pratique et être prises en charge par les intervenants plutôt que par l’équipe de recherche.

Orientation 2. Maximiser la validité externe

La deuxième orientation méthodologique de la recherche d’effectivité est de maximiser la validité externe, qui renvoie au degré de généralisation potentielle des résultats d’une étude au-delà de son contexte propre (Shadish et al., 2002). La validité externe concerne la capacité de généraliser les effets d’une intervention à différentes Unités (participants), différents Traitements (variantes de l’intervention), différents Outcomes (différentes mesures du changement chez les participants ou mêmes mesures à des moments différents) et différents Settings (milieux) – ce qui peut être résumé par l’acronyme UTOS (Cronbach, Glesser, Nanda et Rajaratnam, 1972). La validité externe et la validité écologique sont des concepts reliés : la validité écologique des méthodes utilisées dans une étude augmente la validité externe de ses résultats en facilitant leur généralisation à des contextes du « vrai monde ». Cependant, la validité externe est un concept plus large qui touche la question suivante : est-ce que l’intervention fonctionne dans toutes les conditions du « vrai monde » ou seulement dans certaines conditions précises (certains participants, interventions, settings et/ou outcomes)?

On peut favoriser la validité externe d’une étude d’effectivité en utilisant une stratégie d’échantillonnage qui rejoint la plus grande diversité possible de milieux, d’intervenants et de participants concernés par l’intervention. Cela signifie que l’échantillon devrait être construit explicitement pour représenter l’hétérogénéité des acteurs et environnements ciblés et que les critères d’exclusion devraient être réduits au minimum. Les essais multi-sites (multisite trials) peuvent être particulièrement pertinents pour atteindre ces objectifs (Glasgow et al., 2003; Marchand et al., 2011; Roy-Byrne et al., 2003; Sussman, Valente, Rohrbach, Skara et Pentz, 2006). Tous les participants susceptibles de recevoir l’intervention dans la pratique courante devraient être inclus dans une étude d’effectivité, indépendamment de leur motivation ou de la spécificité de leur problème d’adaptation. De la même façon, l’ensemble des milieux et intervenants ciblés devraient être représentés dans l’échantillon, incluant des milieux plus réticents ou moins motivés. Il est utile d’inclure des mesures multiples des outcomes d’intérêt, de même qu’un suivi à long terme de l’intervention, idéalement pour un minimum de six mois (Flay et al., 2005). Ce suivi devrait évaluer à la fois le maintien de la mise en oeuvre de l’intervention (institutionnalisation) et ses effets à travers le temps (Glasgow et Emmons, 2007; Glasgow et al., 2006; Glasgow et al., 2003; Green, 2006), ce qui permet d’examiner des questions relatives à la durabilité (sustainability) (Wiltsey Stirman et al., 2012).

Une autre stratégie servant à augmenter la validité externe d’une étude d’effectivité est d’analyser les sources de variation des effets d’une intervention (Segal et al., 2012; Weiss, Bloom et Brock, 2013). Ces analyses prennent typiquement la forme d’analyses de modération qui servent à déterminer si les effets d’une intervention diffèrent systématiquement selon les caractéristiques des participants, du contexte de mise en oeuvre, des intervenants impliqués et des variantes de l’intervention. Ces analyses permettent d’aller au-delà de l’effet principal d’une intervention et de préciser les conditions favorables ou défavorables à ses effets. Ces analyses peuvent aussi contribuer à identifier empiriquement les composantes indispensables (core components) et modifiables d’une intervention (Blakely et al., 2002; Castro, Barrera et Martinez, 2004). La recherche d’effectivité offre un contexte optimal pour analyser les sources de variation des effets d’une intervention puisqu’elle vise explicitement à inclure l’hétérogénéité naturelle des conditions d’intervention. Il est donc recommandé de prévoir systématiquement l’analyse des sources de variations dans ce genre d’étude (Gottfredson et al., 2015). Cette dernière recommandation implique que la puissance statistique d’une étude devrait être prévue en fonction de cette analyse des sources de variations et non seulement en fonction de l’analyse des principaux effets de l’intervention.

On peut recourir à plusieurs outils pour favoriser la validité externe d’une étude d’effectivité. Le cadre RE-AIM (Reach, Effectiveness, Adoption, Implementation, Maintenance; Glasgow, Vogt et Boles, 1999) développé en santé publique peut être particulièrement utile. Contrairement aux cadres traditionnels, RE-AIM accorde autant d’importance à la portée d’une intervention qu’à ses effets. Ce cadre met à la disposition de la communauté scientifique une série de moyens pour documenter la couverture et la représentativité de la population rejointe par rapport à une population ciblée (www.re-aim.org). Il met également l’accent sur le maintien de la mise en oeuvre et des effets d’une intervention à l’aide de la composante Maintien (« maintenance »). Le schéma CONSORT modifié pour les essais pratiques/pragmatiques (Zwarenstein et al., 2008) et les critères de qualité de Green et Glasgow (2006) sont deux autres outils utiles pour guider la manière de rapporter les caractéristiques d’une étude afin de circonscrire la validité externe de ses résultats.

Orientation 3. Maximiser l’utilité pratique

La troisième orientation de la recherche d’effectivité consiste à maximiser l’utilité pratique des résultats (Dunn, 2013; Tunis et al., 2003). La première recommandation à cet égard est de contraster l’intervention cible à des alternatives cliniquement pertinentes plutôt qu’à l’absence d’intervention ou à un placebo (Dunn, 2013; Thorpe et al., 2009; Tunis et al., 2003). Comparer une intervention à une condition contrôle sans intervention permet d’estimer l’effet causal théorique de cette intervention mais ne répond pas à la question la plus importante pour un gestionnaire ou un intervenant : « devrais-je déployer l’énergie et les ressources nécessaires pour mettre en oeuvre cette intervention plutôt qu’une autre? » De ce point de vue, l’alternative par défaut dans une recherche d’effectivité devrait être l’intervention courante (Treatment As Usual; TAU) bien que la comparaison de plusieurs interventions démontrées efficaces soit encore plus utile dans un domaine où l’intervention atteint un stade de développement avancé. La recherche comparant les effets de plusieurs IFP dans le « vrai monde » est appelée recherche d’effectivité comparative (Comparative Effectiveness Research; CER; Glasgow et Steiner, 2012).

Une autre stratégie servant à augmenter l’utilité pratique des résultats est de colliger le plus d’informations possibles pour guider la prise de décision des acteurs sur le terrain (Glasgow et Emmons, 2007; Glasgow et al., 2006; Marchand et al., 2011; Roy-Byrne et al., 2003; Thorpe et al., 2009; Tunis et al., 2003). Il est recommandé d’inclure un maximum d’informations quant aux ressources nécessaires à la mise en oeuvre d’un programme, en particulier les coûts prévisibles. Il est également recommandé d’inclure des mesures d’effets diversifiées, globales et prioritaires pour les milieux et les intervenants (fonctionnement général, qualité de vie, etc.) (Tunis et al., 2003). Tel que mentionné précédemment, le recours à des mesures déjà utilisées et recueillies par les milieux (données administratives, cliniques) est à privilégier. Enfin, il est essentiel de documenter les effets non anticipés d’une intervention (Marchand et al., 2011) compte tenu de possibles effets iatrogènes (Dishion, McCord et Poulin, 1999).

Deux approches peuvent être recommandées afin de faire valoir le point de vue des principaux intéressés dans une étude d’effectivité et de documenter un large éventail d’effets (incluant des effets non anticipés). La première de ces approches consiste à inclure des données qualitatives et de recourir à des méthodes mixtes (Creswell et Clark, 2007). Les données qualitatives complémentent les données quantitatives de plusieurs façons, notamment en offrant des résultats plus valides, plus complets, plus nuancés et plus représentatifs des préoccupations des acteurs. Les méthodes mixtes sont de plus en plus valorisées en recherche d’effectivité (Albright, Gechter et Kempe, 2013). La deuxième approche consiste à privilégier des méthodes participatives (Bogart et Uyeda, 2009; Brown et al., 2012; Glasgow, Green, Taylor et Stange, 2012; Weissberg et Greenberg, 1998) qui associent gestionnaires, intervenants et chercheurs dans l’ensemble des décisions relatives à la recherche. Les approches mixtes et participatives sont compatibles avec les devis expérimentaux traditionnels et leur ajout est fortement recommandé dans toute recherche d’effectivité.

Orientation 4. Préserver un bon niveau de validité interne

La quatrième orientation de la recherche d’effectivité est de préserver un bon niveau de validité interne, qui réfère au degré de justesse des inférences causales tirées d’une étude (Shadish et al., 2002). Dans le cas présent, la validité interne concerne la capacité d’attribuer les effets observés à l’intervention étudiée. Préserver la validité interne est un défi complexe dans une recherche d’effectivité puisque la centration sur les autres orientations (validité écologique, validité externe, utilité pratique) réduit la capacité d’appliquer du contrôle expérimental (Clarke, 1995; Flay et al., 2005). Cette quatrième orientation a des implications au niveau de l’évaluation de la mise en oeuvre et des effets d’une intervention.

Évaluation de la mise en oeuvre. L’évaluation de la mise en oeuvre d’une intervention est essentielle en recherche d’effectivité (Clarke, 1995; Flay et al., 2005; Marchand et al., 2011). Contrairement à la recherche d’efficacité où l’intervention et ses conditions de mise en oeuvre sont très homogènes et standardisées, la recherche d’effectivité laisse libre cours à des variations d’un milieu à l’autre, d’un intervenant à l’autre, etc. L’évaluation de la mise en oeuvre est donc nécessaire dans ce contexte pour relier les effets observés aux interventions réellement mises en place ou dans certains cas, pour déterminer si l’absence d’effets est fonction de l’intervention elle-même ou de sa mise en oeuvre inadéquate.

L’évaluation de la mise en oeuvre devrait documenter la fidélité de l’intervention, c’est-à-dire le degré de conformité entre l’intervention prévue par les concepteurs et celle qui est réellement mise en place (Dane et Schneider, 1998; Domitrovich et al., 2008; Domitrovich et Greenberg, 2000). Les IFP sont rarement mises en oeuvre telles que prévues (Elliott & Mihalic, 2004; Ennett et al., 2003) et les effets dérivés des interventions dépendent fortement de la fidélité de leur mise en oeuvre (Durlak et DuPre, 2008). La fidélité est typiquement mesurée selon cinq dimensions (Dane et Schneider, 1998; Durlak et DuPre, 2008; Dusenbury, Brannigan, Falco et Hansen, 2003; Fagan, Hanson, Hawkins et Arthur, 2008) : 1) l’adhésion ou la conformité du contenu livré par rapport au contenu prévu; 2) l’exposition ou la conformité de l’intensité ou dosage par rapport à l’exposition prévue; 3) la qualité de l’animation ou la manière dont le programme est livré par les animateurs; 4) la réponse des participants ou leur engagement dans le programme et 5) la différentiation ou le degré avec lequel les composantes principales de l’intervention peuvent être distinguées des composantes d’autres interventions.

L’évaluation de la mise en oeuvre devrait aussi documenter les adaptations apportées à l’intervention, qu’elles soient volontaires ou non (Backer, 2001; Blakely et al., 2002; Durlak, 1998). Ces adaptations peuvent inclure : (1) les retraits ou les soustractions d’éléments de contenu; (2) l’altération de la nature de certains éléments de contenu et (3) les changements dans la manière de livrer le programme (dosage, nombre de séances) (Backer, 2001). Malgré l’association entre la fidélité et les effets des interventions, certaines adaptations doivent presque toujours être apportées aux interventions pour faciliter leur mise en oeuvre en pratique et ces adaptations ne sont pas forcément délétères (Backer, 2001; Durlak, 1998). Une certaine flexibilité dans la mise en oeuvre peut permettre d’ajuster plus convenablement une intervention aux réalités locales, particulièrement lorsque cette intervention est utilisée auprès d’une nouvelle communauté culturelle (Blakely et al., 2002; Castro et al., 2004; Lee, Altschul et Mowbray, 2008). Étant donné que l’impact des adaptations sur les effets d’une intervention est inconnu a priori, un des intérêts de la recherche d’effectivité est de contribuer à identifier empiriquement ce qui peut ou ne peut pas être modifié dans une intervention.

Évaluation des effets. Autant que possible, la recherche d’effectivité devrait être conduite à l’aide de devis expérimentaux ou quasi-expérimentaux qui permettent de tirer des inférences causales robustes (Figures 3 et 4). Lorsque le contexte le permet, le devis expérimental avec randomisation individuelle des participants aux conditions demeure optimal et devrait être privilégié (Flay et al., 2005; Mercer et al., 2007). Cependant, il est souvent impossible de mettre en place un tel devis dans une étude d’effectivité pour des raisons pratiques et/ou éthiques (Clarke, 1995; Flay et al., 2005; Glasgow et al., 2003; Marchand et al., 2011; Roy-Byrne et al., 2003). Par exemple, il peut être inacceptable pour des intervenants de ne pas offrir une intervention à certains patients si cette intervention a montré des bénéfices dans une étude d’efficacité préalable. La recherche d’effectivité exige donc généralement de trouver une alternative au devis expérimental classique utilisé dans les ECR d’efficacité (Mercer et al., 2007).

Dans ce contexte, une première option est d’adapter le devis expérimental (Glasgow, 2013; Glasgow, Magid, Beck, Ritzwoller et Estabrooks, 2005; Horn et Gassaway, 2007; Hotopf, 2002; Mercer et al., 2007; Patsopoulos, 2011; Pentz, 2004; Treweek et Zwarenstein, 2009). Une adaptation souvent indiquée est de randomiser les milieux aux conditions (Cluster RCT; Bland, 2004) plutôt que de randomiser les participants de manière individuelle. L’utilisation d’un essai randomisé en cluster permet de limiter le risque d’effets de contamination tout en facilitant considérablement la collecte des données d’un point de vue logistique. Une autre façon d’adapter le devis randomisé est de recourir à un devis par liste d’attente dynamique (Dynamic waitlist, Stepwedge; Brown, Wyman, Guo et Pena, 2006). Dans un tel devis, tous les participants reçoivent l’intervention, mais à un moment différent fixé aléatoirement. Ce devis peut être mis en place dans le contexte d’un devis randomisé en cluster où la mise en oeuvre de l’intervention dans différents milieux est échelonnée à travers le temps. Par exemple, la Figure 3d présente un devis dans lequel trois groupes de milieux reçoivent l’intervention à trois moments différents. Certaines mesures sont un post-test pour certains groupes et un prétest pour d’autres et il devient alors possible d’analyser les effets en comparant les conditions des groupes qui ont et n’ont pas reçu l’intervention à chaque temps de mesure, de même qu’à travers le temps dans une même condition (avant et après l’intervention). En plus de préserver une forme de randomisation, un devis par liste d’attente dynamique éclipse les problèmes éthiques liés à l’absence d’intervention chez quelque groupes témoin et facilite la logistique de la recherche en mettant en oeuvre l’intervention de façon séquentielle dans un nombre restreint de milieux à la fois (Brown, Mason et Brown, 2014).

Figure 3

Exemples de devis randomisés (classiques et adaptés)

Figure 4

Exemples de devis quasi-expérimentaux

Une autre alternative lorsqu’un devis expérimental classique ne peut être utilisé est de recourir à un devis adaptatif (adaptive design). Dans un tel devis, l’information cumulative colligée pendant l’étude sert à modifier en cours de route sa conduite (Brown et al., 2014; Brown et al., 2009). Dans le contexte d’une recherche d’effectivité, les devis adaptatifs peuvent être utiles pour ajuster la recherche en fonction de considérations pratiques, améliorer la convenance et la qualité d’une intervention en cours de route (ajustement du dosage et du contenu), incorporer les préférences des acteurs (clients et intervenants) quant aux choix des interventions livrées ou arrêter de manière prématurée des interventions clairement inefficaces (Brown et al., 2014; Brown et al., 2009). Les devis adaptatifs impliquent typiquement plusieurs randomisations. Dans l’exemple de la Figure 3e, la probabilité de randomisation des milieux à deux conditions (intervention vs contrôle) est modifiée en cours de route de .50–.50 à .75–.25 en fonction d’analyses intérimaires indiquant un avantage de l’intervention relativement à la condition contrôle. Cet ajustement de la randomisation permet de diminuer le nombre des participants exposés à une condition contrôle moins efficace, tout en préservant la validité interne du devis.

Enfin, lorsque toute forme de randomisation s’avère impossible, il est possible de recourir à un devis quasi-expérimental. Les meilleures options sont 1) un devis de type régression-discontinuité, 2) un devis avec série temporelle interrompue dans un seul ou préférablement plusieurs groupes et, en dernier recours, 3) un devis avec groupes non équivalents créés par assignation non aléatoire, dans la mesure où l’on peut démontrer l’équivalence des groupes avant l’intervention (Gottfredson et al., 2015). Ces devis sont discutés en détail dans la plupart des textes introductifs de méthodologie scientifique (Shadish et al., 2002). Peu importe la nature du devis mis en place, des stratégies statistiques appropriées devraient être utilisées pour modéliser les effets de l’intervention. Par exemple, des analyses multi-niveaux devraient être utilisées si les participants sont nichés dans des milieux ou des groupes d’intervention. Des analyses de type « intention-de traiter » (Gupta, 2011) devraient systématiquement être employées pour tenir compte de l’information provenant de participants dont les données sont incomplètes puisque l’attrition est souvent plus importante dans une étude d’effectivité que dans une étude d’efficacité (Singal, Higgins et Waljee, 2014).

Méthodes et analyses complémentaires

Certaines méthodes complémentaires peuvent bonifier la contribution d’une recherche d’effectivité. Dans la plupart des situations, il est possible de prévoir des analyses d’efficience (ou économiques), qui visent à comparer différents choix d’interventions en fonction de leurs coûts et leurs conséquences (Drummond, O’Brien et Stoddard, 2005). Les analyses d’efficience sont particulièrement précieuses pour les gestionnaires et intervenants qui doivent choisir parmi plusieurs approches efficaces ou effectives dans un contexte de ressources limitées. La question n’est donc pas simplement de savoir si une intervention fonctionne, mais bien de déterminer si l’investissement dans cette intervention représente la meilleure utilisation possible des ressources disponibles. En documentant les coûts associés à la mise en place des interventions étudiées, il devient relativement simple de dériver un ratio coût-effectivité prenant la forme suivante (Caulkins, Nicosa et Pacula, 2014) :

Le ratio coût-effectivité permet de standardiser la comparaison des coûts associés aux bénéfices relatifs de plusieurs interventions lorsque la même mesure d’effet est utilisée pour évaluer les résultats de ces interventions. Par exemple, deux interventions visant à prévenir la dépression pourraient produire des effets équivalents, mais coûter respectivement 1,000$ et 5,000$ par cas de dépression évité, ce qui favoriserait le choix de la première intervention. D’autres analyses d’efficience peuvent être greffées à une étude d’effectivité, incluant les analyses de compensation des coûts (cost-offset), de coût-utilité (cost-utility) et de coût-bénéfice (cost-benefit) (voir Caulkins et al., 2014).

Une deuxième méthode complémentaire consiste à étudier simultanément l’effectivité d’une intervention et les stratégies pour faciliter son transfert vers la pratique. Ce type d’étude hybride effectivité-transfert peut contribuer à préciser les stratégies les plus efficaces pour mettre en oeuvre les IFP, qui demeurent peu connues et font l’objet de la nouvelle Science du transfert et de la diffusion (Implementation Science) (Proctor et al., 2009; Spoth et al., 2013). Trois types d’études hybrides sont décrites dans la littérature (Bernet, Willens et Bauer, 2013; Curran, Bauer, Mittman, Pyne et Stetler, 2012). Dans une étude hybride de type I, la primauté est accordée à l’effectivité de l’intervention, mais des données secondaires (acceptabilité, faisabilité, etc.) concernant ses conditions de transfert sont colligées par des méthodes qualitatives ou mixtes centrées sur les processus. Ces études peuvent informer le développement d’études futures dans lesquelles des stratégies de transfert seront testées de manière expérimentale. Dans une étude hybride de type II, une importance équivalente est accordée au test expérimental de l’effectivité de l’intervention et d’une (ou plusieurs) stratégie(s) de transfert prédéterminées. Les devis en cluster, par liste d’attente dynamique ou adaptatifs, représentent des options de choix pour ce type d’études (Figure 5). Dans de tels devis, les effets des stratégies de transfert sont déterminés en fonction du niveau de mise en oeuvre obtenu dans chaque cas, alors que les effets de l’intervention sont déterminés en fonction du changement chez les participants. Enfin, dans une étude hybride de type III, la primauté est accordée à l’évaluation d’une ou plusieurs stratégie(s) de transfert et des données secondaires sont colligées afin de documenter les effets de l’intervention chez les participants. Étant donné que l’effectivité d’une intervention est largement dépendante des conditions dans lesquelles cette intervention est mise en oeuvre, l’utilisation de devis hybrides est de plus en plus prévalente et recommandée.

Figure 5

Exemple de devis hybride effectivité-implantation (type II)

Enfin, il peut être utile dans une étude d’effectivité de prévoir des analyses de médiation visant à valider les mécanismes d’action d’une intervention. Toutefois, comme la mise en oeuvre d’une intervention est souvent variable dans ce type d’études, les études d’efficacité sont susceptibles de fournir un terrain plus fertile pour détecter et valider ces mécanismes. De manière générale, les études d’efficacité conviennent mieux aux analyses de médiation (déterminer les mécanismes d’une intervention), alors que les études d’effectivité sont particulièrement utiles pour les analyses de modération (déterminer les sources de variation des effets d’une intervention).

Implications de la recherche d’effectivité

Il est clair que le modèle de validation des IFP a trop longtemps reposé sur une preuve exclusivement fondée sur la validité interne et que ce modèle contribue à perpétuer l’écart recherche-pratique (Glasgow et Emmons, 2007; Glasgow et al., 2006; Green, 2001; Green et Glasgow, 2006). Pour que les IFP intègrent plus harmonieusement la pratique courante, la recherche doit produire des preuves plus représentatives des réalités de cette pratique, que certains nomment des « preuves fondées sur la pratique » (Ammerman, Smith et Calancie, 2014; Green, 2006). La recherche d’effectivité représente une des principales stratégies pour atteindre cet objectif, quoique d’autres approches peuvent aussi y contribuer (p. ex. partenariats en recherche-action participative, évaluation de programmes, etc.). La grande force de la recherche d’effectivité réside dans la recherche d’un compromis explicite entre considérations théoriques et pratiques dans l’espoir de fournir une preuve qui est d’une part applicable (validité écologique), généralisable (validité externe) et pertinente (utilité) en pratique et, d’autre part, suffisamment robuste (validité interne) pour satisfaire les standards de la communauté scientifique (Green et Glasgow, 2006).

La recherche d’effectivité peut également contribuer à accélérer le transfert des IFP de la recherche vers la pratique. En produisant une information contextualisée et centrée sur la prise de décision des utilisateurs, ce type de recherche permet aux gestionnaires et aux intervenants de répondre à des questions prioritaires, telles que :

Cette intervention peut-elle fonctionner dans mon contexte?

Quelles adaptations puis-je y apporter sans altérer les bénéfices de cette intervention?

Quelles conditions de mise en oeuvre dois-je mettre en place?

Quels usagers devraient être sélectionnés?

Le transfert des IFP de la recherche vers la pratique peut être accélérée encore davantage par une analyse comparant l’efficience de plusieurs interventions et/ou l’utilisation d’un devis hybride effectivité-transfert permettant d’étudier à la fois l’effectivité d’une intervention et les conditions/stratégies permettant de faciliter son transfert de la recherche vers la pratique. Compte tenu de l’importance grandissante des analyses économiques et de la Science du transfert et de la diffusion (Implementation Science), il s’avère utile dans la plupart des études d’effectivité de prévoir, au minimum, l’analyse d’un ratio coût-effectivité et une étude des obstacles et facilitants à la mise en oeuvre de l’intervention en pratique (devis hybride de type I).

La recherche d’effectivité comporte également des implications souvent négligées par rapport au développement même des interventions. En effet, prévoir de tester une intervention dans une optique d’effectivité implique d’adopter un mode de développement centré sur le transfert et la diffusion éventuelle de cette intervention dans la pratique (design for fidelity and/or dissemination; Allen, Linnan et Emmons, 2012; Brownson, Jacobs, Tabak, Hoener et Stamatakis, 2013), c’est-à-dire de penser son développement en fonction des réalités et des considérations du terrain. Dès lors, des notions de faisabilité, de simplicité, d’applicabilité, de coûts et de flexibilité prennent de l’importance. À l’inverse, les interventions validées par la recherche d’efficacité sont souvent trop longues, trop coûteuses et trop exigeantes pour être mises en oeuvre à large échelle et font habituellement fi des mécanismes susceptibles de soutenir leur mise en oeuvre (Ammerman, Smith et Calancie, 2014; Comitee on the Prevention of Mental Disorders and Substance Abuse among Children, 2009; Rotheram-Borus et Duan, 2003). Réfléchir d’emblée en termes d’effectivité peut donc non seulement bonifier la manière de valider les interventions et de les transférer dans la pratique, mais aussi en générer d’autres qui sont mieux adaptées à la pratique. Une telle démarche peut aussi encourager les chercheurs à sortir d’un modèle strictement linéaire en évaluant du même coup l’efficacité ET l’effectivité d’interventions directement développées, utilisées et pré-testées sur le terrain (parfois appelées innovations locales). L’avantage de ce scénario est d’éviter de déployer des ressources substantielles pour tester l’efficacité d’une intervention dont les effets ne seront jamais réalistement reproduits dans la pratique courante.

Enfin, la recherche d’effectivité peut apporter une contribution locale toute particulière. En effet, la majorité des IFP disponibles ont été développées et testées hors du Québec dans un contexte linguistique, culturel, organisationnel et politique différent. Il n’est donc pas très utile d’investir dans une nouvelle évaluation d’efficacité de ces interventions puisqu’il est déjà établi qu’elles peuvent fonctionner. Cependant, il n’est pas non plus prudent d’investir immédiatement des ressources massives pour diffuser ces interventions à large échelle puisqu’il n’est pas assuré qu’elles soient adaptées à la réalité de la pratique locale. La recherche d’effectivité peut donc se révéler particulièrement utile pour déterminer si des IFP validées hors Québec peuvent être mises en place et produire les effets escomptés dans le contexte de la pratique québécoise avant qu’une décision soit prise quant à leur diffusion à large échelle.

Recommandations

En guise de conclusion, voici quelques recommandations destinées aux différents acteurs impliqués dans la validation des IFP au Québec :

Pour valider une intervention ou un programme de manière complète, les chercheurs devraient viser non seulement à démontrer son efficacité mais également son effectivité.

Ces mêmes chercheurs devraient concevoir l’évaluation d’une intervention en fonction du type de preuve qu’ils souhaitent produire (efficacité et/ou effectivité) et décrire leur étude en regard des concepts et outils utilisés dans la littérature scientifique (p.ex : grille PRECIS; Thorpe et al., 2009), en tenant compte du fait qu’une étude partage souvent des caractéristiques d’efficacité et d’effectivité.

Les spécialistes du transfert de connaissances qui produisent des recensions systématiques, guides de pratique et répertoires d’IFP devraient tenir compte de la distinction entre preuve d’efficacité et d’effectivité et accorder un statut particulier à la preuve d’effectivité, tel que suggéré par le modèle de la SPR (Flay et al., 2005; Gottfredson et al., 2015).

Les professeurs et les chargés de cours devraient intégrer les méthodes de la recherche d’effectivité de manière plus systématique dans la formation des futurs intervenants et chercheurs appelés à concevoir, évaluer et transférer des IFP.

Les différents acteurs concernés par le développement et la validation des IFP (chercheurs, organismes subventionnaires, organismes de transfert de connaissances, milieux de pratiques, etc.) devraient prioriser explicitement la recherche d’effectivité de même que d’autres méthodes permettant d’étudier les interventions dans la pratique courante.

Évidemment, une telle priorisation exige le développement de capacités conséquentes, à commencer par la mise en place de partenariats solides et durables entre chercheurs et milieux de pratiques. Réaliser une bonne étude d’effectivité représente un défi considérable puisque ce type de recherche exige habituellement des échantillons très larges, des analyses complexes (p.ex. analyses multi-niveaux), une équipe de chercheurs pragmatique et diversifiée, l’établissement et le maintien de partenariats recherche-pratique fonctionnels et, surtout, un délicat travail d’équilibre entre des orientations méthodologiques contradictoires, en particulier en ce qui concerne les validités internes et externes (Clarke, 1995; Marchand et al., 2011; Roy-Byrne et al., 2003). Malgré ces défis, sinon grâce aux différents compromis qui les caractérisent, la recherche d’effectivité représente une stratégie particulièrement prometteuse dans la quête d’une meilleure conciliation recherche-pratique.

Appendices

Bibliographie

- Albright, K., Gechter, K. et Kempe, A. (2013). Importance of mixed methods in pragmatic trials and dissemination and implementation research. Academic Pediatrics, 13(5), 400-407.

- Allen, J. D., Linnan, L. A. et Emmons, K. M. (2012). Fidelity and its relationship to implementation effectiveness, adaptation, and dissemination. Dans R. C. Brownson, G. A. Colditz et E. K. Proctor (Dir.), Dissemination and implementation research in health (p. 305-326). New York, NY: Oxford University Press.

- Ammerman, A., Smith, T. W. et Calancie, L. (2014). Practice-based evidence in public health: Improving reach, relevance, and results. Annual Review of Public Health, 35, 47-63.

- Archambault, I. Janosz, M., Pascal, S., Lecoq, A., Goulet, M.et Christenson, L. S. (2015). Évaluation de l’efficacité du programme d’intervention Check and Connect à l’école primaire. Manuscrit soumis pour publication.

- Backer, T. E. (2001). Finding the balance: Program fidelity and adaptation in substance abuse prevention: A state of the art review. Rockville, MD: Center for Substance Abuse Prevention, Substance Abuse Mental Health Services Administration.

- Bausell, R. B. (2006). Translation research: Introduction to the special issue. Evaluation in the Health Professions, 29(1), 3-6.

- Bernet, A. C., Willens, D. E. et Bauer, M. S. (2013). Effectiveness-implementation hybrid designs: Implications for quality improvement science. Implementation Science: IS, 8(Suppl 1), S2-S2.

- Blakely, C., Mayer, J., Gottschalk, R., Schmitt, N., Davidson, W., Roitman, D. et Emshoff, J. (2002). The fidelity-adaptation debate: Implications for the implementation of public sector social programs. Dans T. Revenson, A. D’Augelli, S. French, D. Hughes, D. Livert, E. Seidman, M. Shinn et H. Yoshikawa (Dir..), A quarter century of community psychology (p. 163-179). New York, NY: Klewer Academic.

- Bland, J. M. (2004). Cluster randomised trials in the medical literature: Two bibliometric surveys. BMC Medical Research Methodology, 4, 21-21.

- Bogart, L. M. et Uyeda, K. (2009). Community-based participatory research: Partnering with communities for effective and sustainable behavioral health interventions. Health psychology: Official journal of the Division of Health Psychology, American Psychological Association, 28(4), 391-393.

- Bowen, F., Rondeau, N., Fortin, F., Dias, T., Bélanger, J., Desbiens, N., Janosz, M., ..., Lacroix, M. (2006). Rapport final d’évaluation des impacts du programme Vers le pacifique pour les quatre années de sa mise en oeuvre (2001-2005). Montréal, QC : Groupe d’étude sur la médiation en milieu scolaire (GEMMS).

- Bronfenbrenner, U. (1979). The ecology of human development: Experiments by nature and design. Cambridge, MA: Harvard University Press.

- Brown, C. H., Kellam, S. G., Kaupert, S., Muthen, B. O., Wang, W., Muthen, L. K., . . . McManus, J. W. (2012). Partnerships for the design, conduct, and analysis of effectiveness, and implementation research: experiences of the prevention science and methodology group. Administration and Policy in Ment Health and Mental Health Services Research, 39(4), 301-316.

- Brown, C. H., Mason, W. A. et Brown, E. C. (2014). Translating the intervention approach into an appropriate research design: The next-generation adaptative designs for effectiveness and implementation research. Dans Z. Sloboda et H. Petras (Dir.), Defining prevention science (p. 363-388). New York, NY: Springer.

- Brown, C. H., Ten Have, T. R., Jo, B., Dagne, G., Wyman, P. A., Muthen, B. et Gibbons, R. D. (2009). Adaptive designs for randomized trials in public health. Annual Review of Public Health, 30, 1-25.

- Brown, C. H., Wyman, P. A., Guo, J. et Pena, J. (2006). Dynamic wait-listed designs for randomized trials: New designs for prevention of youth suicide. Clinical Trials, 3(3), 259-271.

- Brownson, R. C., Jacobs, J. A., Tabak, R.G., Hoehner, C.M., et Stamatakis, K.A. (2013). Designing for dissemination among public health researchers: Findings from a national survey in the United States. American Journal of Public Health, 103,1693–1699.

- Brunswick, E. (1956). Perception and the representative design of psychologicalexperiments (2e éd.). Berkeley, CA: University of California Press.

- Castro, F. G., Barrera, M., Jr. et Martinez, C. R., Jr. (2004). The cultural adaptation of prevention interventions: Resolving tensions between fidelity and fit. Prevention Science, 5(1), 41-45.

- Caulkins, J. P., Nicosa, N., & Pacula, R. L. (2014). Economic analysis and policy studies: Special challenges in the prevention sciences. Dans Z. Sloboda et H. Petras (Dir.), Defining prevention science (p. 571-596). New York, NY: Springer.

- Chalkidou, K. et Walley, T. (2010). Using comparative effectiveness research to inform policy and practice in the UK HHS: Past, present and future. Pharmacoeconomics, 28(10), 799-811.

- Chambless, D. L. et Ollendick, T. H. (2001). Empirically supported psychological interventions: Controversies and evidence. Annual Review of Psychology, 52, 685-716.

- Clarke, G. N. (1995). Improving the transition from basic efficacy research to effectiveness studies: Methodological issues and procedures. Journal of Consulting and Clinical Psychology, 63(5), 718-725.

- Comitee on the prevention of mental disorders and substance abuse among children, youth, and young adults: Research advances and promisingi. (2009). Preventing mental, emotional, and behavioral disorders among young people: progress and possibilities. Washington, DC: Nation Academies Press.

- Creswell, J. W. et Clark, V. L. P. (2007). Designing and conducting mixed methods research. Los Angeles, CA: Sage.

- Cronbach, L. H., Glesser, G. C., Nanda, H. et Rajaratnam, N. (1972). The dependability of behavioral measurements: Theory of generalizability for scores and profiles. New York, NY: John Wiley.

- Curran, G. M., Bauer, M., Mittman, B., Pyne, J. M. et Stetler, C. (2012). Effectiveness-implementation hybrid designs: Combining elements of clinical effectiveness and implementation research to enhance public health impact. Medical Care, 50(3), 217-226.

- Dagenais, C. et Ridde, V. (2012). Approches et pratiques en évaluation de programmes (2e éd.). Montréal, QC : Presses de l’Université de Montréal.

- Dane, A. V. et Schneider, B. H. (1998). Program integrity in primary and early secondary prevention: Are implementation effects out of control? Clinical Psychology Review, 18(1), 23-45.

- Delpin-Combe, F., Roubaud, C., Martin-Gaujard, G., Fortin, M. E., Rouch, I. et Krolak-Salmon, P. (2013). Efficacité d’une unité cognitivo-comportementale sur les symptômes psychologiques et comportementaux des démences. Revue neurologique, 169(6-7), 490-494.

- DeRubeis, R. J. et Crits-Christoph, P. (1998). Empirically supported individual and group psychological treatments for adult mental disorders. Journal of Consulting and Clinical Psychology, 66(1), 37-52.

- Dishion, T. J., McCord, J. et Poulin, F. (1999). When interventions harm. Peer groups and problem behavior. American Psychologist, 54(9), 755-764.

- Domitrvich, C. E., Bradshaw, C. P., Poduska, J. M., Hoagwood, K., Buckley, J. A., Olin, S., . . . Ialongo, N. S. (2008). Maximizing the implementation quality of evidence-based preventive interventions in schools: A conceptual framework. Advances in School Mental Health Promotion, 1(3), 6-28.

- Domitrovich, C. E. et Greenberg, M. T. (2000). The study of implementation: current findings from effective programs that prevent mental disorders in school-aged children. Journal of Educational and Psychological Consultation, 11(2), 193-221.

- Drummond, R. F., O’Brien, B. et Stoddard, G. L. (2005). Methods for economic evaluation of health care programmes (3e éd.). New York, NY: Oxford University Press.

- Dubé, E. J. (2012). Données probantes : quelques réflexions sur la nature des preuves et sur certaines preuves dénaturées. Revue québécoise de psychologie, 33(2), 81-96.

- Dunn, G. (2013). Pragmatic trials of complex psychosocial interventions: methodological challenges. Epidemiology and Psychiatric Science, 22(2), 105-109.

- Durlak, J. A. (1998). Why program implementation is important. Journal of Prevention and Intervention in the Community, 17(2), 5-18.

- Durlak, J. A. et DuPre, E. P. (2008). Implementation matters: A review of research on the influence of implementation on program outcomes and the factors affecting implementation. American Journal of Community Psychology, 41(3-4), 327-350.

- Dusenbury, L., Brannigan, R., Falco, M. et Hansen, W. B. (2003). A review of research on fidelity of implementation: Implications for drug abuse prevention in school settings. Health Education Research, 18(2), 237-256.

- Elliott, D. S. et Mihalic, S. (2004). Issues in disseminating and replicating effective prevention programs. Prevention Science, 5(1), 47-53.

- Ennett, S. T., Ringwalt, C. L., Thorne, J., Rohrbach, L. A., Vincus, A., Simons-Rudolph, A. et Jones, S. (2003). A comparison of current practice in school-based substance use prevention programs with meta-analysis findings. Prevention Science, 4(1), 1-14.

- Fagan, A. A., Hanson, K., Hawkins, J. D. et Arthur, M. W. (2008). Bridging science to practice: Achieving prevention program implementation fidelity in the community youth development study. American Journal of Community Psychology, 41(3-4), 235-249.

- Falissard, B. (2009). Psychiatrie de l’adolescent: L’efficacité thérapeutique en question. Revue adolescence, 27(3), 789-795.

- Farkas, L., Cyr, M., Lebeau, T., Lemay, J. et McDuff, P. (2009). L’efficacité de l’approche MASTR-EMDR Auprès d’adolescent(e)s qui ont été agressé(e)s sexuellement. Revue québécoise de psychologie, 29(3), 101-115.

- Flay, B. R. (1986). Efficacy and effectiveness trials (and other phases of research) in the development of health promotion programs. Preventive Medicine, 15(5), 451-474.

- Flay, B. R., Biglan, A., Boruch, R. F., Castro, F. G., Gottfredson, D., Kellam, S., . . . Ji, P. (2005). Standards of evidence: Criteria for efficacy, effectiveness and dissemination. Prevention Science, 6(3), 151-175.

- Glasgow, R. E. (2013). What does it mean to be pragmatic? Pragmatic methods, measures, and models to facilitate research translation. Health Education and Behavior, 40(3), 257-265.

- Glasgow, R. E., & Emmons, K. M. (2007). How can we increase translation of research into practice? Types of evidence needed. Annual Review of Public Health, 28, 413-433.

- Glasgow, R. E., Green, L. W., Klesges, L. M., Abrams, D. B., Fisher, E. B., Goldstein, M. G., . . . Orleans, C. T. (2006). External validity: We need to do more. Annals of Behavioral Medicine, 31(2), 105-108.

- Glasgow, R. E., Green, L. W., Taylor, M. V. et Stange, K. C. (2012). An evidence integration triangle for aligning science with policy and practice. American Journal of Preventive Medicine, 42(6), 646-654.

- Glasgow, R. E., Lichtenstein, E. et Marcus, A. C. (2003). Why don’t we see more translation of health promotion research to practice? Rethinking the efficacy-to-effectiveness transition. American Journal of Public Health, 93(8), 1261-1267.

- Glasgow, R. E., Magid, D. J., Beck, A., Ritzwoller, D. et Estabrooks, P. A. (2005). Practical clinical trials for translating research to practice: Design and measurement recommendations. Medical Care, 43(6), 551-557.

- Glasgow, R. E. et Steiner, J. F. (2012). Comparative effectiveness research to accelerate translation: recommendations for an emerging field of science. Dans R. C. Brownson, G. A. Colditz & E. K. Proctor (Dir.), Dissemination and implementation research in health (p. 72-93). New York, NY: Oxford University Press.

- Glasgow, R. E., Vogt, T. M. et Boles, S. M. (1999). Evaluating the public health impact of health promotion interventions: The RE-AIM framework. American Journal of Public Health, 89(9), 1322-1327.

- Gottfredson, D. C., Cook, T. D., Gardner, F. E., Gorman-Smith, D., Howe, G., Sandler, I. N., & Zafft, K. M. (2015). Standards of evidence for efficacy, effectiveness, and scale-up research in prevention science: Next generation. Prevention Science, 16(7), 893-926.

- Graham, I. D., Logan, J., Harrison, M. B., Straus, S. E., Tetroe, J., Caswell, W. et Robinson, N. (2006). Lost in knowledge translation: Time for a map? Journal of Continuing Education in the Health Professions, 26(1), 13-24.

- Green, L. W. (2001). From research to ‘‘best practices’’ in other settings and populations. American Journal of Health Behavior, 25(3), 165-178.

- Green, L. W. (2006). Public health asks of systems science: to advance our evidence-based practice, can you help us get more practice-based evidence? American Journal of Public Health, 96(3), 406-409.

- Green, L. W. et Glasgow, R. E. (2006). Evaluating the relevance, generalization, and applicability of research: issues in external validation and translation methodology. Evaluation in the Health Professions, 29(1), 126-153.

- Greenwald, P. et Cullen, J. W. (1984). The scientific approach to cancer control. CA: A Cancer Journal for Clinicians, 34, 328-332.

- Gupta, S. K. (2011). Intention-to-treat concept: A review. Perspectives in Clinical Research, 2(3), 109-112.

- Haynes, B. (1999). Can it work? Does it work? Is it worth it? The testing of healthcare interventions is evolving. British Medical Journal, 319(7211), 652–653.

- Higgins, J. P. et Green, S. (Dir.) (2011). Cochrane handbook for systematic reviews of interventions: Collaboration Cochrane. Repéré à www.cochrane-handbook.org.

- Horn, S. D. et Gassaway, J. (2007). Practice-based evidence study design for comparative effectiveness research. Medical Care, 45(10 Supl 2), S50-57.

- Hotopf, M. (2002). The pragmatic randomised controlled trial. Advances in Psychiatric Treatment, 8(5), 326-333.

- Hunsley, J. (2007). Training psychologists for evidence-based practice. Canadian Psychology/Psychologie canadienne, 48(1), 32-42.

- Instituts de Médecine (Etats-Unis) (2009). Initial National Priorities for Comparative Effectiveness Research. Washington, DC: National Academy Press.

- Lee, S. J., Altschul, I. et Mowbray, C. T. (2008). Using planned adaptation to implement evidence-based programs with new populations. American Journal of Community Psychology, 41(3-4), 290-303.

- Marchand, E., Stice, E., Rohde, P. et Becker, C. B. (2011). Moving from efficacy to effectiveness trials in prevention research. Behavior Research and Therapy, 49(1), 32-41.

- Mercer, S. L., DeVinney, B. J., Fine, L. J., Green, L. W. et Dougherty, D. (2007). Study designs for effectiveness and translation research:Identifying trade-offs. American Journal of Preventive Medicine, 33(2), 139-154.

- Merry, S. N. (2013). Preventing depression in adolescents: time for a new approach? JAMA Pediatrics, 167(11), 994-995.

- Moisan, A., Poulin, F., Capuano, F. et Vitaro, F. (2014). Impact de deux interventions visant à améliorer la compétence sociale chez des enfants agressifs de la maternelle. Revue canadienne des sciences du comportement, 46(2), 301-311.

- Nagloo, L., Valero, C., Rehaj, S. et Favrod, J. (2013). Biais d’amplification dans les citations: L’exemple d’une revue systématique de la littérature sur l’efficacité de la thérapie comportementale et cognitive des symptômes psychotiques. L’évolution psychiatrique, 78(1), 119-126.

- National Institute for Health and Clinical Excellence (NICE). (2009). The guidelines manual. Londres, Angleterre: NICE.

- National Heart, Lung, and Blood Institute. (1983). Guidelines for Demonstration and Education Research Grants. Washington, DC: National Heart, Lung, and Blood Institute.

- Norcross, J. C., Beutler, L. E. et Levant, R. F. (2006). Evidence-based practices in mental health: Debate and dialogue on the fundamental questions. Washington, DC: American Psychological Association.

- Patsopoulos, N. A. (2011). A pragmatic view on pragmatic trials. Dialogues in Clinical Neuroscience, 13(2), 217-224.

- Pentz, M. A. (2004). Form follows function: designs for prevention effectiveness and diffusion research. Prevention Science, 5(1), 23-29.

- Poulin, F., Capuano, F., Vitaro, F., Verlaan, P., Brodeur, M., & Giroux, J. (2013). Large-scale dissemination of an evidence-based prevention program for at-risk kindergartners: Lessons learned from an effectiveness trial of the Fluppy program. Dans M. Boivin et K. L.. Bierman (éditeurs). Promoting school readiness and early learning: implications of developmental research for practice (p. 304-328). New York, NY: Guilford Press.

- Proctor, E. K., Landsverk, J., Aarons, G., Chambers, D., Glisson, C. et Mittman, B. (2009). Implementation research in mental health services: An emerging science with conceptual, methodological, and training challenges. Administration and Policy in Mental Health and Mental Health Services Research, 36(1), 24-34.

- Provencher, M. D., St-Amand, J., Hawke, L. D., Baruch, P. et Tremblay, J. (2010). La thérapie cognitivo-comportementale pour le traitement des symptômes dépressifs dans le trouble bipolaire. Journal de thérapie comportementale et cognitive, 20, 61-65.

- Rabin, B. A., Brownson, R. C., Haire-Joshu, D., Kreuter, M. W. et Weaver, N. L. (2008). A glossary for dissemination and implementation research in health. Journal of Public Health Managment Practice, 14(2), 117-123.

- Rotheram-Borus, M. J. et Duan, N. (2003). Next generation of preventive interventions. Journal of the American Academy of Child and Adolescent Psychiatry, 42(5), 518-526.

- Roy-Byrne, P. P., Sherbourne, C. D., Craske, M. G., Stein, M. B., Katon, W., Sullivan, G., . . . Bystritsky, A. (2003). Moving treatment research from clinical trials to the real world. Psychiatric Services, 54(3), 327-332.

- Ruggeri, M., Lasalvia, A. et Bonetto, C. (2013). A new generation of pragmatic trials of psychosocial interventions is needed. Epidemiology and Psychiatric Science, 22(2), 111-117.

- Segal, J. B., Weiss, C. et Varadhan, R. (2012). Understanding heterogeneity of treatment effects in pragmatic trials with an example of a large, simple trial of a drug treatment for osteoporosis (white paper). Baltimore, MD: Center for Medical Technology and Policy.

- Shadish, W. R., Cook, T. D. et Campbell, D. T. (2002). Experimental and quasi-experimental designs for generalized causal inference. Boston, MA: Houghton Mifflin.

- Singal, A. G., Higgins, P. D. R. et Waljee, A. K. (2014). A primer on effectiveness and efficacy trials. Clinical and Translational Gastroenterolology, 5, e45.

- Spoth, R., Rohrbach, L. A., Greenberg, M., Leaf, P., Brown, C. H., Fagan, A., . . . Hawkins, J. D. (2013). Addressing core challenges for the next generation of type 2 translation research and systems: The translation science to population impact (TSci Impact) framework. Prevention Science, 14(4), 319-351.

- Sussman, S., Valente, T. W., Rohrbach, L. A., Skara, S. et Pentz, M. A. (2006). Translation in the health professions: Converting science into action. Evaluation in the Health Professions, 29(1), 7-32.

- Thorpe, K. E., Zwarenstein, M., Oxman, A. D., Treweek, S., Furberg, C. D., Altman, D. G., . . . Chalkidou, K. (2009). A pragmatic-explanatory continuum indicator summary (PRECIS): A tool to help trial designers. Journal of Clinical Epidemiology, 62(5), 464-475.

- Tremblay, M. et Ben Amar, M. (2007). Les interventions efficaces pour aider les fumeurs à renoncer au tabac. Drogues, santé et société, 6(1), 241-281.

- Treweek, S. et Zwarenstein, M. (2009). Making trials matter: pragmatic and explanatory trials and the problem of applicability. Trials, 10(1), 37.

- Tunis, S. R., Stryer, D. B. et Clancy, C. M. (2003). Practical clinical trials: increasing the value of clinical research for decision making in clinical and health policy. JAMA, 290(12), 1624-1632.

- Victora, C. G., Habicht, J.-P. et Bryce, J. (2004). Evidence-based public health: Moving beyond randomized trials. American Journal of Public Health, 94(3), 400-405.

- Weiss, M. J., Bloom, H. S. et Brock, T. (2013). A conceptual framework for studying the sources of variation in program effects. New York, NY: MDRC.

- Weissberg, M. T. et Greenberg, R. (1998). Prevention science and collaborative community action research: Combining the best from both perspectives. Journal of Mental Health, 7(5), 479-492.

- Whicher, D. M., Chalkidou, K., Dhalla, I. A., Levin, L. et Tunis, S. (2009). Comparative effectiveness research in Ontario, Canada: Producing relevant and timely information for health care decision makers. The Milbank Quarterly, 87(3), 585-606.

- Wiltsey Stirman, S., Kimberly, J., Cook, N., Calloway, A., Castro, F. et Charns, M. (2012). The sustainability of new programs and innovations: A review of the empirical literature and recommendations for future research. Implementation Science, 7, 17.

- Zerhouni, E. (2003). Medicine. The NIH Roadmap. Science, 302(5642), 63-72.

- Zwarenstein, M., Treweek, S., Gagnier, J. J., Altman, D. G., Tunis, S., Haynes, B., . . . Moher, D. (2008). Improving the reporting of pragmatic trials: an extension of the CONSORT statement. Bristih Medical Journal, 337, a2390.

List of figures

Figure 1

Phases de développement des interventions selon différents modèles en santé et en sciences sociales (adapté de Flay, 1986; Mercer et al., 2007)

Figure 2

Schéma d’une étude d’effectivité à partir de la grille de critères PRÉCIS (adapté de Thorpe et al., 2009)

Note. Les critères sont indiqués en caractère gras. Les pôles centraux représentent une position « explicative » (efficacité) et les pôles éloignés du centre représentent une position « pragmatique » (effectivité). Le schéma représente une étude ayant une position pragmatique extrême pour chacun des critères.

Figure 3

Exemples de devis randomisés (classiques et adaptés)

Figure 4

Exemples de devis quasi-expérimentaux

Figure 5

Exemple de devis hybride effectivité-implantation (type II)

List of tables

Tableau 1

10.7202/016949ar

10.7202/016949ar