Abstracts

Résumé

Le facteur d’impact, établi par l’Institute for Scientific Information (ISI), est fréquemment utilisé pour évaluer les chercheurs et leurs programmes. Sur la base d’exemples, cet article propose quelques clés pour analyser les conditions et les limites d’interprétation d’indicateurs qui, à l’origine, n’ont pas été conçus pour l’évaluation individuelle. Il présente aussi les conséquences prévisibles des nouvelles technologies d’information, en particulier l’avènement de journaux électroniques, sur la production, la publication et l’évaluation des résultats de la recherche dans les sciences biomédicales.

Summary

The impact factor of scientific reviews, calculated by the Institute for Scientific Information (ISI), is increasingly used to evaluate the performance of scientists and programmes. Bibliometric indicators, originally designed for other purposes than individual evaluation, are very useful tools provided their interpretation is not extrapolated beyond their limits of validity. Here we present a critical analysis of appropriate uses and misuses of bibliometric data based on case studies. We also outline anticipated consequences of new information technologies, such as electronic journals or open access schemes, on the mode of science production, evaluation and dissemination in biomedical sciences.

Article body

L’inflation des articles et la multiplication des expertises compliquent la tâche des instances d’évaluation des universités et des organismes de recherche, qui cherchent à simplifier les critères de jugement des travaux des chercheurs et de leurs programmes. Quoi de plus rassurant à cet égard que des indices apparemment objectifs, reflétant en principe l’intérêt des utilisateurs qui citent les résultats, un peu comme « l’indice d’audience » de la télévision. C’est en partie pour cela que le recours aux indicateurs bibliométriques commercialisés se généralise. Cependant, l’utilisation « profane » de ces indicateurs conduit à leur faire dire davantage que ce qu’avait prévu leur concepteur, Eugène Garfield, fondateur en 1966, de l’Institute for Scientific Information (ISI), qui analyse aujourd’hui plus de 8 500 revues et 25 millions de citations par an.

Nous présentons ici un bilan critique de l’intérêt et des limites d’interprétation de certains indicateurs, en insistant notamment sur le facteur d’impact, indicateur le plus utilisé, et sur les conséquences que risque d’avoir l’avènement des journaux électroniques sur leur usage.

Une grande hétérogénéité entre disciplines

Les principaux indicateurs (Encadré 1) donnent une estimation neutre de l’exploitation des résultats scientifiques, mais ne prennent guère en compte la diversité des stratégies de publication et des besoins des différentes disciplines.

C’est ainsi que les mathématiciens, qui n’ont pas les mêmes pratiques que les biologistes, ont des journaux dont le facteur d’impact est inférieur à celui des grands journaux de biomédecine (2,7 contre 31,7 pour les plus élevés). À l’intérieur même d’une discipline, les facteurs d’impact des journaux généralistes et de spécialités ne sont pas du même ordre de grandeur. C’est aussi le cas des revues dont le succès tient au fait qu’elles publient surtout des articles cliniques ou de synthèse. Une analyse réalisée en 2001 à l’Inserm montre bien les différences d’impact entre disciplines médicales (Figure 1). Il est donc important de tenir compte du contexte disciplinaire pour interpréter les indicateurs.

Figure 1

Variation du facteur d’impact moyen (en 2000) de revues appartenant à différentes disciplines biomédicales.

Une hiérarchie de classement en biologie et médecine

En réalité, il suffirait de ne retenir que quelques grandes catégories pour classer les journaux. Pour la biologie et la médecine, ceux-ci peuvent être regroupés schématiquement en « grands généralistes multidisciplinaires » à fort impact (Nature, Science, PNAS…), qui publient des ensembles originaux d’explications ou des découvertes manifestes (encore qu’y soient parfois publiés des résultats contestables ou fondés sur des analyses superficielles et vite oubliées). Viennent ensuite les « généralistes disciplinaires » (TheJournal of Immunology, The Journal of Biological Chemistry, Endocrinology, Brain…), puis les journaux plus spécialisés (Cerebral Cortex, The Journal of Cognitive Neuroscience, Neuroimage...) qui publient des observations dont l’intérêt est moins immédiatement perceptible que pour la catégorie précédente. Enfin, à la base de cette distribution pyramidale, se trouvent des périodiques à faible impact[1], d’audience très « diluée » (Neurotoxicology, Human Movement Science…), produits par des courants scientifiques parfois concurrents, ainsi que des journaux non anglophones. Chaque catégorie occupe ainsi une « niche » particulière.

Mais la science ne pourrait pas progresser sur la seule base des articles les plus « chauds ». Les théories innovantes sont souvent préparées par la mise en évidence de corrélations dont la signification n’apparaît pas d’entrée de jeu. L’histoire de la découverte de la pathogénie d’Helicobacter pylori, qui a révolutionné la compréhension de plusieurs maladies gastro-intestinales, en est un exemple (Figure 2). Bien que publiée dans The Lancet, la première description de la bactérie par B. Marshall en 1984 [1] n’a d’abord été perçue que comme une curiosité, jusqu’à ce que l’auteur s’administre la bactérie par voie orale pour prouver son rôle pathogène dans la gastrite. L’article publié subséquemment dans le Medical Journal of Australia, dont le facteur d’impact est faible (FI < 2), a pourtant recueilli à ce jour 780 citations [2]. La mise en évidence, en 1990, d’anticorps spécifiques dans le sang des personnes infectées a permis d’établir un lien entre cette infection et le cancer de l’estomac. Vingt ans après la publication princeps, cette découverte a fait l’objet de plusieurs milliers de publications abondamment citées, mais sans effet sur le facteur d’impact du journal qui avait publié le travail original.

Figure 2

Nombre de citations de l’article princeps de B.J. Marshall sur la découverte du rôle de Helicobacter pylori en pathologie gastro-intestinale, paru en 1984 [1].

* Preuve expérimentale des postulats de Koch par Marshall. ** Élaboration des tests sérologiques. *** Découverte du rôle de Helicobacter pylori dans la genèse du cancer de l’estomac.

Un autre exemple du rôle des journaux à faible impact est illustré par le Southwestern Entomologist, qui, avec un facteur d’impact de 0,284, est pourtant le journal de référence pour la description des nouvelles espèces d’insectes semi-désertiques du monde entier. Les espèces nouvelles n’attirent pas toujours une attention immédiate (indice d’immédiateté très bas à 0,02), mais leur inventaire est un prérequis pour les progrès de la zoologie et de la génétique des insectes. D’où l’importante demi-vie des citations de ce journal (plus de dix ans).

Quelle fiabilité accorder aux indicateurs ?

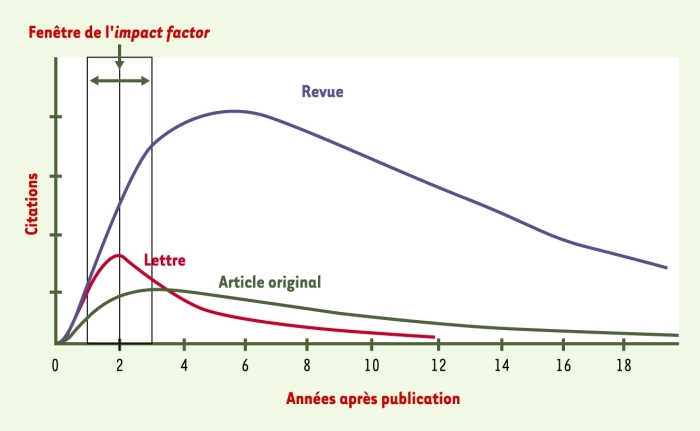

On peut émettre des réserves sur le mode de calcul du facteur d’impact [3]. En effet, celui-ci ne comptabilise, au titre du nombre des publications, que les articles originaux et les revues, mais, au titre des citations, tient compte en plus, des notes, lettres à l’éditeur, correctifs et analyses de livres (Tableau I). Le facteur d’impact est calculé sur la base des deux années suivant la publication et dépend donc uniquement du nombre de citations des articles du journal durant cette période. Or, comme le remarquent M. Amin et M. Mabe [4], le taux de citations passe par un maximum après deux ans pour les « lettres », après deux à trois ans pour les articles originaux, mais seulement après cinq à six ans pour les revues de synthèse (Figure 3) [4]. Les courbes de citations sont plus « plates » (avec de faibles taux de citations durant les deux premières années) en biologie « classique » (physiologie, zoologie, botanique, écologie) où les articles se démodent moins rapidement. Ainsi, la fenêtre étroite de calcul du facteur d’impact pénalise certaines disciplines.

Tableau I

Facteurs d’impact respectifs de deux revues de neurosciences, Cortex et Pain Forum, en 1999 et 2000.

La troisième ligne présente le facteur d’impact du Journal Citation Report (JCR) calculé par l’ISI, et la dernière ligne, un facteur d’impact recalculé, qui ne prend en compte, au numérateur comme au dénominateur, que les données « citables » (d’après [3]).

Figure 3

Évolution dans le temps du nombre moyen de citations par nature d’articles.

Pour les « lettres » (articles courts), le pic de citations sur la courbe est proche de l’origine et une partie importante des citations se trouve dans la fenêtre de deux ans du facteur d’impact. Pour les articles originaux, le pic se situe autour de trois ans après la publication ; le nombre de citations dans la fenêtre étant moins important, le facteur d’impact sera plus bas. Pour les « revues », le pic maximal de citations est plus tardif, mais le nombre absolu élevé de citations se traduit par un facteur d’impact plus élevé (d’après [4]).

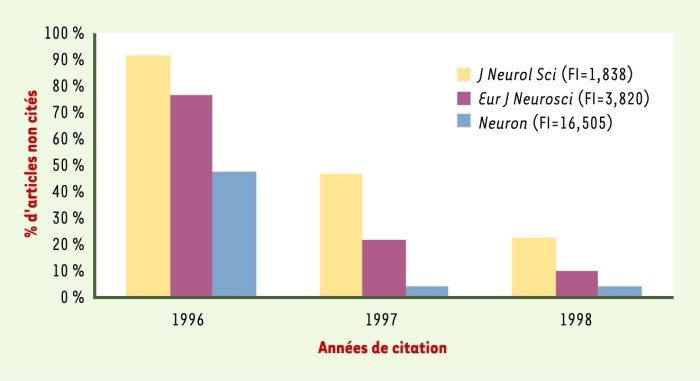

Il ne faut pas oublier non plus que le facteur d’impact représente la moyenne des citations d’un ensemble d’articles. Un article publié dans un journal à fort facteur d’impact n’est donc pas nécessairement très cité, même si le pourcentage des articles non cités diminue avec le temps (Figure 4). En même temps, des articles publiés dans des revues à faible facteur d’impact peuvent être fortement cités.

Figure 4

Évolution dans le temps du pourcentage d’articles non cités, publiés en 1996 dans trois revues de neuroscience à facteurs d’impact (FI) différents (Journal of Neurological Sciences, The European Journal of Neurosciences, Neuron).

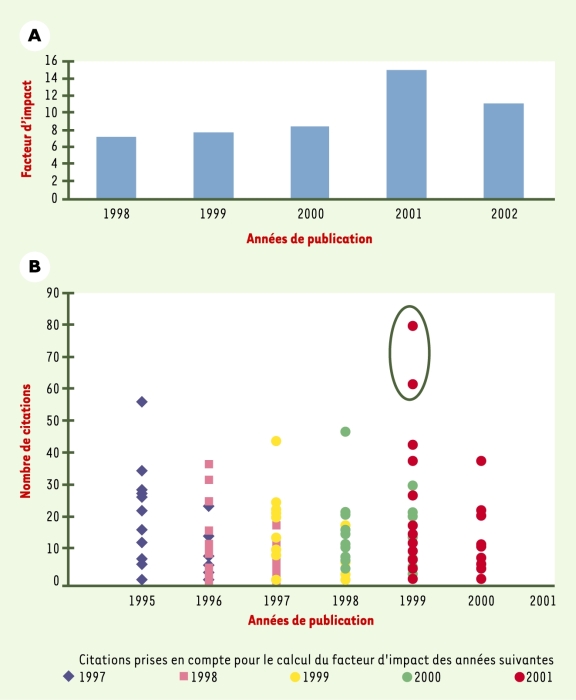

Les facteurs d’impact de journaux de petite taille sont très sensibles à la parution de tels articles. Citons l’exemple de Frontiers in Neuroendocrinology qui publie une douzaine d’articles par an (Figure 5A). L’augmentation spectaculaire de son facteur d’impact en 2001 est clairement due au nombre de citations élevé de deux articles parus en 1999 (Figure 5B). Cet exemple parmi d’autres montre qu’il est déraisonnable d’accorder au facteur d’impact plus de précision qu’il n’en mérite, conclusion qui correspond d’ailleurs aux recommandations de son concepteur [5]. C’est sans doute pourquoi la perception par les scientifiques de la valeur de journaux ne coïncide pas nécessairement avec leur facteur d’impact [6].

Le facteur d’impact peut aussi être manipulé. Ainsi, une augmentation de facteur d’impact peut résulter d’une demande aux auteurs de citer abondamment le journal auquel ils soumettent leur manuscrit.

Le facteur d’impact peut être utilisé pour améliorer le financement d’une institution. L’un d’entre nous, rédacteur d’une revue internationale, ayant fait observer à un auteur l’excès manifeste des autocitations de son article, s’est vu répondre naïvement par celui-ci qu’il avait agi sur le conseil de son président d’université, soucieux de renforcer l’image de son institution auprès du Sénat des États-Unis.

Le détournement du facteur d’impact lors des procédures d’évaluation de l’activité des chercheurs comme des structures de recherche est un autre danger largement documenté. Il a été montré que ces pratiques abusives ont un effet néfaste sur le contenu des publications et sur la mise en oeuvre des priorités de la recherche [7].

Pour ces raisons, la signification du facteur d’impact d’un journal ne peut être extrapolée à chacun de ses articles, comme l’avait indiqué Eugène Garfield lui-même [8, 9]. L’évaluation des chercheurs sur la seule base des journaux dans lesquels ils publient est injuste, même si, globalement, les recherches publiées dans des revues à fort impact ont de meilleures chances de marquer leur discipline. Mais toutes les recherches d’intérêt ne peuvent évidemment pas être publiées dans les grands journaux généralistes (qui représentent à peine plus de 1 % de la totalité d’entre eux) et, à l’inverse, il n’est pas toujours nécessaire de faire oeuvre originale pour être publié dans les grands journaux. Au cours de la dernière décennie, l’application systématique de bonnes techniques de routine pour déterminer le phénotype d’un nouveau transgène a souvent permis d’obtenir une publication dans Science ou Nature.

Intérêt des indicateurs pour la macroévaluation

En revanche, l’utilisation des indicateurs pour évaluer la performance d’un grand institut, d’une université, voire d’un pays, parait plus légitime : les causes de distorsion évoquées ci-dessus sont alors plus diluées et biaisent moins le résultat. L’analyse de la littérature sur le diabète, réalisée par l’ISI entre 1991 et 2001 (34 378 articles), montre que près de 30 % des articles ont été publiés dans trois revues (Diabetes Care, Diabetes et Diabetologia) alors qu’on en trouve moins de 0,3 % dans Nature et Science[2]. Les États-Unis arrivent en tête avec 117 035 citations pour 10 214 articles, suivis par le Royaume-Uni (30 397 citations pour 3 279 articles) et la France (14 689 citations pour 1 418 articles). La consommation moyenne des articles est relativement comparable, puisque l’index de citations par article s’établit respectivement à 11,5, 9,3 et 10,4. Si l’on compare l’Europe des 12 à l’Amérique du Nord (États-Unis et Canada), on obtient une performance à peu près égale en nombre d’articles publiés, mais un peu inférieure en taux de citations (8,7 contre 11,2) pour l’Europe.

Une autre étude[3] confirme la bonne tenue de la recherche française sur le diabète au cours de la dernière décennie : 40 articles parmi le Top 1 %[4] des publications mondiales, Lille, Lyon et Paris venant en tête, avec des taux moyens respectifs de citations de 9,1, 7,5 et 5,7. La France vient également en troisième position, si l’on analyse les publications sur le diabète dans quatre journaux prestigieux en recherche fondamentale (Nature, Science) et clinique (The New England Journal of Medicine, Lancet), et en seconde position pour l’indice de citations (Tableau II).

Tableau II

Performances des recherches sur le diabète de quatre grands pays (publications parues de 1991 à 2001 dans Nature, Science, The New England Journal of Medicine, The Lancet).

Figure 5

Facteur d’impact de la revue Frontiers in Neuroendocrinology (revue de « petite taille »).

A. Variation du facteur d’impact en fonction de l’année de publication. B. L’augmentation importante du facteur d’impact de cette revue en 2001 est liée au nombre de citations de deux articles publiés en 1999 (encerclés).

La macroévaluation devrait s’affiner, grâce à la mise au point de nouveaux indicateurs bibliométriques, tel celui réalisé à l’université de Leyde, qui prend davantage d’éléments en compte que ne le fait l’ISI (en intégrant notamment les brevets et en rapportant le décompte des citations à la moyenne des citations d’une discipline)[5].

Le nouveau paysage de la publication électronique

L’interprétation des indicateurs bibliométriques risque cependant d’être rapidement dépassée par la mutation en cours de la publication scientifique. La mise sur internet de la plupart des journaux facilite la recherche des articles et développe une nouvelle culture de partage. L’avènement du libre accès (open access) remet par ailleurs en cause le modèle économique traditionnel d’édition scientifique, où des éditeurs font souvent payer deux fois la distribution des articles, par le producteur de connaissance sous forme de frais d’édition, et par l’utilisateur lors de l’abonnement. Ce nouveau modèle permet aux lecteurs un accès libre et gratuit, les coûts d’édition étant à la charge des auteurs. Des initiatives nouvelles ont vu le jour dans le domaine biomédical ; parmi les plus connues, citons celles de BioMedCentral et de la Public Library of Science (PLOS) (Encadré 2).

Dès 1991, les physiciens ont assaini le marché de leurs publications en généralisant l’usage du « prétirage » (preprint) affiché rapidement sur un serveur web d’accès libre. Les articles sont généralement (mais pas toujours) évalués ou livrés à l’appréciation des lecteurs dont les critiques sont attachées à l’article[6].

La formule des preprints étant malaisée à mettre en oeuvre en biologie en raison d’un plus grand risque de pillage prématuré des données, les biologistes s’orientent vers de nouveaux journaux électroniques contrôlés par des comités de lecture pour garantir la qualité de leur contenu. Ces journaux seront indexés, et donc, cités comme les revues traditionnelles (c’est déjà largement le cas). L’évaluation des articles par des procédés « tout électronique » permet également des économies et des gains de temps. Les efforts des National Institutes of Health aux États-Unis et de Signal Hill en Europe[7] pour mettre en place des journaux électroniques de qualité vont dans le même sens. Le coût raisonnable de production et le libre accès de journaux électroniques tels que BioMedCentral permettront peut-être d’améliorer les chances de survie de l’édition européenne et, surtout, l’accès à l’information des pays émergents.

Une objection fréquente au « tout électronique » porte sur sa visibilité. Un article publié dans une revue traditionnelle ne reste-t-il pas mieux cité qu’une publication accessible seulement sur Internet ? Une étude récente tend plutôt à prouver le contraire [10], même s’il faut l’interpréter avec prudence dans la mesure où elle concerne l’informatique, une discipline jeune dont les habitudes de publication sont particulières. L’expérience de Pediatrics, qui offre gratuitement une partie de ses articles en ligne [11], suggère que ces derniers sont perçus comme des articles de « second choix » et donc moins cités.

Quelle incidence cette mutation va-t-elle avoir sur les moeurs de lecture et les pratiques de citations, sachant que ce qui est lu va se limiter de plus en plus à ce qui est facilement accessible électroniquement ? L’évolution du mode de diffusion des connaissances et de nouveaux indices (tels les comptages d’accès en ligne) devraient relativiser le caractère d’indicateur de référence du facteur d’impact. Des initiatives comme Digital Object Identifier (un instrument unificateur des ressources électroniques du Web) de CrossRef[8], un groupement de sociétés savantes et d’éditeurs, ou encore de BioMed Central avec Faculty of 1000(Encadré 3) joueront sans doute un rôle dans cette évolution.

Conclusions et perspectives

Le facteur d’impact s’est progressivement imposé comme un indicateur-clé de l’évaluation scientifique, grâce à l’antériorité de la base de données de l’ISI et à l’absence d’autres critères quantitatifs. Mais la communication électronique ouvre de nouvelles perspectives à l’évaluation et devrait permettre d’affiner les indicateurs infométriques, le facteur d’impact y trouvant alors une plus juste place. Les évolutions en cours sont également susceptibles d’affecter les relations entre science et société. Par exemple, l’analyse logistique développée par des archéologues[9] permet de mieux distinguer les données relativement certaines de la littérature qui les habille. En simplifiant le nombre de sources d’information, elle devrait les rendre plus transparentes. De nouveaux indicateurs pourront aussi intégrer des paramètres de société dans une approche plus globale, comme des activités de partage, de diffusion des connaissances et de formation sous toutes leurs formes. Mais cette évolution ne prendra vraiment son sens que si les institutions publiques de recherche et les agences de moyens y jouent pleinement leur rôle, notamment en adaptant rapidement leurs procédures d’évaluation à la nouvelle donne.

Appendices

Notes

-

[1]

En sciences de la vie, les articles qui alimentent cette dernière catégorie tendent à se multiplier, notamment en raison de la durée limitée des thèses et parfois des stages post-doctoraux : le jeune scientifique n’a pas le temps d’approfondir ou de recouper ses observations par d’autres méthodes, et après son départ, personne dans le laboratoire ne poursuit son travail. La stratégie consiste alors à essayer plusieurs journaux par ordre de facteur d’impact dégressif, jusqu’à en trouver un qui accepte le manuscrit (notons que cet effet pervers de la thèse pénalise davantage les publications européennes que les publications américaines, l’organisation hiérarchique des laboratoires aux États-Unis permettant plus facilement de confier la poursuite d’un série d’expériences à d’autres collaborateurs).

-

[2]

ISI Special Topics :http://www.esi-topics.com/diabetes/.

-

[3]

La recherche sur le diabète en France, étude du Groupe de bibliométrie de l’Inserm, sur la base des données de l’ISI, en utilisant le mot-clé « diabetes », mars 2003.

-

[4]

L’ISI, qui classe les articles par année et par discipline, identifie 1 % des plus cités d’entre eux, ce qui qualifie le top 1 %.

- [5]

-

[6]

Les « prétirages » ont en fait une tradition ancienne. Dès le xviie siècle, le Père Marin Mersenne avait entrepris de copier toutes les informations scientifiques qu’il recevait (Toricelli était notamment un de ses informateurs) et de les diffuser largement à travers l’Europe. Dans les années 1930, Enrico Fermi avait lui aussi pris l’initiative de diffuser ses prétirages par courrier à une grand nombre de ses collègues (voir [12]).

- [7]

- [8]

-

[9]

L’analyse logistique permet de séparer les éléments d’analyse raisonnablement vérifiés des éléments plus spéculatifs qui permettent d’en préciser le sens, mais ne comportent pas le même degré de validation (voir [13]).

Références

- 1. Marshall BJ, Warren JR. Unidentified curved bacilli in the stomach of patients with gastritis and peptic-ulceration. Lancet 1984 ; 1 : 1311-5.

- 2. Marshall BJ, Armstrong JA, McGechie DB, Glancy RJ. Attempt to fulfill Koch postulates for pyloric Campylobacter. Med J Aust 1985 ; 142 : 436-9.

- 3. Jacso PA. Deficiency in the algorithm for calculating the impact factor of scholarly journals : The journal impact factor. Cortex 2001 ; 37 : 590-4.

- 4. Amin M, Mabe M. Impact factors : use and abuse. Perspectives in Publishing(newsletter for journal editors, Elsevier Science) 2000 ; 1 : 1-6 (http://www.elsevier.nl/homepage/about/ita/editors/perspectives1.pdf).

- 5. Garfield E. The impact factor and using it correctly. Unfallchirurg 1998 ; 101 : 413-4.

- 6. Lewison G. Researchers’ and users’ perceptions of the relative standing of biomedical papers in different journals. Scientometrics 2002 ; 53 : 229-40.

- 7. Lawrence PA. The politics of publication. Authors, reviewers and editors must act to protect the quality of research. Nature 2003 ; 422 : 259-61.

- 8. Garfield E. Evaluating research. Do bibliometric indicators provide the best measures. Introduction to a review of bibliometric and other science indicators and their role in research evaluation (reprinted). Current Contents 1989 ; 14 : 3-10.

- 9. Garfield E. How can impact factors be improved ? Br Med J 1996 ; 313 : 411-3.

- 10. Lawrence S. Free online availability substantially increases a paper’s impact. Nature 2001 ; 411 : 521.

- 11. Anderson K, Sack J, Krauss L, O’Keefe L. Publishing online-only peer-reviewed biomedical literature : three years of citation, author perception, and usage experience. J Electronic Publishing 2001 ; 6 (http://www.press.umich.edu/jep/06-03/ anderson.html).

- 12. Burke J. Connections. Boston : Little Brown and Company, 1995.

- 13. Gardin JC. The logicist analysis of explanatory theories in archaeology. In : Franck R, ed. The explanatory power of models. Boston : Kluwer Academic Publishers, 2002 : 267-84.

List of figures

Figure 1

Variation du facteur d’impact moyen (en 2000) de revues appartenant à différentes disciplines biomédicales.

Figure 2

Nombre de citations de l’article princeps de B.J. Marshall sur la découverte du rôle de Helicobacter pylori en pathologie gastro-intestinale, paru en 1984 [1].

Figure 3

Évolution dans le temps du nombre moyen de citations par nature d’articles.

Pour les « lettres » (articles courts), le pic de citations sur la courbe est proche de l’origine et une partie importante des citations se trouve dans la fenêtre de deux ans du facteur d’impact. Pour les articles originaux, le pic se situe autour de trois ans après la publication ; le nombre de citations dans la fenêtre étant moins important, le facteur d’impact sera plus bas. Pour les « revues », le pic maximal de citations est plus tardif, mais le nombre absolu élevé de citations se traduit par un facteur d’impact plus élevé (d’après [4]).

Figure 4

Évolution dans le temps du pourcentage d’articles non cités, publiés en 1996 dans trois revues de neuroscience à facteurs d’impact (FI) différents (Journal of Neurological Sciences, The European Journal of Neurosciences, Neuron).

Figure 5

Facteur d’impact de la revue Frontiers in Neuroendocrinology (revue de « petite taille »).

List of tables

Tableau I

Facteurs d’impact respectifs de deux revues de neurosciences, Cortex et Pain Forum, en 1999 et 2000.

Tableau II

Performances des recherches sur le diabète de quatre grands pays (publications parues de 1991 à 2001 dans Nature, Science, The New England Journal of Medicine, The Lancet).

![Nombre de citations de l’article princeps de B.J. Marshall sur la découverte du rôle de Helicobacter pylori en pathologie gastro-intestinale, paru en 1984 [1].](/en/journals/ms/2004-v20-n10-ms814/009339ar/media/009339arf002n.jpg)