Abstracts

Résumé

Partant du postulat du glissement progressif des dispositifs cinématographiques vers un paradigme électrique, l’auteur questionne l’impact de l’enregistrement synchrone filmique et vidéo sur nos conceptions de la technique audiovisuelle. Utilisant plusieurs exemples provenant en particulier du fonds de l’ONF, l’article décrit les difficultés liées à l’établissement d’une synchronisation son/image fiable au cinéma, pour ensuite analyser les principales différences esthétiques induites par l’utilisation des deux supports (pellicule et bande magnétique). L’asservissement de l’image et du son étant une donnée « ontologique » du medium vidéo, la désynchronisation devient un choix esthétique produisant un changement dans la perception de la temporalité des images et des sons.

Abstract

Based on the hypothesis of a progressive move of cinematographic devices toward the electric paradigm, the author examines the impact of synchronous recording in film and video on conceptions of audio-visual technique. Drawing on a range of examples taken primarily from the NFB fonds, this article describes the difficulties tied to obtaining reliable sound/image synchronization on a film strip, and provides an analysis of the main aesthetic differences between the media of film stock and magnetic tape. The technical coupling of image and sound, (the French term asservissement literally means enslavement) lends the video medium an “ontological” characteristic; thus, desynchronization becomes an aesthetic choice which has consequences for the perception of image/sound temporality.

Article body

La synchronisation entre le son et l’image occupe une grande place dans les innovations techniques tout au long du 20e siècle ; cependant, il existe encore peu de travaux sur cet aspect[1]. Avant de questionner l’impact de l’enregistrement synchrone (filmique et vidéo) sur nos conceptions de la technique audiovisuelle, replaçons ce débat dans une perspective historique : tout commence avec les différentes tentatives de production d’une image et d’un son synchronisés, et ce, même avant l’invention du cinématographe Lumière[2]. Dès le cinéma des premiers temps, toutes sortes de bruits – paroles, musiques, cris, rires, bruitages, etc. – accompagnent la majorité des projections. Leurs sources sont également très variées : corps humain, objets divers, instruments de musique, disques, signaux électriques diffusés à distance, etc. Tous ces sons sont plus ou moins aléatoires, et jusqu’à la fin des années 1920, il n’est pas possible de contrôler leur émission et donc de les synchroniser avec la bande image. La grande révolution du cinéma sonore[3] est l’asservissement du son à l’image, ainsi que la synchronisation absolue des paroles et des bruits avec leur source à l’image, rendue possible par le transfert du signal électrique sonore sous forme optique directement sur la pellicule.

Cependant, la généralisation des dispositifs de synchronisation entre le son et l’image lors de la projection ne constitue qu’une étape du développement synchrone du cinéma. L’autre étape primordiale est celle de l’enregistrement simultané d’un son et d’une image. Ceci devient possible, en studio, dès le début des années 1930, et très rapidement, sous la pression des actualités cinématographiques, les techniciens inventent un matériel d’enregistrement synchrone pour le tournage en extérieur. Cependant, jusqu’aux années 1950, le matériel sonore est lourd et encombrant, car le son est enregistré sur un support optique (ou un disque microsillon, dans certains cas). Pour l’enregistrement d’un son en extérieur, les techniciens déplacent tout ce matériel dans un camion. Si le réalisateur veut enregistrer un son synchrone à l’image, le régisseur doit ajouter un second camion transportant un générateur de courant électrique stable permettant d’asservir les moteurs de la caméra et de l’enregistreur son, car la seule synchronisation possible est réalisée sur le secteur : la fréquence du courant sert de référence pour tous les appareils (60 ou 50 Hz).

La situation commence à évoluer après la Deuxième Guerre mondiale avec l’invention de la bande magnétique et la possibilité de conserver le son sous format électrique[4]. Les premiers magnétophones[5], développés dans les années 1950, rendent possible une évolution importante des dispositifs d’enregistrement cinématographique : là où un matériel lourd, encombrant et peu discret imposait des conditions de tournage contraignantes, la possibilité d’enregistrer le son de manière autonome ouvre sur un autre mode de tournage qui permet aux cinéastes de s’adapter à la réalité filmée. Cependant, il faut attendre plusieurs années avant que quelques cinéastes s’emparent de ce matériel et l’adaptent aux spécificités du tournage cinématographique. Le faible intérêt pour les dispositifs légers et synchrones s’explique par une conception majoritaire du cinéma : le cinéma serait comme une machine devant laquelle on organise le monde, plutôt qu’une technique permettant d’enregistrer « parmi le monde[6] ». En effet, c’est le désir de filmer au milieu de la réalité qui pousse les cinéastes à demander un matériel plus léger, maniable, ergonomique et discret. À partir du moment où les cinéastes peuvent porter leur matériel au milieu des personnes filmées, ils sentent le besoin d’un système de synchronisation léger entre le magnétophone et la caméra, et ce système sera en effet développé au tournant des années 1960 par les cinéastes du direct (Richard Leacock, Jean Rouch, Wolf Koenig, Colin Low, Michel Brault, Marcel Carrière, etc.). Dans les années 1970, plusieurs innovations proposées par les techniciens du cinéma direct (repère temporel fixe – time code, qualité des lentilles, ergonomie des caméscopes, caméra portée ou micro-trottoir, etc.) servent de base au développement de la vidéo légère.

Si au départ l’électrification des dispositifs de production audiovisuelle concerne l’asservissement des images et des sons, avec l’échantillonnage électronique de l’image, cette synchronisation devient une caractéristique de base. La question se déplace alors vers le décalage – impliquant différentes possibilités de mise en scène – entre la captation et la diffusion de l’événement. Cet article s’intéresse à l’évolution électrique de la technique audiovisuelle et à ses effets sur la manière dont les cinéastes conçoivent l’enregistrement audiovisuel de la réalité. Plus spécifiquement, il s’agit de décrire les difficultés qu’il y a à obtenir une synchronisation son/image fiable au cinéma, puis d’analyser les différents enjeux esthétiques induits par les deux supports (pellicule et bande magnétique). L’asservissement de l’image et du son étant une donnée « ontologique » du medium vidéo, la désynchronisation devient un choix esthétique produisant un changement dans la perception de la temporalité des images et des sons.

Synchronisation cinématographique

La synchronisation entre image et son à l’enregistrement peut être obtenue de quatre manières différentes. La première consiste à synchroniser deux moteurs (pour l’image et pour le son) sur les phases du secteur. Ce système est rigoureux si les deux moteurs sont branchés sur la même fréquence, et il existe depuis les années 1930. Malheureusement, il est lourd et encombrant et exclut tout tournage synchrone loin d’une source de courant électrique stable.

La seconde solution, appelée single system, a été développée pour répondre aux besoins de reportage des télévisions. Le son et l’image sont enregistrés sur la même bande. L’image est fixée sur une partie de la pellicule, qui est généralement au format 16 mm, tandis qu’une bande de la même pellicule est réservée au son, sur piste optique ou magnétique :

La dernière caméra professionnelle utilisant ce procédé fut l’Auricon 16 mm (USA) employée, par exemple, par les télévisions américaines durant les événements de mai 1968 car beaucoup plus fiable, d’après les techniciens américains, que les caméras autosilencieuses européennes. De nos jours, la plupart des caméras autosilencieuses offrent un module permettant l’enregistrement direct sur pellicule image : leur emploi est rarissime[7].

Ce système peut sembler parfaitement adapté au cinéma léger et synchrone. Or, dans aucun des pôles de développement de ce cinéma, les cinéastes n’utilisent le single system. Son défaut principal est la difficulté de réaliser des montages complexes avec une pellicule équipée d’une piste magnétique. De plus, le coût relativement élevé de la pellicule limite le nombre d’heures de tournage. Enfin, comme les cinéastes du direct s’y sont peu intéressés, ce type de matériel est resté lourd et encombrant. Cet aspect ne gênait guère les cadreurs de télévision, qui posaient généralement la caméra sur un pied et avaient rarement besoin d’un matériel léger et ergonomique.

Aucune de ces deux solutions ne correspondant à l’exigence d’un matériel réellement léger et ergonomique, les techniciens se tournent du côté de la synchronisation par pilotage, avec ou sans câble, ou par quartz : lorsque les deux appareils ont des moteurs asservis (c’est-à-dire régulés à une vitesse constante), la difficulté est de les stabiliser sur la même fréquence. Il y a alors deux options : soit transmettre la vitesse de défilement de l’un des appareils à l’autre à travers un câble ou par microémetteurs ; soit brancher les deux appareils sur des générateurs de fréquences produisant la même fréquence fixe, comme la pulsation produite par un quartz.

À la fin des années 1950, les cinéastes de l’équipe Drew et Leacock inventent un matériel léger et synchrone[8]. Don Alan Pennebaker et Richard Leacock créent un système de synchronisation à partir du quartz Accutron des montres Bulova. Grâce aux oscillations produites par le quartz, les moteurs des deux appareils d’enregistrement sont régulés sur la même fréquence : ils sont parfaitement synchrones, tout en restant indépendants, car il n’y a pas de liaison physique constante entre les deux, la synchronisation reposant seulement sur l’asservissement des deux moteurs à une vitesse identique. Le début du tournage est repéré au moyen de la claquette. Ce système présente cependant deux problèmes : il coûte relativement cher et il est très sensible aux variations thermiques. Si l’un des deux appareils fonctionne dans un lieu mieux chauffé que l’autre, si par exemple le cameraman est au chaud et l’ingénieur du son dans un courant d’air froid, il résultera des variations dans la prise synchrone, qui seront difficiles à rattraper au montage.

Contrairement à l’équipe Drew et Leacock, le service technique de l’Office national du film (ONF[9]) choisit de transmettre au magnétophone, à travers un câble puis par microémetteurs, la vitesse de défilement du moteur de la caméra. Dans un premier temps, avant l’arrivée du Nagra III (vers 1960), l’ONF ne possédant pas de magnétophone dont le moteur puisse être asservi, les ingénieurs inventent un système pour inscrire le signal de synchronisation sur la piste magnétique. La caméra délivre un signal proportionnel à la vitesse réelle. Un générateur, de très petite taille, placé sur la caméra, produit une fréquence proportionnelle à la vitesse du moteur et communique au magnétophone le signal correspondant à cette fréquence. Lors de l’enregistrement du son, le signal s’inscrit sur la bordure de la bande magnétique, grâce à la tête d’enregistrement pilottone (piloton) puis néo-pilote (Fig. 1a-1b). Si la vitesse de la caméra varie au cours de la prise de vue, cette variation est inscrite sur la bande sonore. Les irrégularités sont rattrapées au moment du repiquage (transfert du son sur une bande magnétique placée sur la pellicule positive). Le système par pilotage (pilottone ou piloton) est mis au point avec le magnétophone le plus stable que possède l’Office, le Sprocketape : c’est un système assez complexe qui suppose une importante modification de la chaîne de traitement du son. Il repose sur quatre modifications majeures du matériel cinématographique : tout d’abord, il faut régulariser les moteurs des enregistreuses, afin de limiter la fluctuation de leur vitesse de défilement. Ensuite, il faut enregistrer le signal de synchronisation de manière indépendante du son capté, pour garder une trace des variations du défilement. La mise au point d’un marqueur temporel permet d’identifier le début de la synchronisation. Enfin, la chaîne de report de son doit être modifiée pour qu’on retrouve la synchronisation image/son.

Fig. 1a-1b

Utilisation en studio du système néo-pilote.

Pour obtenir une synchronisation légère, le premier impératif est de contrôler la vitesse de défilement de la pellicule et de la bande magnétique. Très tôt, les techniciens du direct sont conscients de cette question et attirent l’attention des ingénieurs sur ce besoin :

On courtisait les gens qui travaillaient à la recherche technique à l’ONF pour qu’ils nous inventent de nouveaux outils. On a franchi une première étape avec cette caméra américaine, une Cinevoice de la compagnie Auricon, modifiée par Chester B. Beachell pour fonctionner avec un bloc de piles et contrôlée par un diapason électronique, afin de garder le synchronisme 24 images/seconde[10].

S’ils veulent pouvoir reporter le son sur la pellicule image, les techniciens doivent vérifier la régularité du moteur des deux enregistreurs.

En laboratoire, les ingénieurs contrôlent les fréquences de rotation avec un oscilloscope lourd et encombrant. Ils ne peuvent pas déplacer ce matériel sur le terrain, ils se fient alors à leur oreille. Ce procédé n’étant pas très fiable, les ingénieurs conçoivent donc un boîtier électronique pour vérifier la vitesse de défilement à chaque changement de bobine. L’arrivée du Nagra III, qui existe depuis 1958 mais n’est disponible à l’Office qu’à partir de 1960, est une véritable révolution. Grâce à l’arrivée des transistors, Stefan Kudelski met au point un système d’asservissement de la vitesse de défilement et permet de synchroniser le moteur du Nagra avec celui de la caméra – Arriflex ou Auricon Cinevoice. Un dispositif de pilotage de la caméra Cinevoice – D.C. Motor Speed Control for Cinevoice – est mis au point pour s’adapter au magnétophone. L’engrenage principal de la caméra produit – par l’intermédiaire d’une tête magnétique – un signal dont la fréquence est indexée sur la vitesse de la caméra. Ce signal est comparé à une tension de référence de 60 Hz – théoriquement constante –, puis un circuit électronique compense les variations de vitesse du moteur. Le Nagra reçoit ensuite le signal de synchronisation de référence de 60 Hz émis par la caméra ; cette fréquence devient la référence pour réguler la vitesse de son moteur. Si la vitesse de la caméra varie au cours de la prise de vue, cette variation est transmise au magnétophone. Les deux appareils sont constamment synchrones et un simple clap permettrait de superposer le son et l’image synchrone. Cependant, par souci de fiabilité, les ingénieurs de l’ONF choisissent de conserver l’enregistrement du signal piloté sur la bande magnétique.

La mise au point d’un marqueur temporel, point de repère du début de la synchronisation image/son, remplace avantageusement le clap classique, inefficace et inutilisable dans certaines situations. Il existe deux modèles de marqueur électronique : electronic slating et scene marking. La mise au point du repérage de scènes avec le son pilote – scene marking device for pilottone recording – intervient probablement dans le tournage du film Les enfants du silence (Michel Brault, Marcel Carrière, Claude Jutra, 1962)[11] (Fig. 2a-2b). Afin de saisir le comportement d’enfants de 5 à 6 ans ayant des difficultés auditives, ainsi que leur faculté d’assimilation et leur adaptation dans le milieu scolaire, les cinéastes introduisent un dispositif d’enregistrement léger et synchrone. Il est composé de deux caméras 16 mm (une Auricon et une Arriflex), d’un enregistreur son sur bande ¼ de pouce, le tout synchronisé par un système pilottone sur secteur. Pour ne pas distraire les enfants de leur routine habituelle, les cinéastes tentent d’être les plus discrets possible. En particulier, les cinéastes du direct éliminent les gestes les plus cinématographiques et les attitudes professionnelles qui attirent l’attention sur le tournage. La classique claquette est sûrement le geste le plus spectaculaire. La difficulté est d’obtenir tout de même pour les trois enregistreurs un repère de synchronisme image/son :

The answer was to record the sound continuously on alternate recorders and to devise a method whereby either or both cameras could shoot at any time and register synchronising marks for each shot. The sound synchronising marks should not, however, be heard on the sound track. […] The Pilot-Tone system was readily adapted to these requirements, an automatic interruption of the control track being used to indicate a camera start. In our case, Camera 1 was identified by a 1/3 second interruption while Camera 2 was identified by a 2/3 second interruption of the control track[12].

Fig. 2a-2b

Les enfants du silence (Michel Brault, Marcel Carrière, Claude Jutra, 1962).

Les cinéastes choisissent donc d’enregistrer le repère de synchronisme image/son sur la piste de synchronisation, c’est-à-dire de couper, momentanément, le signal de 60 Hz destiné à impressionner la piste pilote. Leurs recherches ouvrent la voie à un système de marqueur électronique utilisé en remplacement de la claquette traditionnelle et, par la suite, du repérage temporel des images. À partir de 1963, des recherches sont menées à l’ONF sur le time index system, une claquette électronique multicaméra portative. D’après Leo H. O’Donnell, c’est la première utilisation connue d’un système de code de temps pour négatif de prise de vues et ruban magnétique[13]. Ensuite, dans les années 1970, un système de code de temps matriciel sur film est mis au point en collaboration avec la société Aäton de Grenoble. A priori, il s’agit de la même technologie que l’on retrouve ensuite sur la bande magnétique vidéo.

C’est alors que la chaîne du traitement du son est modifiée, afin de s’adapter au système pilottone puis neo-pilottone : le son est reporté sur la piste magnétique collée sur la pellicule ; cette piste est collée parallèlement à l’image, avec un décalage de quelques images pour s’adapter à la distance sur l’appareil de projection, entre la tête de lecture magnétique et l’objectif ; le son est parfaitement synchronisé avec l’image ; enfin la vitesse de défilement correspond à la vitesse d’enregistrement. Dans le cas contraire, la hauteur de son ne serait pas forcément respectée. Car autant l’oeil humain note peu les imperfections de l’image, autant l’oreille est très sensible aux décalages – aux défauts de synchronisation image/son, aux variations de hauteur de son, etc. Le système pilottone est remplacé ensuite par le neo-pilottone, développé par Kudelski. La nouvelle tête magnétique réduit la diaphonie entre la piste de synchronisation et la piste d’enregistrement (piste programme) : ce nouveau système de synchronisation permet d’améliorer le rapport signal/bruit. De plus, le neo-pilottone est moins contraignant, car la nouvelle configuration le rend moins sensible aux champs magnétiques. La piste pilote polarisée a l’avantage d’augmenter la marge à l’enregistrement du son programme, tout en renforçant le synchronisme.

Il faut noter une différence majeure entre les systèmes de synchronisation à quartz et piloté. Ce dernier, mis en place par les techniciens parisiens et montréalais, suppose un câble de liaison entre le preneur de son et le cadreur. Richard Leacock et Don Alan Pennebaker choisissent la synchronisation à quartz spécifiquement, pour le motif qu’il n’y a pas de liaison constante entre les deux techniciens. L’avantage est que chaque technicien est libre de se déplacer sans constamment devoir surveiller les déplacements de l’autre. Par exemple dans Primary (Robert Drew, Richard Leacock, 1960), le cadreur peut filmer les réactions des auditeurs pendant que le preneur de son reste près de Hubert Humphrey, afin d’enregistrer son discours dans de bonnes conditions (Fig. 3a-3b). En revanche, il peut se présenter des inconvénients, comme dans la scène finale où John F. et Jackie Kennedy quittent le studio de télévision après l’annonce des résultats : le preneur de son n’ayant pas suivi, il n’y a pas de son correspondant à l’image. Les cinéastes canadiens et français au contraire semblent s’accommoder du câble. Par exemple, Mario Ruspoli montre que ce câble force les deux techniciens à rester en contact[14] et qu’il permet ainsi d’enregistrer une image et un son cohérents. L’idée est également partagée par Serge Leblanc – responsable du département de la synchro française de l’ONF – et par Jean Roy – responsable du département de la caméra[15]. Cela explique certainement pourquoi il faut attendre 1964 pour qu’un matériel de synchronisation sans fil apparaisse à l’ONF. Une autre explication pour ce délai vient des exigences de qualité des ingénieurs de l’Office qui ne se contentent pas d’un système simple mais approximatif, comme celui développé par l’équipe Drew et Leacock. L’absence de liaison entre les deux appareils empêche de vérifier la synchronisation lors du tirage des copies. Il est alors très difficile de corriger un décalage éventuel. C’est pourquoi les ingénieurs canadiens choisissent de transmettre le signal de synchronisme par microémetteur.

Fig. 3a-3b

Comme nous venons de le voir, le principe d’une synchronisation cinématographique légère n’est pas simple, et sa mise au point ne s’est pas faite de manière fluide, mais à travers une série d’approximations. Dans toutes ces étapes, on assiste à la mise au point d’un nouveau dispositif, c’est-à-dire à l’invention de nouveaux agencements techniques à partir d’un matériel déjà existant. Cependant, il s’agit généralement de petites modifications accumulées, de micro-inventions. Par conséquent, on peut considérer que dans la plupart des cas, il n’y a pas invention d’un nouveau matériel mais innovation, c’est-à-dire modification d’un système technique déjà existant. D’après Bernard Stiegler, l’innovation correspond au développement d’un système technique ; il s’agit donc d’améliorer un dispositif en augmentant son efficacité en fonction de pratiques déjà établies[16]. Les inventions au contraire correspondent à des modifications majeures et sont généralement effectuées en laboratoire. Elles supposent une planification : définition d’un cahier des charges, dessin technique, fabrication de nouvelles pièces, mise en place de normes d’usage et d’entretien, description dans les rapports techniques et, parfois, dépôt de brevet. Par exemple, le nombre d’inventions concernant le cinéma léger et synchrone à l’ONF est relativement peu important : 1955, magnétophone portatif léger Sprocketape ; 1962, marqueur électronique ; 1964, générateur de synchronisation pilottone à quartz. Ce sont les ingénieurs et les opérateurs de prise de vue et de son qui ont apporté beaucoup d’innovations. Les innovations sont directement inspirées de besoins nés sur le lieu de tournage et elles sont réalisées sur place ou de retour à l’atelier : elles sont généralement improvisées sans être validées par l’institution. Par conséquent, elles sont réalisées sans financement spécifique et ne sont pas toujours répertoriées.

Il faut bien sûr relativiser cette distinction. Il n’y a pas de séparation nette entre invention et innovation. Les deux processus finissent par collaborer et s’influencer mutuellement. Les petits « bidouillages » des cinéastes du direct finissent par inspirer des manufacturiers. C’est dans un esprit de collaboration que naissent les nouvelles caméras Éclair et Aäton. Il faut préciser également que je ne place pas de hiérarchisation entre les inventions majeures réalisées en laboratoire et les patentages mis au point sur le terrain. Même si l’invention des techniques légères et synchrones ne se fait pas suivant un principe systémique mais dans une longue suite d’improvisations et d’approximations, elle constitue un point important de l’évolution des techniques audiovisuelles.

Si le développement de la vidéo (du Portapak de Sony en 1965 aux premiers caméscopes) est beaucoup moins artisanal que celui du cinéma léger et synchrone, le processus est moins lisse qu’il n’y paraît. Les évolutions et les tâtonnements ne sont pas visibles, mais ils le seraient certainement si l’on avait accès aux archives ; on serait alors plus conscient des impasses et des incertitudes. Dans le cas du cinéma léger et synchrone, nous avons accès à la plupart des étapes de la mise en place grâce aux archives de l’ONF, ou des principaux fabricants de caméras (Éclair ou Aäton) ou de magnétophones (Nagra), ainsi qu’à la mémoire de certains témoins. Dans le cas du Portapak, il est sans doute possible de parler d’innovation, étant donné que le principe consiste « simplement » à connecter une caméra vidéo (allégée et modifiée pour être portée à l’épaule) à un magnétoscope (lui aussi allégé et renforcé). Mais avec le développement du caméscope professionnel par Sony en 1982, ou du caméscope grand public par Panasonic, on assiste réellement à l’invention d’un nouveau concept et on peut donc parler d’innovation.

Si l’on replace l’évolution légère et synchrone de la technique audiovisuelle dans une perspective historique plus large, il est possible d’observer un glissement progressif du dispositif cinématographique vers le paradigme électrique. Au départ mécanique, optique et chimique, la production de l’image cinématographique dépend de plus en plus de technologies électriques (enregistrement magnétique ; moteurs électriques ; synchronisation par pilottone). Ensuite, l’électrification de l’image audiovisuelle[17] se poursuit de manière concomitante du côté de la diffusion télévisuelle, puis du développement des supports vidéo analogiques, puis numériques. Ce déploiement est particulièrement visible dans les modes de production et de diffusion de l’image photographique et cinématographique, puis audiovisuelle : un mode de pensée influencé par l’électricité se déploie progressivement, sans totalement remplacer les paradigmes mécanique et humain préexistants, ni empêcher le développement de nouveaux présupposés. La métamorphose électrique du médium prend différents aspects, dont l’un des principaux est la synchronisation progressive, depuis l’enregistrement jusqu’à la projection du son, de l’image et de l’événement capté.

Pellicule et bande magnétique

Globalement, les caractéristiques des dispositifs légers et synchrones permettent de forcer le médium technique afin de décentrer la caméra et d’obtenir un son proche de l’image captée. La souplesse, la (relative) légèreté et la discrétion du dispositif de tournage permettent à la caméra de se faufiler parmi les personnes filmées et laissent ainsi plus de place à l’improvisation. Tout en ayant un impact sur la réalité, la caméra n’est plus le centre de l’attention : ce n’est plus aux protagonistes de s’adapter à la caméra, mais au matériel d’enregistrement de suivre les personnes filmées. Ce décentrement a également pour conséquence de modifier les rapports esthétiques entre l’image et le son : si la majorité des films sont réalisés à partir de l’image, le fait de capter un son direct (c’est-à-dire enregistré sur le lieu de tournage de la scène) et synchrone (avec un système de synchronisation entre le moteur de la caméra et celui du magnétophone) donne une plus grande valeur au son. Ainsi, beaucoup de cinéastes du direct (dont Pierre Perrault) pensent la mise en scène et le montage de leur film à partir du son (principalement la parole). Ensuite, ils explorent plusieurs options de montage. Paradoxalement, si le cinéma direct cherche une captation synchrone, ce n’est pas forcément pour respecter l’asservissement entre le son et l’image au montage : la synchronisation est une possibilité et la désynchronisation devient une forme d’expression. Dans de nombreux cas, les cinéastes vont reconstruire une trame sonore en fonction de ce qu’ils veulent révéler de la réalité filmée. La question du montage et de la désynchronisation est un aspect du cinéma direct déjà bien documenté[18]. Voyons plus en détail quelques exemples où le défaut de synchronisation lors de la captation a influencé les choix de montage.

Si dans les années 1960 des dispositifs permettent une synchronisation fiable de l’image et du son au tournage, l’enregistrement continue toujours de se faire sur deux supports séparés : au cinéma, la synchronisation audiovisuelle n’est jamais garantie par le support et reste une difficulté technique importante. Au contraire, dans la vidéo, avec l’échantillonnage électronique, le son et l’image sont asservis sur le même support : sauf erreur du cadreur, le son est systématiquement enregistré avec l’image. Cette différence majeure a des conséquences sur les conditions de tournage et sur les choix esthétiques des cinéastes. Afin de mieux comprendre cet aspect, voyons quelques exemples tirés du cinéma direct québécois.

Lors du tournage de Pour la suite du monde, les cinéastes tentent de capter des scènes de la vie quotidienne reflétant les habitudes et les modes de pensée des habitants de l’Isle-aux-Coudres. Sans pouvoir être constamment présents, les cinéastes inventent des tactiques pour enregistrer des micro-évènements. Par exemple, Marcel Carrière est présent avec son matériel et il enregistre Grand Louis lorsqu’il parle de son coq : « Oh ! Oh ! Oh ! C’est tout un coq, ça, quatre fois par jour ! » Ensuite, Michel Brault entendant l’enregistrement décide de « faire des images pour mettre là-dessus ! » : le lendemain, il filme le coq courant après les poules. Ainsi, sans avoir pu capter la réalité audiovisuelle, les deux opérateurs inventent un subterfuge pour pallier l’absence d’images : le montage permet de reconstituer la scène originelle. Il est intéressant de noter que dans cette scène le fait que les temporalités de l’image et du son ne soient pas identiques ne pose pas de problème : la sincérité des cinéastes n’est pas remise en cause, tant que l’homogénéité spatiale et thématique est respectée. Le décalage entre la prise de son et la prise d’image ou la manipulation au montage n’est pas remarqué par la plupart des spectateurs, et la scène du coq de Grand Louis ne semble absolument pas artificielle. Au contraire, le public la reçoit comme un moment de cinéma direct.

Parfois, la difficulté est encore plus grande. Lors du tournage de l’épisode du Son des Français d’Amérique[19] sur l’île du Cap-Breton dans une communauté acadienne, André Gladu, Michel Brault et Claude Beaugrand enregistrent Tom Chiasson chantant Les culottes de velours, une vieille complainte francophone du 15e siècle. À la suite d’un malentendu entre les deux réalisateurs, Brault se trouve à court de pellicule après deux minutes d’enregistrement. De même, la bande magnétique de Beaugrand se termine après dix minutes, alors que Monsieur Chiasson n’a pas terminé sa chanson[20]. Même si les deux techniciens sont très expérimentés dans ce type de tournage, ils ne peuvent dépasser les limites que leur impose le dispositif technique. Cette scène se trouve tout de même dans l’épisode numéro quatre Y’allont-y disparaître ?, mais la chanson est tronquée et des plans de coupe viennent palier l’image manquante. Ce type de mésaventure est pratiquement impossible lors d’un tournage avec un caméscope vidéo, car le son et l’image sont enregistrés sur le même support et l’autonomie actuelle des caméscopes dépasse facilement les soixante minutes : ceci contribue à simplifier les conditions de tournage.

Ainsi, à partir des années 1970-1980, les cinéastes qui choisissent de tourner en vidéo tentent de repousser encore les limites de la transparence du médium. L’impression de transparence s’amplifie avec le perfectionnement des caméscopes dans les années 1990 : simplification et allégement du matériel ; possibilité de tournage dans des conditions de faible luminosité ; augmentation de l’autonomie (cassettes et batteries). L’encodage numérique va décupler encore ces possibilités : image plus nette ; profondeur de champ plus grande ; légèreté des caméscopes ; image duplicable à l’infini ; facilité de montage, etc. Les caractéristiques des caméscopes limitent les gestes techniques nécessaires pour obtenir un son et une image de qualité, et libèrent le cadreur et le preneur de son qui peuvent se concentrer davantage sur la réalité qui se présente à eux. Le reportage et un certain cinéma documentaire vont exploiter pleinement les capacités de ce nouveau médium.

Dans Chroniques de Nitinaht (Maurice Bulbulian, 1997, 3 parties), Maurice Bulbulian accompagne les Ditidahts du village de Nitinaht Lake en Colombie-Britannique dans leur travail de mémoire communautaire visant à mettre un terme à une histoire marquée par la violence familiale, les agressions sexuelles et l’inceste. Pendant près de sept ans, le cinéaste est accueilli dans la communauté pour filmer les témoignages. Le film rend compte de cette recherche collective de pardon à travers la mise en scène de la communication à distance rendue possible par la technique vidéo. Après une séquence d’introduction qui présente le problème et les principaux acteurs de ce drame social, le cinéaste prend la parole afin de présenter son projet et sa position par rapport à la communauté :

Lors de cette réunion, quelqu’un a suggéré que l’on utilise la caméra à l’intérieur de la communauté, comme faisant partie du processus de guérison. Ils décideraient plus tard si l’on allait en faire un film qui serait montré à l’extérieur de la communauté. C’est dans cet esprit que je suis allé rencontrer la mère de Bonnie, Linda, qui vit maintenant à l’extérieur de la communauté, pour lui montrer ce premier tournage. Je voulais lui demander de partager avec nous les sentiments d’une mère prise entre son père comme agresseur et sa fille comme victime.

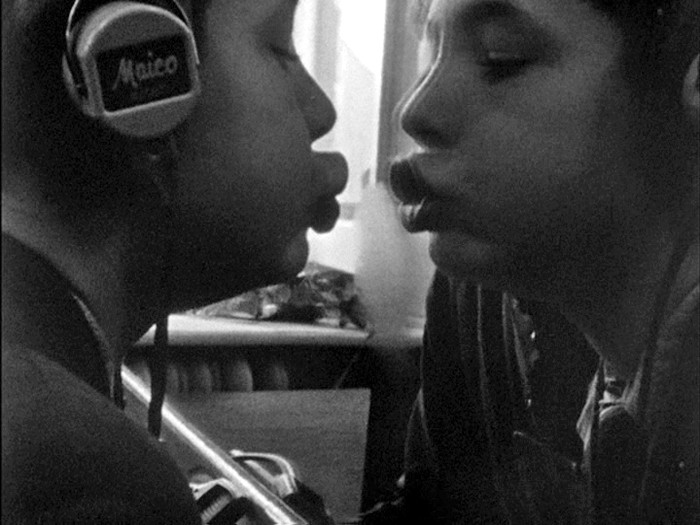

Suit une longue séquence d’une vingtaine de minutes, présentant un dialogue virtuel entre les différents membres de la communauté concernés par le drame, dont Carl, sa femme, sa fille Linda, ses fils, le chef de la communauté, sa famille, etc. Carl est en prison où il suit une thérapie et Linda a fui le village avec sa fille, afin de la protéger. Aucun d’eux ne peut dialoguer directement avec leur communauté : la caméra va faire le lien entre ces trois groupes. Voyons comment le dialogue virtuel via la vidéo est mis en scène (Fig. 4a-4b).

Fig. 4a-4b

Au début de la séquence, Linda termine le visionnement de la séquence d’introduction que le spectateur vient de voir, où le chef du village appelle à un dialogue entre les parties et à un processus de guérison et de pardon. Ensuite, Linda partage son désarroi, entre l’admiration pour son père et sa colère pour ce qu’il leur a fait subir. À la fin de la scène, Linda demande à son père de venir lui/leur demander pardon. La scène se termine avec le Chant de Linda, tel qu’indiqué par un sous-titre, et continue sur un plan large de Carl assis, en uniforme de prisonnier avec la mention « Carl, après 4 mois de détention », qui visionne le témoignage de Linda que nous venons de voir. Commence ensuite la confession de Carl : « En thérapie, ils m’ont dit de me rappeler les événements de ma jeunesse, le genre de vie que j’ai eu. » Alors que la voix de Carl poursuit (« Impossible d’oublier, dites-vous ? C’est facile d’oublier ce qu’on ne veut pas se rappeler. Vous ne savez pas quelle vie j’ai vécue […] »), nous voyons alors un plan large des membres de la communauté assis de dos, suivant le témoignage de Carl sur un écran de télévision (dans l’image), accompagné du sous-titre : « Octobre 1990 projection pour la communauté ». Pendant les six minutes que dure le témoignage de Carl, le son semble être en continuité, alors que l’image alterne entre un gros plan de biais de Carl parlant et différents plans de la communauté écoutant Carl. La séquence se termine par les réactions des membres de la communauté. Certains choisissent de s’adresser directement à Carl, comme l’un des aînés : « Je comprends ta colère, Carl. Certains te rejettent parce qu’ils ont peur. » Le dialogue continue, malgré la séparation spatiale et le décalage dans le temps. Ainsi, les trois groupes dialoguent à travers la vidéo ; les trois espaces correspondent à trois tournages différents et espacés dans le temps[21]. Le dispositif d’enregistrement, en filmant les confidences et en devenant une partie intégrale de la mémoire communautaire, participe au travail de réconciliation et de pardon.

Globalement, les images et les sons restent synchrones et attachés à un lieu et à une date de tournage. Le passage d’un lieu à un autre se fait par l’intermédiaire de la télévision : on n’assiste pas à un dialogue mis en scène par le montage de différents témoignages ; il ne s’agit pas non plus d’un dialogue en présence. L’artificialité du dispositif n’est pas cachée, mais, au contraire, la virtualité du dialogue est soulignée par le visage de Carl sur l’écran de télévision. Cet aspect est souligné à la fin de la scène, lorsque la caméra placée dans le dos des spectateurs zoome sur l’écran de télévision, montrant le même plan de Carl parlant, dans une image bleutée et lignée caractéristique de la télévision. De plus, si l’on écoute avec attention la séquence, on perçoit une différence entre l’ambiance sonore de l’espace carcéral et celle de la salle de projection. Lorsque l’on voit Carl en gros plan, on entend des sons sourds tels des bruits de porte, qui ne sont pas audibles lorsque l’on voit les spectateurs. En revanche, on entend les faibles bruits que font les membres de la communauté concentrés sur la télévision. Même s’il semble y avoir une continuité créée artificiellement par le montage, le son et la télévision rétablissent la distinction entre les lieux et le décalage temporel.

Il y a un son qui ne rentre pas dans ce schéma : le « Chant de Linda » qui accompagne la transition entre la première scène avec Linda et les premières images de la confession de Carl. La voix de Linda est une prolepse sonore : chaque membre de la communauté touché par la tragédie et participant au processus de guérison entonnera un chant qui lui est propre lors de la cérémonie finale. En juillet 1990, Linda n’a pas encore chanté son chant, mais il est déjà en gestation : le début de dialogue – rendu possible par l’intermédiaire de la vidéo – est le début du travail de réconciliation et de pardon, il correspond donc aux premiers moments de la création du chant de guérison. Ainsi, cette désynchronisation spécifique est particulièrement signifiante : le chant fait le lien entre le témoignage de Linda et la réaction de son père, après son visionnement ; il annonce également la mise en route du processus de réconciliation.

* * *

Ces exemples montrent que la pratique vidéo ne rompt pas totalement avec les modes de fonctionnement liés au médium cinématographique : il faut plutôt y voir une continuité, apportant à la fois une apparente simplification technique et une complexification du dispositif. Ainsi, l’idée de lier une image audiovisuelle avec un lieu n’est pas nouvelle. De même, le principe de projeter une séquence aux personnes filmées au cours du tournage est appliqué depuis les frères Lumière : la vidéo simplifie et accélère le dispositif, permettant de le réaliser instantanément.

L’asservissement du son et de l’image sur la bande magnétique change néanmoins le rapport des cinéastes à la synchronisation et constitue une différence majeure entre ces deux supports : contrairement au montage cinématographique qui suppose un respect des règles techniques afin de conserver une synchronisation, en vidéo (que le montage soit analogique ou numérique) une manipulation est nécessaire afin de rompre la synchronisation et de séparer image et son. Dans le cas d’un entretien, le montage conserve généralement le lien entre la parole et le visage, en « dissimulant » partiellement l’un ou l’autre, soit en ajoutant un plan de coupe (ou un insert dans l’image), soit en mixant le son de l’entretien avec d’autres sources. Globalement, le son est lié à une image et chaque désynchronisation doit être motivée. Cette différence « ontologique » crée une perception alternative des temporalités des images audiovisuelles et permet d’autres mises en scène des décalages temporels : au cinéma, l’idée d’une image associée à un espace-temps particulier est liée à la synchronisation audiovisuelle, forcément construite au tournage et au montage ; au contraire, en vidéo, le fait que l’image soit automatiquement audiovisuelle renforce le rapport au « ici et maintenant » du tournage. La synchronisation n’est ni choisie ni construite ; elle est directement induite par le support. La désynchronisation au contraire relève d’un choix qui remet en cause non seulement le lien entre l’image et le son, mais également la validité de l’image en termes de « ça a été » : le lien entre l’image audiovisuelle et la réalité du tournage relève de la synchronisation. Au cinéma, la manipulation crée la sincérité, et en vidéo, la synchronisation est « naturelle », tandis que la désynchronisation donne une dimension supplémentaire à la simple monstration. D’autre part, les personnes filmées sont dorénavant conscientes des possibilités offertes par la technique audiovisuelle : ainsi, dans notre dernier exemple, les membres de la communauté ont eu l’idée de demander l’aide du cinéaste pour faire voyager leurs témoignages. C’est en cela que la vidéo modifie radicalement notre rapport à la technique audiovisuelle.

Appendices

Note biographique

Vincent Bouchard enseigne les cinémas francophones à l’Université de Louisiane à Lafayette. Le livre issu de sa thèse, Pour un cinéma léger et synchrone à Montréal !, est paru récemment aux Presses universitaires du Septentrion (2012). Il a en outre collaboré à plusieurs publications universitaires, dont Pierre Perrault, le legs (2009) dirigé par Michèle Garneau et Johanne Villeneuve. Il est également membre du groupe de recherche « Cinéma et oralité » dirigé par Germain Lacasse (Université de Montréal). Dans ce contexte, il a coédité, avec G. Lacasse et G. Scheppler, l’ouvrage Pratiques orales du cinéma (2011) et le numéro Cinéma & oralité de la revue CiNéMAS (2010).

Notes

-

[1]

D’après une recherche dans différentes bases de données, dont celles de la Cinémathèque québécoise, de l’Université de Montréal, de l’Université McGill, ainsi qu’Érudit, ce sujet est peu répertorié.

-

[2]

À ce sujet, consulter Giusy Pisano et Valérie Pozner (dir.), Le muet a la parole, cinéma et performances à l’aube du 20e siècle, Paris, AFRHC, 2005 et Giusy Pisano, Une archéologie du cinéma sonore, Paris, CNRS, 2004.

-

[3]

À ce sujet, consulter Martin Barnier, En route vers le parlant. Histoire d’une évolution technologique, économique et esthétique du cinéma (1926-1934), Liège, Céfal, 2002 et Donald Crafton, The Talkies : American Cinema’s Sound, 1926-1931, London, Scribner, 1997.

-

[4]

En 1948, Western Electric construit un enregistreur perforé 35 mm biformat : pellicule photographique, pellicule magnétique.

-

[5]

En 1951, Stefan Kudelski conçoit et fabrique le Nagra 1, le premier magnétophone léger, portatif, autonome et de haute qualité, ayant 5 heures d’autonomie de batterie et pesant 4 kg. Pour plus de précisions, consulter les travaux de Séverine Graff sur le Nagra et les premiers magnétophones.

-

[6]

Voir la distinction que André Gaudreault et Philipe Marion proposent entre la caméra à manivelle des frères Lumière et le studio d’Edison dans « Moteur ou manivelle : incidence du vecteur énergétique dans la captation des images de la cinématographie-attraction », Montréal, 2005 (article non publié).

-

[7]

René Briot, Les techniques cinématographiques, Paris, ESRA, 1985, p. 284.

-

[8]

Le cinéma direct apparaît en simultané dans trois pôles : New York (Richard Leacock, Robert Drew, Don Alan Pennebaker, etc.), Paris (Jean Rouch, Mario Ruspoli, Chris Marker, etc.) et Montréal (Office national du film - ONF).

-

[9]

Organisme fédéral canadien de production et de distribution cinématographique, mis en place en 1939 par John Grierson, à la demande du gouvernement canadien.

-

[10]

Marcel Carrière et Jean Daniel Lafond, « L’oreille ordinaire », La revue de la Cinémathèque, Montréal, 1991, p. 14.

-

[11]

Tournage du 30 janvier 1961 au 7 mars 1961 et du 20 mars 1962 au 11 octobre 1962. Cette innovation est publiée dans le Quarterly Report on Technical Operations, mars 1961, Archives de l’ONF, Montréal.

-

[12]

Ibid., p. 8.

-

[13]

Leo H. O’Donnell, Time Index System, 1976, p. 2 ; Le système du time index, 15 juin 1973, p. 3 ; invention datée de 1963 dans Division de la recherche et du développement technique – 1945, 1990, Archives de l’ONF, Montréal.

-

[14]

Mario Ruspoli, Le groupe synchrone cinématographique léger, Rapport UNESCO, 2e table ronde de Beyrouth, 1963, p. 27.

-

[15]

Serge Leblanc et Jean Roy, Synchronisation de Baie James (85-064), Note de service, document destiné à Paul Larose, 11 avril 1972, Archives de l’ONF, Montréal.

-

[16]

Bernard Stiegler, La technique et le temps. Tome 1 : La faute d’Épiméthée, Paris, Galilée, 1994, p. 47.

-

[17]

L’expression « électrification de l’image audiovisuelle » a été proposée par Philippe Despoix et Vincent Bouchard lors du colloque Électricité : déploiement d’un paradigme (CRI VII, Université de Montréal, octobre 2005).

-

[18]

Voir, en particulier : Michèle Garneau et Johanne Villeneuve (dir.), Pierre Perrault, le legs, Montréal, Fides, 2009.

-

[19]

Michel Brault, André Gladu, Nanouk Films, 1974-1978, 27 X 28 pouces.

-

[20]

Entretien avec André Gladu, octobre 2009, Lafayette, Louisiane.

-

[21]

En fait, à ce moment-là, il n’y a plus que deux groupes, Linda ayant rejoint les siens et participant au débat qui suit la projection.

List of figures

Fig. 1a-1b

Fig. 2a-2b

Fig. 3a-3b

Fig. 4a-4b