Article body

Avec l’avènement de l’intelligence artificielle, le plagiat a pris une forme nouvelle. Des systèmes automatisés peuvent désormais générer du contenu à la place de véritables auteurs, mettant en question la notion même de plagiat. Alors que certains peuvent voir cela comme une opportunité de faciliter la création de contenu, d’autres s’inquiètent des conséquences pour les travailleurs de l’écriture et la qualité de l’information disponible sur Internet. Dans ce contexte, il est important de réfléchir aux enjeux éthiques liés à l’utilisation de l’IA et de prendre des mesures pour protéger les droits des auteurs et garantir une utilisation responsable de l’IA.

En toute transparence, nous n’avons pas rédigé ce premier paragraphe ; c’est plutôt un algorithme d’intelligence d’artificielle proposé par OpenAI nommé ChatGPT qui nous l’a proposé lorsque nous avons envoyé une requête à savoir si l’utilisation de l’intelligence artificielle constituait du plagiat sur le plan éthique (Error: Reference source not found). ChatGPT est l’agent conversationnel utilisant l’IA qui a accueilli plus d’un million d’utilisateurs en 5 jours, représentant la croissance la plus importante pour un service en ligne (Harris, 2022). Le modèle a été entrainé sur un ensemble fermé de données, qui a été enregistré avant 2021.

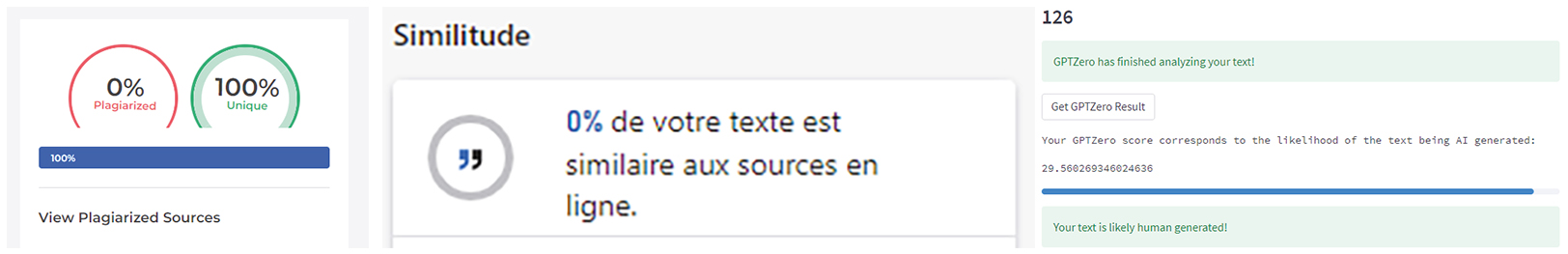

L’analyse du paragraphe à partir de trois outils de détection de plagiat indique que le texte est original dans tous les cas (Figure 1). Pourtant, l’est-il vraiment ? Le Larousse définit le plagiat comme « [l]’acte de quelqu’un qui, dans le domaine artistique ou littéraire, donne pour sien ce qu’il a pris à l’oeuvre d’un autre ». Sans précision sur cet « autre », on peut ainsi s’interroger sur la production d’un texte par un algorithme d’IA, mais qui s’alimente des centaines de milliers de textes en ligne. N’est-ce pas là le travail même du chercheur, du moins en partie, soit de s’approprier puis reprendre dans ses mots le travail d’autrui ? La qualité des textes générés par un algorithme d’IA s’améliore rapidement à un point tel que de faux articles scientifiques, rédigés par une IA, sont déjà parvenus à berner un processus d’évaluation par les pairs (Abd-Elaal et al., 2022) et pourront aisément berner les outils de détection.

Figure 1

Détection de plagiat à partir du site https://plagiarismdetector.net/, Microsoft Word Online et GPTzero[1]

À partir de combien de mots considère-t-on un extrait comme ayant été plagié ? L’expression « lumière du jour » ne semble pas poser problème ; toutefois, celle « jardin de givre » devrait, en toute honnêteté, être attribuée à Nelligan (1898). Ces réflexions sur les paramètres techniques sont incontournables dans le contexte où l’on souhaite déterminer si ce qu’une IA produit est ou non du plagiat, car cette dernière peut également reprendre des extraits de texte en ligne, possiblement même de traductions. Comme l’IA est dépourvue d’intentionnalité, ce serait plutôt l’humain qui, en ayant recours à l’IA, serait le responsable du plagiat, ou au minimum, de s’assister d’un agent conversationnel comme aide à l’écriture, ce qui pourrait être aussi vu comme du plagiat. Les règlements académiques prévoient que l’exécution par autrui, l’utilisation totale ou partielle d’un texte rédigé en le faisant passer pour sien, mais aussi le recours à toute aide non autorisée sont reconnus comme du plagiat, copiage ou fraude. Pourrait-on voir l’IA comme un assistant d’aide à l’écriture comme Antidote, ou encore comme un coauteur du texte, à l’instar, par exemple, de O’Connor et ChatGPT (2022) ?

Bien qu’on puisse s’imaginer que de jeunes enfants ne peuvent pas facilement mobiliser OpenAI Playground ou ChatGPT (sites Web en anglais, création d’un compte, certains services payants), des adolescents ou de jeunes adultes, quant à eux, pourraient être tentés de le faire. Les sites OpenAI[2] ou ChatGPT[3] peuvent proposer des résumés des oeuvres, nous aider à rédiger un poème ou même créer un texte à partir d’une prémisse, etc. Ainsi, un élève pourrait demander un résumé de l’oeuvre de Michel Tremblay ou nous expliquer le conflit israélo-palestinien en quelques lignes. Il s’avère même possible de bonifier ou d’ajuster un texte existant, notamment avec OpenAI, mais aussi avec un outil comme Lex.page[4]. D’autres outils, comme SpeedWrite[5] ou Quillbot[6], font plutôt la démarche de simplifier, de résumer ou de paraphraser un texte existant afin d’en conserver l’essentiel. Selon Abd-Elaal et al. (2022), les personnes enseignantes sont mal préparées pour détecter l’utilisation de l’IA dans ces textes. Sans pour autant qu’elles soient infaillibles, il existe différentes pistes de détection possibles : reconnaitre l’emploi de grammaire non contextuelle, vérifier l’existence des références bibliographiques dans le cas d’un article scientifique, ou encore analyser la cohérence textuelle globale au-delà de la quantité d’information et de la bonne structure des phrases. Un outil comme ChatGPT ne cherche pas à produire la réponse la plus juste possible, mais bien la réponse la plus probable. Ce faisant, la réponse proposée échappe bien souvent de nombreuses subtilités et contient des informations erronées (Allouche, 2023), ce qu’un spécialiste ou une personne enseignante pourrait détecter.

L’IA elle-même pourrait-elle nous aider à déterminer si le texte est celui généré par un algorithme d’IA ? La réponse théorique est oui. C’est le cas de l’outil GPTzero, développé par Edward Tian, et de l’outil « Giant Language model Test Room »[7] qui permet de déterminer si le texte est produit par un algorithme d’IA ou non. L’outil GPTzero nous propose un score composite à partir de deux indicateurs : « perplexity », ou la complexité du texte et « burstiness », ou la variabilité des phrases. Dans ce contexte, néanmoins, il apparait essentiel d’apporter des amendements aux règlements académiques pour permettre de traiter de tels cas de plagiat qui comprennent une certaine marge d’incertitude alors qu’il faut actuellement en faire une démonstration explicite. Cela impliquerait aussi de se pencher sur la légalité même de mobiliser des outils de détection pour des travaux d’étudiants (Alphonso, 2004), geste qui pourrait lui-même alimenter l’IA pour de nouvelles détections.

Du côté des personnes étudiantes qui commettent ces infractions, les raisons peuvent être multiples : manque de motivation ou de temps, méconnaissance des règles, négligence, attentes incohérentes du personnel enseignant, etc. (Simonnot, 2014). Nonobstant la raison, l’IA rend le travail de détection encore plus difficile, et selon nous, ce n’est qu’une question de temps pour que cela devienne impossible de différencier l’originalité d’un texte pour des travaux étudiants.

Malgré tout, les potentialités de l’IA pour le personnel enseignant sont nombreuses : évaluations automatisées, agent intelligent pour accompagner les élèves, suivi des activités, etc. Mais peu ou prou ont mis en évidence les enjeux que pourrait soulever l’IA à des fins non prévues ou inopportunes. Le problème reste entier, que faisons-nous ? Nous pouvons d’abord imaginer que l’IA devienne une aide à l’écriture ou à la synthèse, en accompagnant l’élève dans les premières étapes d’écriture. Dans ce contexte, il faut donc examiner comment l’IA pourrait devenir un levier à l’apprentissage, mais il serait néanmoins toujours difficile pour l’enseignant de discerner ce qui vient des personnes apprenantes ou d’un algorithme d’IA. Cela peut également amener à développer son esprit critique pour synthétiser de l’information retrouvée sur Internet (identifier les faiblesses du texte, ajouter des informations pertinentes, organiser plus efficacement les idées, etc.). Même derrière ces usages intéressants, il demeure difficile de définir si l’outil a réellement soutenu l’élève ou s’il a plutôt été utilisé sans réel apprentissage. Le monde de l’éducation devra s’y pencher plus tôt que tard.

Pour conclure, nous laisserons le mot de la fin à l’algorithme sur la place de l’intelligence artificielle en éducation, qui nous suggère que : « l’intelligence artificielle en éducation est un sujet extrêmement complexe et il y a encore beaucoup de choses que nous ne savons pas. Cependant, il semble y avoir un potentiel énorme pour l’IA en éducation et nous espérons que les chercheurs et les pédagogues continueront à explorer ces possibilités afin de permettre aux élèves d’atteindre leur plein potentiel. » (OpenAI, 2022). Superficiel, je vous l’accorde, mais il est difficile d’être en désaccord, non ?

Appendices

Notes

Bibliographie

- Abd-Elaal, E.-S., Gamage, S. H. P. W., et Mills, J. E. (2022). Assisting academics to identify computer generated writing. European Journal of Engineering Education, 47(5), 725‑745. https://doi.org/10.1080/03043797.2022.2046709

- Allouche, E. (2023, 4 janvier). Sens et finalités du numérique en éducation – Hors-série : Tests et simulations d’« entretien » avec ChatGPT (Open AI). Éducation, numérique et recherche. https://edunumrech.hypotheses.org/7635?fbclid=IwAR3u9pAVDzAwVCxdBWcIr-TsaUVmy_Sk_NccRg08EfL07RO3OxdR7ZhMovA

- Alphonso, C. (2004). Student rebel beats McGill in essay fight. Globe and Mail. https://www.theglobeandmail.com/news/national/student-rebel-beats-mcgill-in-essay-fight/article992417/

- Harris, R. (2022, 23 décembre). ChatGPT gains 1 million users within 5 days. AppDeveloper. https://appdevelopermagazine.com/Chatgpt-gains-1-million-users-within-5-days/

- O’Connor, S. et ChatGPT. (2022). Open artificial intelligence platforms in nursing education: Tools for academic progress or abuse? Nurse Education in Practice. DOI: 10.1016/j.nepr.2022.103537.

- Simonnot, B. (2014). Le plagiat universitaire, seulement une question d’éthique ? Questions de communication, 26, 219‑233. https://doi.org/10.4000/questionsdecommunication.9304

List of figures

Figure 1

Détection de plagiat à partir du site https://plagiarismdetector.net/, Microsoft Word Online et GPTzero[1]